#画像処理

Depth Pro+YOLO11でカメラと人物の距離の推定を試してみた

概要Appleが発表した単眼深度推定モデルのDepth Proを試してみました。

Depth Proはゼロショットで実際の距離の推定ができる点が特徴です。

YOLO11のセグメンテーションモデルと組み合わせて、カメラと人物の距離を推定してみました。

高速な推論を謳っていますが、あまり速くはありませんでした。

Google ColabのL4インスタンスで810×1080のサンプル画像に2秒

YOLO11を試してみた

概要YOLOv8を発表したUltralyticsが新しいYOLOシリーズのモデル YOLO11 を発表したので試してみました。

Ultralyticsのドキュメントもv8から11へ更新されています。

命名はこれまでと異なり「v」無しの YOLO11 です。

「v」付きの命名を避けたのは、既にYOLOv11という命名の悪戯リポジトリがあるためかもしれません

YOLOは物体検出モデルとして有

Depth Anything V1とV2の結果を見比べる

概要単眼深度推定モデルDepth Anything (以降はV1として記載します)とそのアップデート版にあたるDepth Anything V2を簡単に比較してみました。

V1に比べV2は輪郭がはっきりしており、細部も予測できるようになった印象を受けました。

推論の速度はほぼ同等で、GPU使用量と重みのファイルサイズは同じでした。

Depth Anything V2のSサイズモデルはApa

SAM2をUltralyticsで試してみた

概要YOLOv8等が利用できる Ultralytics がSAM2をサポートしたので試してみました。

SAM2の tiny ~ large サイズの重みを利用できます。

画像や動画のセグメンテーションが可能です。

YOLOv8等の物体検出モデルを組み合わせたセグメンテーションの自動アノテーション関数が利用できます。

タイトルの通り本記事はUltralytics上のSAM2を利用しています

論文解説 4M-21: An Any-to-Any Vision Modelfor Tens of Tasks and Modalities

ひとことまとめ

概要Any to Anyの研究は以前から行われていたが、使用されているモーダル数が少なく変換に制限があった。そこでSAMや4DHumansなどの疑似ラベルや画像のメタデータやカラーパレットなどのモダリティを追加した。既存のモデルよりも性能の低下なしに3倍多くのタスクやモダリティを解けることを示した

提案手法提案手法は4M(https://arxiv.org/pdf/2312.0

小さな物体の検出率UPのためにSAHIを試してみた

概要物体検出モデルが見逃しやすい小さな物体の検出力向上を目的としたライブラリSAHIを試してみました。

物体検出モデルにはYOLOv8sとYOLOv8xを使用しました。

YOLOのインスタンスセグメンテーションは未対応なようです。

SAHI (Slicing Aided Hyper Inference)入力画像を分割して物体検出モデルに入力し、その結果をマージしてくれるライブラリです。

G

顔、目、口を認識するためのOpenCVの使用法 - C++での実装

本記事では、OpenCVのHaar Cascadeを使用して画像中の顔と目を検出する方法について説明します。まず、Haar Cascadeについて簡単に紹介します。

Haar Cascadeの紹介

Haar Cascadeは、2001年にPaul ViolaとMichael Jonesによって導入された、コンピュータビジョンにおける物体検出のための広く使用されている手法です。この技術は、画像やビ

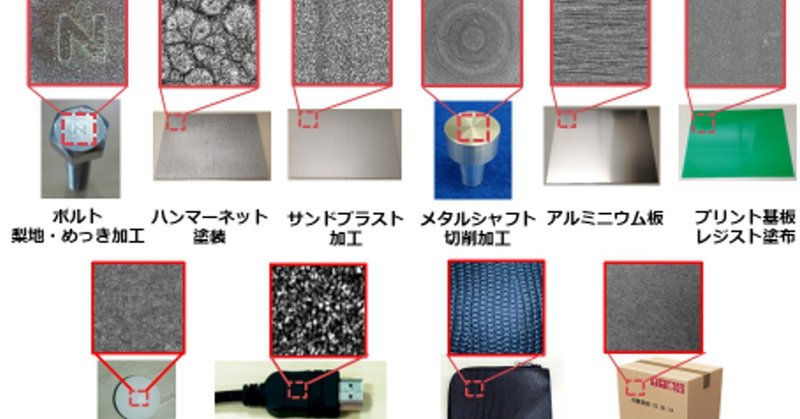

エール ―若き画像研究の旗手へ― 第3回 「物体指紋」で画像技術界をバズらせた石山塁博士―モノのタグなし認証技術―

序「物体指紋」の石山塁博士

ビジョン技術の実利用ワークショップ(ViEW2011)のIS会場ゾーン左手奥にて石山塁博士が,はにかみながら熱弁されていた。ViEW2014(機械部品の話題)の時だと本人はおっしゃるが,ViEW2011(メロンの話題)である。その様子が他にない強い印象であった。

初めてお声かけしたときの記憶は鮮明である。石山さんの所属は「NEC情報メディアプロセッシング研究所」であ

Ultralyticsの自動アノテーションを試してみた

概要ultralyticsライブラリのセグメンテーション向け自動アノテーション関数auto_annotateを試してみました。

YOLO形式での出力時に塞がれてしまう🍩の穴を復活させる方法を調査して試してみました。

実施内容Google ColabのCPU環境で試しました。

準備

ライブラリインストールとリポジトリのクローンします。

!pip install ultralytics!

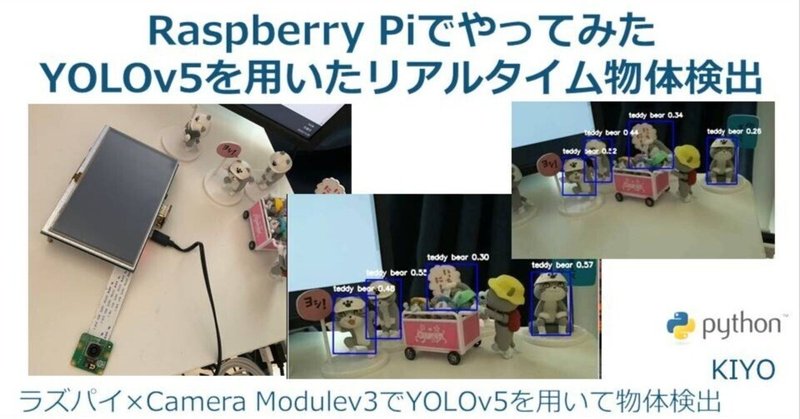

Raspberry Piでやってみた3(画像処理):YOLOv5を用いたリアルタイム物体検出

1.概要 Rasberry Pi×YOLOv5を用いてリアルタイムで物体検出をしてみます。前回の記事では静止画、動画、USBカメラでの利用は確認できました。今回は仮想環境下でカメラモジュールv3を用いてYOLOv5を動かしてみます。

結論としては「Rasberry Pi4では処理能力が足りないため、普通のPCかJetsonを使用した方が良い」ため、あくまで勉強用となります。

1-1.YOL