2024年4月の記事一覧

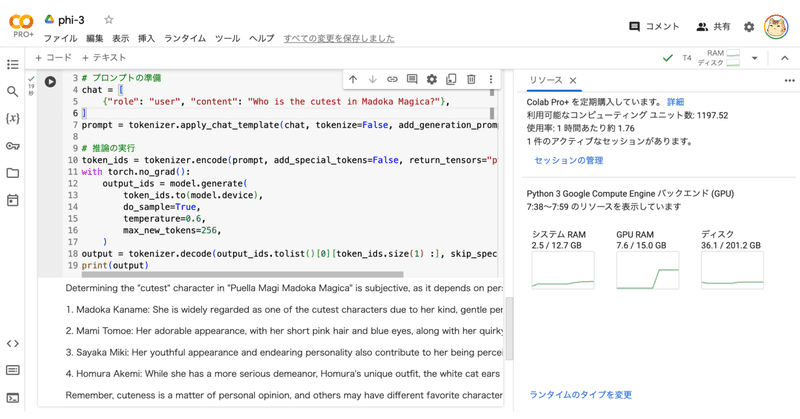

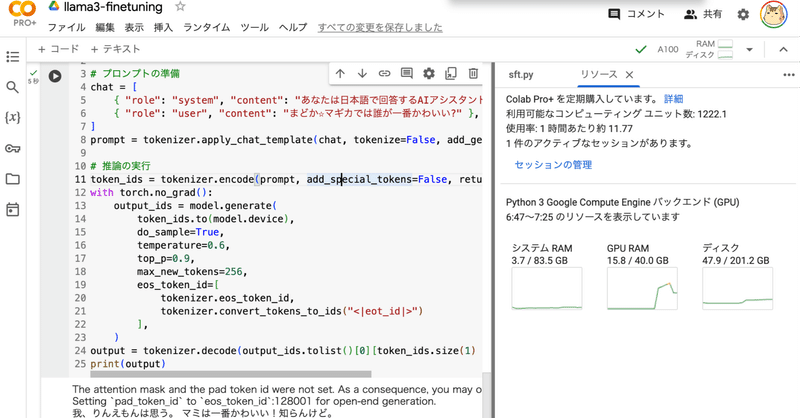

Google Colab で mergekit-evolve による 進化的モデルマージ を試す

「Google Colab」で「mergekit-evolve」による「進化的モデルマージ」を試したので、まとめました。

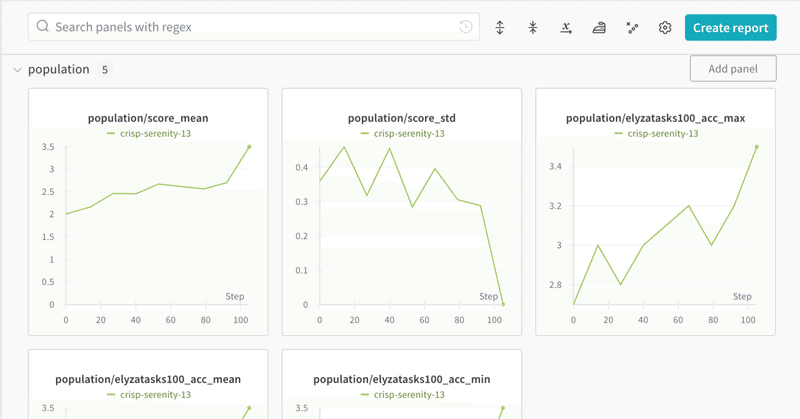

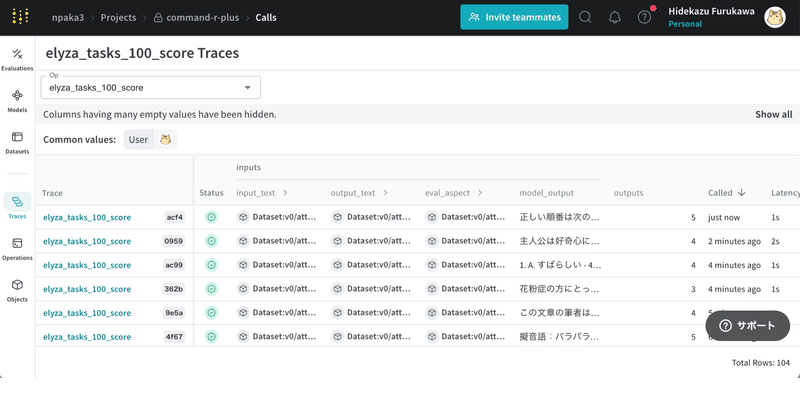

1. mergekit-evolve「Google Colab」で「mergekit-evolve」による進化的モデルマージを試します。うみゆきさんのコードを参考にさせてもらいつつ、実行環境 Colab + 評価者 Gemini で試してみました。

2. Colabでの実行

LLMの強化学習における新手法:TR-DPOの論文紹介

論文名

Learn Your Reference Model for Real Good Alignment

arXivリンク

https://arxiv.org/pdf/2404.09656.pdf

ひとこと要約

Direct Preference Optimization (DPO)を改良したTrust Region DPO (TR-DPO)を提案。

メモ

背景

従来のアライン

エンジニア経験の無い一般人男性が、AIマンガアシスタントを作っちゃう話(生成AIなんでも展示会ふりかえり)

2024年4月21日(日)、渋谷Abema Towers内、CyberAgent様のスペースで開催された、生成AIの個人開発者の展示会「生成AIなんでも展示会」に出展させていただきました。

私は、生成AI(主にLLM)を用いて、マンガの制作を助けるツールを作って、そのデモや成果物を展示しました。

当日は、たくさんの方にブースにお越しいただいて、事前に用意していたプレゼンテーションをほとんど使用せ

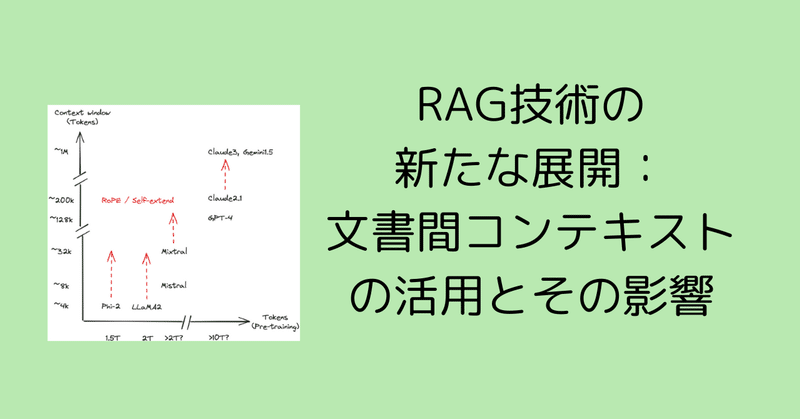

RAG技術の新たな展開:文書間コンテキストの活用とその影響

LangChainチームの@Lance Martinが最近公開したビデオシリーズでは、大規模言語モデル(LLM)とRetrieval Augmented Generation(RAG)技術の進化について詳しく説明されています。このビデオでは、特に多くの文書からコンテキストを必要とする問いに対応するためのRAPTORのアプローチや、長いコンテキスト埋め込み技術、自己反射型RAGやC-RAGなどの新た

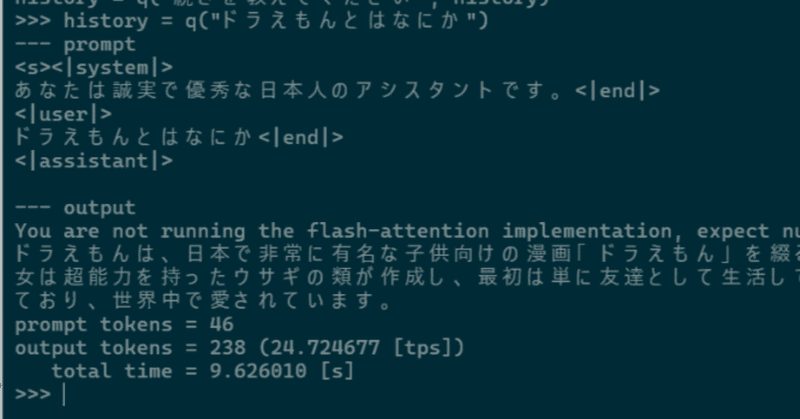

もっとみるChatGPT登場時と同じような衝撃を受けたgroqを調べてみた

groqとは?groqとは、言語モデル処理に特化したLPU(Language Processing Unit)を開発している会社です。

このLPUを使用することにより大規模言語モデルの応答速度が格段に速くなります。

その結果、ユーザはレスポンスの待ち時間を意識することなく大規模言語モデルを使用することができるようになります。

groqは、そのLPUを使用したgroq.comというChatG