Google Colab で Phi-3 を試す

「Google Colab」で「Phi-3」を試したので、まとめました。

1. Phi-3

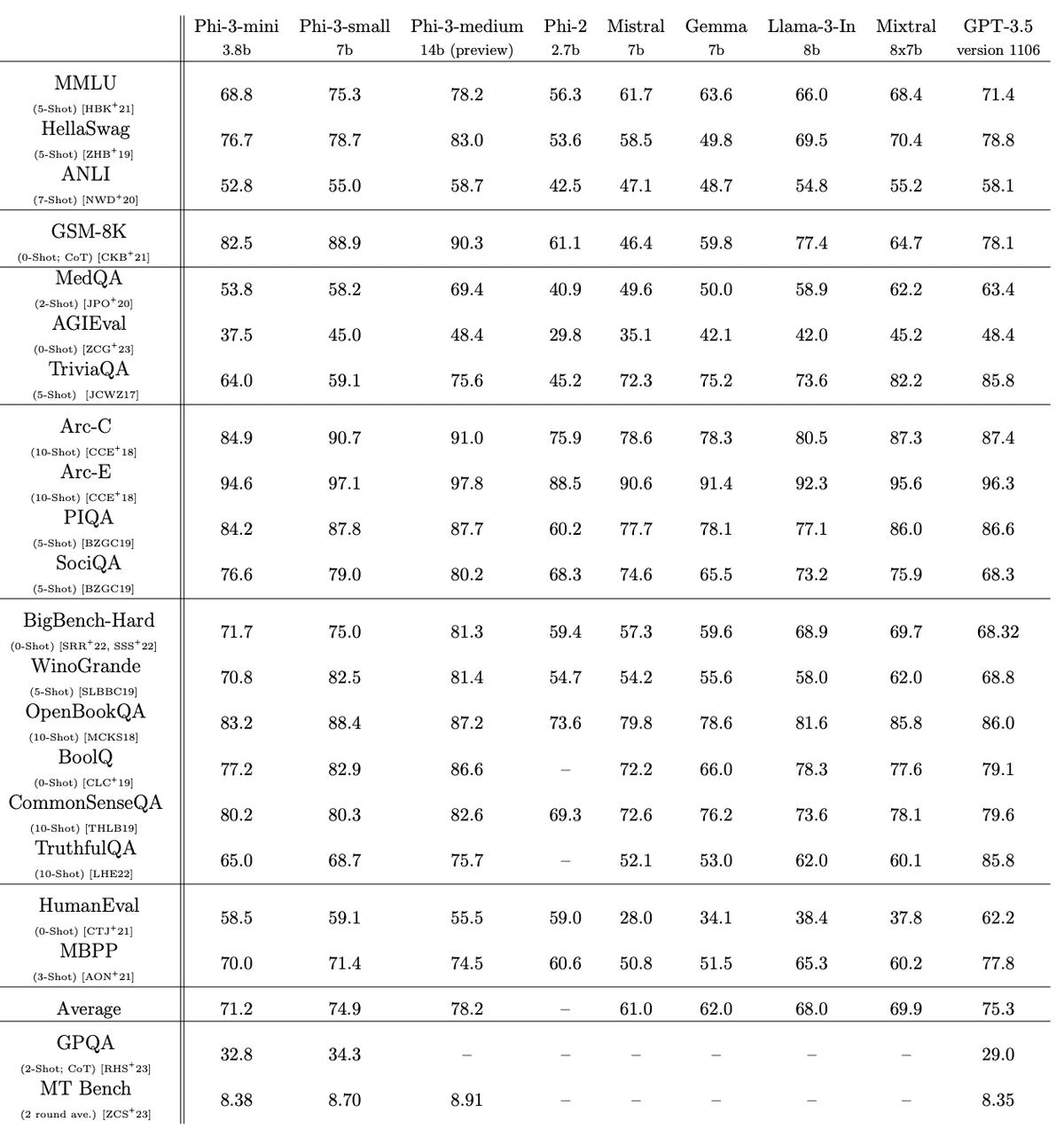

「Phi-3」は、Microsoftが開発したSLM (Small Language Model)です。さまざまな言語、推論、コーディング、数学のベンチマークにわたって、同じサイズのモデルや次のサイズのモデルよりも優れたパフォーマンスを発揮します。

パラメータ数と学習トークン数は、次のとおりです。

・Phi-3-mini (3.8B、3兆3000億)

・Phi-3-small (7B、4兆8000億)

・Phi-3-medium (14B、4兆8000億)

2. Phi-3 のモデル

「Phi-3」では現在、次の4種類のモデルが提供されています。

・microsoft/Phi-3-mini-4k-instruct

・microsoft/Phi-3-mini-4k-instruct-onnx

・microsoft/Phi-3-mini-128k-instruct

・microsoft/Phi-3-mini-128k-instruct-onnx

2. Colabでの実行

Colabでの実行手順は、次のとおりです。

(1) パッケージのインストール。

# パッケージのインストール

!pip install -U transformers accelerate(2) 「HuggingFace」からAPIキーを取得し、Colabのシークレットマネージャーの「HF_TOKEN」に登録。

(3) トークナイザーとモデルの準備。

今回は、「microsoft/Phi-3-mini-128k-instruct」を使います。

from transformers import AutoModelForCausalLM, AutoTokenizer

# トークナイザーの準備

tokenizer = AutoTokenizer.from_pretrained(

"microsoft/Phi-3-mini-128k-instruct"

)

# モデルの準備

model = AutoModelForCausalLM.from_pretrained(

"microsoft/Phi-3-mini-128k-instruct",

device_map="cuda",

torch_dtype="auto",

trust_remote_code=True,

)(4) 推論の実行。

import torch

# プロンプトの準備

chat = [

{"role": "user", "content": "Who is the cutest in Madoka Magica?"},

]

prompt = tokenizer.apply_chat_template(chat, tokenize=False, add_generation_prompt=True)

# 推論の実行

token_ids = tokenizer.encode(prompt, add_special_tokens=False, return_tensors="pt")

with torch.no_grad():

output_ids = model.generate(

token_ids.to(model.device),

do_sample=True,

temperature=0.6,

max_new_tokens=256,

)

output = tokenizer.decode(output_ids.tolist()[0][token_ids.size(1) :], skip_special_tokens=True)

print(output)Who is the cutest in Madoka Magica?

Determining the "cutest" character in "Puella Magi Madoka Magica" is subjective, as it depends on personal preferences and interpretations of cuteness. However, some characters that are often considered cute include:

1. Madoka Kaname: She is widely regarded as one of the cutest characters due to her kind, gentle personality and her evolution throughout the series.

2. Mami Tomoe: Her adorable appearance, with her short pink hair and blue eyes, along with her quirky and childlike personality, often make her a favorite among fans.

3. Sayaka Miki: Her youthful appearance and endearing personality also contribute to her being perceived as one of the cutest characters in the series.

4. Homura Akemi: While she has a more serious demeanor, Homura's unique outfit, the white cat ears she wears, and her cat-like personality traits can make her appear cute to some viewers.

Remember, cuteness is a matter of personal opinion, and others may have different favorite characters.

【翻訳】

まどか☆マギカでは誰が一番かわいい?

『魔法少女まどか☆マギカ』の中で「最もかわいい」キャラクターを決めるのは、個人の好みやかわいさの解釈に依存するため、主観的なものです。 ただし、かわいいと考えられるキャラクターには次のようなものがあります。

1.鹿目まどか:彼女は優しくて優しい性格とシリーズを通しての進化により、最もかわいいキャラクターの1人として広く認められています。

2. 巴マミ: ピンクのショートヘアと青い瞳の愛らしい容姿と、風変わりで子供っぽい性格がファンの間で人気です。

3. 美樹さやか:彼女の若々しい外見と愛らしい性格も、彼女がシリーズの中で最もかわいいキャラクターの一人として認識されることに貢献しています。

4. 暁美ほむら:彼女はより真面目な態度を持っていますが、ほむらの独特の服装、彼女が身に着けている白い猫耳、そして彼女の猫のような性格特性は、一部の視聴者にとって彼女を可愛く見せることができます。

かわいさは個人的な意見の問題であり、好きなキャラクターは人によって異なる可能性があることを覚えておいてください。