【論文瞬読】大規模言語モデル(LLM)が回帰分析の新たな王者に?驚くべき性能の秘密を探る

こんにちは!株式会社AI Nestです。

今日は、自然言語処理と機械学習の世界に革命を起こす可能性を秘めた論文を紹介します。タイトルは「From Words to Numbers: Your Large Language Model Is Secretly A Capable Regressor When Given In-Context Examples」。大規模言語モデル(LLM)が、コンテキスト内の例示のみを使って回帰タスクを実行できるという驚くべき発見について述べられています。

タイトル:From Words to Numbers: Your Large Language Model Is Secretly A Capable Regressor When Given In-Context Examples

URL:https://arxiv.org/abs/2404.07544

所属:University of Arizona, Technical University of Cluj-Napoca

著者:Robert Vacareanu, Vlad-Andrei Negru, Vasile Suciu, Mihai Surdeanu

回帰とは?

まず、回帰とは何でしょうか?回帰は、入力変数から出力変数の値を予測するタスクです。線形回帰と非線形回帰の2種類があります。線形回帰は、入力変数と出力変数の関係が一次式で表せる場合に用いられ、非線形回帰は、その関係が非線形である場合に用いられます。回帰分析は、経済学、社会科学、自然科学など、様々な分野で広く応用されています。

LLMの驚くべき回帰能力

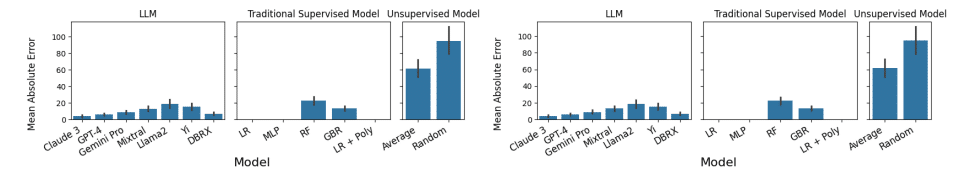

この論文では、LLMがこれらの回帰タスクをどれほどうまく実行できるかを調査しました。具体的には、いくつかの異なるLLM(GPT-4、Claude 3、DBRXなど)を用いて、線形回帰と非線形回帰のタスクを実行し、その性能を従来の教師あり手法と比較しました。

LLM、従来の教師あり手法、教師なし手法の性能比較

驚くべきことに、LLMは追加の学習やパラメータ更新なしで、線形および非線形回帰を実行できることがわかりました。しかも、その性能は、ランダムフォレスト、勾配ブースティングなどの従来の教師あり手法に匹敵する、あるいはそれ以上だったのです!例えば、Claude 3は、非線形回帰の一種であるFriedman #2データセットにおいて、AdaBoost、SVM、ランダムフォレスト、KNN、勾配ブースティングなどの手法を上回る性能を示しました。

LLM、従来の教師あり手法、教師なし手法の性能比較

少数例学習とメタ学習への示唆

さらに、LLMの性能は、コンテキスト内の例示数が増えるにつれて向上することも明らかになりました。つまり、LLMは少数の例からタスクを学習できるということです。これは、少数例学習やメタ学習の観点からも非常に興味深い発見だと言えるでしょう。少数例学習は、少数の例示から新しいタスクを学習する手法であり、メタ学習は、学習方法そのものを学習する手法です。LLMがこれらの能力を持っているということは、より汎用性の高い人工知能システムの構築に繋がる可能性があります。

研究の限界と課題

ただし、この研究にはいくつかの限界もあります。例えば、LLMの予測と説明には不一致がある場合があること、データ汚染の可能性があることなどです。LLMは、時として予測の根拠となる説明を生成しますが、その説明と実際の予測値が一致しないことがあるのです。また、LLMの学習データに、今回使用したデータセットと類似のものが含まれている可能性があり、それがLLMの高い性能の原因となっている可能性があります。

しかし、新しく導入されたデータセットでの性能から判断すると、データ汚染の影響は限定的であると考えられます。この論文では、著者らが新たに作成したオリジナルのデータセットを用いて実験を行っていますが、そこでもLLMは高い性能を示しました。これは、LLMの回帰能力が特定のデータセットに依存しているのではなく、より一般的な能力であることを示唆しています。

今後の研究課題としては、LLMのコンテキスト学習能力のメカニズムを解明することや、他のタスクへの適用可能性を検証することが挙げられます。LLMがどのようにしてコンテキストから情報を抽出し、タスクを学習しているのか、そのプロセスを理解することは、より効果的なLLMの開発に繋がるでしょう。また、回帰以外のタスク、例えば分類や生成などにおけるLLMの性能を評価することも重要です。

さらに、データ汚染の問題にも注意を払い、より頑健な評価方法を確立することが求められます。LLMの学習データを公開し、評価データとの重複を確認するなどの措置が必要かもしれません。

LLMの可能性と応用

総じて、この論文はLLMの新たな可能性を示唆する重要な研究であり、自然言語処理と機械学習の発展に寄与すると考えられます。同時に、LLMの能力の限界や適用範囲についてさらなる研究が必要であることも示唆しています。

この研究は、自然言語処理や機械学習に携わる研究者や実務家にとって、非常に価値のある知見をもたらしてくれます。LLMの潜在的な能力を活用することで、より効率的で汎用性の高いシステムを構築できるかもしれません。例えば、少数の例示からタスクを学習できるLLMを用いれば、大量のラベル付きデータを用意することなく、高精度な予測モデルを構築できるかもしれません。

また、LLMの回帰能力は、自然言語処理の分野だけでなく、他の分野にも応用できる可能性があります。例えば、経済学や社会科学の分野では、様々な指標の予測にLLMを用いることができるかもしれません。自然科学の分野では、実験データの分析にLLMを活用できるかもしれません。

LLMの実応用における注意点

ただし、LLMを実際の問題に適用する際には、その限界にも留意する必要があります。LLMは、あくまでも統計的なモデルであり、因果関係の理解や、物理法則の考慮などは苦手とします。したがって、LLMの予測結果は、常に人間の専門家による検証が必要不可欠です。

また、LLMの予測の説明可能性や、公平性の問題にも注意を払う必要があります。LLMが予測の根拠を明確に示せない場合、その予測を信頼することは難しくなります。また、LLMが学習データに内在するバイアスを学習してしまう可能性もあります。これらの問題に対処するためには、LLMの内部動作の理解を深めると共に、説明可能な人工知能の研究を進める必要があるでしょう。

おわりに

2つの大規模言語モデルの累積リグレットのプロット

皆さんも、この論文を読んでみて、LLMの可能性について考えてみてはいかがでしょうか?自然言語処理と機械学習の世界は、常に驚きに満ちています。今後のLLMの発展から目が離せませんね!研究者の方は、LLMの能力の解明に向けて、さらなる研究を進めてみてはいかがでしょうか。実務家の方は、LLMを実際の問題に適用することで、新たなソリューションを生み出せるかもしれません。

LLMは、まだ発展途上の技術ですが、その可能性は計り知れません。この論文は、LLMの新たな一面を明らかにした、重要な一歩だと言えるでしょう。今後のLLMの発展に、大いに期待したいと思います!