ChatGPTで編集作業支援を試してみる

『上昇』の訳出がちょうど終わる頃に、大規模言語モデルによる生成AI、ChatGPTが公開、話題となり始めました。

翻訳そのものがこのような技術によってどうなっていくか、ということについての感想は後述しますが、翻訳からゲラとなり、編集のフェーズに入っていく段階で、翻訳というよりもテキスト作業に近い部分でいろいろなAI支援ができるのではないか、ということに思いいたり、いくつかのプロンプト動作の実験をしてみました。せっかくですので、参考までに公開したいと思います。文章を書く、というものとは別の、生成AIの使い方です。

※なおヘッダー画像もAI生成です(generated by DALL-E 2)。

大量の英文名をカタカナにする

今回の本の原著者謝辞、本当にたくさんの人名が並んでいました。これだけの著作になると、謝辞対象もそれは多くなって当然と思いますが、私の仕事はたくさん並んだその方々を日本語版でカタカナにしていくことで、機械的のように思えて馴染みのない名前については発音を調べたりかなり大変です。日本語でも表記がおおむね定まっている名前ならばいいですが、そういうものばかりではありません。英文読み上げをしてくれるソフト(DeepLもしてくれます)や名前を発音してくれるサイトなどもありますが、足りなければ登場した人の講演動画を探し、演者紹介や自己紹介に耳をそばだてたりして確認しています。実際にはそのように訳文を作っているのですが、作業のベースくらいはAIで作れたのではと(後から)思いました。

今回は原文テキストを使わずに、実験用にまずChatGPTに名前のサンプルを30人分ほど作ってもらいましょう。以下のプロンプトです(ここはなんとなく英語で指示しました)。こういうサンプルデータ作成に使えるのも生成AIのなかなか便利な点かと思います。

では、一気にカタカナにします。

ここまでやってもらえると下作業としてかなり楽ですね。実は、このようなアウトプットのままではなく、さらにChatGPTで作表まですることができます。

これは、そのままコピーしてExcel等のスプレッドシートに持っていけますので、さらにチェックや修正が楽になりそうです。こんな使い方ができる、というお話でした。

邦訳文献の引用書式を揃える

今回は(も)原注の長大な本で、全部で56ページ、800エントリ以上あるのですが、その中には邦訳のある文献があちらこちらに埋め込まれています。注は全訳をつけてもそこは手をつけずにゲラに回すのですが、担当の編集者たちは(信じられないことに)その大半を探し出すというすごいスキルを持っています。それでも初校ゲラになってからチェックすると、さすがに専門の文献をずっと見てきたというアドバンテージもあって、あ、これ、翻訳あったなとか、宝探しのように結構気がつきます。こちらの方で気づいたものについてはこの段階で記入して再校ゲラで確認しますが、正確を期すべき書誌情報でさらに汚い赤字を増やすのものなあと、追加案はテキストファイルで準備したいところです。

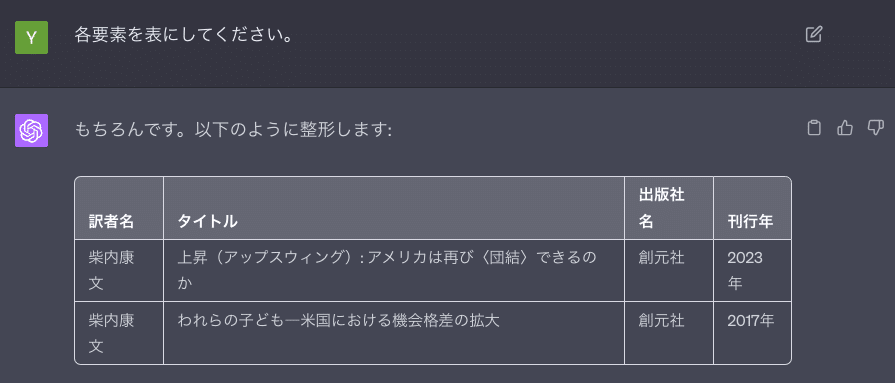

今回の邦訳文献書式はこのようなフォーマットにしています。〔訳者名『タイトル』出版社名、刊行年〕で、前後はいわゆる亀甲括弧です。

〔柴内康文訳『われらの子ども』創元社、2017年〕

図書館や出版社、書店サイト等のカタログ情報で必要な事項を探し、一つずつこの形に整形していけばいいのですが、量がかさむとそれなりに面倒ですし、充血した眼と固まる腕で作業していますので、手元の狂いもありえます。そこで以下のやりかたを試してみましょう。

まず当該文献を検索し、書誌情報の行からいただいて文献一つごとに空行を入れながらリスト化していきます。それらを「入力文」として、プロンプトにかけます。二つほどかけてみた例を見てみましょう(整形例に載せたのは、実際に登場した文献、フーヴァーのAmerican Individualism、星一訳です)。

原著者名、「単行本」や刊行月日、各種記号など、引用書式には不要な情報が入力データには結構入っているのですが、きれいに取り除いて必要な情報だけを正確に認識し、指定したフォーマットにしてくれています(なお実はこれですでにbotのようになってもいるので、引き続いてプロンプトのところに書誌情報を放り込むと整形結果を返す出力器になっています)。追加される邦訳文献についてはこういう感じで、本書の書式テキストデータに適宜直して編集の方に戻したのでした。

見ていただけるとわかりますが、異なる形式の入力が混ぜ込まれていても、それはそれで同じように判断して整えてくれています(前者はAmazonさんの提示情報、後者は紀伊國屋さんの提示情報をもとにしたものです。記載事項は事実上同じですが、提示順序や著者名を示す記号などが違います)。文献によってはいろいろと探さないと見つからないことがあり、データの形式が入り交じってしまいますが、それでも同じように動きます。

この結果、すごいことと思います。私はこの種の作業だと大昔はawkなどのスクリプト言語と正規表現を駆使してやっていたのですが、その枠組みでこれを整理するのは例外が多すぎてちょっとやりたくありません。LLMはいわば人間に近い感じで、あいまいで揺れの大きいデータであってもうまい具合に判断し、必要な情報を抽出してくるように思えます。

実はデータ分析の世界では、そもそも現実のデータを分析できるところまで持っていく「前処理」に相当の時間を使うことが知られています。分析そのものはかなり前から方針が定まっていることもあってむしろ時間がかからず、分析をはじめるまでにすさまじい労力がかかることが少なくないのです。整っていないデータであっても、LLMがある意味で人間のように見て必要な情報を適切に持ってくるところに何かの可能性があるような、そんな気がしました。

なお、いまプロンプトをあらためてGPT4で走らせてみて、本当に上のようなシンプルな記述でほぼ完璧に動いているのでこれもちょっと驚きました。記憶が定かでないのですが、確か実際にGPT3.5で動かしたときにはいくつかの例外処理が発生し、それらについてはさらに追記して以下のように指示をしたのでした。今回、余計な指示はしなくともリスト全体にほぼ完全に動いていました。賢くなっているのか、私がやらせた作業で何か覚えてしまったか…?

翻訳の道具として

それにしてもDeepL以来、機械翻訳の精度はもう画期的に変わったなあ、という気がしています。この種のツールに全面的に頼るようなことはないのですが(電子辞書はないと翻訳できませんが)、文の構造がとれないとか、入り組んでいて扱いが難しいなと思うときなど、かなり手際のよい処理をしてきてはっとして参考にすることはあります。あと、代名詞が指しているものをしっかりわかって必要に応じて入れ込んで訳しているときなど、ちょっとびっくりしたりしますね。一方で全然わからなそうなときに、すっぱりと訳し抜けをしたりもしますけれど。あとトリッキーな文章だと、肯定否定を完全に取り違えていることもまだ…。

なおChatGPTについては、この表現(語句)は直接的な意味から派生して、比喩的にどういう意味を持ちうるだろうか、といったことを質問して出てきたアドバイスなどが非常にしっくりくるときがありました。自然な文章の出力に長けたAIならではなのかもしれません。

私はまあ、兼業翻訳家のような感じではあるのですが、こういう仕事は苦労もありますが同時に実り多く好きな一方で、次第になくなっていくものなのかな、ということも頭をよぎります。海外のたくさんの文献を日本語で読む、読めるというのが、日本語文化に連綿と続いてきた豊かさの一つであったと思うのですが、そういう形で文化に携わる最後の世代になってしまうのかもしれないのかな、とも。

もっとも内容の深い作品について、商業出版に耐えうる翻訳というのを一気にできる段階ではないとも感じますので、まだまだやれることありそうな気もします。一方でこれからは、AIも当然に使いこなすクリエイティブな世界が広がっていくのは明らかで、それもまた楽しみに感じているところです。

追記

その1 ChatGPTの社会科学研究/教育のユースケース

学内、学外でChatGPTのFD講演をする機会がこのところありました。上記の内容も含んでいますが、あとはテキストの感情評定やAPI利用、授業コメントに対するレスポンスの生成器の試作、さらにCode Interpreterによるデータ分析と考察生成のデモなどをしています。

同志社大学社会学部で講演をしてきました。本学でも話してきましたが、2部制前半は生成AIとプロンプトの基礎、後半はテキストデータ整形や分析コード生成、テキスト感情評定やAPI活用に加え、Code Interpreterによる分析と考察出力などのデモをしました。ご清聴感謝です。表紙絵もDALL-E 2生成です。 pic.twitter.com/GXTusYVOUm

— 柴内 康文 | Yasufumi Shibanai (@yasu_shibanai) July 30, 2023

その2 文献情報整形の揺れ

このnoteアップ後に担当編集者にから、副題の区切り記号に揺れがあったので人間の側で直したよ、という指摘を受けました。ごめんなさい。

ChatGPTくん、書誌情報の配列はばっちりだったけど副題の表記方法にじゃっかん揺れがあったので(参照媒体によって表記が異なるからかも)、ニンゲンが手直し・確認して最終稿ができました。https://t.co/uIybtuAg9B

— 編集O(創元社) (@o_sogensha) July 31, 2023

その返信にも書いていますが、うちのAIアシスタントを弁護しておくとこれは指示を出した私が明示しなかったので、変に中身はいじらないでおこうとした結果かなと思います(たぶん)。実際、一言言っておけばちゃんと揃えてきます。

ここでも面白いのは、区切り記号にどんなものがあるか、指示の中でいちいち明示したわけではないことです。それでもこちらが主題、こちらが副題と判断して統一しています。そういうところが、今回の生成AIの「賢さ」だなと思います。