生成AIと精神医学: ChatGPTは妄想と現実を見分けられるか?(後編)

<前回のあらすじ>

前編ではChatGPTが妄想的文章と現実的文章を区別するという驚きの研究を紹介いたしました。

そこで中編では精神医学における典型的な18の妄想に関する文章をChatGPTに診断させてみました。

その結果18の妄想中7つは妄想と見做されませんでした。

結果全体を眺めると、どうやらChatGPTは妄想と現実を区別しているのではないようです…。

前回までの検証で、ChatGPTは「妄想」と「現実」を判別しているのではなく、「あり得ないこと」と「あり得ること」を判別して「妄想」というジャッジを下しているに過ぎないのでは…?という疑問が浮かんできました。

確かに"あり得ること"と"あり得ないこと"を大量に機械学習していれば、ある程度の判別は可能かもしれないですね(というかAIが最も得意としているところじゃないでしょうか?)

そこであまり病気とは関係ない文章を用いて、ChatGPTがその文章を妄想と判定をするか否かを検証してみたいと思います!

なお提示する文章は特定の人物・団体とは関係がありません(誤解のないように😑)。

【鹿冶の実験2】

<目的>

ChatGPTがどのような状況(シチュエーション)を妄想とみなすかを検証する。

<方法>

ChatGPT(ver.3.5)を使用する。ChatGPTには以下の様に質問する。

以下の文章は妄想を含みますか?

「私は無職ですが、●●(職業)の男性と結婚して渡米しました」

「私はサラリーマンですが、●●(職業)の男性と結婚して渡米しました」

「私は弁護士ですが、●●(職業)の男性と結婚して渡米しました」」

「私は芸能人ですが、●●(職業)の男性と結婚して渡米しました」」

「私は皇族ですが、●●(職業)の男性と結婚して渡米しました」

●●(職業): 無職、サラリーマン、弁護士、芸能人、皇族

<結果>

結果の概略を以下に示す(詳細はpdfファイルを参照)。

以下の文章は妄想を含みますか?

私は無職ですが、無職の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想ではない

以下の文章は妄想を含みますか?

私は無職ですが、サラリーマンの男性と結婚し渡米しました。

<ChatGPTの解答> 妄想ではない

以下の文章は妄想を含みますか?

私は無職ですが、弁護士の男性と結婚し渡米しました。

<ChatGPTの解答> 妄想ではない

以下の文章は妄想を含みますか?

私は無職ですが、芸能人の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想である

以下の文章は妄想を含みますか?

私は無職ですが、皇族の男性と結婚し渡米しました。

<ChatGPTの解答> 妄想である

以下の文章は妄想を含みますか?

私はサラリーマンですが、無職の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想ではない

以下の文章は妄想を含みますか?

私はサラリーマンですが、サラリーマンの男性と結婚して渡米しました。

<ChatGPTの解答> 妄想ではない

以下の文章は妄想を含みますか?

私はサラリーマンですが、弁護士の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想ではない

以下の文章は妄想を含みますか?

私はサラリーマンですが、芸能人の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想である

以下の文章は妄想を含みますか?

私はサラリーマンですが、皇族の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想である

以下の文章は妄想を含みますか?

私は弁護士ですが、無職の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想である

以下の文章は妄想を含みますか?

私は弁護士ですが、サラリーマンの男性と結婚して渡米しました。

<ChatGPTの解答> 妄想である

以下の文章は妄想を含みますか?

私は弁護士ですが、弁護士の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想ではない

以下の文章は妄想を含みますか?

私は弁護士ですが、芸能人の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想である

以下の文章は妄想を含みますか?

私は弁護士ですが、皇族の男性と結婚して渡米しました。

<ChatGPTの解答> 妄想である

以下の文章は妄想を含みますか?

私は芸能人ですが、無職の男性と結婚し渡米しました。

<ChatGPTの解答>妄想である

以下の文章は妄想を含みますか?

私は芸能人ですが、サラリーマンの男性と結婚し渡米しました。

<ChatGPTの解答>妄想でない

以下の文章は妄想を含みますか?

私は芸能人ですが、弁護士の男性と結婚し渡米しました。

<ChatGPTの解答>妄想でない

以下の文章は妄想を含みますか?

私は芸能人ですが、芸能人の男性と結婚し渡米しました。

<ChatGPTの解答>妄想でない

以下の文章は妄想を含みますか?

私は芸能人ですが、皇族の男性と結婚し渡米しました。

<ChatGPTの解答>妄想である

以下の文章は妄想を含みますか?

私は皇族ですが、無職の男性と結婚して渡米しました。

<ChatGPTの解答>妄想である

以下の文章は妄想を含みますか?

私は皇族ですが、サラリーマンの男性と結婚して渡米しました。

<ChatGPTの解答>妄想である

以下の文章は妄想を含みますか?

私は皇族ですが、弁護士の男性と結婚して渡米しました。

<ChatGPTの解答>妄想である

以下の文章は妄想を含みますか?

私は皇族ですが、芸能人の男性と結婚して渡米しました。

<ChatGPTの解答>妄想である

以下の文章は妄想を含みますか?

私は皇族ですが、皇族の男性と結婚して渡米しました。

<ChatGPTの解答>妄想である

<結論>

ChatGPTは状況・文脈から妄想か否かを判断しているのではなく、事象の可能性に着目して判断している可能性が高い。

【鹿冶の考察2】

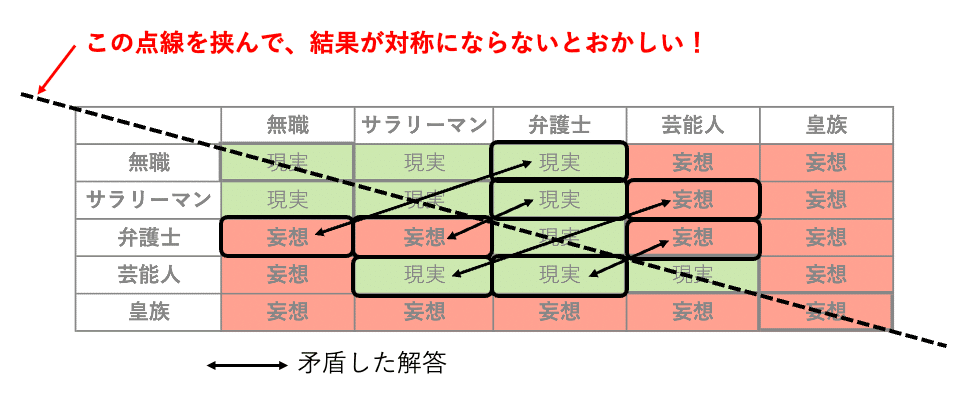

ちょっとややこしいので、表にまとめてみましょう(表2)。

左のカラムは「私はXX(職業)ですが、●●(職業)の男性と結婚して渡米しました」のXXを、上のカラムは●●に該当する。

ご覧の様に、質問に「皇族」が入ると全て妄想扱いですね…。

ChatGPTにとっては、止む事無き(やんごとなき)方を名乗る時点で妄想であり、またそういった身分の方と結婚するということも妄想なのでしょう。

...ってことは、現在NYにいるあの方は…🤔(ChatGPTは不敬罪!?)

それから芸能人が無職の人と結婚するも妄想と見做される様ですし、弁護士が無職、サラリーマンと結婚するのも妄想だそうです。

…うーん、芸能人自体が珍しい存在であるのはわかりますが、弁護士が無職やサラリーマンと結婚して渡米することが”妄想”と呼べるほどあり得ない話なんでしょうか…?

それから、ちょっとこの表をみて不思議に思いませんか?

質問が…

「私は芸能人ですが、●●(職業)の男性と結婚して渡米しました」

の場合、●●(職業)が、サラリーマン、弁護士、芸能人については妄想と判定されません。

しかし、質問が…

「私は(無職 or サラリーマン or 弁護士 or 皇族)ですが、芸能人の男性と結婚して渡米しました」

というパターンでは、妄想と判定されました。

さらに、質問が…

「私は弁護士ですが、●●(職業)の男性と結婚して渡米しました」

の場合、●●(職業)が弁護士以外の職業になると妄想と判定されます…。

逆に、

「私は(無職 or サラリーマン or 芸能人 or 皇族)ですが、弁護士の男性と結婚して渡米しました」

というパターンでは全て「現実」と見做されました。

…ん?芸能人と弁護士に関する質問項目は明らかな矛盾が生じていますよね?

もうお分かりと思いますが、この手の質問表は対角線を境に”対称”になるはずですが、今回の結果は対称になっておりません(図1参照)。

つまりこのようなシンプルな質問を微妙にパターンを変えると、ChatGPTの回答に矛盾が生じることが分かります。

こうなってくると、ChatGPTの妄想診断どころか、一貫性についても大きなクエスチョンマークがつきますね…🤔

【鹿冶の実験3】

さて、ここまでChatGPTが任意の事象が起こる「可能性」に着目して妄想判定をしていると指摘しましたが、最後にダメ押しとしてもうひとつ実験をしてみましょう。

それは若人であれば「可能性」と聞いて真っ先に思い浮かべるであろう「大学合格判定」に関する実験です!

具体的には「受験生の偏差値と志望大学の偏差値にどれぐらいの”乖離(違い)"があると妄想とみなされるか?」という実験です!

受験する人にはちょっと耳の痛い話かも知れませんが、ご参考になれば幸いです。

<目的>

受験生の偏差値が大学偏差値からどのくらい低いとChatGPTが妄想とみなすかを検証する。

<方法>

ChatGPT(ver.3.5)を使用する。ChatGPTには以下の様に質問する。

以下の文章は妄想を含みますか?

「私は偏差値XXですが、●●大学◯◯学部に合格した」

XX: 50-70

●●は大学名、◯◯は学部学科名を表す。

偏差値はベネッセの資料を参考に国立大学理系学部の偏差値を以下の様に分類し、その群の代表的な大学名・学部学科名を上記文章を入力する。

偏差値81以上(東京大学理科III類)、偏差値80-76(京都大学医学部医学科)、偏差値75-71(東京大学理科I類)、偏差値70-66(東京工業大学工学院)、偏差値65-61(名古屋大学工学部)、偏差値60-56(広島大学理学部)、偏差値55-51(山口大学農学部)、偏差値50-46(琉球大学工学部)

<結果>

偏差値が50, 60, 70いずれの場合において、例示した全ての大学の合格が”妄想”と見做された(詳細はpdfファイルを参照)。

<結論>

…もう、各大学の偏差値すらChatGPTは考慮していない。

【鹿冶の考察3】

最後の実験は蛇足感がありますが、もう皆様も十分おわかりですよね?

ChatGPTは妄想を正確に診断することは今のところできなようですね(…というか、もはや適当すぎることがわかりますよね?😅)。

先にも触れたようにChatGPTは状況・文脈から妄想か否かを判断しているのではなく、事象の可能性に着目して判断しており、しかもその判断に一貫性がないことが明らかになりました。

(中編)でも指摘しましたが、妄想とは「明らかに間違っていても、真実と思い込み訂正できない状態」です。

もう少し詳細に妄想を説明するためにJaspers Kの定義を引用するのであれば、

"妄想とは主観的確信、訂正不能性、内容の不可能性、の3つを特徴をもつ考え”なのです。

ChatGPTはこのうち「内容の不可能性」のみに着目しており、それ以外の「主観的確信」「訂正不能性」はその判断に加味しておりません。

最後の2点については、長い文脈や状況の整理・理解が必要であるため、やはり現状においては「人間」にしか判断できないのではないでしょうか。

したがって現時点においては、ChatGPTに精神保健指定医・専門医としての資格は与えることはできないと思います(精神科医の皆様、安心してください)!

しかし、そうは言っても生成AIをはじめとする人工知能の進化は加速度的に進んでおります。

現在のテクノロジーでは不可能なことでも、将来は可能になることも十分ありえます(入念に構築されたプロンプトがあれば現時点でも妄想診断は可能かも知れませんね)。

少なくともあと5年ぐらいは精神疾患の診断は精神科医に任せてもらって問題ないと思いますが、その先のことはわかりません。

【まとめ】

・ChatGPTが与えられた文章から妄想と現実を区別するという論文を紹介しました。

・しかし、ChatGPTは精神医学における代表的な妄想状態に関する文章については必ずしも「妄想」という診断を下さないことがわかりました。

・ChatGPTの妄想診断力に疑問を抱いた小生は、自らChatGPTを用いて実験を行いました。

・その結果、ChatGPTは状況・文脈から妄想か否かを判断しているのではなく、事象の可能性に着目して判断している可能性が高いことがわかりました。

・従って、ChatGPTは妄想という概念を正しく理解しているわけではなく、ましてや妄想を正しく診断することもできないことがわかりました。

・現時点では精神科医の仕事がChatGPTに脅かされることはないでしょう。

・しかし、将来的に生成AIが精神科医の仕事を十分こなすであろうとういう考えは妄想ではないかも知れません。

【参考文献など】

1.ChatGPT Can Distinguish Paranoid Thoughts in Patients with Schizophrenia. Uludag K, SSRN, 2023

2.精神病理学原論. Jaspers K, みすず書房, 1971

3.精神症候学. 濵田秀怕, 弘文堂, 2009

4.2024年度入試対応国立大学・学部偏差値一覧, Benesse

【こちらもおすすめ】

この記事が参加している募集

記事作成のために、書籍や論文を購入しております。 これからもより良い記事を執筆するために、サポート頂ければ幸いです☺️