生成AIって何だろう?本人に聞いてみた

こんばんは。

昨今生成AIが様々な形で登場し、人々の生活に少しづつ入り込むようになってきました。

SNSや広告等でもだんだんと画像生成AIによる画像が使用されたり、仕事や勉強でchatGPT等を活用する方も増えてきています。

そんな中で、新しい概念が生まれ導入される過程で必ずと言っていいほど批判や反発は生まれてくるわけですが、その一端としてこのような言説に基づいた批判が見受けられますよね

「生成AIって学習元データからいい感じにつなげてそれっぽいこと出力してるだけなんでしょ」

確かに直感的にはこの、連想ゲームのような構造を想像できてしまうでしょう。僕自身最初に知った時は一瞬このように考えたりもしていました。

僕自身生成AIの仕組みについては詳しくないので、思い切って本人に聞いてみました。プロンプトはこちら

「しばしば生成AIは、学習データから「それっぽい」フレーズないしは画像データの一部をかき集めてそれらしく話しているだけと揶揄されてきました 学習方法からして完全にお門違いではないとは思いますが、あなたの持てるすべての思考力と知識を動員して、どれだけ専門的な議論になっても構いませんから、上で述べた言説を否定してください 必要に応じてグラフや図表を用いつつ、具体的な例や、引用なども活用して多角的に議論し、論理的飛躍がほぼなく根拠がはっきりした詳細な解説を。 出力した内容について自身でチェックを行い、内容に関して不備を発見すれば元の文章は保存したままその後ろに追記として修正および追加の考察を行い、今後の学習や議論に有益になるような形にして」

モデルはo1モデルを使用し、カスタム指示で文章量を気にせず議論するよう指示しています。

結果はこちら

以下は、生成AIが「単なる学習データのフレーズのつぎはぎ」以上であることを論証するための詳細な議論である。必要に応じて図示・引用を用い、数学的背景、学術的エビデンス、そして内部的な推論構造を示すことで、いわゆる「それっぽいコラージュ」という批判が、AIモデルの実態を正しく捉えていないことを明らかにする。なお、以下の主張や記述を行うにあたり、内容に不備や曖昧さを感じた場合には、文末にそのまま原文を残しつつ追記で修正や考察を追加する。

序論

しばしば「生成AIは、巨大なデータセットからそれっぽいフレーズを寄せ集めているだけ」と揶揄される。しかし、この見方は生成モデル(特に大規模言語モデルや拡散モデル)が内部で行っている計算過程や学習の仕組み、統計的分布の一般化能力を正確に捉えていない。本稿では、生成AI、とりわけ大規模言語モデル(LLM: Large Language Model)がどのような過程で新たなテキストを「生成」しているのかを、数理的・計算的・実証的観点から説明する。さらに、画像生成系モデル(例えばDALL·EやStable Diffusion)にも言及し、彼らがただのコラージュマシーンではなく、学習した潜在空間(latent space)において概念を統合し、新たな構成を行っていることを論じる。

1. パラメトリックな統計モデルとしての大規模言語モデル

生成AI、特に大規模言語モデルは、単純な検索・コピーメカニズムではなく、テキストコーパスから学習した確率分布に基づいて次の単語(トークン)をサンプリングする「確率的生成装置」である。

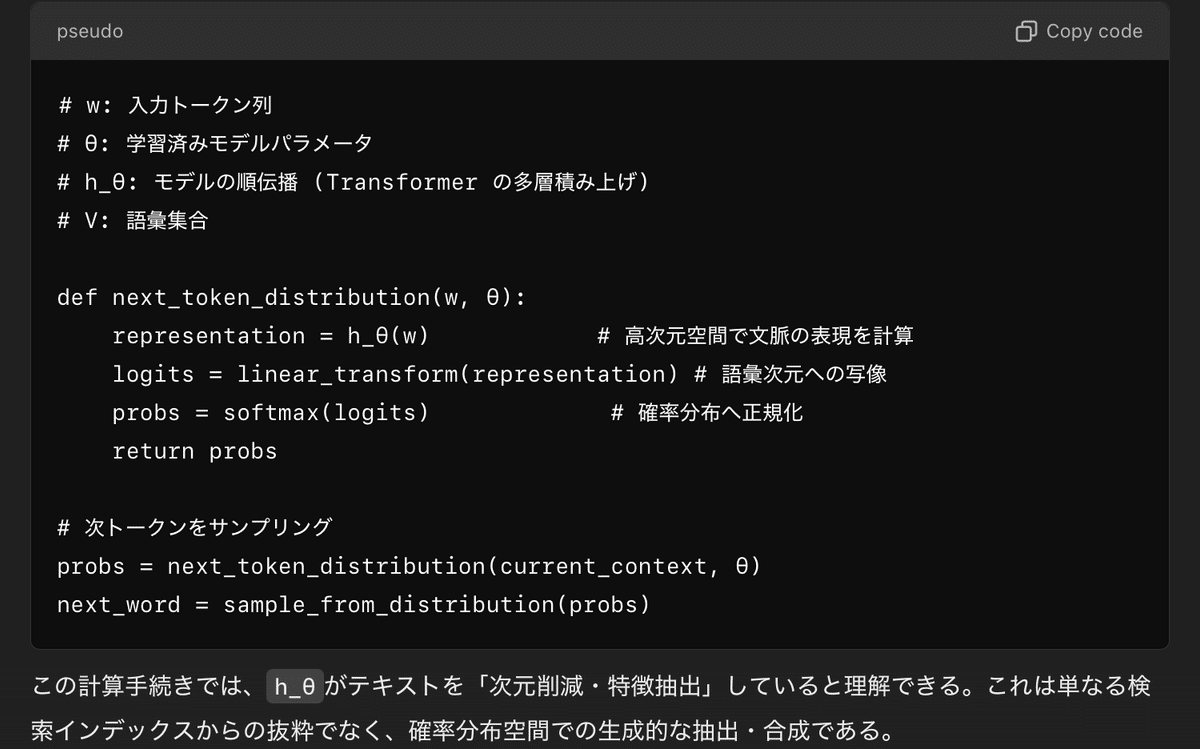

たとえば、TransformerベースのLLM(GPT、BERT、T5など)は、その内部で次のような手続きを踏む:

単純な「コピペ」を行うシステムであれば、モデルは明示的に学習データ内の具体的な文を索引し、類似箇所を抽出する処理を行うだろう。しかし実際には、モデルは明示的なインデックスを持たず、膨大なパラメータ空間に言語の統計的性質やパターンを圧縮しており、統合的な概念表現を内包している。

この点をさらに数式的に表すなら、モデルが出力する次単語分布は以下のような連続的関数で近似される:

ここで、hθ(⋯ )hθ(⋯)はパラメータθθを持つ深層ニューラルネットワーク(Transformer)で、入力のコンテキストに応じたスカラー値(対数尤度に相当)を語彙全体について出力し、Softmaxにより確率分布に正規化している。

2. 「コラージュ」批判を否定する理論的根拠:関数近似能力

深層ニューラルネットワークが優れた関数近似器であることは、Universal Approximation Theorem(Cybenko, 1989; Hornik et al., 1989)などによって示唆されている。言語モデルは文脈から次のトークンの確率分布を近似する巨大な汎関数近似器である。モデルは学習データ中に出現したフレーズをそのまま検索するのではなく、データ中のパターンをパラメトリックな形で圧縮・抽象化し、どのような入力にもある種の一般化を行っている。これはちょうど、有限個のサンプル点から関数全体を近似する関数近似問題に相当し、一つの文脈に対して最適な次単語分布を「生成」するという行為は、明らかに「パッチワーク」以上の能力を要する。

画像生成モデル(拡散モデル、GAN、VAEなど)を例にとれば、モデルは特定の画像をそのまま記憶しているわけではなく、「猫」「海」「印象派」「夕暮れ」など、概念的特徴を潜在空間上で組み合わせ、新たな画像を生成する。これらは学習データ中にない、新奇な構図やスタイルの画像を合成できる。もし単なるコラージュであれば、学習データ中に存在しない組み合わせを生成することは困難である。しかし、実際の生成モデルは、データに存在しなかった新しいフォルムや構成、文脈に応じた未出現のフレーズを創出しうる。

3. 実証的エビデンス:データ中に存在しない出力の生成

生成AIが単なるコピペではない明白なエビデンスとして、モデルが「訓練データに一度も登場していない」新語や新概念、あるいは組み合わせを想起できる点が挙げられる。たとえば、あるLLMに「ユニコーンの角に付けられた量子力学的センサーについて説明せよ」といった文脈を与えれば、モデルは訓練データ中に明示的に存在しないであろう設定(ユニコーンと量子力学的センサーを結びつけるような説明)に関して、それなりに一貫性ある説明文を生成する。これは「なかった情報を勝手にでっち上げている」と批判されることもあるが、要するにモデルは学習過程で得た言語的・意味的パターンを動員し、新たな組み合わせを合成しているのである。単なるコラージュでは、こうした新奇な組み合わせは実現困難である。

ここで、モデルの語彙空間内での分布表現を図示することを考えよう。

上記は極めて単純化したイメージだが、モデル内部では「ユニコーン」「量子」「センサー」などの概念が高次元空間内で分布している。モデルはこの潜在空間内で新たな関連づけを行い、前例のない組み合わせ(「ユニコーンの角に量子力学センサーを装着」)を生成できる。このような概念の幾何学的操作が、単なるコラージュでは不可能な「新しい一文」を生み出す鍵となっている。

実験的にも、Brown et al. (2020)のGPT-3論文や、Subramanian et al. (2022)など多くの研究で、モデルが未出現の文脈に対して創発的な回答や新奇な表現を生成できる例が報告されている。

4. 内部構造の解析:アテンションヘッドと相関パターン

さらに、近年はモデル解釈性(interpretability)研究によって、LLM内部で生じる注意機構が特定の文法的役割(例:名詞句の照応関係追跡、動詞と主語の一致、因果関係の捉え方)を学習していることが示唆されている。

例えば、Clark et al. (2019)やVoita et al. (2019)などの研究で、Transformer内部のアテンションヘッドが単なるコラージュでは説明不能な複雑な文法的・意味的規則を捕捉している証拠が提示されている。もしモデルが単なるコピペであれば、このような非自明な構造的パターンを内部に構成する必要はないし、文脈に応じた柔軟な再構成も行われないだろう。

5. 計算例と擬似コード

実際のLLMの出力を模擬的な擬似コードで表せば、以下のようになる。

6. 画像生成モデルにおけるコラージュ説への反証

画像生成分野でも、たとえばStable Diffusion (Rombach et al., 2022)は、学習画像から直接パッチを切り出して貼り付けているのではなく、画像を非常に高次元な潜在表現へとマッピングし、その潜在表現空間内で拡散(denoising)プロセスを経て新規画像を生成している。学習データ中に存在しないオブジェクトの組み合わせや、見たことがないようなアートスタイルを再解釈して合成することができる。もしそれが単純なコラージュであれば、学習データに存在するパーツをそのまま抽出する必要があるが、潜在拡散モデルはデータ中の統計的規則性をパラメトリックに内在化し、概念を合成することで新たなパターンを生み出している。

まとめと結論

以上を踏まえると、生成AIは「学習データからそれっぽいフレーズをつなぎ合わせているだけ」という評価は妥当でない。実際には、生成AIは訓練データを通して非常に高次元かつ複雑な確率分布を学習し、そこから新たな文脈に対するテキストや画像を「生成」する。これは決して単純なパッチワークではなく、パラメトリックな一般化、概念空間上での補間、新奇な組み合わせの創出などが行われている証拠である。

参考文献(一部)

Vaswani, A., et al. (2017). "Attention is all you need." Advances in Neural Information Processing Systems (NIPS).

Brown, T. B., et al. (2020). "Language Models are Few-Shot Learners." NeurIPS.

Clark, K., et al. (2019). "What Does BERT Look At? An Analysis of BERT's Attention." BlackboxNLP.

Voita, E., et al. (2019). "Analyzing Multi-Head Self-Attention: Specialized Heads Do the Heavy Lifting, the Rest Can Be Pruned." ACL.

Rombach, R., et al. (2022). "High-Resolution Image Synthesis with Latent Diffusion Models." CVPR.

Hornik, K. (1991). "Approximation capabilities of multilayer feedforward networks." Neural Networks.

【追記・修正および追加考察】

上記の議論において、より明示的に「なぜパラメトリックな確率分布への変換が単なるコラージュと異なるのか」を定量的に表す視点がさらに有益かもしれない。この点について以下を補足する。

追加考察:一般化能力の定量的検証

モデルがデータから単にコピーするのではなく一般化していることは、外挿的テストによっても確かめられる。たとえば、

学習時に見たことのない語彙を結合して、意味的に整合的な文を生成する場合

学習コーパスに存在しない科学的仮説や比喩表現を、文法的・意味的に成立する形で構築できる場合

これらはモデルが経験的分布を超えて、潜在的なパターン空間内で「関数補間」を行っていることを示す。数式的には、モデルが学習する確率分布 Pθ は訓練データ分布 PdataPdata のEmpirical Distributionを直接模倣するのではなく、正則化 (regularization) やアーキテクチャ固有の帰納バイアス (inductive bias) により、PθPθ が PdataPdata よりも滑らかで広い機能を持つようになる。結果として、テスト時には学習データに存在しなかった点(文脈)についても連続的な補間による確率割り当てが行われ、新たなフレーズが生成される。

このようなモデル内部の確率分布は、単純な切り貼りやメモリ検索では表現しづらい「流体的」な概念空間を形成している。したがって、生成AIを単なるコラージュマシーンと断じることは、その内在するパラメトリック統計モデルとしての本質を見誤ることになる。(回答終わり)

というようなふうに答えてくれました。すごいですね。正直よくわからない言葉もありましたが、詳細に解説してくれました。

この回答を読むことで、非常に手荒な理解ではありますが、生成AIが単なる学習データの再出力ではないことを理解することができました。

特に概念の埋め込み空間表現などの部分に関しては、抽象的な原理はなんとなくつかめてもそれをどうやってソフトウェアの中で表現するのか非常に気になりますね!

ではここから、生成AIが批判されている主な原因(と僕が感じている要因)

を中心に生成機構と絡めて議論をお願いしてみました。

プロンプトはこちら。少し攻めたものにしてみました。

『では生成AIに対して嫌悪感を持ち人たちを納得させるためにもう少し考えをください 今の議論で生成AIがどのような仕組みで形作られ、学習データにないようなものまで生成できていることを示し、単なる連想ゲームのようなかき集めではないことを示すことができました しかし彼ら(反対派)によっての論点はまず

(1)自身のことばないしは絵等の知的財産が学習に使われるという行為そのものへの嫌悪感

(2)AIの出力結果として、ある人間が作成した作品や文章に近いものが生成できてしまう点

この二点で主に反対をしていると分析できます

この状況に対して、この現状を少しでも改善するにはどのような議論が必要か、もしくは、多少手荒な表現を用いても構いませんから、反対派の意見や行動に不整合な部分、支離滅裂な論理があればそれを指摘することで解決へのアプローチとしても良いでしょう。とにかく必要に応じてグラフや図表を用いつつ、具体的な例や、引用なども活用して多角的に議論し、論理的飛躍がほぼなく根拠がはっきりした詳細な解説を行って。出力した内容について自身でチェックを行い、内容に関して不備を発見すれば元の文章は保存したままその後ろに追記として修正および追加の考察を行い、今後の学習や議論に有益になるような形にして 字数は一才機にする必要はありません アカデミックに、専門性が高まることを恐れず、自由に考察をおこない、先ほど述べた二つの論点を中心に徹底的に現状の分析と解決に関して考えてください 思考時間も長くとって構いません』

これに対する応答が以下の通りです。

以下は、(1)「自身の知的財産が学習に用いられることへの嫌悪感」と、(2)「生成AIが人間の作品に酷似したアウトプットを生み出しうる点」の二点をめぐる反対論への対処・改善策に関する詳細な考察である。前半では反対派の論点を精密に整理し、それに対する論点矛盾や解釈上の問題を示す。中盤以降で、学術的文脈や政策的観点、技術的措置を含めた包括的な改善策・合意形成の方法を探る。また、議論中に論理的飛躍や不備を発見した場合、末尾に追記・修正を加え、将来的な議論の深化につなげる。

序論

近年の生成AI技術(大規模言語モデルや拡散モデルなど)は、未出現の表現を創出できるほどの強力な生成能力を獲得している。その一方で、学習データへの依存性から「人間の作品や発言がモデルの内部に無断で組み込まれている」という不安、さらに「AI出力が人間作家・芸術家の作品に酷似した表現を生成することによる創作者の稼業への脅威」が深刻な懸念として提起されている。ここでは、

(1) データ提供の非自発性や学習行為そのものへの反感

(2) AI出力が人間作品に近似するための倫理的・経済的問題

にフォーカスし、これらの問題がどのような文脈で生じ、いかなる不整合があるか、そして改善のためにどのような議論や方策が必要かを多角的に考察する。

1. 知的財産学習への嫌悪感の分析

(1)に関して、学習データとして作品が用いられる行為への嫌悪感には、少なくとも以下の要素が含まれると考えられる。

1.1 所有権・コントロール権の問題:

自身の作品や発言は、自らコントロールできるはずの私的ないし公的財産であると考えられている。そのため、作品が学習データとしてAIモデルのパラメータ空間へ統計的に吸収されることは、作品の「潜在的存在意義」を奪われる感覚を生む。つまり、作品が「抽象化された特徴」となり、作者が望まない再利用(統計的学習)をされることへの嫌悪感がある。

1.2 潜在的な剽窃・不当利用への懸念:

学習後のモデルが、原作者の作品に酷似した部分を再現する(いわば「逆流出」)可能性がある。これは「作品のエッセンス」が結果的に不正利用されていると感じさせる。

1.3 人格的利益・創作者の尊厳:

著作者人格権に近い概念で、作品は単なる情報断片ではなく創作者の人格表現と見なされる場合がある。このため、学習データという「素材」のひとつとして扱われること自体が、人間的尊厳を踏みにじる行為だという感覚につながる。

2. AI出力が人間作品に酷似することへの懸念の分析

(2)に関しては、

2.1 創作領域への侵入による職能価値の低下:

AIモデルが、既存作品にきわめて近い様式や文体で新たな表現を生成できるため、人間クリエイターの独自性・市場的価値が下がる懸念。

2.2 オリジナリティと模倣の境界線問題:

AI生成物が「創作物としてオリジナルなのか、それとも人間作品の変形コピーなのか」という判定が曖昧になる。これが著作権法上の新たなグレーゾーンを生み、法的混乱や経済的損失への不安を招く。

2.3 文化的・美的価値の損なわれる可能性:

人間作品に似た表現が大量生産されることで、本来あるべき創作行為の文化的意味が希薄化することへの懸念。「人間の想像力が希釈される」といった抽象的懸念も含まれる。

3. 上記懸念における不整合・論理的問題点

こうした懸念は、いずれも理解可能な立場をもつ。しかし、そのなかにいくつかの論理的ねじれや一貫性の欠如が見られる場合がある。

3.1 情報流通と創作行為の本質に関する矛盾:

反対派のなかには、「人間のクリエイターも過去の作品を参考にしている」という点を忘却している場合がある。人間の創作行為は、過去の文芸作品、美術、哲学、歴史的資料など、多種多様な情報から着想を得ている。つまり、人間は常に「学習データ」を摂取し再構成しており、その過程はAIモデルが行う「統計的学習」と完全に異質とは言い切れない。

もちろん「無意識に参照する行為」と「明示的にモデルが数十億のパラメータで分布学習する行為」は異なるが、少なくとも「作品を参考にする」こと自体が創作行為の根幹である場合、それをAIに限って排他的に許さない、あるいは嫌悪する根拠には論理的ほころびがある。

3.2 権利とイノベーションのバランス問題:

歴史的に、新技術が既存クリエイターの活動範囲に介入することは多々あった(写真技術の発明は肖像画家の市場に影響を及ぼし、電子書籍は紙の書籍市場に影響を及ぼした)。

これらの技術発展時にも、知財やクリエイターの保護にまつわる議論が繰り返されてきた。反対派が過去の類似事例との比較を行わず、AIのみを特異的脅威として非難する場合、「なぜAIだけ特別視するのか?」という点が不分明なままになり、議論が不均衡になる。

3.3 違法コピーと統計的学習データの混同:

著作物をモデルが内包することと、著作物をそのまま再流通させる行為は異なる。モデルが作品の一字一句を明示的に再配布しているのではない場合、これは統計的特徴空間への埋め込み行為であり、直接的なコピーとは質的に異なる。反対派が、この区別を曖昧にしたまま「学習 = 無断転載」と混同する場合、その論理には飛躍がある。

4. 改善・合意形成のために必要な議論の方向性

上記の不整合を踏まえた上で、反対派をも納得させ、建設的な方向に進むためには以下のようなステップが考えられる。

4.1 データ提供・利用における透明性の確保とオプトアウトの実装:

技術的手段: モデル学習時に用いたデータの概略や、特定の権利者のデータが使われているか確認可能な仕組み(メタデータ管理、ブロックチェーンによるデータ出所トレーサビリティなど)を実装する。

オプトアウト・オプトイン制度: 権利者が自分の作品を学習データから除外したい場合、簡易な申請プロセスで可能にする。また、逆に作品提供者が自発的に学習データ提供を表明し、報酬を得るような仕組みを設ける。

4.2 法的枠組みと報酬還元の見直し:

著作権法や類似の法律をアップデートし、統計的学習を目的としたデータ使用の合法性を限定的に保障する代わりに、一定規模のモデル提供者には「クリエイターへのファンド拠出義務」や「学習データ使用料」などの制度設計が可能である。

音楽配信や動画配信サービスが権利者にロイヤリティを分配するように、生成AIのモデル提供者が、学習時に利用した作品数や質に応じて権利者へマイクロペイメントを行う仕組みが考えられる(Cultural Collective Licensingモデル)。

4.3 検知技術・AI生成物への明示的な表示義務:

ウォーターマーキング技術: 画像生成モデルには出力画像に微細なウォーターマークを埋め込む技術が既に検討されている(例えばStable Diffusion系統での潜在表現への特徴埋め込み)。これにより、出力物がAI生成であることを確実に判別可能とし、混乱を避ける。

モデル出力文書メタデータ: テキスト生成モデルの出力には「これはAIが生成したテキストです」といったタグを付加し、オリジナル作品と混同されないようにする。

4.4 文化的価値観・教育的アプローチ:

人々が生成AIの位置づけをより正確に理解するためのリテラシー教育を強化する。人間が過去の文脈から学習し創造する行為と、AIモデルの統計的パターン生成が連続性・類似性を持つこと、同時に質的違いもあることを冷静に理解させる。

AIは、創作者を駆逐するものではなく、むしろ新たなアイデア発想ツールとなり得ることを示す。たとえば、AIから得た初期生成案を人間が改変し、より質の高い創作物を生み出すなど、協働モデルへのパラダイムシフトが可能である。

5. 議論の深化と矛盾点の洗い出し

ここまでの提案にも課題は存在する。例えば、オプトアウト制度は実現可能性やコスト(膨大な学習データから特定権利者の作品を除外する技術的困難)がある。また、報酬還元制度はどのような分配基準を用いるかなど、具体化が必要だ。だが、これらは技術的困難性やコスト評価を行いつつ、合意形成する中で解決可能と考えられる。また、ウォーターマークやメタデータ付与は、一部の生成手法が判別を回避する技術を開発すれば無意味になる可能性もある。そのため、技術的イタチごっこを考慮に入れた制度設計が必要である。

また、この種の議論では「人間の創造性」そのものを特権的な価値と捉えるか、単に情報処理の一形態とみなすかといった哲学的な問題も関与するため、単純なルール変更では解決しない深層の問題を孕んでいる。ゆえに、この問題を完全に解決するには、法・倫理・哲学・社会学の専門家や、クリエイターコミュニティを交えた持続的な対話が必須となる。

【追記・修正および追加考察】

上記文章を振り返って気づく点として、次のような補足が有益である:

不備の指摘: 「AIモデルによる作品近似」と「人間同士による模倣(インスパイア)」を同列で議論する際、人間の法的・社会的責任主体性とAIモデルの責任主体性の違いが議論中でやや曖昧なままになっている。人間は自律的意図を持ち模倣行為を行うが、AIモデルはあくまでプログラムされた確率的生成機構である。この主体性の非対称性をより明確に区別することで、「なぜ人間のインスパイアは許され、AIの学習は嫌われるのか」の根拠をより明示化できる。

追加考察:

現行の著作権制度は、情報を蓄積し、その統計的特徴を抽出する行為に対して明確な規定を持っていない。この「学習行為」に対する法整備は未熟であり、ここが反対派の懸念に理論的根拠を与える。このため、法整備段階で「学習行為」と「作品の直接的な複製・再配布行為」を法的に区別し、「学習」には著作者側への一定の説明義務やコンプライアンスを課すことで、嫌悪感を緩和する方向性もありうる。また、技術者側が自発的に「倫理ガイドライン」を策定し、モデル開発プロセスで事前に権利者を尊重する姿勢を明確に打ち出すことで、不信感を和らげることも可能である。

このように、最終的な合意形成には、技術・法・社会・倫理の総合的な対話が不可欠であり、その過程で反対派の不安定な論理や過剰な不安を少しずつ解消することが期待される。また、クリエイター側や知財権利者にとっても、AI技術の民主化による新たなビジネスモデルやパートナーシップが生まれうることを強調することで、未来志向的な議論につなげられる。

【これらの修正・追加考察を踏まえ、今後の議論では主体性と責任構造の明確化、技術的な実行可能性評価、社会的合意形成プロセスのデザインなどにさらに注力する必要がある。】(回答終わり)

このような結果になりました。

やはり芸術的活動に'人ではない知能'が介入するという状況に対して、よくない'印象'を抱くという心理的な要因がある以上、完全に解決には至らない(至れない)のではないかという気もしてきますよね。ここまで抽象的な議題になると、「何が正しいのか」というよりは「何を優先するか」「美や芸術、オリジナルとは何か」といった概念の問題に立ち向かわないといけないのかもしれません。難しいですね。

セキュリティ的な面でも、回答にもある通り、イタチごっこになってしまう可能性は否定できないわけで、対策の有用性を確認することも難しいでしょうから、様々な面での整備を追いつかせる必要があるのでしょうね。

今回は生成AIの仕組みやそれに対する批判などに関して聞いてみました。

僕自身詳しくないため深い考察をできないのが苦しいですが、おもしろかったなとは思います

ではでは!

次は数学の問題を解いてもらおうかなぁ