クリックするだけ!ローカルLLMを入れよう!PART2 LM Studioで噂のDeepSeekを日本語で試す!

前回は7Bを入れて日本語でまともな会話ができなかったので、CyberAgentの32Bを入れたいと思います。

やっぱり簡単だったので、速攻でnoteに書くことができました!

↓ 下記が前回の記事です

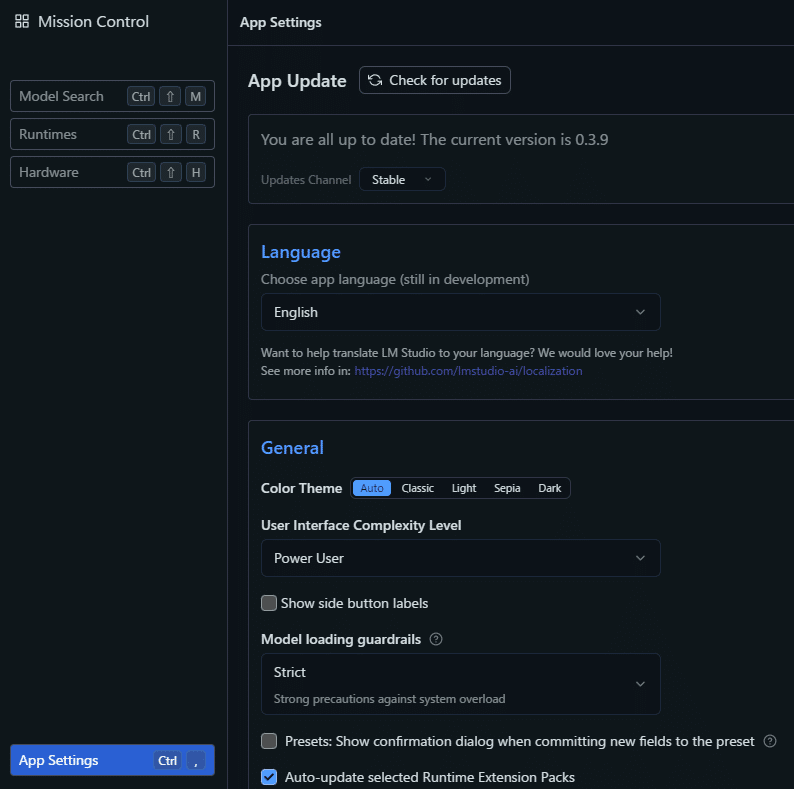

今回、一番悩んだのはココです。どこからLLM追加するのか探しましたところ。右下の「歯車マーク」から行けるようです。

クリックすると設定画面が出るので左上の「ModelSearch」をクリックするとLLMを検索できます。ついでにLanguageで日本語に切り替えましょう。

こちらが検索画面です「cyberagent」でokです。

下記のように、似たようなのが沢山出てきますが、それぞれ何か後ろに文字が追加されているのは、量子化(軽量化)など何か改良されているタイプのようです。通常、精度は落ちる場合が多いようですが、モノによって違うので詳細は不明です。

何か軽量化や改良がされています

ダウンロード数が圧倒的な、14B、32Bが、それぞれあります。

まずは32Bを試してみます。

ダウンロードが完了したら「Load Model」でモデルを読み込みます。

そんなに細かく

説明しなくてもいいのかな

読み込みが終わると利用可能になります。。

さっそく前回7Bと同様の質問から。。。

ただし、私のスペックでは残念ながら1分20秒もかかりました。。。

まるで前回の7Bの人が裏で一生懸命考えて喋っているかのような速度です。。

※私は RTX3060Ti で VRAMが8Gしか無いです。。

ChatGPTに聞いたスペック対応表です ※参考程度に

とりあえず前回と同じ質問をしてみます。

7B と同じ雰囲気なのに、急にまともに返答されると、当時のおかしな返答の記憶が蘇りましたが、まともな結果です!

クロサワを黒川と伝えてるので少しおかしいですが、ウソの返答じゃないのでOKです。32Bでも日本語利用はギリギリ?

ただし処理時間が2分56秒なので、やはり7Bの人が裏で一生懸命考えているようです。

ということで、早速14Bを試してみたいと思います!

14Bのモデルをダウンロード

とりあえず同じの

来ました。48.40秒、カワイイ絵文字付き

「こんにちわ、日本語は理解できますか?」

7B = 0.29秒

14B = 48.40秒

32B = 1分29秒

ちなみに私のPCの結果なので高スペックのグラボなどを積んでいるならもっと早いかと思います。

また、リソース割り当ての設定変更、チューニングもできるようですが、今回は特に設定はいじってない初期状態です。

それでもリソースギリギリまで使ってましたが。。

とりあえず、同様にこっちもやっておきます。

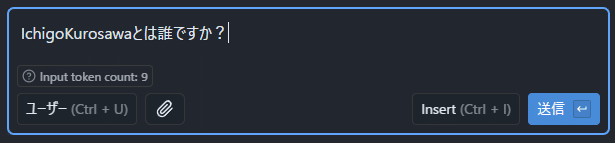

「IchigoKurosawaとは誰ですか?」

7B = 2.53秒

14B = 1分2秒

32B = 2分56秒

7B圧倒的に早いですね。。。

ちなみに下記がURL

https://ichigo-kurosawa.com/

そんなサイトありませんでした。。

そして、長男は、久雄。

7Bと32Bの中間の14B。。。これがハルシネーションってやつでしょうか。。。それっぽい返答で間違えている。。

まとめ

と。。とりあえずローカルLLMとして提供されているのはウレシイですね。

いろいろな利用用途や今後の期待が大きいです。

当然の結果ながら、32Bの返答内容が一番良かったと思いますが、遅いのでもっとスペックの良いPCを買わないとです。。。

また今度、いろいろ挑戦してみたいと思います!

いちおう補足ですが、公式などで利用できるのは桁違いでパターンが巨大で賢いので勘違いしないように。。最新、公式だと2025/02/06現在

DeepSeekV3で671Bとのことです。

いいなと思ったら応援しよう!