【超入門】Hugging Faceの長いモデル名のggufモデルをPage AssistでOllama用にダウンロードする方法

先にこちらの記事を書きました。

上記記事の最後に、本タイトルの内容を書いておきましたが、モデル名が長い時には別方法があるので、こちらの紹介です。

追記:2024.11.6

Page Assistのバージョン 1.3.3 で直下のパネル表示が修正されて、ちゃんと見えるようになりました。

まず、モデル名が長い場合どうなるかをお見せします。

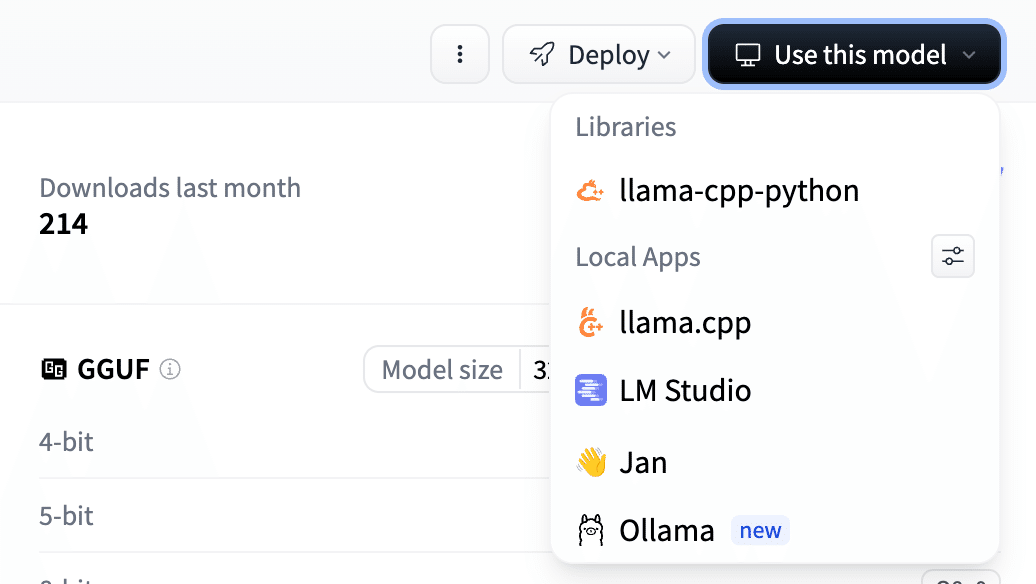

こちらのモデルのページで、以下のように【Use this model】を選んでみましょう。

こうなって、量子化を選ぶ部分が隠れてしまいます。

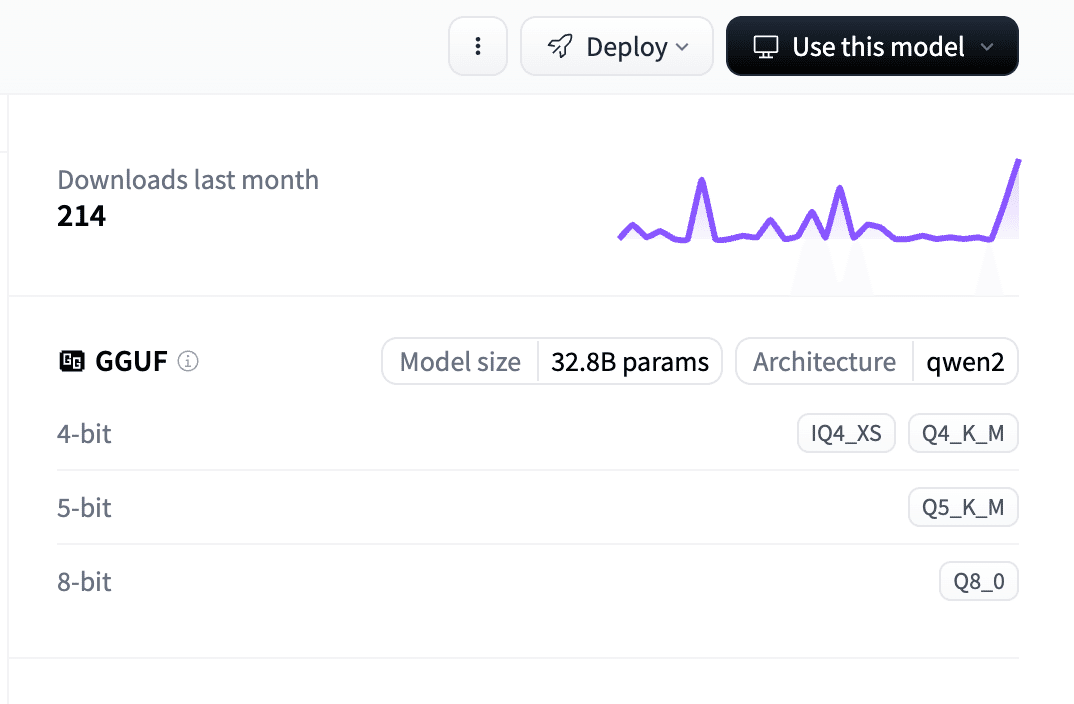

ということで、まずは先にどの量子化モデルをダウンロードするかを選んでください。この場合、以下の画像の IQ4_XS, Q4_K_M, Q5_K_M. Q8_0 が選択できます。

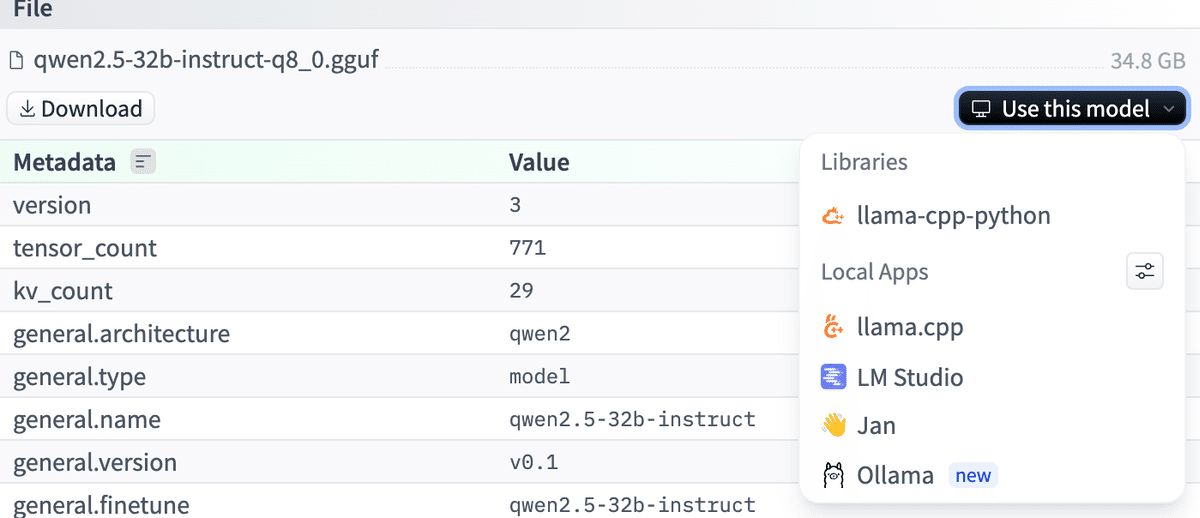

たとえばQ8_0をクリックしましょう。そうすると、画面右側に、以下のパネルが出てきます。パネル上に 【Use this model】が右上に見えます。

ここからは今までと同じです、このパネル上で同様の手順をとってください。

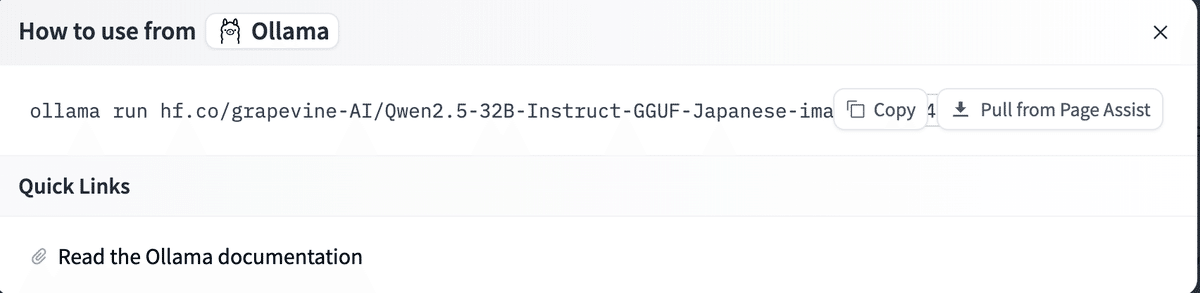

Ollamaを選択することで、以下のように量子化がどれかは画面上ではみれませんが、【Pull from Page Assist 】で選んだQ8_0がダウンロードできます。

(不安でしたら、Copyでどこかで確認してみてください。この場合は下記となり、たしかにQ8_0の量子化モデルが指定されていることがわかります。)

ollama run hf.co/grapevine-AI/Qwen2.5-32B-Instruct-GGUF-Japanese-imatrix:Q8_0

それでは、Page AssistとOllamaでローカルLLMの世界をエンジョイしてみてください。

#AI #AIとやってみた #やってみた #ローカルLLM #LLM #大規模言語モデル #HuggingFace #Ollama

いいなと思ったら応援しよう!