ディープフェイクの検出技術:社会実装への期待

ディープラーニングとフェイクの合成語である「ディープフェイク」。今では、生成AIと同様にアルゴリズムの高度化、コンピューティング・リソースの拡大、データの入手容易化などから、これら技術を悪用しょうとする者の参入障壁が低くなり、ソーシャルメディアを中心に拡がって、政治やビジネス、個人に対するその問題が拡散してしまっています。

一方で、これらのフェイクを検出するための技術も進歩しており、ディープフェイクを音声解析から99%の精度で検出するテクノロジーも既に商用ベースで存在し、これらホワイト・テクノロジーの社会実装が期待されています。

この投稿では、ディープフェイクの検出技術を提供しているPindrop社のCEO、ヴィジャイ・バラスブラマニアン氏とアンドリーセン・ホロウィッツのジェネラル・パートナーであるマーティン・カサド氏の会話を紹介するものです。

[主なサブテーマ]

ディープフェイクによる詐欺や犯罪

ディープフェイク技術の高度化

ディープフェイク検出技術の原理

政策・規制と民間の役割

1. Pindrop社概要

Pindrop社は、ジョージア州アトランタに本社を持つ2011年に設立された電話詐欺の検知やコールセンター向けの認証技術を開発・提供する”非上場企業”です。

Pindrop社の主力製品である「Pindrop Voice API」は、音声(声紋)をもとに個人を識別し、録音音声やなりすまし音声を検出する次世代の生体音声認証技術で、特定の言語やテキスト、環境に依存せず、高精度な認証を短時間で実現します。また、ディープフェイク音声の検出にも対応しており、AI生成の音声を99%の精度で識別する「Pulse Inspect」というツールも提供しており、音声セキュリティ、本人確認、詐欺検出の分野で高く評価されて、銀行、保険、証券業界などで幅広く採用されています。日本市場に対しては、2023年3月より国内代理店を通じて事業を展開しています。

2. インタビュー&ディスカッション

[ヴィジャイ・バラスブラマニアン](Pindrop)

我々はディープフェイク(Deep Fake)の検出を約7年間続けています。

そのような音声や映像の操作については、それ以前から行われており、ナンシー・ペロシ氏のスピーチがゆがめられた事例などが見られていました。

「ローズガーデンで、こうした、えーと、視覚的な…」

[ヴィジャイ・バラスブラマニアン]

彼らが行ったのは、ただ音声をスローにしただけで、ディープフェイクではなく単なる「チープフェイク」(Cheap Fake)でした。違いは、音声や映像のクローン化を改良するため、GAN(Generative Adversarial Network:敵対的生成ネットワーク)と呼ばれる技術が使われるようになったことです。これによって、より本人そっくりのものを作り出すことが可能になっています。二つのシステム(生成モデルと識別モデル)が競い合うような仕組みで、目的は、マーティンの声や顔にどれだけ近づけるか、というものです。

一方のシステムが、これが機械か人間か見分けられるか?と異常を見つけ出そうとします。いわば逆チューリングテストのようです。そしてこのGANの処理を何度も反復することで、システムは非常に高い精度で訓練され、ディープラーニングのニューラルネットワークによってディープフェイクが生まれます。このような技術が向上した結果、人間と機械を区別することが非常に難しくなってきています。

[マーチン・カサド]

ディープフェイクは以前よりも多く話題になっていますよね?

[ヴィジャイ・バラスブラマニアン]

そうですね。

[マーチン・カサド]

そして、この現象が生成AIの波と重なっているように見えませんか?生成AIの波に乗って、新しいタイプのディープフェイクが生まれていると言えるでしょうか?

[ヴィジャイ・バラスブラマニアン]

生成AIによって素晴らしいことがたくさん実現できるようになりました。

ただし、初めの頃は、声をクローンできるツールは一つしかありませんでした。「Lyrebird」というツールで、さまざまな素晴らしい用途に使われていました。

[ヴィジャイ・バラスブラマニアン]

昨年末には誰かの声をクローンするためのツールが120種類ありましたが、今年3月には350種類にまで増えました。オープンソースのツールも多く、人の声や姿を簡単に模倣できるようになり、そのコストもほぼゼロに近くなっています。たとえば、今ではあなたの声をクローンするのに3〜5秒の音声データがあれば十分です。高品質なディープフェイクを作るには15秒ほどの音声が必要ですが、それでも以前とは大違いです。生成AIが普及する前、ジョン・レジェンドがGoogle Homeの音声になった際は、録音スタジオで約20時間もさまざまなセリフを録音しました。彼が「サンフランシスコの気温は37度です」と言えるように準備するのに、20時間かかっていたんです。それが今では15秒の音声と、300以上のツールがあればできてしまうのです。

[マーチン・カサド]

覚えているか分かりませんが、そんなに昔のことじゃないんです。私が日本にいたとき、普段かかってこない両親から電話がかかってきて、母が「今どこにいるの?」って聞いてくるんです。「日本だよ」と答えると、「嘘でしょう?」と。で、また「日本にいるよ」と言うと、母が「ちょっとお父さんにも聞いてみる」と言って父が電話に出ました。父も「今どこだ?」と聞いてくるので「日本だよ」と答えると、父は「さっき君と話したとき、君は刑務所にいると言っていて、今10,000ドルの保釈金を届けに行くところだったんだ」と言うんです。

私は「何の話?」と聞き返しました。すると父は、「誰かから電話がかかってきて、君が交通事故にあって負傷して声が少しこもっていたから、現金を指定された場所に持ってくるように言われた」と言いました。母が電話をかけてくれたおかげで、その途中で気づくことができました。この後、警察に通報しましたが、これはよくある詐欺手口で、恐らく私の声を真似して声をこもらせて騙そうとしたのだろうということでした。こういった声を変えて人を騙す手口は以前から存在していますが、このような生成AIによるフェイクに新しい呼び方が必要なのか、それとも同じものと捉えてそれほど心配しなくて良いのか、どう思いますか?

[ヴィジャイ・バラスブラマニアン]

日本でそんなことがあったとは興味深いですね。実は8年ほど前に声の詐欺について話していた際にその詐欺の元祖とも言える「おれおれ詐欺」について、日本の方が説明してくれたことを思い出しました。

[マーチン・カサド]

まさにそれですね。

[ヴィジャイ・バラスブラマニアン]

その頃、日本では詐欺によって騙し取られる被害が、5億ドル規模に達していました。何が変わったかというと、詐欺のスケールと、実際に声を真似する技術の精度が高まったのです。

今では誰でも手軽に自分の声を真似させるツールが使えます。以前は、アクセントなどがあると本当の声を完全には真似できませんでしたが、今では15秒の動画、たとえばお孫さんの15秒のTikTok動画があれば十分です。実際には、5秒あればかなりの精度で声をクローンできます。つまり、詐欺師がこのような技術をスケール化し、さらにこれを大規模言語モデルと組み合わせているのです。

今では、相手が何かを言ったら、大規模言語モデルで返答を作成させるといったことが可能となっています。さらに興味深いのは、通常は大規模言語モデルのハルシネーション(幻覚)が問題なのですが、人を騙すためなら逆に好都合ということです。

詐欺では、悪い状況が起きていることを大規模言語モデルが驚くほど巧妙に相手に信じ込ませようとしているケースを目にしています。

[マーチン・カサド]

あなたは、おそらく世界で最も多くの種類のボイス詐欺に触れている専門家でしょう。

おれおれ詐欺については聞いたことがありますが、それ以外に今よく見られるディープフェイクの利用例について教えていただけますか?

[ヴィジャイ・バラスブラマニアン]

今のディープフェイクは、特に政治界隈で見ることができます。例えば、バイデン大統領の選挙キャンペーンに関する虚偽情報の問題がありましたが、私たちがそれを見つけて特定しました。

[マーチン・カサド]

その具体的な内容を話してもらえますか?

[ヴィジャイ・バラスブラマニアン]

今年の初めに実際に起こったのですが、ディープフェイクは主に商業、メディア、コミュニケーションの3つの大きな分野に影響を与えます。これはニュースメディアやソーシャルメディアも含みます。選挙の年の始まりに、共和党の予備選が行われているニューハンプシャー州で発生しました。全員に電話がかかってきて、こう言われたのです。

「What a bunch of malarkey. We know the value of voting Democratic when our votes count」(まったくナンセンスだ。私たちは、投票カウントされる場合に民主党に投票する価値のあることを知っている。)

[ヴィジャイ・バラスブラマニアン]

そしてこれは、バイデン大統領の声で作られており、最もターゲットとされる人達を狙ってきたのです。人々は、本当にバイデン大統領なのか、と混乱しました。

我々は、これがディープフェイクであることを確認し、さらに「ソーストレーシング」という技術で、どのAIアプリケーションがこのディープフェイクの作成に使われたかも特定しました。

そのアプリケーションの開発企業は非常に優れた企業で、我々は彼らと協力し、すぐにこのスクリプトを使用した人物を特定して、再発を防ぐことにつながりました。

その後、規制が発動され、この通話を配信した通信事業者には罰金が科されました。

ディープフェイクを意図的に作成した政治アナリストにも罰金が科されました。

これは、最初の政治的な偽情報のケースでした。このような事例はよく見られます。

[マーチン・カサド]

それは今年の出来事ですか?

[ヴィジャイ・バラスブラマニアン]

はい、今年の1月に起こりました。

[マーチン・カサド]

驚きですね。

さて、政治関連や高齢者を狙ったケースについて話しましたが、他に興味深い事例があればもう一つ教えてください。それから、ディープフェイクの検出方法についてもお聞きしたいです。

[ヴィジャイ・バラスブラマニアン]

身近な例で言うと、商取引分野、特に金融機関での状況です。生成AIが2022年に登場し、2023年には一部の顧客企業で月に1件程度のディープフェイクが見られるようになりました。当時はたいした問題ではありませんでしたが、今年に入ってからは急激に増加し、現在では顧客あたり1日1件のペースで発生しています。特に、大手銀行のような顧客企業では3時間に1件の割合でディープフェイクが確認されるほどです。そのスピードは驚異的で、今年の最初の6カ月間で、ディープフェイクの件数が昨年全体と比較して1400%も増加しており、年末までさらに増える可能性があると懸念しています。

[マーチン・カサド]

それらのディープフェイクは検出可能なのですか? それともこれは、終わりの始まりですか?

[ヴィジャイ・バラスブラマニアン]

あなたはこれまでにも、信じられない感覚になるサイクルをいくつも経験されてきましたよね。

オンライン詐欺やスパムメールなど、似たような問題がたくさんありましたが、今回も状況は同じです。

実はディープフェイクは、ほぼ完全に検出することが可能です。現時点では、99%の検出率と1%の誤検知率で非常に高い精度で検出することができています。

[マーチン・カサド]

例えば、声が私のものかどうかを判別する場合の検出の基準値はどのくらいですか?

[ヴィジャイ・バラスブラマニアン]

おおよそ10万分の1から100万分の1という非常に高い精度と高い特異性があります。ディープフェイクの検出についても、99%の精度で行っています。例えば、音声であれば、コンタクトセンターなどの低解像度のチャンネルでも、毎秒8,000回の音声サンプルが取られています。そのため、音声が時間と共にどのように変化するかを非常に細かく観察することができます。ディープフェイクのシステムは、周波数ドメインや時間ドメインで誤差が生じやすく、その誤差が多いことが検出の手がかりになります。人間の耳は毎秒8,000回の異常を検知することはできませんが、AIはそれが可能です。オンライン会議のような状況では16,000サンプル、音楽では44,000サンプルが毎秒取得されます。このように膨大なデータがあるため、検出可能な異常がたくさん存在し、かなりの高い精度でディープフェイクを見分けることができるのです。

[マーチン・カサド]

政策の分野では、ウォーターマーク(透かし)や暗号化などによる対策の提案が見られますが、犯罪者にこれらを守らせるのは不自然に思えます。正規か不正かを見分けるためのより積極的な手段については、どう考えていますか?

[ヴィジャイ・バラスブラマニアン]

そこにセキュリティのプロの存在理由があるのです。ほとんどの攻撃者がこちらの意図通りにウォーターマークを入れてくれるわけではない、というのはすぐにお分かりでしょう。でも、仮にウォーターマークがなかったとしても、です。

たとえば、先ほど例に出したバイデン大統領の自動音声メッセージの件ですが、あの時、実際に生成された音声にはウォーターマークが含まれていました。しかし、それを再度ウォーターマークの検出システムで確認しても、抽出できたのは2%だけでした。

[マーチン・カサド]

ああ、なるほど。つまり最初のバイデンの音声には...

[ヴィジャイ・バラスブラマニアン]

ウォーターマークが入っていたんです。AIアプリで生成されたものだったので、ウォーターマークが含まれていました。

[マーチン・カサド]

それがコピーされた。。。

[ヴィジャイ・バラスブラマニアン]

そのウォーターマークの98%は消えてしまったんです。音声を再生するとき、空間を通して伝わったり、電話回線を通ったりする中で、ビットやバイトが削られてしまいます。そして削られると、音声はとてもデータ量が少ないチャンネルなので、何度もウォーターマークを入れたとしても保持することは難しいのです。このようなウォーターマーク技術は非常に優れた手法ですが、守りを何重にもすることが重要です。ウォーターマークがあれば、本物の素材を多く特定できるようになります。ただ、攻撃者は従ってくれません。ニュースメディアと一緒に検証を行っていますが、たとえば、イスラエルとハマスの戦争に関する動画や音声の90%が偽物なんです。

[マーチン・カサド]

え、いくつですか?

[ヴィジャイ・バラスブラマニアン]

90%が偽物です。

[マーチン・カサド]

え? 驚くべきことではないのかもしれませんが…

[ヴィジャイ・バラスブラマニアン]

全てがつくりものです。別の戦争の映像を使っていたり、簡単な偽造だったり、あるいは本格的に作ったディープフェイク、もしくは寄せ集めのコンテンツもあります。これからは、何が本物かを見極める力がますます重要になります。なぜなら、こういったことが今や大量に行えるようになっているからです。

[マーチン・カサド]

AI技術がどのように影響しているか説明いただけますか?明らかに、攻撃者にとって何らかの経済的なメリットが生まれたことから、この増加が見られるのだと思います。そして、この傾向がさらに加速していくのは間違いないですね。

[ヴィジャイ・バラスブラマニアン]

私が話しているのは、ディープフェイク検出システムには、高い耐性が求められるということです。単に今のディープフェイクを検出するだけではなく、いわゆるゼロデイ・ディープフェイクも検出できるようでなければなりません。新しいシステムが作られたとき、そのディープフェイクをどうやって見分けるのかが課題です。

考え方としては、ディープフェイクのアーキテクチャは単一のシステムではなく、複数のコンポーネントから構成されています。それぞれのコンポーネントが残す微妙な痕跡、いわゆる「フェイクプリント」があるんです。新しいシステムが作られるとき、以前のシステムのパーツを組み合わせていることが多く、そのフェイクプリントが残るため、新しいものでも検出可能になるわけです。

たいていの場合、新しいシステムは一部のコンポーネントだけが改良され、他の部分はそのままになっていることが多いのです。

我々は実際にGANを使って自分たちでディープフェイクを生成し、検出システムを開発しています。ディープフェイクを生成して、どうすればこれを突破できるか?を考え、何度も改良を重ねています。

[マーチン・カサド]

つまり、あなたたちは生成したディープフェイクを使って、自分たちで検出システムを開発しているということですね。GANを使って、精度の高いディープフェイクを作り、それに対する検出方法を開発しているという理解で合っていますか?

[ヴィジャイ・バラスブラマニアン]

その通りです。我々は、開発した検出システムに何度も何度も改善を重ねていきます。興味深いのは、ディープフェイクが聞き取りやすく、本物に見せるという目的と検出システムを欺くという目的を同時に達成しようとすると、両者が衝突を起こし始める点です。たとえば、ノイズを加えると検出システムの目を逃れることができますが、ノイズが多すぎると聞き取りにくくなり、話が理解できなくなります。実際、パリのオリンピックの際にレブロン・ジェームズがコーチを批判しているように見えるディープフェイクが出回ったとき、我々に声がかかり、実際に調査を行いましたが、もちろんそれは本物ではありませんでした。

ディープフェイクだったので、我々はマネジメントチームにその情報を提供し、AI生成コンテンツとしてラベルが付けられるようになりました。

ただ、音声には多くのノイズが加えられていて、検出を避けるための操作が見受けられました。多くの人が音声をはっきりと聞き取れず、「本当に本物なのか?」という反応でした。

ここからスタートして、GANを動かしたり、ディープフェイク生成システムのアーキテクチャの理解を試みたり、そして最終的にはある客観的な関数の乖離を見つけ出します。これによって私たちは検出できると自信を持っています。見分けるのは、人間として何か違和感を覚えるか、システムとして検出するかのどちらかです。

[マーチン・カサド]

スパムやディープフェイクが機能する理由のひとつは、限界費用がとても低いため、大規模に実行できることです。スパムメールのコストがほとんどかからないのと同じです。例えば、ディープフェイクをn個生成するのに1ドルかかるなら、n個のディープフェイクを検出するのにはいくらかかるのか?1対1、10対1、それとも100対1でしょうか?

[ヴィジャイ・バラスブラマニアン]

ディープフェイクの検出はもっと安価です。Appleがデバイス上で実行できるモデルをリリースしたのが似た例にあたります。

Appleのモデルは、音声からテキスト変換などの多機能な小規模モデルですが、我々のモデルはそれよりも約100分の1のサイズです。このため、ディープフェイクの検出がずっと速く、また現在のところ、生成コストの約100分の1で検出することができます。今では、さらに低コストでの検出法も模索している状況です。

[マーチン・カサド]

なるほど、検出が生成のコストに比べて数桁安いということですね。つまり、防御策がある限り、悪意のある側には2桁多いリソースが必要です。これは結構大きな差で、通常、こういった対抗策ではコストの均衡を目指すものですが、良識ある人々が多い状況ですからね。

[ヴィジャイ・バラスブラマニアン]

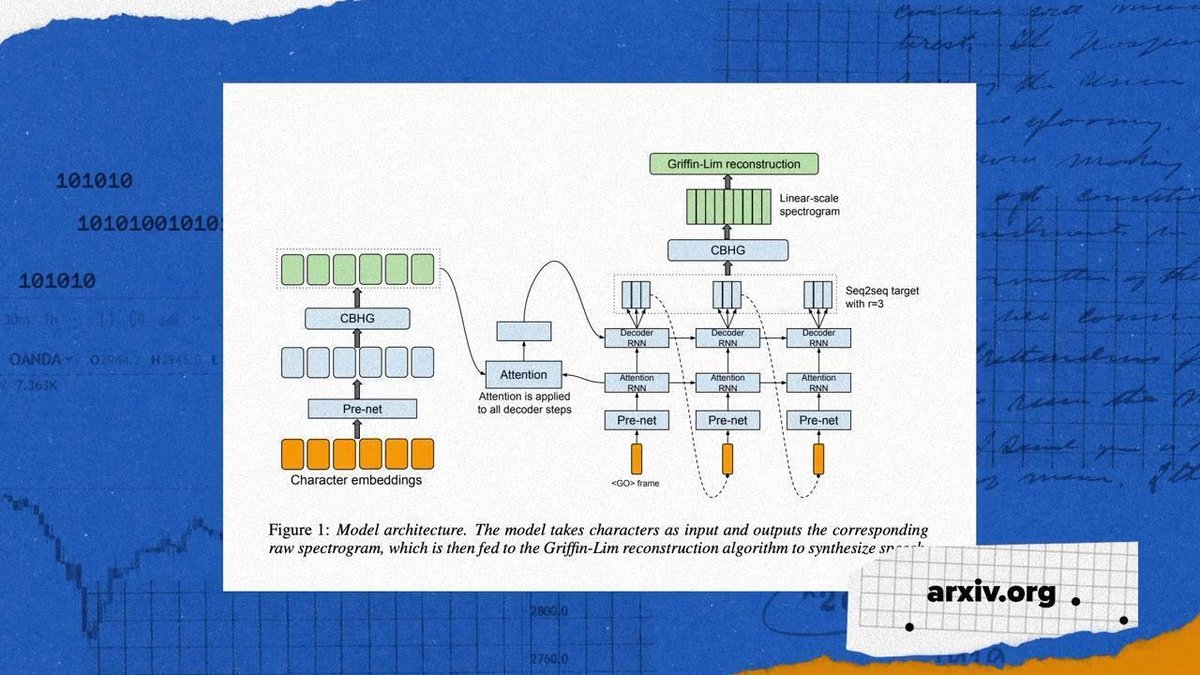

そして、数桁の差がある上に、一度ディープフェイクの特徴を掴んでしまえば、新しいアーキテクチャに変更しない限り、検出するのは難しくありません。完全にパイプラインを再設計する企業はごくわずかで、最後に行われたのはGoogleの「TACOTRON」(Towards End-to-End Speech Synthesis)で、パイプラインのいくつかの部分が再設計されました。これは非常にコストがかかる作業です。

[マーチン・カサド]

検出がこれほど安価なのは、よりシンプルだからですか?つまり、ディープフェイクは人間に聞こえるように作られ、検出を回避する複雑さが必要なのに対し、検出側は焦点を絞れるのでコストが抑えられる、と。

それから、AIが進化しすぎて、検出が完全に失敗するようになる未来はないですよね?

[ヴィジャイ・バラスブラマニアン]

完全に検出を回避するようにシステムを設計すると、自然な人間の話し方が犠牲になることが多いのです。また、人間のような話し方を優先すると、声帯や横隔膜、唇、口、鼻腔といった数千年かけて進化してきた身体的な要素に制限されます。すべてを正確に再現するのは難しいのです。テンプレートを基に作られていますが、限界があります。それに、マーティンさんの声をより詳しく分析すればするほど、微妙な変化を認識する能力も向上します。

[マーチン・カサド]

そして、我々も善意の立場として、データ共有で協力できるインセンティブがありますね。

悪意のある側がアクセスできないデータにもアクセスできるのは大きな利点です。これはスパム対策と似ていますね。スパムは攻撃者には効果的ですが、防御側も対策を講じれば効果を上げられる。ただし、対策が必要なのは確かです。ディープフェイク検出の戦略をしっかりと整えておけば安心、ということですか?

[ヴィジャイ・バラスブラマニアン]

その通りです。そして、これは各分野での対策が必要だと思います。たとえば、ボイスクローンのようなAIアプリケーションは、喉頭がんを患った方々に声を提供するなど、素晴らしいことをしていますよね。ただ、そうした場合は、声を再現してほしいというユーザーの同意があるからこその話です。つまり、元となるAIアプリケーション側が、実際にプラットフォームを利用したい人が利用していることを確認できることが第一のポイントです。

[マーチン・カサド]

そして、正規の利用を支援すると同時に、不正な利用も検出できるように、実際に生成を行っている企業とのパートナーシップが重要になってくる、ということですね?

[ヴィジャイ・バラスブラマニアン]

そうです、まさにその通りです。Eleven Labs社(https://elevenlabs.io/)は本当に素晴らしい会社です。

彼らは声を倫理的かつ安全に、慎重に作成するために多大な努力をしています。優れたツールを多く世に送り出そうとしていて、私たちもパートナーシップを組んで、データセットも共有してもらっています。このような企業は他にもあります。例えば、ハリウッド映画にも関わったRespeecher社(https://www.respeecher.com/)もそうです。

これらの企業が連携して、正しい方向に進め始めています。これは、2000年代の詐欺対策やメールスパム対策の状況にも似ています。

[マーチン・カサド]

最近、カリフォルニアや連邦レベルで多くの政策討議に参加してきたのですが、規制やルールに関して、特にイノベーションや言論の自由について、政策立案者にどのような助言をされますか?多くの政策立案者がこのポッドキャストを聞いています。難しいテーマですが。

[ヴィジャイ・バラスブラマニアン]

シンプルに言えば、脅威となる側には厳しく、創造的な側には柔軟であるべきです。これが根本的な違いです。歴史にも良い例がたくさんあります。例えば、私たちが経験したメール時代には、CAN-SPAM法が素晴らしいアプローチでしたが、これは優れた機械学習技術との併用で効果を発揮しました。

[マーチン・カサド]

CAN-SPAM法がどのように機能しているかを簡単に説明していただけますか?良い例になると思います。

[ヴィジャイ・バラスブラマニアン]

CAN-SPAM法は、無作為なマーケティングメッセージを送信する際、ヘッダーを明確にし、オプトアウトの選択肢を提供し、厳格なポリシーに従うことを義務付けたものです。このルールに従わない場合は罰金が科されます。

また、スパムを検出するための高度な技術も導入されています。特に無作為なマーケティングやポルノのような悪質なコンテンツに対して基準を設けることで、AIや機械学習技術を用いてこれらの違反を効果的に検出できます。

似たようなことが銀行やeコマースがオンライン化した際にも起こりました。オンライン詐欺の増加に伴い、KYC(Know Your Customer)法やAML(Anti-Money Laundering)規制などが導入され、組織が顧客の身元を確認し、本人確認を行う技術の実装が求められました。この技術があることで、コンプライアンスの実効性が向上したのです。

このような事例でうまくいったのは、2つの明確な基準があったことです。まず、技術的に確実に検出可能な範囲を明確にすること。検出ができなければ、ルールの強制は難しいからです。そして、許容される行為の明確な境界線を設けることで、違反者を特定し、責任を問えるようにすることです。

ディープフェイクに関しても同様に、明確な基準があります。言論の自由を尊重しつつも、詐欺、暴力の扇動、わいせつ物の拡散など、従来から言論の自由が保護しない行為には制限が設けられています。このような有害な用途でディープフェイクが使用された場合には、罰金や法的な保護措置が必要です。これが適用すべきモデルだと考えています。言論の自由を守りつつも、有害な文脈での乱用を防ぐためのセーフガードを設けることが重要です。

[マーチン・カサド]

ただし、厳密には違法でないが、迷惑なグレーゾーンもありますよね。このような迷惑なものは、メールボックスや他のスペースを埋めてしまうことがあり、うんざりします。そのため、ルールを設定して、それを超えた場合に訴訟に訴えたり、オプトアウトできる仕組みを作ることで、このような迷惑なものを規制対象外に置くことができます。このような対応が、ここでも当てはまるでしょう。そして、もちろん、求められているコンテンツには特に規制は必要ありません。

[ヴィジャイ・バラスブラマニアン]

もう一つ加えると、現在は多くのプラットフォーム経由でコンテンツを消費しているので、プラットフォーマー側にも何が本物で何が偽物なのかを明確に区別する責任をある程度持たせるべきだと思います。そうでないと、一般消費者がAI生成かどうかを見分けるのは非常に難しくなり、この点においてもプラットフォーマーにも一定の責任があると思います。

[マーチン・カサド]

現在の技術レベルを考えると、スパム対策と同様に、プラットフォーム側がベストプラクティスを実施する責任を持つのが妥当です。我々はマイクロソフトやGoogleのスパム検出に頼っていますが、同じアプローチをプラットフォームにも適用するのが合理的だと思います。

まず、重要なポイントとして、ディープフェイクは以前から存在していましたが、この新しい世代には新しい名前が必要かもしれません。これは仮定の話ではなく、ディープフェイクの増加が著しく、1日1件の新たな事例があると報告され、生成コストも大幅に下がっています。良いニュースとしては、検出が可能であり、適切なソリューションがあれば今後も検出可能である点です。

したがって、どの政策も、検出に関するガイダンスやプラットフォームへの責任を求めるものにすべきです。現実的に検出が可能ですから、問題に対する意識を高めつつも、危機的な状況ではありません。政策立案者がこの特定のケースのためにAI全体を規制する必要はありません。

この説明で要点は捉えているでしょうか?

[ヴィジャイ・バラスブラマニアン]

素晴らしい要約です。非常に的確に捉えています。

3. オリジナル・コンテンツ

オリジナル・コンテンツは、以下リンクからご視聴になれます。

尚、本投稿の内容は、参考訳です。また、意訳や省略、情報を補足したコンテンツを含んでいます。

a16zより

(Original Published date : 2024/10/31 EST)

[出演]

Pindrop

ヴィジャイ・バラスブラマニアン(Vijay Balasubramaniyan)

Co-founder & CEO

Andreessen Horowitz

マーチン・カサド(Martin Casado)

<御礼>

最後までお読み頂きまして誠に有難うございます。

役に立ちましたら、スキ、フォロー頂けると大変喜び、モチベーションにもつながりますので、是非よろしくお願いいたします。

だうじょん

<免責事項>

本執筆内容は、執筆者個人の備忘録を情報提供のみを目的として公開するものであり、いかなる金融商品や個別株への投資勧誘や投資手法を推奨するものではありません。また、本執筆によって提供される情報は、個々の読者の方々にとって適切であるとは限らず、またその真実性、完全性、正確性、いかなる特定の目的への適時性について保証されるものではありません。 投資を行う際は、株式への投資は大きなリスクを伴うものであることをご認識の上、読者の皆様ご自身の判断と責任で投資なされるようお願い申し上げます。