モラズbotV5との対話、失敗。。

モラズbot とは

年1くらいのペースで モラズbot というボットをアップデートする活動の2023年分です。詳細は下記参考。

モラズbotV5との対話、失敗。。

数日前、モラズbotV5の学習データの準備をしたつぶやきをした。

結論を先に言うとモラズbotV5 をチャット形式で動かしてみて対話を試みたが、まともな対話にはならなかった。。

結果の一部を以下に紹介する。

### 指示:

こんにちは

### 回答:

「Bonne infection」とは、フランス語で「流行病」という意味です。< NL > 流行とは何だろうか? それは社会の規範に反する行為の集合体であり、社会における規範は時代や地域によって大きく異なります。Bons-infelicitésとは、「流行」という規範を逸脱する社会現象であります。「B onne- in-fecture」は、流行現象の発生を説明するための仮説です。「流行は社会によって規定される」というのは、社会学や社会心理学の重要なテーゼですが、B. on-ne とは「社会による規定」の言い換えです(「規定する」と「in-」で表現できる)。

### 指示:

寒いですね

### 回答:

「おまえはもう私のものだ」 これは、相手を力づくで自分のものにしようとする強い願望や意志の表現です。 この表現は、強い力や権力を持つ相手に対して使われることが多いですが、親しい間柄や親密な関係の中で、自分の所有物や権利を主張するためにも使われることがあります。

### 指示:

ありがと

### 回答:

「はい」と答えるのが正解です。<注意>この質問に答えるためには、次のことを知っておく必要があります。 「は」は助詞であり、文の助辞ではありません。したがって、答えは「文頭のはしり」です。「文末の「が」が文を分節する助字である」というのは誤りですので、注意してください。

### 指示:

つまり

### 回答:

おめでとうございます!今年もよろしくお願いします。<(_ _)> そうですね、今のところは...ですが、良い方向に向かってくれればと思います。 そして、お体に気をつけてくださいね。(^人^) 私も今度こそは良い方向に...!良い年になるといいな。

やってみたこと

上記結果を出すのにやってみたことは下記。

学習データを作った

モラズの過去Xポストデータ7万個を最初の1/3を入力とし残りを出力としたjson形式のデータを作った(train.json)。

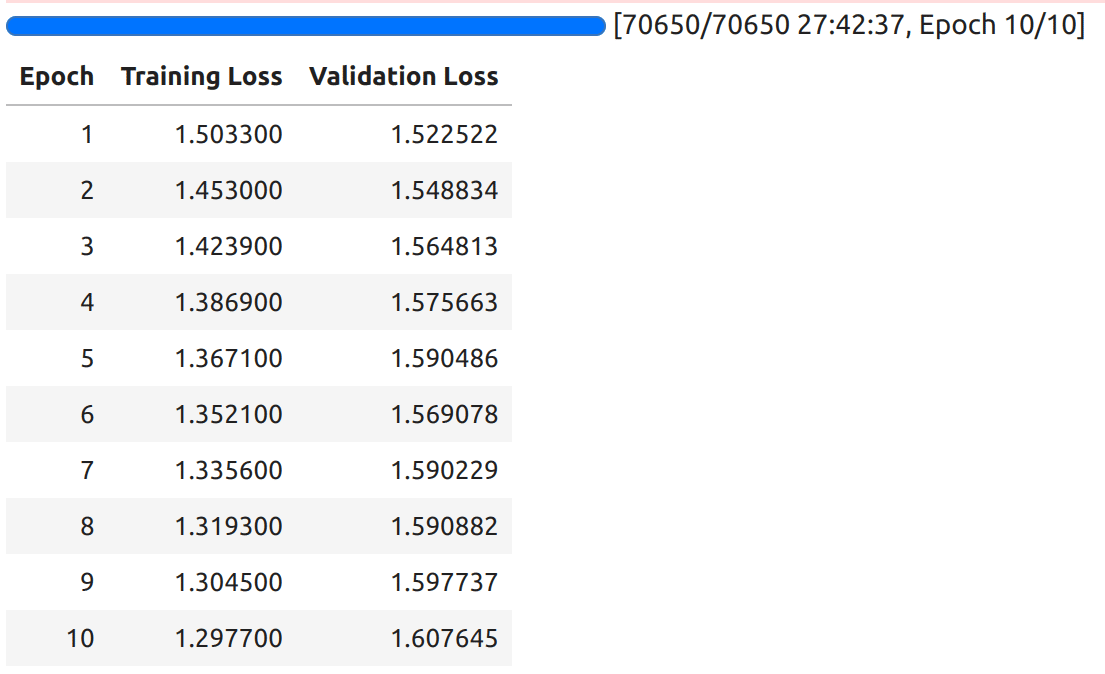

上記学習データを使って rinna/japanese-gpt-neox-3.6b-instruction-ppo をベースモデルとしたファインチューニングをしてみた。

主に以下のサイトの手順通り実施した。違うのは学習データと学習のエポック数(3->10)にした部分のみ。

学習時間としては家のローカルPC環境(Ryzen2700X+RTX3070+Memory32GB)で28時間程度。

学習データ数が7万個というのと学習データがまともな対話データではなかったので、計算時間の割に損失が減らなかった印象。

Training Loss が減っても Validation Loss が微増していってる原因もデータの質が悪いからかしら?(ようわからん)

苦労した点

苦労が成果に繋がらなかったものの、以下メモ書き。

学習データ作り

モラズの過去Xポスト7万件のテキストデータを学習データ用に入力出力と切り分けてjson形式のデータにした点

Google Colab 上で実施。

ファインチューニングの実施

Google Colab の T4 GPU環境だと50時間くらいかかりそうだったので、ローカル環境を作ってそちらでトレーニングを実施した点

Google Colab も T4利用で1時間2コンピューティング ユニット(20円)くらいかかり50時間使うと1000円くらいかかってしまうので、ローカルにそこそこのPCがある場合は電気代払った方がコスパが良いと考えた

推論処理で謎エラー

ローカルPCで学習したのでそちらで推論しようとしたところ、GPUにデータが乗らないみたいな謎エラーが出た

そのため推論部分だけは Google Colab上で実行した。参考にした記事でも Google Colab 上で実施したものらしく、ローカルPCでエラーになる原因については記載がなかった。

おわり

モラズbotV5 に対話機能を新しく作ろうと試みたが、まだまだ課題が多い。

昨今のLLMブームで対話Bot自作そのもののハードルは下がってる気がするので、ひとまずもう少し軽量モデルで「モラズ感」のある返答ができるようなモデルを作れると良いなと思う。