【12,000文字】SDXLの高速化技術5選❗️知らないと損なコレ、全て分かりますか❓️:Lightning、LCM、TCD、ResAdapter、SDXS

どうも皆さん!寝るときは完全に暗くするタイプの女、葉加瀬あいです!

皆さん、日々のAIを使った画像生成ははかどっておりますでしょうか?

最近はStable Diffusion Web UI Forgeの登場によって、SDXLによる画像生成の門戸が広く開かれたような感じがありますよね!

前まで、私も以下のマガジンにあるような記事などでクラウドサービスを使用してStable Diffusion XL(SDXL)を使用する方法について発信してきたんですけども、ようやくStable Diffusion XLを使用した画像生成を行うユーザが増えてきた感じがします。

https://note.com/ai_hakase/m/m8e1b089bc489

ただ、ユーザの増加に伴ってやはり画像生成の時間が人によっては1分や3分、多い方だと5分ぐらいかかってしまうなどといった画像生成の遅さの意見もよく聞きます。実際、Stable Diffusion XLのウィークポイントとしては、この画像生成の遅さなどが挙げられるんですよね。

そこで今回は、そういった問題を解決するために、新しい画像生成技術を使ったStable Diffusion XLの画像生成速度の高速化について解説をしていきたいと思います!

今回の内容が理解できると、今まで画像生成にかけていた時間を大幅に節約することができて、その時間を他の技術のキャッチアップや家族との時間などに当てることができるようになるかと思います。

つまり、今まで損失していた余分な時間をカットすることができるので、今回はそういった皆さんの画像生成によって発生する時間の損失分を取り戻して、新しく手に入れた時間を使ってより新しいことに挑戦していったり、自分の他の趣味に時間を使えるようにしたりできるようにすることをミッションに解説記事を書いていこうと思います!

なお、私の記事を読む上での注意事項などをこちらで説明しておりますので、以下のプロフィール記事をご一読いただいた上で閲覧するようお願いいたします。

https://note.com/ai_hakase/n/ncdcda4208fd7

それでは、早速続きを解説していきたいと思います!

Stable Diffusion XLとその課題

Stable Diffusion XLの概要と特徴

一応、知らない方向けにSDXLとは何なのかといったことを簡単に説明すると、今までのStable Diffusionの画像生成の最新進化版(現時点で)の学習モデルというものになります!

この学習モデルというのは、つまりはAIで画像生成を行う心臓部分のようなもので、この学習モデルの性能が高いとより高品質で美しい画像が簡単に作れるといったことになります。

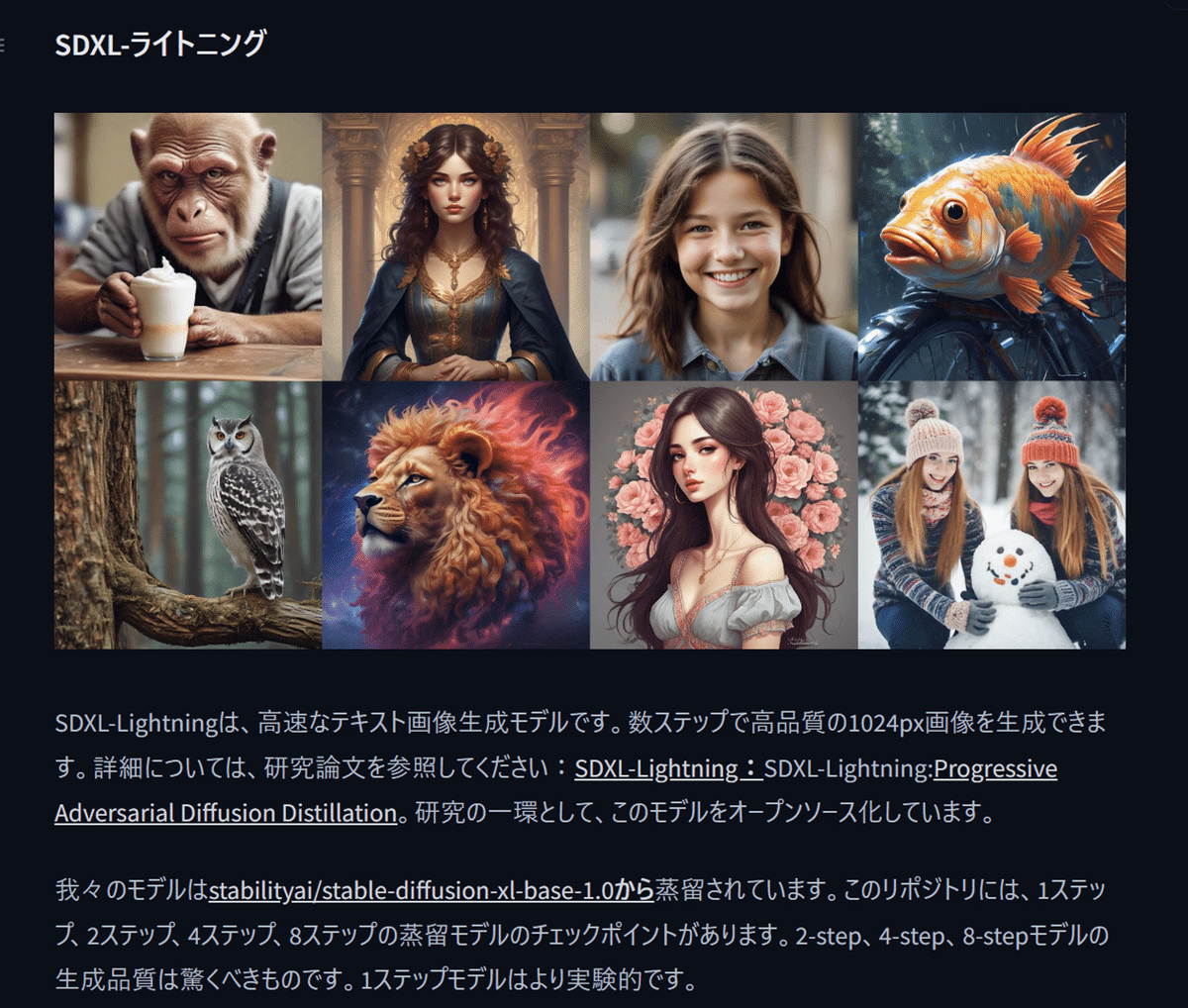

たとえばこんな感じの画像などですね!

(画像)

つまり、今までのStable Diffusionの学習モデルのより新しい世代の学習モデルがSDXLというものになるということですね!ちなみに、1番最初のStable Diffusionの学習モデルをSD 1.5と呼んだりもします。(SD 1.5が超サイヤ人だとするなら、SDXLがスーパーサイヤ人2みたいな感じですね!)

詳しくはこちらのURLで解説をしておりますので、気になる方はこちらを見てみてください!

https://note.com/ai_hakase/n/na5ec07303a0f?magazine_key=ma637c61904c0

また、こちらのマガジンでStable Diffusionの基礎編も解説しておりますので、Stable Diffusionについて詳しくないといった方はこちらもぜひ見てみてください!このマガジンを読めばStable Diffusionの基礎的なことは大体わかるようにまとめてあります!

https://note.com/ai_hakase/m/ma637c61904c0

また、その発展編としてこちらのようにStable Diffusionを使った画像生成の応用編も掲載しています。こちらも興味のある方はぜひ見てみてください!

こちらでは、Stable Diffusionの最新技術や便利なワークフロー(コンテンツを作成するまでの流れ)などを解説しておりますので、ここで解説しているような便利な機能やコツを知るだけで周りと差をつけることもできます! https://note.com/ai_hakase/m/m801944010f99

さて、ここでSDXLの話に戻りたいのですが、このSDXLの登場によって、Stable Diffusionを使った画像生成はとても綺麗で本物と見分けがつかないような高品質の画像が作成できたりということができるようになりました。

実際にStable Diffusionの技術やアップスケーラーなどといった画像の拡大やディテールアップができる他のAI技術などを併用すると私のこちらのメンバーシップの説明欄にもあるようなリアルな画像が作成できます。

(画像)

URLはこちらから! https://note.com/ai_hakase/n/ncdcda4208fd7

画像生成の遅さという問題点

ただし、このSDXLにはいくつかの欠点もありまして、それが原因で素晴らしい技術ではあるのにあまり多くの人に使用されない現状がありました。

それというのが、学習モデルの学習パラメーター数の膨大さというものに起因していて、どういうことかというとStable Diffusion XLでは学習されているデータの数がとても多いため、学習モデルのサイズが6.4 GBほどあるものが一般的で、画像作成を行うにあたってのPCの推奨スペックなども約16 GBのビデオメモリ(VRAM)を搭載したグラフィックボードのPCでないと画像生成そのものができないなどと、かなり様々な制約がありました。

つまり、高性能な画像生成ができるのに、それに伴って使用するPCの要求スペックも高かったんですよね。(そのスペックのPCを購入するには大体25万円ほどの費用がかかります)

なので、今までは私のこちらのマガジンで解説をしているようにクラウドサービスを使うことによってこの問題を解決していました。

https://note.com/ai_hakase/m/m8e1b089bc489

クラウドサービスを使用する利点としては、自分のPCの上で動かすわけではなくウェブサイト上で動かすものになりますので、どのようなPCを使用していてもインターネットに繋げれば約16 GBほどのビデオメモリ(VRAM)を搭載したグラフィックボードの仮想マシンを使用することができました。

つまり、このクラウドサービス上でそういったGPUマシンを使用することによって、このStable Diffusion XLのPCへの要求スペックが高いという問題をクリアしていたわけなんですよね。

また、こちらのクラウドサービスを使用したStable Diffusion XLの画像生成に関しては私を含めた生成AI技術の何人かの方がこの方法を発信していたのですが、いちいちクラウドサービスを立ち上げたりなどしなければならず、プログラミングのコードを実行して起動するといったあまりユーザーフレンドリーではない操作も相まって、あまり多くの人には浸透しなかったんですよね。

高速化技術の登場と時間の有効活用

高速化技術によるStable Diffusion XLの画像生成速度の改善

そこで、様々な研究者さん達が考えに考え抜いて、このStable Diffusion XLのPCの要求スペックの高さをどうにかできないか?ということを考え始めました。

つまり、画像生成を行うときにビデオメモリ(VRAM)を16 GBほど使用してしまう問題を解決できないか?と考えてもっと低いビデオメモリ(VRAM)で実行できるようにする方法を編み出したんですよね。

それが、私がこちらの記事でも解説しているStable Diffusion Web UI Forgeというものになりまして、なんとこちらを使用すれば8 GBから12 GB位のビデオメモリ(VRAM)を搭載したPCであれば簡単にStable Diffusion XLを使用することができるようになりました!(そのくらいのスペックのPCであれば大体10万円ちょっとぐらいで購入できたりします) https://note.com/ai_hakase/n/n0f9eed704c09?magazine_key=m3e572d1342e9

このStable Diffusion Web UI Forgeというものはいわば皆さんが画像生成をいつも行っているStable Diffusion Web UIの亜種、つまりはStable Diffusion Web UIをモチーフにしてもっと便利な使い方ができないか?といった観点で第三者の方が開発したものになります。

実際に、操作画面を見てみると、このようにもともとのStable Diffusion Web UIの操作画面とほとんど変わりません。つまり、見た目はほとんど何も変わらないのに追加の機能や画像生成の速度アップなどの恩恵が受けられるので、とてもリリース当初は話題になったんですよね。

(画像)

実際に、このStable Diffusion Web UI Forgeを使用するともともとのStable Diffusion Web UIにはなかった様々な便利な機能や最新技術を使用することができて、本家のStable Diffusion Web UIからこちらに乗り換える方もとても多いです。

私もStable Diffusion Web UI Forgeでしか使用することができない機能についてこちらのマガジンで解説をしておりますので、興味のある方はぜひ見てみてください! https://note.com/ai_hakase/m/m3e572d1342e9

話を戻すと、このStable Diffusion Web UI Forgeの出現によって何が変わったかというと、画像生成に必要なPCの要求スペックが格段に下がったので、結果としてStable Diffusion XLを使用するユーザの増加につながりました。

これによって、Stable Diffusion XLの様々な技術が最近ようやっと利用されるようになってきたのですが、ここで1つの大きな問題が発生しました。

それが、画像生成の速度の遅さです。Stable Diffusion XLは、学習されている画像のデフォルトのサイズが1024×1024といった形になりますので、デフォルトで推奨される画像生成のサイズなどもおのずと1024×1024のピクセル数の前後といった形になります。

つまり、大きな画像を作成する反面、AIを使って画像生成をする速度が今までのStable Diffusion 1.5の学習モデルと比べて遅いんですよね。

イメージとしては、Stable Diffusion 1.5で画像生成するのにかかる時間が30秒ほどだとするとStable Diffusion XLで画像生成を行うのにかかる時間は1分から2分程だと考えておいてください。

(使用するPCの設定やControlNetなどの設定などにもよってこの画像生成の時間は変わってきます。)

一応、Stable Diffusion Web UI ForgeでStable Diffusion XLを使用した場合は、画像生成の速度も約30%から40%ほど高速化ができたりなど、画像生成のスピードもアップしたのですが、それでもやはりもっと早く画像生成ができないか?といった声がとても多くありました。

画像引用:https://ikuriblog.com/how-to-use-stable-diffusion-web-ui-forge/

そこで、様々な研究者が考えたのが、このStable Diffusion XLの画像生成のスピードをもっと早くできないか?といったことです。

つまり、ここで開発された様々な画像生成の高速化の技術が冒頭で解説した「SDXL LightningやLCMやTCD、ResAdapter、SDXS」といった技術になります。

詳しくは後ほど解説をするのですが、これらの登場によって、Stable Diffusion XLによる画像生成をもっと少ないステップ数で行うことが可能になりました。ステップ数というのは、画像生成を行うための処理時間のようなもので、その処理時間を短縮することによって画像生成の高速化を図るというアプローチになります!

具体的にはこのステップ数の短縮というのは、LCMという技術から始まり、その後SDXL LightningやTCDといったように、様々なステップ数の短縮の技術が開発されてはそのアップグレード版が次々に登場したりしています。

(画像)

(画像)

さらに、これに加えて、そもそもStable Diffusionで画像生成される画像のサイズを1024×1024ではなくて512×512という小さいサイズで作成できるようにしようといったアプローチも生まれています。それが、ResAdapterという技術です。

つまり、作成される画像のサイズが小さくなるので、その分画像生成を行うにあたっての処理時間が減少するといった考え方になります。

実は、推奨される画像サイズが1024×1024の場合、それをStable Diffusion Web UIの機能で512×512といった形で指定して画像生成してしまうと、学習されている画像データのサイズとは異なるため、あまり良い画像生成が行われたり、あまり質の高くない画像が生成されることが一般的です。

このResAdapterという技術については後ほど詳しく解説するのですが、簡単に言うと、生成画像のサイズを小さくしたり大きくしても、生成される画像の品質に影響が出ないようにするといったことを目的とした技術になります。

(画像)

つまり、画像生成に必要なステップ数を短縮するための技術と、生成される画像のサイズを小さくする技術を組み合わせてより高速に画像生成ができるようにできるといった形になります。

そして、それのいいとこ取り、つまりはステップ数の短縮と画像生成サイズの変更に対応する技術が合わさったのがSDXSといった技術になります。

(画像)

今回はそれらの技術についてより詳しく解説したり、実際に使用する方法、今後の展望などをお伝えしていけたらと思っております。

この画像生成の高速化などができると、今まで以上に様々なプロンプト(画像生成をする際のAIへの指示文)を試してみたり、キャラクターデザインやストーリーの作成などといった、あらゆる作業の時間を大幅に短縮することができます。

皆さんの時間は有限ですので、つまりはこの画像生成の高速化を理解することによって、今まで失っていた時間をそのまま節約することにつながりますので、空いた時間でまた別の技術を調べたり、家族との時間を取ったりなど、今まで失っていた様々な時間を取り戻すことができます。

反対に、こちらの方法を知らないともっと周りと差がついていったり、技術を知らないが故に余分な時間を画像生成に使ってしまったりなど、皆さんの将来の損失につながりますので、ここでは、そういった皆さんの時間を節約してもっと様々なことに挑戦していけるようにすることをミッションとして解説記事を書いていこうと思います!

この画像生成の高速化という最新技術を学んで、もっと自由な時間を手に入れたいという方はぜひ今回の投稿を最後まで見ていてください。

それでは、本題に戻って続きを解説していきます!

まずは、SDXL LightningやLCM、TCD、ResAdapter、SDXSなどといった、画像生成の高速化に関する最新の技術について、具体的にどのようなことができるのかを解説していきたいと思います!

それぞれの技術の特徴をまとめると以下のような形になります。なお、リリースされた時系列順に解説していきます。厳密に言うと、画像生成の高速化の技術はこの技術以外にもあるのですが、今回は話題の技術をピックアップして解説していきます!

この記事が参加している募集

この記事が気に入ったらチップで応援してみませんか?