ベイズ階層モデルを用いた音声からの完全教師なし音素・単語獲得に関する谷口Gの一連の研究について

本日のLanguage and Robotics 研究会の際に、谷口の研究グループがやってきた音声からの完全教師なし音素・単語獲得(二重分節解析器)に関する一連の研究が話題になったので、2010年代半ばから2020年頃まで取り組んでいた一連の研究についてリスト的にまとめておくことにする。

1.音声データからの教師なし音素・単語獲得

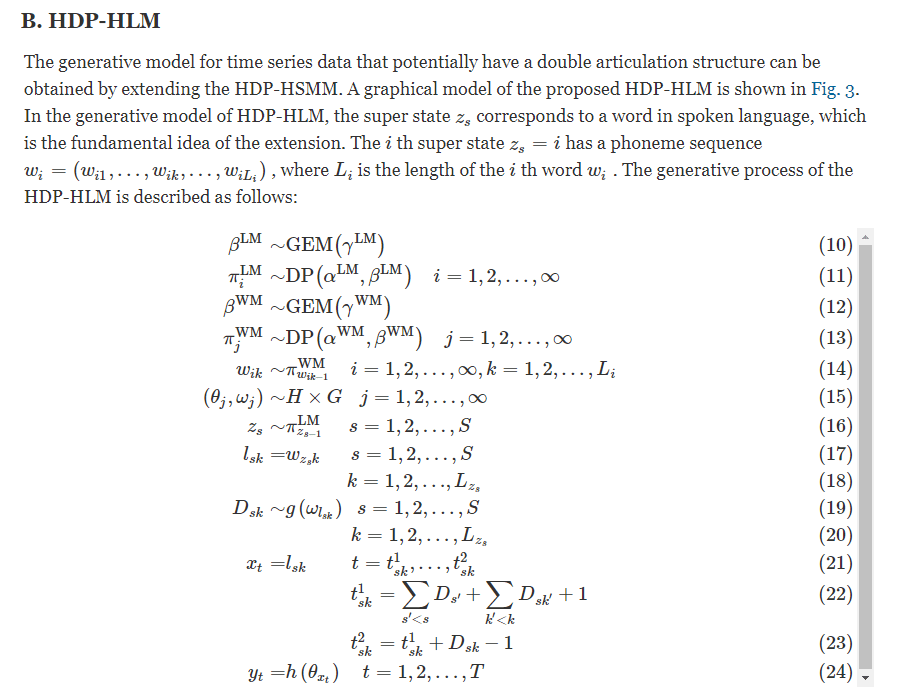

二重分節構造全体をベイズ生成モデルで表現しブロック化ギブスサンプラーを導出

Tadahiro Taniguchi, Shogo Nagasaka, Ryo Nakashima, Nonparametric Bayesian Double Articulation Analyzer for Direct Language Acquisition from Continuous Speech Signals, IEEE Transactions on Cognitive and Developmental Systems, 8(3), 171-185, 2016. DOI: 10.1109/TCDS.2016.2550591

2. 前段にAutoEncoderベースの特徴抽出を加えてちょっとパフォーマンス改善

Tadahiro Taniguchi, Ryo Nakashima, Hailong Liu and Shogo Nagasaka, Double Articulation Analyzer with Deep Sparse Autoencoder for Unsupervised Word Discovery from Speech Signals, Advanced Robotics, 30(11-12), 770-783, 2016. DOI:10.1080/01691864.2016.1159981

https://www.tandfonline.com/doi/full/10.1080/01691864.2016.1159981

3. メモ化など工夫して高速化(オーダー落とす)

Ryo Ozaki, Tadahiro Taniguchi, Accelerated Nonparametric Bayesian Double Articulation Analyzer for Unsupervised Word Discovery, The 8th Joint IEEE International Conference on Development and Learning and on Epigenetic Robotics 2018, 2018, pp. 238-244

複数話者の違いをConditionalなAEで吸収し複数話者対応

Ryo Nakashima, Ryo Ozaki, Tadahiro Taniguchi, Unsupervised Phoneme and Word Discovery From Multiple Speakers Using Double Articulation Analyzer and Neural Network With Parametric Bias, Frontiers in Robotics and AI, 6(-), 92, 2019

https://www.frontiersin.org/articles/10.3389/frobt.2019.00092/full

プロソディ情報を統合しプロソディ情報と分布の統計情報を相互利用可能に

Okuda, Yasuaki, et al. "Double articulation analyzer with prosody for unsupervised word and phone discovery." IEEE Transactions on Cognitive and Developmental Systems (2022).

マルチモーダル物体カテゴリ学習を統合し相互学習

Akira Taniguchi, Hiroaki Murakami, Ryo Ozaki, Tadahiro Taniguchi, Unsupervised Multimodal Word Discovery based on Double Articulation Analysis with Co-occurrence cues, IEEE Transactions on Cognitive and Developmental Systems, (), 2023

これらは「音声データそのものを入力にした教師なし音素・単語同時獲得」に関する研究です。これ以外にも言語獲得関係はいろいろとやっています。

ちなみにこの後、Zero Resource Speech Challengeなどでは自己教師付き学習による表現学習の方に大きな関心が行った気がします。

弊ラボのリソース問題によって論文はだせてもZeroSpeechのような国際舞台にちゃんと出ていけなかったことは反省点だなぁと思っております。

時代は進んでLLMや基盤モデルが自己教師付き学習で発展し、言語観が大きくかわりつつある昨今、音素や単語のデータベースを作るかのように分節化と学習をベースに置いたような語彙獲得の研究の方向性ももう少し変わっていくのだと思います。

この記事が気に入ったらサポートをしてみませんか?