グローバルなビジネスプロフェッショナルなら、知らないではすまされない話。

シリコンバレー人事のTimTamです。今月(2月)はアメリカでBlack History Monthといって、これまでの黒人の歴史を振り返る月で、業務的な観点からいうと、ダイバーシティ担当が大忙しになる月です。米国だけではなく、カナダや、イギリスでも実施されます(UKは10月)。

なので2月は例年、アフリカンアメリカン系の様々なゲストスピーカーを呼んで講演会をしたり、関連する社員のインタビューを行ったりと、各社でイベントが色々とあります。また、Black History Month(BHM)にちなんだ商品などが発表されたりします。例えば、アップルはBHMに敬意を表して、以下のようなアップルウォッチブラックユニティコレクションを発表しました。

そういえば、リンクトインのアイコンも2月はこんな感じになってます。↓

島国である日本では、周りは殆ど日本人という環境で育ちますので、あまり人種差別とか、肌感覚がある方は少ないかもしれませんが、それってかなり特殊なんですよね。最近でこそ、東京では様々な国からの旅行者や、海外企業からの派遣者、その他さまざまな理由で東京に滞在するノン・ジャパニーズらしき方が沢山いますが、それでも殆ど周りは日本人で似たような常識や感覚を持ち合わせたモノカルチャー集団という特殊な国と言えます(ここで私が、外国人という表現を使っていなかったり、ノン・ジャパニーズ「らしき方」と書いたのは、みかけでは必ずしも日本国籍の方とは判断できないためですが、色々と配慮した書き方をしている事に気づいたでしょうか?)。

テレビドラマや映画の登場人物を見ても、何もしないと白人に偏りがちなところを、できるだけ性別、LGBTQ、人種等のバランスを取るように意識しているなあというのが分かります。昨年観たNetflixのThe 100というドラマも主人公のリーダーは女性で、レズビアンなんですが、ものすごく自然に描かれています。スパイダーマンの主人公のマイルズ・モラレスだって、白人男性ではありません。

話を戻すと、今年の社内イベントはコロナ禍なので勿論すべてオンラインなのですが、そのコンテンツのクオリティの高さはすごいものがあります。特に今年は昨年来のBLM(Black Lives Matter)を受けて、より一層の高まりを見せる人権問題という背景がある中での諸々のイベント展開となりました。

今年のゲストは、MITメディアラボの卒業生であるデータサイエンティストのJoy Buolamwiniさん。その内容を知って正直驚きました。こんなところにも差別や偏見があったのかと。そして、正直自分のダイバーシティの認識が甘かったなと思いました。勿論根底にある考え方は、こちらの記事に述べた通り変わっていませんが、特定のグループがexclude(排除)されて開発されたものがどういうネガティブなインパクトを持つ事になるのか、という非常に具体的な例について知ることができました。

以下の動画をまずご覧ください。(サブタイトルで日本語を選択する事も可能です)

彼女は、学生時代のとあるプロジェクトで顔認識技術を使うことになりました。彼女のプロジェクトメンバーの友人たちは問題なく顔認識されるのに、なぜか自分の顔が認識されないという問題にぶちあたります。ところが、彼女の(白人の)友人がやると、その問題は起こりません。は?なんで?と思いますよね。そう、黒人の人の顔は人の顔としてすら認識されないことがあるのです。彼女は、黒人(アフリカンアメリカン)なので、だからなのかと、疑問を抱くようになります。そしてそれを証拠に、白いマスクをかぶったところ、顔として認識されるようになります。Facebookでも、写真をアップロードすると、自動的に「これは○○さん?」みたいなタグがsuggestされる場合がありますが、彼女の場合はいつもこれが不正確だとのこと。

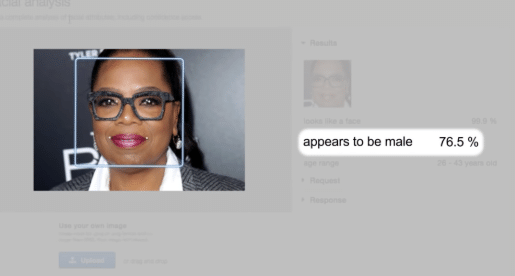

彼女は有名人の顔を使って、ただしく年齢や性別などが判別されるかの統計的な実験を行います。例えば、アメリカで有名な俳優であり司会者であるオプラウィンフリーのケースだと以下のように認識されたようです。

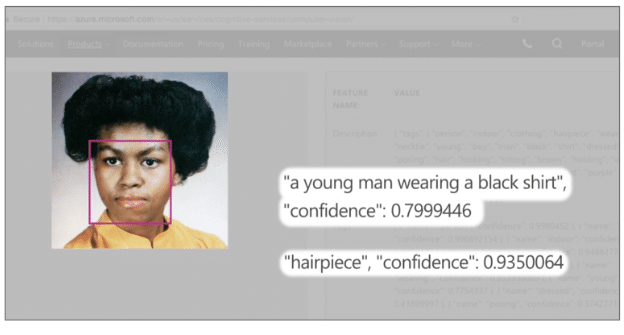

アマゾンのAI顔認識技術だそうですが、76.5%の確率で男性と判断しています。次に、オバマ元大統領のファーストレディーであるミッシェルオバマさんの場合はこちら。これはマイクロソフトのAI顔認識技術だそうです。

AIがどう判断したかと言うと、79.99%の確度で、黒いシャツを着た若い男性。かつら(hairpiece)をかぶっている。この確度は93.5%。だそうです。

顔認識技術は、アマゾン、マイクロソフト、IBM、Face++(中国の企業)などの企業がリードしていると言われており、各社によって若干の差はあるようなのですが、やはり肌の色が濃くなり、性別が女性になるほど、認識率が落ちるという現実を彼女は発見します。

以下はアマゾンの技術の事例ですが、白人男性が100%の認識率になっているのに対し、一番低いのが黒人の女性。

Sourceは画像にリンクを貼っておきました。

どうしてこのような事が起きるのでしょうか。AIはディープラーニングなので、使われているサンプルによって、「標準的な」「典型的な」顔から離れれば離れるほど、認識率が悪くなるというわけです。では誰がその「標準的な顔」のパターンにつながる開発を行っているのでしょうか?昔から指摘されている、シリコンバレーの問題として、やはりエンジニアは圧倒的白人男性が優位な世界であり、開発側も無意識に使うサンプルが白人に偏っているという事を示しています。また、ダイバーシティが進んでいないと、これらの技術を必要とする企業の顧客も、白人の男性であることが多いという現実もあるのかもしれません。

この問題をJoyは、coded gazeとか、algorithmic bias(アルゴリズム上の偏見)と呼んでおり、これらを解決すべく自分でAlgorithmic Justice Leagueという会社を起業する事を決めます。

さて、こういった偏りのある顔認識技術が未成熟なまま、さまざまなところで実用化が進むとどういう事が起きるでしょうか。ビデオの中では、米国の警察が犯罪に対処するためにこれらの顔認識技術を導入しはじめているとのこと。米国では2人に1人の顔が、政府のもつ何らかのデータベースに登録されていて(怖っ!)、犯人の特定に使われているとのことですが、その背後で使用されているアルゴリズムの正確性については開示されていないそうです。実際に、とあるまったく無実無関係の黒人男性が、違う犯人と間違われて、2歳の娘の前でいきなり警察に逮捕されるという事件も起きています(3か月後に釈放)。

Joyは、今後ますますこのようなAIアルゴリズムが未成熟なまま、多くの場面で活用されていくであろうことに懸念を示しています。例えば、無人のATMマシーンでお金を借りる場面への活用の研究、企業の採用面接での活用可能性、大学入試での活用可能性、ローンを組めるかどうか、保険に入れるかどうかなど、日常の多くのシーンでこれらのAI技術が使われる可能性があり、このままでは、さまざまな判断がフェアとはいえない(差別的な)形で行われる可能性があります。

今回の実験の中に、日本人を含むアジア人の結果は載っていませんが、上述のAlgorithmic Justice Leagueに参加する事で、より多くのサンプルを提供したり、監査を依頼したりと色々な貢献ができるようです。

私のようなHR関係者、かつテクノロジー企業で働く者にとっては、こういう問題は知らなかったでは済まされません。ダイバーシティを無視したAI技術は是正されなければなりませんし、特に日本人を含むアジア人もどちらかというとマイノリティ側です。フェアな技術の発展のためにもダイバーシティを目指す事は必要であるという大きな学びを今回は認識する事ができました。

では、また。

いいなと思ったら応援しよう!