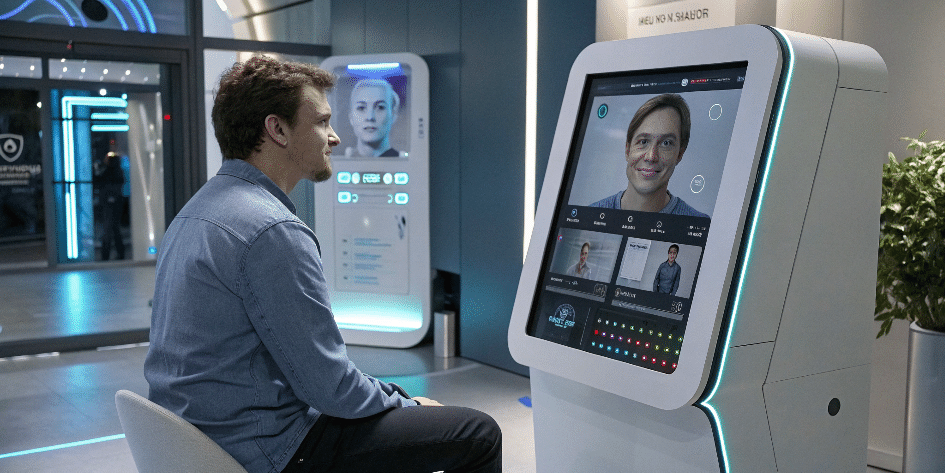

テキスト+顔情報のAIが紡ぐ新しい治療対話

近年、LLMと呼ばれるAI技術を使った心理サポートが研究されていますが、その多くはテキストだけを使ってアドバイスをくれるものでした。ところが、視覚情報、特に顔の表情を組み合わせることで、より人間的な共感を引き出せるのではないか。

テキストだけでなく画像や感情の変化まで捉えるマルチモーダル認知リフレーミング療法が進化しつつあります。簡単にいえば「AIが言葉以外の手がかりもキャッチして、心理療法をサポートしてくれる」研究です。

これにより、たとえば落ち込んだ表情や戸惑いを見せたときに、テキストのみのやりとりよりも、より的確かつ親身なアプローチが期待できます。AIが相談相手になり得る時代に、私たちはどう向き合うべきなのか、その最先端を探ってみます。

まえがき

「いま、人の表情と話し言葉をAIが同時に処理し、心の中をより深く理解する試みが進んでいるそうです。」そんな情報を耳にすると、いよいよAIが人間の心理や感情に近いレベルでサポートしてくれる未来がやってくるのか、と考えずにはいられません。

この記事では、その最先端の研究をご紹介しながら、会話と表情の両面からアプローチするセラピストAIの実力と課題について、探ってみたいと思います。

マルチモーダル認知リフレーミング療法とは?

まずは、やや長めの名称「マルチモーダル認知リフレーミング療法」を分解してみましょう。

「認知リフレーミング」とは?

心理療法のなかでも「認知行動療法(CBT)」の重要なパーツとして、ネガティブな考え方を別の視点から捉え直す手法を指します。

たとえば「人前でミスしたら笑われるに決まってる」という思考を、「もしかしたらサポートしてくれる人もいるかも」とか「笑われても、それが自分をすごくおとしめるわけじゃないはず」といった具合に、少し別角度で考え直すことで気持ちを楽にするのです。「マルチモーダル」とは?

「モーダル」というのは「情報源」や「形式」のようなイメージです。音声や画像、文字データといった複数の形式を組み合わせて使うのが「マルチモーダル」。本研究では特に「表情の画像」と「対話テキスト」を掛け合わせることで、よりリアルに近いカウンセリング体験を狙っています。

要するに、この研究でいう「マルチモーダル認知リフレーミング療法」は、文字だけでなく顔の表情といった非言語的な情報もちゃんと活かしたうえで、AIがクライアントの心理を汲みとりながら認知の修正をサポートする、そんな枠組みを意味しているのです。

背景:なぜ表情が大切なのか

実際の対面カウンセリングでは、クライアントのしぐさ、声のトーン、顔の動きなど、言葉以外の部分から多くの情報を読み取ります。セラピストはそこから「この人は今、悲しみよりも不安が強いかもしれない」「少しイライラが混ざっているかも」といった繊細なヒントを得て、適切に共感や提案を行うのです。

ところが、テキストベースのやり取りだけだと、クライアントがどんな表情をしているのか、どれだけ緊張しているのか、といった情報が抜け落ちてしまいます。そこで顔の表情を取り込み、「非言語的証拠」としてAIに処理させよう、というのが大きなポイントです。

M2CoSCデータセットの登場

今回の研究では「M2CoSC(Multi Modal-Cognitive Support Conversation)」という新しいデータセットを構築しました。これは、対話(テキスト)とクライアントの表情画像がセットになったもの。具体的には、

1.AffectNetという表情データセット(様々な感情表情の写真が含まれる)

2.既存の認知リフレーミングのテキストデータセット

これらを組み合わせて合成対話を作り、さらにGPT-4やGPT-4 VisionなどのAI同士で「クライアント役」「セラピスト役」を演じさせるロールプレイを実施し、疑似カウンセリング会話を生成したのです。

そして、これを手動でクレンジング(不自然な会話を省いたり、画像とテキストが整合しないものを取り除いたり)した結果、最終的に約400以上の対話セットが整備されました。各会話は全4ターンのやりとりになっていて、心理療法のステージ(まえがき的な導入、問題探索、ブレーンストーミング、最後の提案)に応じてセラピストとクライアントが受け答えする形式です。

実験:マルチホップ心理療法的推論の威力

ここで登場するのが「マルチホップ心理療法的推論」という考え方です。シンプルにいえば、

1.クライアントの状態(表情・思考・認知の歪み)を先に把握する

2.そのうえで適切な介入や提案を行う

という2段階を分けてAIに行わせるやり方です。実際のセラピストが「この人、こういう悩みと感情があるから、こう声かけしよう」と手順を踏むように、AIにも「まず状態を確認→それに応じて対応策を考える」というフェーズを設定します。

たとえば、クライアントの画像が「心底落ち込んでいる表情」と判定されたり、「思考」に「どうせ自分はダメだ」というフレーズが含まれていたり、「思考の罠」として過度な一般化をしているかもしれない、といった情報をAIが逐次拾います。そのうえで「それなら励ましを多めに入れてみよう」「別の視点を提案してみよう」と判断するわけです。

LLMやVLMを活用した比較実験

今回の研究では、大きく2種類のモデルをテストしています。

・LLaMA2:テキストだけを扱うLLM

・LLaVA:画像(Vision)とテキストを一緒に扱えるVLM(Vision-Language Model)

さらに、これらをM2CoSCデータセットで微調整したり、マルチホップ推論を組み合わせたりして性能比較を行いました。具体的な呼称は以下のようになります。

「CS-LLaVA」:M2CoSCで学習したLLaVA

「CS-LLaVA w/MH」:さらにマルチホップ心理療法的推論を加えたLLaVA

これらのモデルが、合成クライアントと実際に4ターンの会話を行うシミュレーションを多数回こなし、「共感・論理的一貫性・ガイダンス」の3つの観点で評価スコアを算出しました。

その結果としては、下記のようなポイントが得られたといいます。

1.テキストのみのモデル(LLaMA2)に比べ、画像情報も扱えるモデル(LLaVA)が明らかに優れた共感と提案を生み出した

2.M2CoSCによる学習を施したCS-LLaVAはさらに性能が向上した

3.マルチホップ推論を追加することで、クライアントの顔表情や思考を段階的に推測・活用できるため、最終的な応答の質がより高まった

具体的な進歩と課題:共感・論理・ガイダンス

評価では「共感」「論理的一貫性」「ガイダンス」がそれぞれ数値化されました。

「共感」はクライアントに寄り添い、不安やネガティブな思考を正しく理解するか

「論理的一貫性」は混乱のないアドバイスや説明ができるか

「ガイダンス」は実際の行動提案や手助けになるような方向性を示せるか

研究結果によれば、表情画像を取り入れたモデルはテキスト単体のモデルと比較して、共感スコアがかなり向上する傾向が見られました。これは、「相手が落ち込んだ顔をしている」という情報を文面だけでなく、画像データとしても確認できるため、自然と共感的な言葉かけをしやすくなるからと考えられます。

一方で「ガイダンス」については、まだ改良の余地があるようです。というのも、ただ慰めたり励ましたりするだけではなく、実際の行動プランを提案したり、次回また同じ思考の罠に陥らないための方法論を提示したりという部分まで踏み込むのは、かなり高いレベルの介入が必要だからです。

どうしても一般論的なアドバイスにとどまってしまいがちで、各個人の状況に応じた掘り下げが不足することが多いといいます。

ステージごとに評価する意義

今回の研究がユニークなのは、対話全体ではなく「ステージごと」にも評価を入れている点です。冒頭で触れたように、認知リフレーミングの段階は、「まえがき的導入(関係づくり)→問題探索→ブレーンストーミング→提案」と進みます。

その各ステージで「共感・論理的一貫性・ガイダンス」を点数化することで、より詳細にモデル同士を比較できるのです。

たとえば、導入の段階では「顔がとても悲しそうだけど、今日どんなことがあってそんな気持ちになっているのかな?」というように、主に共感が重要になります。

一方、「提案」の段階になると、「それを踏まえて、次にこういう行動を試してみようか?」と具体策が求められるので、ガイダンスの重要度が高まります。こうした細かい区別をすることで、どの段階でどのモデルが弱いのかがはっきりわかるのです。

実験結果では、「導入段階」でマルチホップ心理療法的推論を取り入れたモデル(CS-LLaVA w/MH)のスコアが特に改善したそうです。初期のうちからクライアントの感情や思考の罠を整理しながら進められるので、より自然で親身な対応ができたというわけですね。

限界と倫理面での配慮

とはいえ、今回の研究はあくまで「合成データセット」での実験です。実際の対面カウンセリングでは、表情のほかにも声のトーン、身振りや姿勢、さらにはクライアントの文化的背景など、考慮すべき要素が膨大に存在します。

また、表情から感情を推定するモデルには、文化差や個人差の問題も出てきます。同じ笑顔でも、ある文化では「うれしい」のサイン、別の文化では「気まずさを隠すための作り笑い」かもしれません。

そこを一律に読み取ろうとすると誤った解釈をしてしまうリスクがあるので、今後は多様な文化的背景への対応が課題になりそうです。

さらに、倫理面での懸念としては、「AIにメンタル面でのアドバイスを完全に任せていいのか?」という問題があります。AIセラピストはあくまでサポートの一環であって、専門家の判断や人間的な関わりを完全に置き換えるものではない、と注意する必要があるでしょう。

今後の展望:もっと多彩な情報を

この研究では、主に「顔の表情」をメインの非言語情報として取り入れましたが、リアルなカウンセリングではそれ以外の手がかりも非常に重要です。身体の動き、声量や声質の変化、話すテンポ、まばたきの頻度など、人間の心理は多種多様なシグナルを持っているからです。

将来的には、こうした複数の非言語情報を総合的に理解できるようなマルチモーダルAIが登場すれば、さらに「人間らしい共感」を実現するかもしれません。たとえば、声が震えているクライアントに対しては、優しいトーンで励ましつつ、画面越しに視線を向けるフレームを組み合わせる、といったことも可能になるでしょう。

ただし、それだけ複雑な情報を扱うには、個人情報やプライバシーを一層厳密に管理しなければなりません。セッションの録画・録音やリアルタイム表情解析が勝手に広まっては大問題です。もし実用化を目指すならば、技術面と同時に倫理面・法整備も検討しなくてはならない段階に来ています。

さいごに

AIが「文字情報+表情データ」という二つの視点から、クライアントの心の動きを汲み取りながら会話を進める――それは今まで以上に“人間っぽい”コミュニケーションに近づく大きな一歩です。研究の結果も、実際に表情を使うことで共感力や論理性を高められる可能性を示唆しています。

もっとも、完璧なアドバイスを期待するのはまだ時期尚早でしょう。実際の臨床現場や複雑な人間関係に適用するには、課題も多く残されています。今後はより多面的なデータを取り込み、文化差も含めた多様な背景に適応できるAIセラピストをめざすことが重要だと言えそうです。

あとがき

社内コミュニケーションや顧客対応の場面で、感情を的確に理解できるシステムがあれば、人材育成にも新たなチャンスが生まれるはずです。ただし、プライバシーと倫理面への配慮は不可欠。本記事で触れたマルチモーダル認知リフレーミングは、まだ道半ばの研究ですが、その可能性は十分に感じられます。ビジネスの未来に一石を投じる切り札となるか、今後の進化に注目していきたいですね。

「自分の顔がうまく笑えていないとき、AIがあれ?元気なさそうですねと声をかけてくれる日が来るかもしれません。」そんな世界は便利さだけでなく、私たちの心の機微に踏み込む気味の悪さも伴うかもしれません。それでも、実際に困っている人が少しでも救われるなら、この新しい技術を前向きに考えてみる価値はあるのではないでしょうか。

以上が、マルチモーダル認知リフレーミング療法をめぐる最新の試みと、その期待と課題のまとめになります。私たちの心を支える新たな方法として、今後の動向に注目してみたいですね。