〈考察〉能力はダウンロードすればよくない?AIの未来はマトリックス🥋 Google Gemini Pro1.5

考察

困難な状況にある主人公が、突然「能力」に目覚めて無双する展開、ワクワクしますよね

『マトリックス』では寝たきり人生から目覚めたばかりの主人公のネオが、格闘技の能力を脳にダウンロードする事で強敵のエージェントたちと互角に戦っていました

ChatGPTに代表されるLLM(大規模言語モデル)の進化を見てると、そんな未来が思い浮かんできました

「グーグルのGemini Pro 1.5のインコンテキスト学習(ICL)がすごいらしい」

OpenAIのSoraショックを思いっきりぶつけられて霞みがちですが、2024年2/16にアップデートされたGoogle(正確には親会社のAlphabet)のGemini Pro 1.5がなかなかの性能飛躍を見せています

①超大容量の入力情報を一発で理解

▼ あの分厚いハリポタ4.5冊分に相当する文字情報を一発で理解可能

Gemini Pro 1.5は100万トークンという長大な「コンテキストウインドウ」を持つため、非常に大量の情報をプロンプトとして処理する事ができます

“コンテキストウィンドウとは、モデルが一度に処理できるトークンの数を表す。これは、最小の構成要素であり、単語の一部、画像やビデオなどを含む物だ。

これは、人間で言う短期記憶のようなものだ。誰かと会話をする中で、直前の記憶を覚えておけなければ、まともな会話をこなすことも出来ないだろう。コンテキストウィンドウが長いという事は、一度に取り扱うことの出来る記憶が大きくなることを示す。”

この100万トークンというのは、英語70万語、プログラミングコード30,000行に相当する量です

2024年2月現在、競合のGPT4 turboが12万8千トークン、Cloude2.1が20万トークンで、動画や音声の認識はできません

②取りこぼしがほぼゼロ

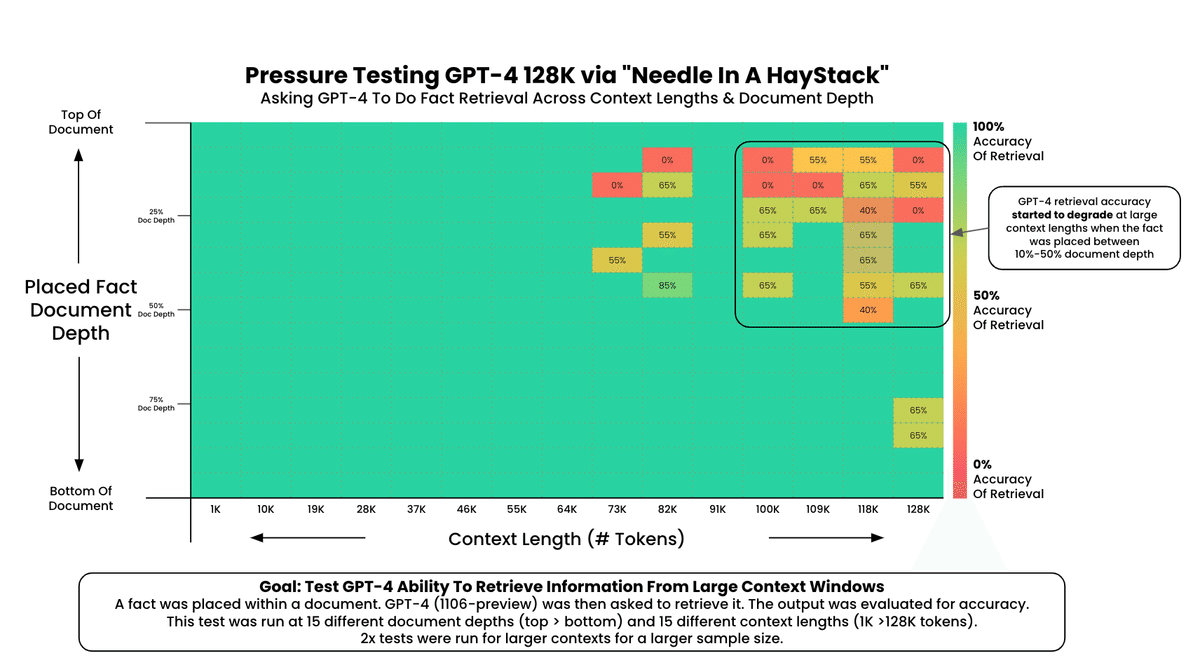

▼「Needle in A HayStack」干し草山の針探しテスト

とはいえ、GPT4 turboやClaude 2.1もそこそこ十分なウインドウサイズではあります

(太宰治の「人間失格」一冊でだいたい10万トークン弱)

ただし実際に使ってみると読み取りが不安定で長文読解の実用には耐えません

大量の文章をプロンプトに入力すると、冒頭や末尾に注目が集中して、真ん中のデータが抜け落ちてしまうことが多いのです

ところが、最新のGeminiは同様の干し草テストにおいて情報脱落率が1%以下を謳っています

Needle in a Haystack Tests Out to 10M Tokens

— Jeff Dean (@🏡) (@JeffDean) February 15, 2024

First, let’s take a quick glance at a needle-in-a-haystack test across many different modalities to exercise Gemini 1.5 Pro’s ability to retrieve information from its very long context. In these tests, green is good, and red is not… pic.twitter.com/hFFoFLQpkj

↑Google AI部門の総責任者Jeff Dean氏によるGeminiの干し草テストのポスト

③音声・動画も詳細に理解可能

▼1時間の動画からの針拾い

Gemini Pro1.5はマルチモーダルモデルのため音声や動画の入力にも対応していて、映画で1時間、ポッドキャスト11時間分のビデオコンテンツを理解する事が可能です

↑こちらは44分間のバスター・キートンの無声映画「シャーロック・ジュニア」をまるごと読み込んで、内容について返答させる動画です

④応用力が高い【インコンテクスト学習】

ユーザーがコンテクストウインドウで暫定的に与えた、モデルがまだ学んでいない特殊な情報(ドメイン知識といいます)を元に、LLMがその場で「インコンテクスト学習」を行う事で、高度な推論を行う事が可能です

Kalamang Translation

— Jeff Dean (@🏡) (@JeffDean) February 15, 2024

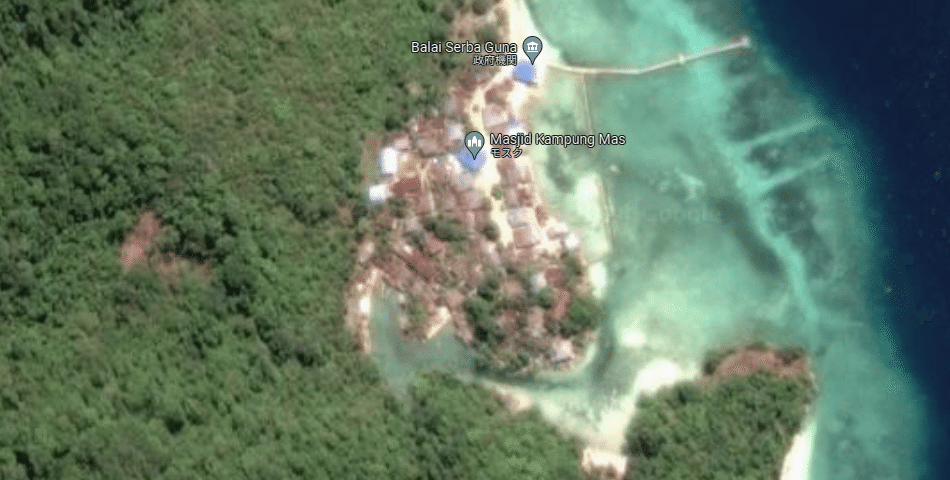

One of the most exciting examples in the report involves translation of Kalamang. Kalamang is a language spoken by fewer than 200 speakers in western New Guinea in the east of Indonesian Papua (https://t.co/HEGWvHpTnA). Kalamang has almost no online… pic.twitter.com/HtPSDlkLH8

Jeff氏のポストによると、カラマン語というパプアニューギニア西部の小さな島のみで話されている200人以下の話者しかいない言語の文法本と辞書を読みこませたところ、同じ本で学習した人間の学習者と遜色のない翻訳技量を示したとの事です

▼ 注目は「マルチモーダル」な大規模「インコンテキスト学習」

① 【🧐もうAIに嘘は言わせない!】現在研究されているRAGの手法が更に発展

現在LLMの利用において、企業のナレッジベースやDBを効率よく活用する技術が最もニーズがあります

各SIerがしのぎを削って開発をしている難易度の高い分野ですが、コンテキストウインドウが強化される事で技術革新が進む事が期待されています

↑RAGの代表的なフレームワーク「LlamaIndex」による、Geminai 1.5 ProのRAGに与えるメリットの考察記事

② 【😇麗しき妄想】ドメイン知識を使ったLLMなりきり専門家が爆誕!

ドラえもんのひみつ道具に「能力カセット」というものがあります

『能力カセット』には数学者、歌手、カンフーの達人、野球選手などの一流の能力が収録されていて、体内で再生する事で誰でも1時間だけその道のプロになることができます

いつものごとく意気揚々と道具を濫用して、学校に遊びにチートプレイを始めるのび太ですが、なぜか今回はドラえもんはとがめません

最後にロダンの「考える人」のカセットを使ったのび太がたどり着いた答えが

「ドラえもんともいつかは別れの時がくる…(略)…やっぱり努力はしなくちゃいけないんだよな。諦めずにな」

自ら悟ってドラえもんに道具を返すのでした

少年の成長を感じさせる、ほろ苦風味のとても良い話なのですが

さんざん努力済みの我々は

能力カセットをガンガン

再生すればよくない?

と思うわけです

身体能力の強化は無理ですが、クリエイティブな創造活動において、なんらかのドメイン知識、メタ知識(やり方の方法論)をパパっとLLMにインストールする事で今までにない瞬発力で創発を産める予感がします

新時代のクリエイターにとっての生成AIの使い所のひとつは、ここにあるのかもしれません

『プロの知見と視点をカセットに収録

LLMのICLでリミックスして

創発によるアウトプットを

バンバン産みだす!』

良識のある大人は何やら眉をひそめそうなコンセプトですが

この妄想の可能性について、しばらく実験を通して探ってみたいと思います

<追記 2024 3/4>

Cloudeのコンテキストウインドウが強化されました

コンテキストウインドウは20万のままですが

干し草針探しは、Gemini 1.5 Pro同様にほぼパーフェクトになった、との事です

100万のモデルもあるとの事ですが、こっちの脱落率は記載されていません

😲しかし変化が早い!!

X(Twitter)で

AIニュースをポストしています

フォロー頂けると嬉しいです!

note @note_PRで、AIの考察/検証/コンテンツ実験の眺めの記事を書いていますhttps://t.co/3ijSKrZdsE#note pic.twitter.com/mexlhvbudS

— psymen @AI CREATOR (@PsymenJ) March 14, 2024

この記事が参加している募集

この記事が気に入ったらサポートをしてみませんか?