Deep Live Camを使ってみた感想:リアルタイムFaceswapの可能性と注意点【素材用画像あり】

はじめに

近年、AIを活用した動画加工技術がめざましい進化を遂げています。

その中でも「Deep Live Cam」は、オープンソースソフトウェアとしてリアルタイムでFaceswap(顔のすげ替え)を実現するツールとして注目すべきものだと思います。

私自身、これまでStable Diffusionや各種AIモデルを用いて静止画の生成や加工に興味を持っていたのですが、動画のリアルタイム処理は敷居が高いイメージがありました。

しかし、Deep Live Camを実際に使ってみると、意外にも“そこそこ”簡単に動かすことができる上、それほどハイスペックな環境ではなくても“それなり”に動いてくれるという印象でした。

今回は、自分の環境(Windows 11 + RTX 4070搭載ゲーミングノートPC)でDeep Live Camを試してみた感想と、インストール時の注意点、そして実際にFaceswapを使った際の体感などをまとめてみたいと思います。

また、本記事の最後には、Deep Live Camで使える“実在しうるレベルのAI生成顔”素材についても言及しています。

もし顔出しをせずにライブ配信やビデオ会議で遊んでみたい方は参考にしてください。

1. Deep Live Camとは何か?

1-1. リアルタイムFaceswapを可能にするOSS

Deep Live Camは、GitHubのhacksider/Deep-Live-Cam で公開されているオープンソースのアプリケーションです。

これまでのFaceswapといえば、ディープフェイク技術を用いて静止画や動画を後処理で合成するような使い方が主でしたが、本ツールは“リアルタイムで”swap処理を行う点が最大の特徴と言えます。

ライブ配信ソフト(OBS StudioやZoomなど)と組み合わせることで、Webカメラ映像に対して別人の顔を合成し、そのまま配信に流すことが可能です。

モデルを最適化することで、ある程度軽量なGPUでも動作できるようになっており、ゲーミングノートPCクラスのGPU(RTX 3060、RTX 4070など)なら、そこそこのコマ数(フレームレート)を保ったままリアルタイムでFaceswapが実現できます。

1-2. Deep Fakeではない

しばしば混同されるのが「これはディープフェイクなのか?」という疑問です。

Deep Live Camは確かにFaceswap技術を使うので、一見ディープフェイクのようにも見えます。

ただし、「元の顔の骨格や配置がすべて残ったまま、顔パーツだけを別の顔に置き換えている」と考えると、厳密には“ディープフェイクとは異なるもの”と捉えるのが正確です。

どちらかというと、顔のマスクを被る感覚に近いイメージでしょうか。元になるモデルの顔要素を被せるだけではなく、自分の顔+相手の顔をミックスした、ある種“第三の顔” になっていると言われると分かりやすいと思います。

2. Deep Live Camのインストール方法(手動)

2-1. Windows版のインストーラーと料金

Deep Live Camには、Windows向けに有償(20ドル)のインストーラーも用意されています。

公式GitHubの説明によると、このインストーラーを使えば煩雑な環境構築をスキップできるということです。

しかし、私の場合は“できるだけコストは抑えたい”というのと、“Pythonまわりに多少慣れているので自分で環境を整えられそう”という判断から、手動インストールを選択しました。

本記事では、公式の手順に沿った手動インストールのポイントを整理します。

2-2. Pythonのバージョン指定に注意

公式手順にもありますが、Python 3.10を使う必要があります。

例えばWindows環境で複数のPythonバージョンを管理している場合、py -3.10 -m venv venv のようにして仮想環境(venv)を3.10でバージョン指定して作成する必要があります。

もしシステムにインストールされていない場合は、あらかじめPython公式サイトから3.10のインストーラーを入手しておきましょう。

2025年1月5日時点では、以下が3.10系の最新版です。

2-3. モデルファイルのダウンロードとリネーム

Deep Live Camを利用するには、Faceswapの推論を行うためのモデルファイルが必要です。

とくに注意したいのは、公式マニュアルで触れられているモデルのダウンロードでは記載不十分の、以下の点です。

inswapper_128.onnx をダウンロードしてモデルフォルダに入れる。

そのファイルを inswapper_128_fp16.onnx という名前にリネームする。

改名するのをうっかり忘れると「モデルが見つからない」エラーになって起動できないので要注意です。

2-4. そのほかの環境整備

公式のGitHubリポジトリにあるrequirements.txtを確認しながら、

pip install -r requirements.txtでライブラリを導入していきます。

GPUに対応させるために、torch や onnxruntime が必要ですが、これらは、基本的には手順どおり進めれば問題なくセットアップできるはずです。

ただし、CUDA対応の以下は、結果論としては同じバージョンをインストールしているだけであり、不要でした。

pip uninstall onnxruntime onnxruntime-gpu

pip install onnxruntime-gpu==1.16.33. Deep Live Camを実際に使ってみた

3-1. 使用環境

PC:Windows 11

GPU:RTX 4070 搭載ゲーミングノート(Stable Diffusionで1枚生成に約1分ほどかかるスペック)

メインメモリ:16GB

Python 3.10 環境

上記スペックでも、ある程度のリアルタイムFaceswapが可能でした。

私の場合、顔出しをテストするためにPCの内蔵Webカメラを使いつつ、OBS Studioから映像をキャプチャして録画・配信のテストを行っています。

3-2. フレームレートの挙動

正直に言うと、常に完全な60fpsが出るわけではありません。

GPU負荷が高いシーンや状況では、コマ落ち(fpsの間引き)が発生しており、映像がややカクつくことがありました。

Deep Live Camの設定画面には「Keep fps」というオプションがあるのですが、これをオンにすると処理負荷によって遅延(ラグ)が増える可能性があります。

リアルタイムの会話や配信では映像と音声のズレが生じると不自然さが目立つため、私は「Keep fps」はオフにし、多少コマ落ちしてもリアルタイム性を重視する設定にしました。

3-3. Swapの品質

実写の顔を前提としているのが大きな特徴です。

特に人間の顔を被せる場合は、元の顔とモデルの顔が“なんとなく似ている”ほど自然な仕上がりになります。

一方で、アニメ顔やCG調のキャラクターを被せようとすると、かなり厳しい結果になりがちです。髪型や輪郭が大きく異なると処理が破綻してしまい、落書きみたいな顔になりがちです。

これらの理由から、Deep Live Camは基本的に“実写系の別人顔に” 変身するのに向いていると考えてよさそうです。

また、前髪についても注意が必要です。

まず端的に前髪の名残が移りこみやすいのみならず、ImageFXの前髪がある女性の画像でテストした結果、眉毛が繋がって大変なことになってしまいました。

薄い前髪なら、そこまで気にならないこともありますが、前髪のない画像を使った方がベターな結果を得やすいでしょう。

3-4. メガネや指などの細かいパーツの認識

個人的に興味があったのが、メガネなどの小物パーツがどの程度拾われるのかという点です。

試した結果、メガネを被せること自体は認識されますが、フレームによって揺らいだり、かすれたりすることがありました。

一方、杯を持っているときの指やコップなど顔を覆った場合は、比較的問題なく認識され、顔はカバーされているというのが、所感です。

3-5. mouth_mask設定で口の動きを自然に

Deep Live Camには、mouth_maskという設定があります。

これは、口元付近のマスク処理を強化して、よりリアルな口の動きを再現するための機能です。

ライブ配信や通話など“話す”機会がある場合は、このmouth_maskをオンにすることで、口の動きが比較的自然に見えるようになりました。

ただし、その分計算負荷は上がるので、GPUが弱い環境だとフレームレート低下があるかもしれません。

3-6. “完璧美女”にはなれない

Deep Live Camで変身できるのは、先述のとおり“元の顔とモデルの顔をミックスした第三の顔”です。

たとえばAIで生成した、人間離れしたレベルに整った美人の写真を使っても、元の顔の骨格や表情の名残は強く残ります。

結果、「完璧な黄金比美女」になるのはなかなか難しいというのが正直なところです。

むしろ、大きくかけ離れた顔を使おうとすればするほど違和感が顕著になってしまいます。

つまり、Deep Live Camは極端にビフォーアフターを変えたい場合にはあまり向かず、“現実にいそうな別人”へ変身するのが得意と考えたほうがよさそうです。

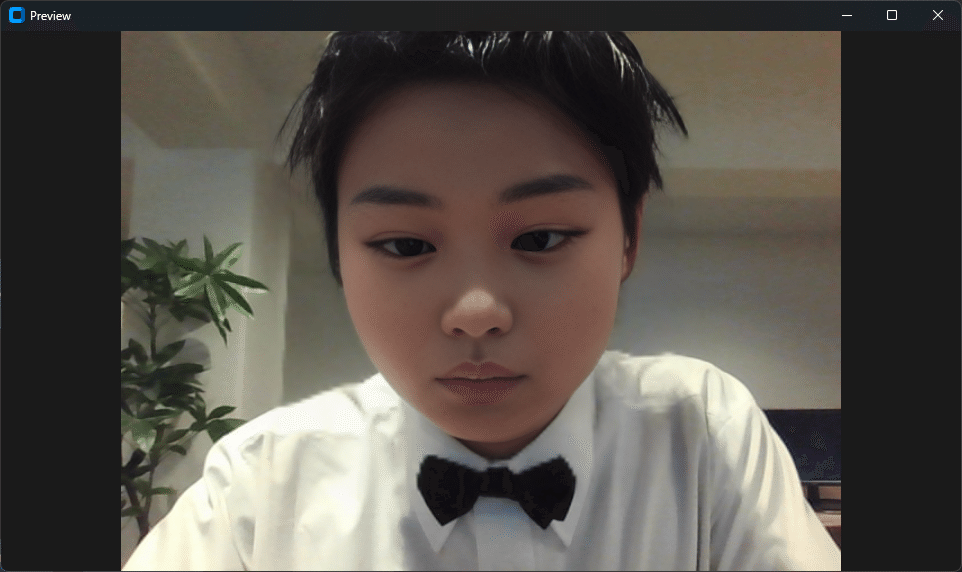

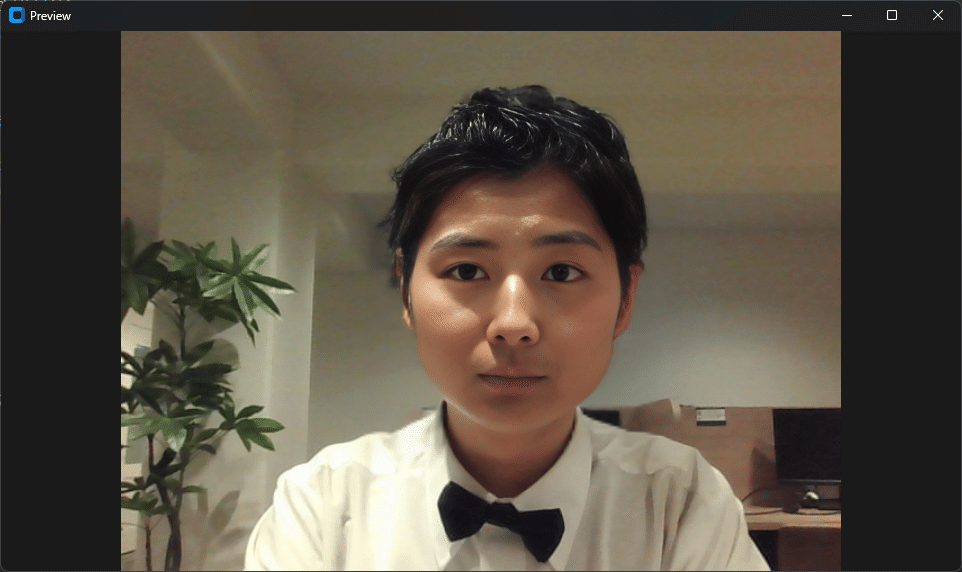

4. 素材画像を配布します

とはいえ、実際の別人を使うことには危惧感がある方向けに、素材画像を配布します。

4-1. 素材画像を用意する理由

Deep Live Camを使ってFaceswapを楽しむにあたって、一番のネックは「どの顔画像を使うか?」という点ではないでしょうか。

実写の芸能人や有名人の顔写真を使うのは、肖像権やパブリシティ権などさまざまなリスクが伴います。

また、身近な友人、知人などの顔を使うとしても、自分自身の顔を別人に渡す行為を不安に感じるお相手も多いことでしょう。

そこで、“実在しうるレベルのAI生成顔” を素材に使うことで、肖像権リスクを回避しながら “自分とは違うけれどもリアルな顔” を楽しめるようになります。

4-2. AI生成顔素材のメリット

私がこのたび配布する予定のAI生成顔素材は、「日本人っぽい自然な顔」 をメインにしたものです。

MyTH株式会社の独自モデルで生成されており、商用可能性などの点でも問題ありません。

ライセンスはCC-BY-SA 4.0で配布します。

簡単に言えば、使うときは先行するクリエイター(ここでは「MyTH株式会社」)の名前をクレジットしてね、加工物は同じライセンスで配布してね、ということです。

(参考までに、Wikipediaと同じライセンスです)

黄金比に最大限近付いた、理想の美を目指した人工彼女及び彼女を混ぜ込んだ「子孫」モデルの顔や、ChilloutMixとその系譜をひく、完成度が高いながら童顔な顔と比べると、もう少し素朴な印象になっております。

また比較的自然な顔が出るImageFX系ともまた違った多様性があるため、リアル系統のFaceswapをテストするときに使いやすいはずです。

もちろん、パーツの位置や輪郭が落ち着いているので、Deep Live Camでswapした際のクオリティも比較的安定しています。もし興味があればぜひ使ってみてください。

4-3. 実際のデータ全量

全量はこちらからDL可能です。

まとめ:Deep Live Camの魅力と注意点

今回は、Deep Live Camを手動インストールし、実際に動かしてみた感想や、使う上でのコツや注意点、さらにはAI生成顔素材の配布意図まで紹介しました。要点を振り返ると、以下のようになります。

Deep Live CamはリアルタイムFaceswapを行うOSS

公式GitHubで無料公開されている

Windows向けインストーラーは20ドルだが、手動インストールも可能

手動インストール時の注意

Python 3.10 で仮想環境を作成する(py -3.10 -m venv venv)

inswapper_128.onnx をダウンロード後、inswapper_128_fp16.onnx にリネームする

pip install -r requirements.txt でライブラリ導入(GPU対応必須)

RTX 4070クラスでもリアルタイムに動く

ただし高fpsは望めないことが多く、シーンによってカクつく

「Keep fps」オフでリアルタイム性優先、「mouth_mask」オンで自然な口の動き

実写系のSwapに特化

アニメやCGキャラは破綻しやすい

顔+髪型が似ている素材ならかなり自然に合成できる

AI級美女との相性は微妙。そのレベルでの大幅な美形化は期待しすぎないほうが無難

AI生成の実写風素材を配布

肖像権リスクを回避しつつ、自然な仕上がりを実現したい

商用利用や公的な利用には注意が必要

総じて、Deep Live Camはハードルが思ったより低く、しかも実用性が高いFaceswapツールだと感じました。

もちろん、「ディープフェイク」に近いイメージがあり、倫理的・法的なリスクに気を付けなくてはいけない場面もあるかもしれません。

しかし、正しく使えば、配信やオンラインミーティング、あるいはエンターテインメント用途でかなり楽しめる技術です。

たとえば、自分の顔を出したくないけど、“声だけではないバーチャル感を出したい” 場合や、単純に配信の“ネタ”として楽しみたい場合などに、Deep Live Camは強力な武器になるでしょう。

今後もバージョンアップや新機能の追加が期待されるので、興味のある方はぜひGitHubをウォッチしてみてください。

私も引き続き、このツールの活用方法をいろいろ試してみながら、改善があればまたレポートしていきたいと思います。

もし本記事の内容が参考になったり、実際にDeep Live Camを触ってみて新たな発見があったりしたら、ぜひコメント欄やSNSで教えてください。

リアルタイムFaceswap技術が、これからどのように発展していくのか、今後がとても楽しみです。

それでは、みなさんも楽しいFaceswapライフを!