【JKI】017_Housing_Market_Madness_01_ETL

【JKI_017】課題を確認

Just KNIME It! (JKI)

今回の挑戦はこちら

問題文をDeepL翻訳し少し加筆して以下に

課題17:住宅市場の狂気

レベル:中

説明: アメリカの住宅価格は少々制御不能な状態です。このチャレンジでは、住宅価格が時代によってどのように変化してきたかを見ていきます。このチャレンジの課題は次のとおりです。

1. CSV Readerノードを使って、ローカルマシンにファイルをダウンロードすることなく、この課題のデータセットをそのリンクから直接読んでください。

2. 月次データを使って、年次データを計算し、最も劇的な変化をした 3 つの地域名を可視化してください。

注:変化を計算するために、データが収集された年から直近の年までを考慮する。欠損値は自由に無視してよいとします。

3. 現在、住宅の平均価格が最も低い州(地域に関係なく)を見つけてください。

4. Wikipediaによると、「2008年9月15日のリーマン・ブラザーズの破綻は、サブプライムローン危機のクライマックスであった」とあります。

これが住宅市場に与えた影響を、どのようなビジュアルで表すことができるでしょうか。

私たちは、質問2に対する回答を参考に、ビジュアライゼーションを雑然とさせないようにしました。

【課題1:入力データの読み込み】

CSVファイルへのリンク:

を使ってCSV Readerでのデータ読込設定をします。

設定:

URLでのファイル格納先指定をしています。

結果:

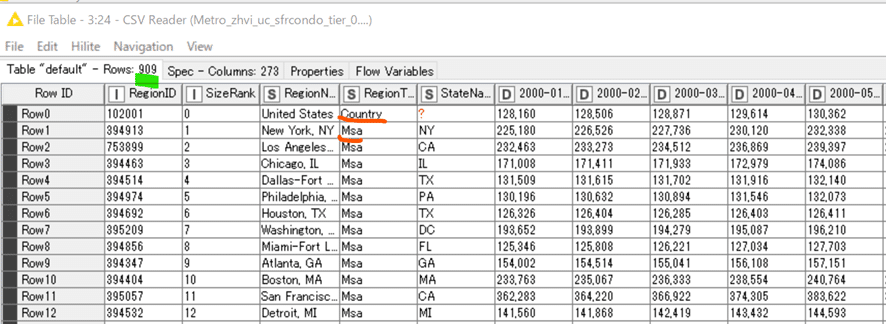

アメリカの国全体データと908地域 (msa)の合わせて909行。

2000年から今年2022年までの住宅価格データが一覧になっています。正直言って高いのか安いのかは私では評価しがたいです。

【課題2:住宅価格変動の地域別比較】ひとまずデータ整形まで

この課題はちょっとKNIME workflow (WF) が長めになってしまいました。

2回に分けて説明します。

ひとまず解析の前のデータ整形部分を説明します。

最初のROWINDEXデータ取得は、実は今回不要です。大きくデータを再編する前には元のデータテーブルの何行目だったかを整数値でデータ化する習慣があって設置したのですが、省略可能です。

Unpivotingは私も比較的よく使う手法でして、人間に見やすく横並びに同種のデータが並んだデータテーブルをKNIMEで集計処理などしたいときは、同種のデータを縦並びに変えます。過去のチャレンジでもTidy Dataについて紹介していたので参考までにリンクを貼っておきます。

設定:

結果:

各地域の909行だったデータが22年間の各月のデータに分けられたため243612行に増えています。人には一見して分かりにくいんですがKNIMEでの集計はしやすくなってます。

次は集計のために年と月の数値カラムが欲しかったので、上図の2つのノードで生成しました。

設定:

日時データ型へ

Locale設定は本来en-US(米国型)がいいと思いますが、ja-JP(日本型)でも問題なかったので横着してそのままにしています。余談ですがここは一度よくわかってなくって恥をかいたところです。この時はen-US(米国型)にすれば簡単だったのに…。

年月データ抽出

結果:

これで新たに生成したYearカラムを使って年単位での集計ができます。

設定:

集計対象のカラムはもっと減らせたと今となっては思います。

結果:

各地域の毎年の住宅価格の平均が算出されました。上図にもある通り、かなり欠損値が多いのが問題です。

注:変化を計算するために、データが収集された年から直近の年までを考慮する。欠損値は自由に無視してよいとします。

とのことでした。ここが今回の課題を解く際に皆さん迷うところではないかと思います。私は大いに悩みました。

私は下記の通りの方針としました。

A) 欠損値が多く比較しにくい2008年以前のデータは解析対象から除く

B) 直近とはデータが12ヶ月分揃っている2021年を示すと考える

上記の方針でこの後さらにデータを前処理してからの解析としました。

続きは後半で。

WFは既にKNIME Hubに上げています。

おまけ:

【JKI_016 感想戦はおいといて】

前回のJust KNIME It! (JKI)は公式解答とWF設計は本質的に変わらなかったようでうれしかったです。そしてもっと嬉しいことに最近はJKIのおかげで世界中のKNinjasと交流が始まっていることです。

上記のイベントのおかげです。勇気を出して参加してよかった。

招待して下さったRosaria SilipoさんはもともとKNIMEエバンジェリストとしての活躍に尊敬の念を抱いておりましたが、今は加えて感謝の気持ちでいっぱいです!

前回にWF紹介をしたsryuさんともつながることができましたし、本当にJKIに参加していてよかった!

しかもJKI皆勤賞は意外に少なくって、KNIME社公認では世界で3名だけ!

まあKNIME Hubでの投稿時のタグ付けとかが結構なハードルになっているとは知っているのですが、それでも嬉しいニュースでした。

この記事が参加している募集

記事を読んでいただきありがとうございます。 先人の智慧をお借りしつつ、みなさんに役立つ情報が届けられたらと願っています。 もしサポートいただけるなら、そのお金はKNIMEの無料勉強会の開催資金に充てようと思います。