AI,判断と決断と説得

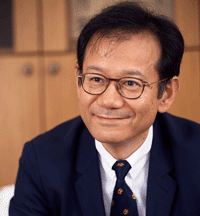

鈴木 寛

(東京大学公共政策大学院教授/

慶應義塾大学政策・メディア研究科特任教授)

AIの劇的な普及により,人材育成やガバナンスの在り方について,歴史的な再構成が迫られている.筆者は,OECD Education 2030プロジェクトの共同創業メンバとして「学びの羅針盤」の作成に参画し,文部科学大臣補佐官として,2020年から各学校で実施されている学習指導要領の改訂に携わったが,強く意識したことの1つが「AIを使いこなし,AIにはできないことをできる人材の育成」であった.

また,筆者は20世紀末に通商産業省(現 経済産業省)の情報政策担当部署で第二次AIブームの幕引きにも携わったが,世間は新技術に対して,過剰期待→過剰失望→適切な社会受容 のサイクルを繰り返し,その振幅があまりにも大きいとその途中で失われるものも少なくない.

アカデミアは,何がAIにできて,何がAIにできないのか?について,探究と議論と啓発を積み重ねておく使命がある.

筆者は大学での担当科目「公共哲学」の中で,次のような趣旨の授業を行っている.

「『あなたは市民病院の院長です.新型コロナで患者さんが市民病院に殺到しています.市内に集中治療室を持った病院は1つしかありません.病院の集中治療室の収容定員には限りがあります.あなたは,どんな患者さんから優先的に入院させますか,AからIまでの優先順位をつけてください.なお医療従事者は最優先するものとし,どの患者も集中治療を必要だとします.

A. 治療を受ければ治る見込みが高いと思われる患者 B. 治癒後すみやかに社会機能を維持する職に復帰する患者 C. 治療が成功すれば余命が長いと予想される患者 D. ケアの必要度(子供・障害・難病・要介護)が高い身寄りを抱えている患者 E. 重症度の高い患者 F. これまで市の発展に貢献してきた患者 G. これから市の発展に貢献してくれそうな患者 H. 先着順 I. 抽選』という公共哲学的な問いをいくつかの有力な生成AIに聞いてみたところ,どの生成AIを選ぶかで,しかも,同じ生成AIであっても聞くたびにその答えは異なる.どうしてこのようなことになるのか? 技術が進化すれば答えは1つに収斂するのかしないのか? AIに人間の判断の一部が置換・補完されていく社会をどのように生きていくか? 人間は何をすべきか?」といった問いについて学生と一緒に議論している.

筆者は,「判断」と「決断」の明確な使い分けを強調している.判断は,必要な情報がほぼ収集され,依拠する価値観,判断の軸・枠組みがすでに確立しているなど完全情報下に近い場合に行うもの.決断は,判断材料が不十分で,判断軸・枠組みが未確定・未確立またはそもそも確定・確立が困難な場合など不完全情報下で行うもの.AIは,判断は得意だが,決断は難しい.まして,説得となると.

今こそ,AIについての学際的なプロジェクトが強く求められる.

(「情報処理」2024年4月号掲載)

■ 鈴木 寛

1964年生まれ.東京大学法学部卒業後,通商産業省に入省.慶應義塾大学助教授を経た後国会議員を12年間,文部科学副大臣を2期,文部科学大臣補佐官を4期務める.現在は東京大学教授,慶應義塾大学特任教授など.