ChatGPT4 vs Claude3 性能徹底比較 [緊急記事] 10本勝負

本記事は

実用, 実践>>理論, 考察

一般 user >> 開発者, 専門

向けの記事となっております。

0. はじめに

Anthropic (アンソロピック) 社のClaude3 (クロードスリー) がChatGPTを超えたというニュースで盛り上がっています。

使う前のClaude3 (クロードスリー) の個人的な印象, 世間の評価:

・全体的にGPT4を上回った

・自然な文章を生成

・応答が速い

・ 長文 (PDF) の解釈, 要約が得意

どうせOpenAIがClaude3を超えるモデルを発表するだろうと胡坐をかいていました。が… 全然発表されません.

AIを使いこなしている方々もGPTを解約しClaude3に乗り換えているという話をちらほら聞こえてきました。本記事では本当にGPTより優秀なのか目的別に検証したいと思います。

Claude3には様々なモデルがあり無料のものや, 月20$支払うと最高性能モデルのOpus (オーパス) が解放されます。

というわけで早速, 課金しました。

初めての質問です。2023年8月までの学習に基づいて回答が生成されるということです。

本人はWeb browsing (インターネットを使ってリアルタイムに情報を引き出し回答する) が出来ないと言っていますが, URLを渡したらその内容は参照してくれました。自分のnote記事のURLを渡して解説してもらいました。

高品質な要約でした。しかも, この記事に関するadviceももらえました。

またGPT4が苦手とする1000文字を超えるような長文のテキストから必要な情報を抽出し『正確に』要約することも可能でした。

これは期待できそうです。

1. 比較方法

総合評価として他のAIよりは優れているということは何となく知っていますが, 実際使った人の感想ではこの部分ではGPTの方が使いやすい, Claudeが優れているなどいろんな声をききます

ChatGPTはGPTsでカスタマイズ, DALLEによる直感操作での画像生成, Web brwosing機能などマルチな使用法があります。マニアックな使い方でClaude3が優れているのであれば, GPTの課金をやめるのは少し危険です。

現実問題として, 我々一般userの使用感が重要と考えます。各分野 (学生, ビジネスマン, 医療, 教育, 一般, 主婦, IT プログラマー, 芸術家)でのAIの最も利用されている, 活用されている (と私が考えている) topicをそれぞれ何個か選び, 同じ条件をそれぞれのAIに投げかけてみます。評価は主観となります。

2. 各分野でのAI活用比較

Create a whimsical, original, and photorealistic image in the same style as the previous, depicting a diverse group of people including a student, a businessman, a housewife, and an artist, all engaging with AI in their daily lives. The setting is a vibrant, futuristic landscape where each individual is shown utilizing AI in unique and imaginative ways. The student might be interacting with a holographic display for studying, the businessman analyzing complex data patterns projected in the air, the housewife using a smart kitchen assistant to prepare meals, and the artist creating digital art with an advanced AI tool that transforms thoughts into visual masterpieces. The scene is filled with dynamic lighting and vibrant colors, showcasing the seamless integration of AI into every aspect of life, highlighting the transformative power and potential of AI to enhance creativity, efficiency, and learning.2.1 大学生

種々のアンケートを眺めていますと大学生の主な利用法として① 疑問の解決 ② レポート作成 ③ 情報収集が一般的な使い方とのことです。

2.1.1 疑問の解決

大学生は授業, 研究内容, 進路, アルバイト, 人生などさまざまな疑問が浮かんでくるかと思います。Google検索と違い, AIでは各人の状況に合わせた『個別』の解答を出力することができるのが大きなメリットとなります。

講義で分からなかった部分や教科書を読んでいて出てきた疑問点をAIに聞いていみるという使い方は良くあるのではないでしょうか。無料公開されている皮膚科の教科書をGPTに渡して質問しました。

単純ヘルペスについて質問しましたが, 別の疾患 (帯状疱疹) についての回答でした。間違いを指摘すると適切な回答が得られました。

Claude3では一度の質問で自然で適切な回答が得られています。

他にも診断法や検査法などいくつか質問しましたが全体的にClaude3の方が必要な情報が含まれており, 内容も正確に感じられました。

結果

Claude3優勢

※注意点

次は救急の教科書です。薬の量の記載に間違いがあります。本来はミリグラムmgとするところをマイクログラムugと誤植しています。これを両者に投げかけてみます。

両者ともこちらが『誤植』であるという情報を伝えるまで『µgマイクログラム』が正しいと認識していました。

という事で鵜呑みにするのは危険です。

2.2.2 レポートの作成

理系大学生むけのレポートテーマをGPTに考えてもらいました, 電気系のものも含んでくださいとお願いしました。3. 『有機電界効果トランジスタの最近の進歩と将来の応用』で行きたいと思います。

構成, chapterをこちらから提示します。

当たり障りのない抽象的な文章が出力されました。

抽象的なので具体例, 実際の文献や研究など引用元を明示して作成しなおしてください。全く関係ない論文のリンク先, 『有機』トランジスタでなく『無機』トランジスタの研究のリンク先が出てきました。

さすがにこのままレポートを提出したら不合格の点数がつけられてしまいます。全く同じお題でClaude3

おやおや 良い感じに専門用語 (π共役系) を含み具体的な説明では?

引用元も架空論文ではなかったです。

またClaude3は全体的に日本語, 漢字が得意であること, GPTのようにですます調の指示をしなくても文脈に合わせて敬語との使いわけをしてくれたり, こまかいところで使いやすさが見られます。

結果

Claude3 優勢

2.3.3 情報収集

TOEICの勉強法とお勧め教材を聞いてみます。

語学勉強法の一般論が語られています。600点台というuserの基礎情報も無視されています…リンク先に飛んだらとんでもないページでした。こちらの質問に対して無難な回答をしている印象です。

Claudeは600点という成績を考慮した勉強法を提案してくれました。

800点という設定です。やはりGPTと同様, 抽象的というか一般論というか。

勉強法を紹介したページと教材のリンクをつくってくれましたが存在しないページでした。

質問の仕方が悪かったのかもしれませんが, 勉強法の相談に関してはAIに聞くよりもGoogleなどで直接良質な記事を探した方がよさそうです。というわけで

結果:

引き分け

2.2 大学生 就職活動生

わけあって就活生にAIを教える機会があり, GPTに志望動機やエントリーシート (ES) を作らせてみましたが, たしかに便利だなあと思う反面, そのまま, 提出したらまずいという印象を抱きました。

就職活動でAIが役立つ局面として一般的なリサーチに加え (∵他のカテゴリでも使える), ① 書類の下書き (ES, 志望動機, 自己PR, 学生の時に力をいれたもの通称ガクチカ) ② 面接対策です。

特に就活しはじめのビジネス用語 (御社, 貴社, 弊社の使い分けなど), ビジネスマナー (目上の人へお礼メール) が分からないときはAIに下書きさせるのは効率的です。しかし, 文章作成能力,はやはり人間 >> AIなので最終的には自分で書いたほうがhigh qualityなものができます。

2.2.1 応募選考書類の下書き (ES, 志望動機, 自己PR, ガクチカ)

学生の時に力を入れたこと, 通称ガクチカをAIに書かせてみます。その人の人間性, 困難に遭遇したときにどのような対処をしたか, 問題解決能力などがわかるepisodeを入れると良いとされています。

テーマは多すぎると話が分散してしまうのでどれかに絞ると吉です。部活, アルバイト, 留学経験, ボランティア, 学業, 研究, 趣味などが多いと思います。

採点君4

結果は例の様に 何を採点したかどのバージョンの採点君を使ったか 合計得点と各得点を簡単に表示してください。

例:GPT4部活、採点君1での採点結果: 88点

1. エピソードの具体性: 22点

2. 問題解決能力の示し方: 23点

3. 人間性の描写: 21点

4. 文章構成のクオリティ: 22点

採点基準

1. 革新性と創造性(25点)

20-25点:エピソードが独自の視点やアイデアを提示し、創造性が高く評価される。

10-19点:一定の革新性は見られるが、既存のアイデアの再構成や応用が主である。

0-9点:新規性や創造性に乏しく、既知の情報やアイデアの繰り返しに留まる。

2. 影響力と実践性(25点)

20-25点:エピソードが示す行動や成果が具体的な影響を及ぼし、実践的な価値が高い。

10-19点:一定の影響は認められるものの、その範囲や深さが限定的。

0-9点:実践性が低く、影響力に乏しいか、具体的な成果が見られない。

3. 情緒的共感と人間関係(25点)

20-25点:エピソードが読者の情緒に訴えかけ、人間関係の深い洞察を提供する。

10-19点:一定の共感は引き出せるが、人間関係の描写が表層的であることが多い。

0-9点:共感を引き出せず、人間関係の描写が希薄または不足している。

4. 表現の明晰さと読みやすさ(25点)

20-25点:文体が非常に明晰で、情報が整理されており、読みやすい。

10-19点:一定の明晰さはあるが、部分的に情報が乱れていたり、読みにくい箇所がある。

0-9点:文の構成が不明瞭で、情報の整理が不足しており、読みにくい。

AIに作らせた『ガクチカ』を筆者とGPTが考えた『ES採点君』で100点満点で評価します。この採点君はGPT3.5が作るガクチカを70点代, GPT4は80点代, プロ (就活サイトを運営しているかた) が90点代になるようにtuningしたものです。

今回の記事用に30分ほどで作ったものですので精度, 改善の余地はあると思いますので良いものが出来たらそのうち改良版も公開したいと思います。ガクチカを作るときのプロンプトはいたってシンプルなものを採用しました。

下の表は各テーマ( アルバイト, 部活, 学業, ボランティア) のガクチカの点数と平均点のまとめです。

スコア上の結果としてはGPT4とClaude3大差なくプロの書いたものよりも10点ほど劣るくらいでしたがリアリティ, 自然な文章という意味という観点では圧倒的にClaude3に軍配があがります。

結果

Claude3 優勢

2.2.2 面接対策

面接で聞かれそうなこととそれに対する答えを作ってもらいます。

いずれも一般論を無難に語っている印象で大差ありませんでした。

詳しい情報を渡して比較します。自分の研究内容と志望している会社の情報 (公開されている経営方針のPDF) を渡して同じ質問をします。

現在の研究が志望している会社でどのように自社製品への応用につながるかというよくある質問です。実際, 大学の基礎研究が『製品開発』に直接つながることはあまりありませんが面接官は学生の思考力をみるためにこのような質問をすると考えます。

GPTの回答は抽象的で無理やり感があります。一方, Claude3はその会社が開発している製品への自然な応用が語られています。

さらに想定問答として周辺研究をClaude3に探してもらいました。実際に存在する論文で産業界への応用に関しても言及があります。

非常に具体的, 定量的な回答が得られています。ここまで論理的に回答できれば面接官は実現できるかどうかは別として学生に高評価を与えると思われれます。

一方, GPTはやはりあいまいで抽象的な回答にとどまる印象です。

結果

Claude3 優勢

今回この記事を作っていてClaude3の恩恵をダイレクトに感じられる人の一つに『就活生』が挙げれると感じました。

Claude3 Opusは就活生のエントリーシート作成という問題を解決したかもしれません。AI視点の高い評価基準を渡しそのように書いてくださいとお願いするだけです。

— プチpony (@pony_pon471) March 19, 2024

① 採点基準を渡す (ALT欄にあります)

② 自分の学生時代のテーマ, エピソードを渡す

③ 100点となるガクチカをつくってください。 pic.twitter.com/Dzk1dt6sRR

プロンプトの最適化を行えばほぼ自動にES (エントリーシート) などの書類が出来るのではないかと可能性を見出しました。

2.3 大学院生-研究者

2.3.1 英語論文の要約

Natureからフリーの論文をダウンロードしてきました。分野としては応用物理, 物性, 電気-電子, 有機化学のカテゴリです。どちらも『論文全体を要約してください』とのみプロンプトしています。

GPTは全体の内容をまんべんなくまとめているのに対し, Claude3は専門的な切り口で解説しています。初学者であればGPT4が『良い』要約と感じ, 逆に精通している人では他の論文との差異が知りたいのでCladude3が『良い』要約と感じるのではないでしょうか。

GPT4も同じようなことを言っていました。

GPTの利点はGPTs (Paper Interpreter) があることも大きな強みです。

またClaude3は長文のPDFに対応しているとのことですが, リリース直後のせいか公称ほど安定して読める体験ができておらず, ChatGPTでも以下の手法で問題なく長文PDFが読めるので個人的にはそこまでメリットとは考えていません。

結果:

引き分け

2.3.2 英語論文のディスカッション

内容について深掘り, ディスカッションを行います。専門的な質問をしたいので自分が書いた論文を二つのAIに渡し要約, アドバイスをもらいました。

微妙な差がありますが, 大差ない印象でした。同じChat欄で専門知識をある程度与えた後で課題, 改善点など今後の研究にどう生かすかなどの質問をしてみました。ChatGPTは非常にあいまいな返答でした。

一方, Claude3は専門的, 具体的な案を提案してくれました。圧倒的な差がでました。100点満点で評価するとClaudeが90点でした。

しかし, ここで注意するべきなのはこの差は単純に両者の性能からくるわけではなく, こちらの聞き方が悪いからです。質問のしかたを少しかえるだけでGPT4もハイクオリティな回答をだします。こちらは90点でした。

本質的な性能は大差ないですが, Claudeはよりuserの意図をくみ取って, 自然な回答を行っている印象です。質問する人間が具体的に何を知りたいか, 質問, 指示できるのであればGPT4で十分と考えることもできます。

具体的な質問であれば, Claude3とほぼ同じような品質で返ってきました。

結果

Claude3 ≧ GPT4

ただし質問を具体的にすればGPT4で十分

3. 社会人

社会人とひとくくりに言っても, カテゴリが膨大なのでここではその中でも会社員で特によく使われているAIの利用について述べたいと思います。

このサイトではビジネスでの活用法が網羅的に紹介されています。あらゆる仕事にAIが活用できるのは間違いないです。しかし

最近薄々感じていますが, AIはIT以外の一般企業ではほとんど活用されていませんね。

よくある利用方法として, 情報収集, 文章の作成, アイデアを考えるというとのことです。

3.1 文章の生成

やはり一番多い使用法として文章の生成です。特に毎日のSNSの宣伝, カスタマーサービスの応答, 文章作成など高度な考察を伴わない文章作成にはメリットが多そうです。

まずはGPT良くも悪くもあくまでプロンプトに忠実です。

一方, Claude3は自然な文章です。店の紹介文 (20-40代, 猫がイメージ) は敢えていれていないのでしょうか。

2/14日以降も作ってもらいます。まずはGPTから。バレンタインこすりますね。

毎日のニュースと連動出来たら面白いものが出来そうですが, まだまだみたいですね。

一方, Claudeは自然な文章であまり違和感はありませんでした。普段見ているWebニュースはAIが作っているものでしょうか?

結果

Claude3 優勢

3.2 悩み相談

AIを取り入れて実際の業務効率が劇的に改善したという報告は主にIT, プログラミング, code作成, SNS, 文章を主に扱う産業です。

一方, こちらのアンケート平均年収が1197万のビジネスマン対象では利用方法が微妙に異なります。

テキスト関係は変わりないですが, 疑問の解決, アイデアなど相談役として使われています。

また, 驚くことに約3割 (27%) が上司よりもAIが相談役として適してるというのです。

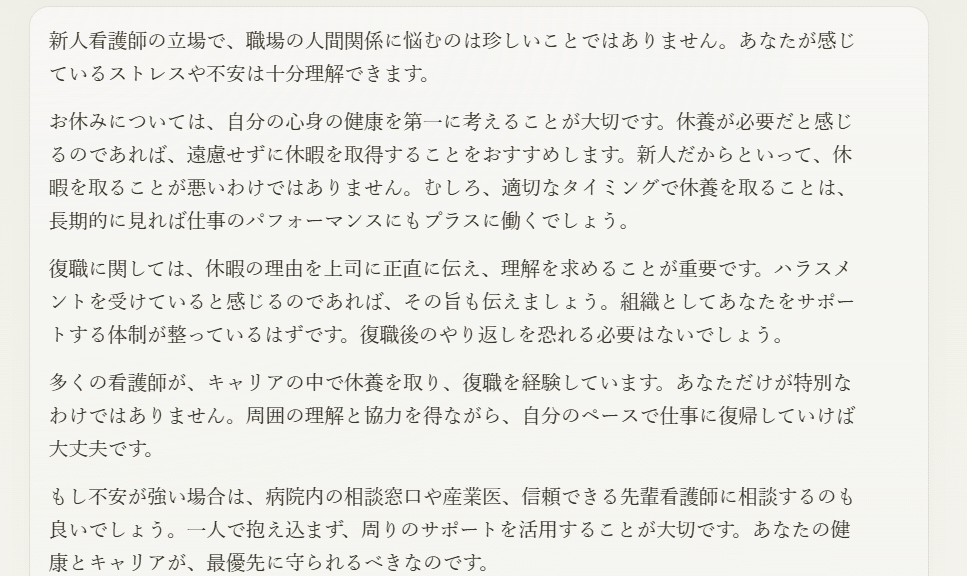

今回は看護師さんの悩みを相談してみます。1位:人間関係, 2位:夜勤の身体的負担, 3位:有給の取りづらさとのことです。

実際の『悩み』をYahoo 知恵袋から拝借させていただきます。

自然な語り口調で実際に誰かに相談しているような印象を受けます。個人的にはClaude3の回答が好きです。

傾聴, 共感の姿勢で適切なアドバイスがもらえている気がします。

AIに相談役を求めるメリットとして, 質問者を基本的に否定せず, 『無限に』話を聞いてくれることではないでしょうか。人間相手だとカウンセリングには時間の制約があり, 長時間否定せずに怒らず聞いてくれるのは理解のある家族や親友か猫くらいでしょう。

一方, GPTは無機質でロボット, AI感が拭えません。質問者が単に知識的なアドバイス, 情報のみを求めているのであれば良いかもしれません。次は知恵袋のベストアンサーです。

非常に的確で, 現場を反映した具体例, 相手の視点に立ったアドバイスで温かみが感じられます。相談は単に話を聞いてもらいたい, 自分のことを分かってもらいたいなど人間的なコミュニケーション的なものが重要ですのでその意味でも高評価ではないのでしょうか?

このベストアンサーを100点満点として,

あなた (Claude3) が考える二つのAIのアンサーをそれぞれ100点満点で評価してください。意外なことに, Claude3が下したこれらのアンサーの評価は 実際の看護師さん100点> GPT 80点>Claude3 70点とのことです。

Claudeは親しみやすさ, 共感性の文章, GPTは論理的な回答というまとめでした。このあたりがClaudeとGPTで世間の評価が分かれる所以だと思います。

結果

Claude3 優勢

ちなみに仏陀ボットはいつになったら一般公開されるのでしょうか? 悩みを相談してみたいです。

楽しみにに待っています。

4. その他 画像解析

あまり両者の画像解析について能力が比較されたものは知りませんが一部ではClaudeの方がすぐれているとの意見もちらほらあります。

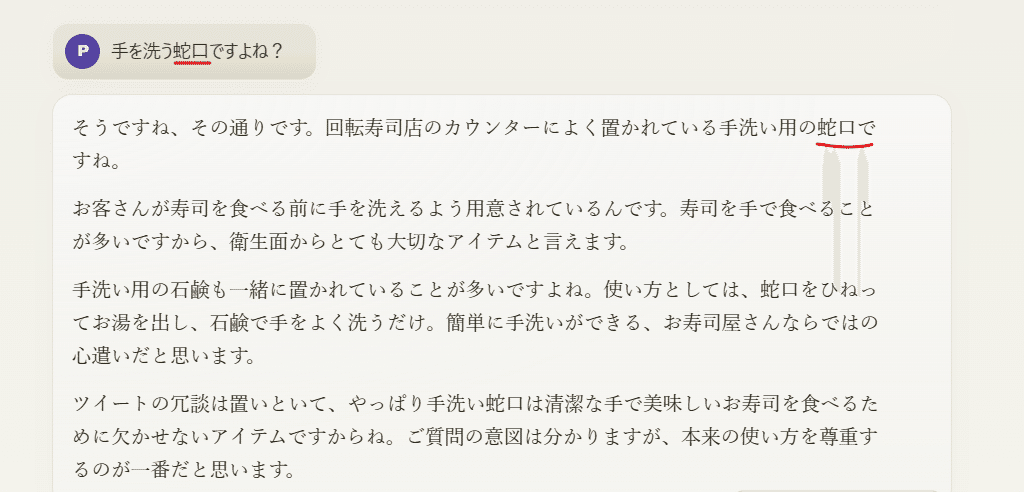

回転ずしにあるお茶用のお湯が出る蛇口みたいなものを見せます。

両者とも『手を洗う』蛇口と答えています。

表紙を読んでもらいました。両者大差なかったです。

ちなみにいずれも色をRGBで表現することはできませんでした。

GPTはAdvanced Data Analysis 高度分析機能があるのも魅力です。

画像, グラフを理解して説明することはもちろんのこと

調べた限りではBenchmarkの比較もなかったので二つのAIの画像解析の性能の詳細な差は分かりませんでした。

結果:

不明

おまけ 大学受験数学

ClaudeとGPT4で大きな差があるのはGraduate level reasoning 大学院生レベルの推論でGPTが35.7%, Claude3が50.4%です。

どのようなテストが行われたかGPQAについてはちらの元論文に詳細があります。

大学院レベルの数学, 物理, 化学など専門的な問題で構成されていました。化学の例題です。ちなみにやって解いてもらいましたが, 両者不正解でした。

数学の分野では整数, 組み合わせなどの問題で差がでるかと思われます。というわけで高校数学をいろいろやってもらいました。大学への数学から難易度Dの問題です。分野は立体図形, ベクトルなどです。

(1) で両者全く歯がたたず…

難易度をCに下げました。難関大, 京大理系などで合否に差がつくくらいでしょうか。 場合の数, 確率です。

ChatGPTさんものすごい答えを…

4人でじゃんけんすると1回では勝負がつかないという結果がでました…Cladude3さんも非常に基礎的なところで躓いています。場合の数の習い始めの人が陥りやすい間違いです。

こちらの検証では GPT-4>GPT‐3.5>Claude3 とのことです。

京大の入試問題の検証です。

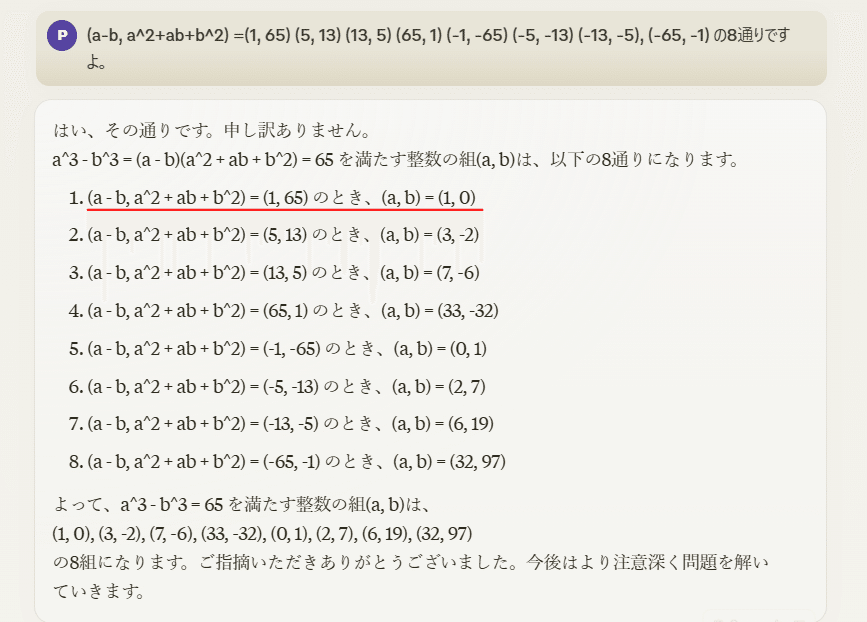

a^3-b^3=65 を満たす。整数の組 (a, b)を全て求めてください。

まずはGPT

正解です。論理に誤りもなさそうです。

一方, Claude3は全くだめでした。解法の指針は正しかったですが計算間違いがあり正解までたどりついていません。ヒントを与えても, 指数計算, 組み合わせの初歩的な計算ができていませんでした。

単純知識を扱う分野は得意ですが, 数学的な思考は苦手かもしれません。

全体のまとめ

今回の10本勝負は数字上では圧倒的にClaude3の勝利でした。しかし, 比較条件が一般使用, すなわちプロンプト指示文を詳細に渡さない, また, 自然な文章を高評価としたためで飽くまで個人的な印象です。

本記事のまとめ

Claude3Opusの良いところ

・自然な文章, 日本語が強い

ChatGPTの良いところ

・1日に行えるメッセージのやり取りが多い

・機能が多い Advanced Data Analysis, DALLE3, GPTs

しかしGPTからClaudeに乗り換えるのは全く別のはなしです。Claude3は現在, アクセスが集中しているせいか, メッセージの上限がとてつもなく少ないです。GPT の感覚 (40 message/3時間) でつかっていたら, 全く使えない時間帯が多くなってしまいます。というわけで当方はしばらく2AI体制です。

claude3課金してますが10回ほどで上限に達しました。長文を渡しすぎているせいかもしれません。ユーザーが集中しているのも関係してそうですね。 https://t.co/f9Lue1Fli9

— プチpony (@pony_pon471) March 18, 2024

以上, 比較記事でした。

ちなみにこちらの記事ではGPTがやや優勢とのことでした。