【画像生成AI】 Flux.1 / SD 3.5 / AuraFlow を快適に使いたい! VRAM 16GB は必要なの?

はじめに

こんにちは、きまま / Easygoing です。

今回は 画像生成AI を使うときにベストな GPU を探します!

参考になるサイト!

まずはじめに、画像生成AI で利用する GPU を比較するとき、とても参考になるサイトをご紹介します。

Tim Dettmers's Blog(英語)

このブログでは、米国のAI研究所のスタッフが、AI の計算に必要なハードウェアについて詳細に解説しています。

まずは一覧のグラフ!

まず最初に、先ほどのサイトから GPU の性能の一覧のグラフを引用します。

Aシリーズ・Hシリーズ:業務用

RTX・GTXシリーズ:一般用

GPU の型番は、数字が大きいものほど新しく、性能が高いことを示しています。

AI 用途 で GPU の性能を比較するとき、赤色のグラフに注目して下さい。

一番下の GTX 1060 は 2016年に発売された GPU ですが、わずか 数年のうちに GPU の性能が数倍以上 になっていることが分かります。

GPU を販売しているのは 3メーカー

2024年11月 現在、GPU を販売しているメーカーは次の3社です。

NVIDIA(RTX・GTX シリーズ)

AMD(Radeon シリーズ)

Intel(Arc シリーズ)

この中で、画像生成を含めた AI 用途 に最適化されているのは NVIDIA です。

NVIDIA の GPU は ハードウェア的に AI の演算に最適化 されているので、画像生成でも高い性能を発揮します。

GPU の世代別の特徴

それでは、NVIDIA の GPU の世代別の特徴をご紹介します。

コンピューターの演算は、浮動小数点(Floating Point)計算を利用して行います。

NVIDIA の GPU は 2年ごとに新しい世代が登場していて、さらに 世代ごとに新しい浮動小数点形式に最適化 されています。

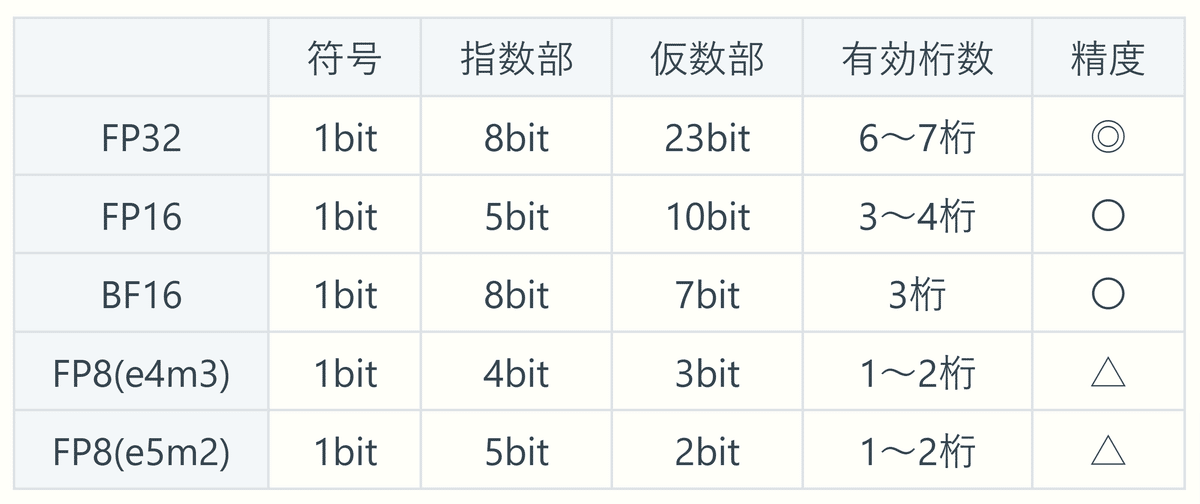

FP32, FP16, BF16, FP8 形式

AI の演算で使われる主な浮動小数点形式は、次の5つがあります。

浮動小数点形式は、表の上にあるものほど精度が高く、画質も良くなります。

現在の主流は FP16 形式

FP32 形式は精度が高いですが計算の負荷が重い形式です。

FP32 → FP16 → FP8 形式になるにつれて、容量は半減して VRAM の使用量と演算の負荷は減りますが、精度も低下してしまいます。

現在の AI 用途 の主流は FP16 形式 です。

BF16 は FP16 の精度を落とす代わりに安定性を上げた形式で、特にモデルのトレーニングが安定する利点があります。

RTX 2000 シリーズは FP16 に最適化

2018年に登場した RTX2000 シリーズは、一世代前の GTX1000 シリーズに比べて、新しく Tensorコア を搭載して、ハードウェア的に FP16 形式に最適化 されました。

Tensor コアがあると、FP16 の処理を従来の 2〜4倍以上の速さで実行することができます。

はじめのグラフを再掲しますが、RTX 2000 シリーズは 一世代前の GTX 1000 シリーズと比べて、処理能力が倍近く向上しているのが分かります。

RTX 4000 シリーズは FP8 に最適化

RTX 2000 シリーズの登場以降、AI の演算の主流は FP16 形式でしたが、最近登場した Flux.1 / SD 3.5 / AuraFlow は容量が大きいので、今は容量と計算の負荷を減らした FP8形式も使われる ようになっています。

Tensor コアは世代が進むにつれて改良が進み、特に RTX 4000 シリーズは FP8 形式の処理にも最適化 されました。

先ほどのグラフでは、RTX 4000 シリーズは黄色のグラフの FP8 形式の処理能力が大きく向上しています。

AI 用途では、VRAM が大切!

AI の演算では多くのメモリを使用するので、メモリの性能と容量が大切になります。

VRAM は GPU に搭載されるメモリで、次のような種類があります。

GDDR は VRAM 用に最適化された高性能なメモリ で、一般的な用途の DDR 形式よりもずっと帯域幅が広いので、処理を高速に行うことができます。

VRAM が不足すると・・・

もし処理中に VRAM の容量が不足した場合、足りない分はシステム RAM を使って演算を行います。

この場合、システムRAM は帯域幅が狭く、さらに PCIE 接続を介した接続遅延も発生するので 処理速度が大きく低下 します。

VRAM の容量を超過した場合、処理時間が数倍以上かかるので、実用性がほとんど無くなってしまいます。

VRAM はどれぐらい必要?

それでは、 VRAM の容量は実際にどれぐらい必要になのでしょうか?

まずは、いろいろな 画像生成AI の VRAM 使用量を測定してみます。

測定環境

RTX 4060 Ti 16GB

システムRAM 64GB

1024 x 1024, eular, 20step

動作確認モデル

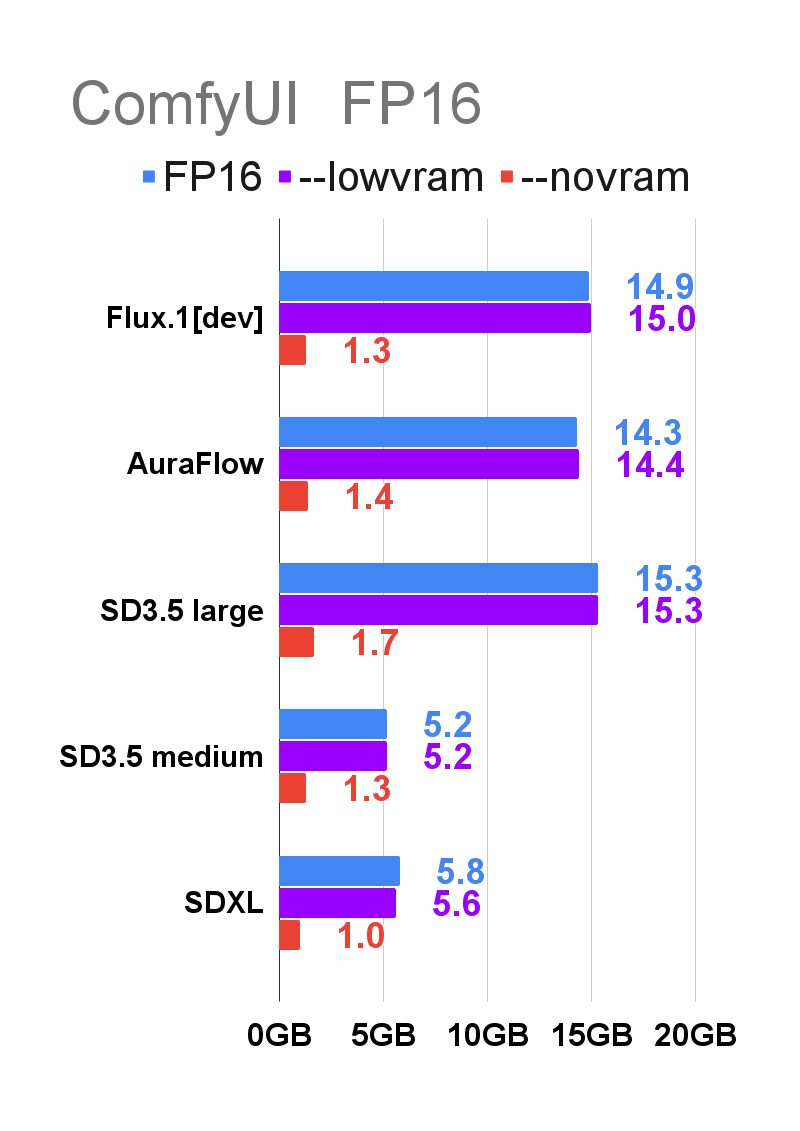

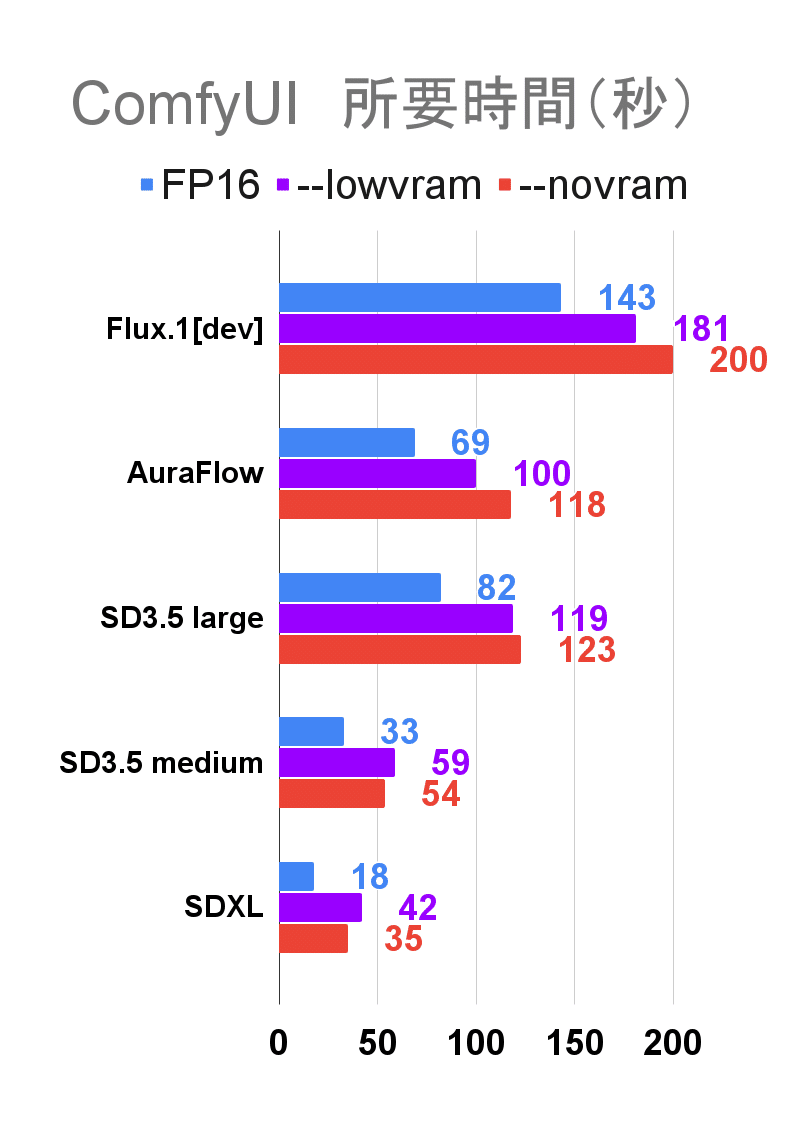

ComfyUI FP16 形式

まずは、青色のグラフの FP16 形式 の VRAM 使用量を見てみます。

新しい 画像生成AI の Flux.1 / AuraFlow / SD3.5 large では、VRAM の利用量が 14〜15GB に達しているので、快適に利用するには VRAM が 16GB 必要 です。

SD 3.5 medium と SDXL は VRAM が 6GB あれば実行できます。

--novram オプションで VRAM 使用量を節約!

ComfyUI には、VRAM の容量が少ないときにモデルの一部をシステム RAM に移動して処理する --lowvram と --novram の2つのオプションがあります。

先ほどのグラフでそれぞれを紫と赤のグラフで示していますが、紫色のグラフを見ると、--lowvram を利用しても VRAM 使用量は変化していません。

一方で、赤色の --novram では、初めから VRAM を利用せずにシステム RAM で処理を行うため、VRAM の使用量を大きく節約する ことができています。

--novram オプションを利用すると、最初から低速の システム RAM を利用するので、画像の生成時間は 1.5 ~ 2倍 ほど長くなりますが、それでも VRAM を超過するよりずっと高速 に処理を行うことができます。

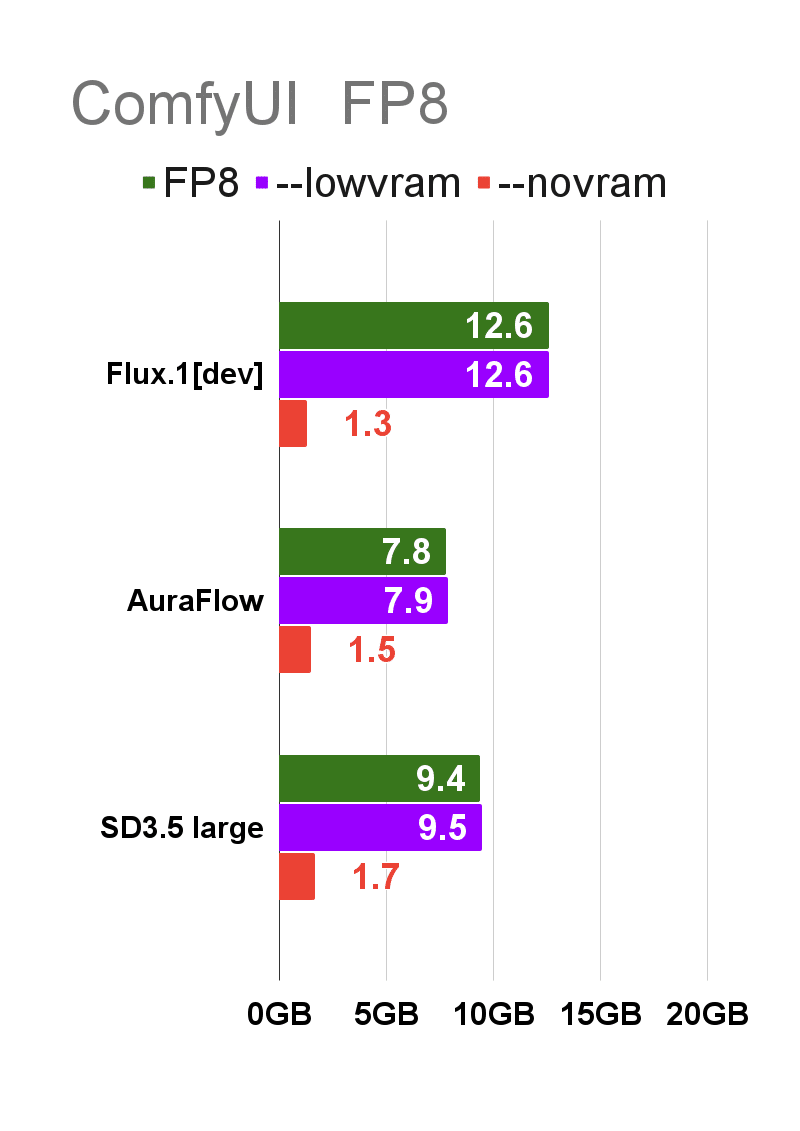

ComfyUI FP8 形式

今度は、FP16 形式よりも処理の軽い FP8 形式の VRAM 使用量を確認します。

緑色のグラフの FP8 形式は、いずれのモデルでも FP16 形式と比べて VRAM 使用量は少なくなりますが、それでも Flux.1 の VRAM 使用量は 12GB を超過 しています。

VRAM 12GB で Flux.1 を利用したい場合、FP8 形式でも圧縮は不十分 です。

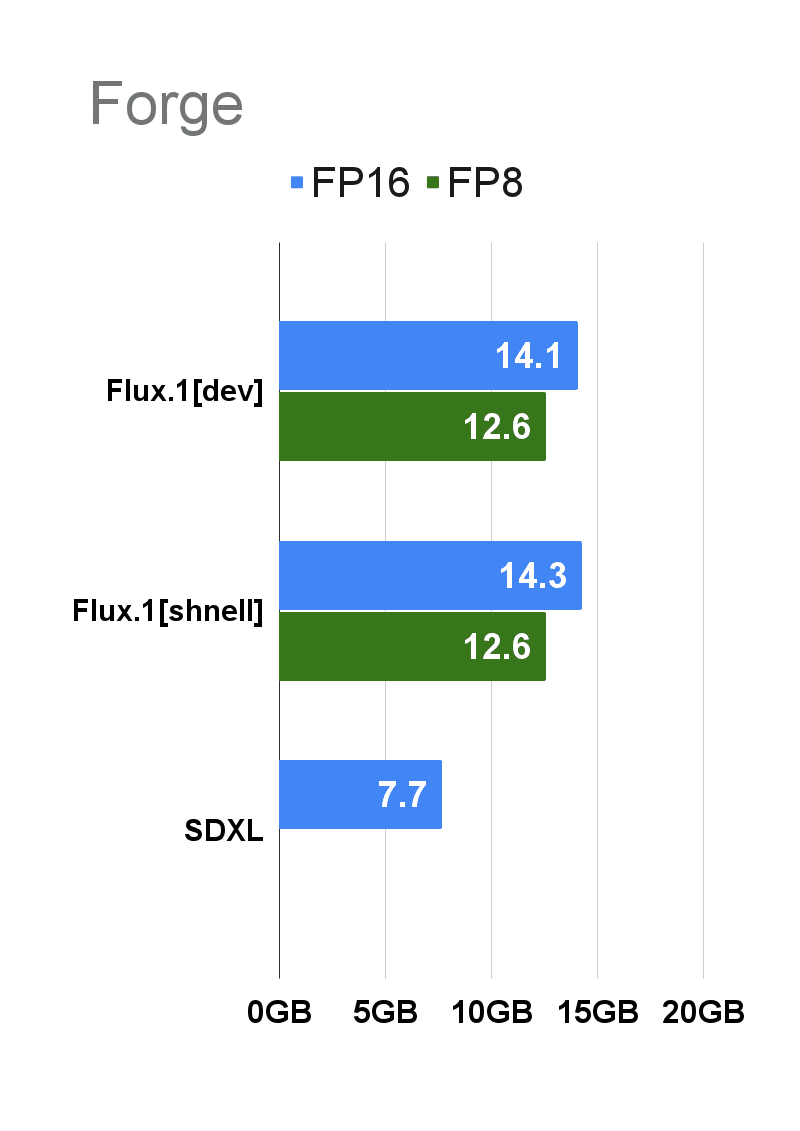

Stable Diffusion WebUI Forge

最後に Stable Diffusion WebUI Forge の VRAM の使用量を測定します。

Stable Diffusion WebUI Forge でも、Flux.1 は FP16 / FP8 いずれの形式でも VRAM 使用量は 12GB を上回ります。

VRAM 12GB 以下の環境で Flux.1 を使う場合、2024年8月に登場した新しい GGUF 形式の利用 が勧められます。

実際の GPU を比較!

それでは、ここから実際の GPU の性能と価格を見てみます。

予算に余裕があるならハイエンド

まず、最新の RTX 4000 シリーズのラインナップを見てみます。

予算に余裕がある場合は、もちろんハイエンドの GPU がオススメです。

RTX 4000 シリーズで、値段あたりの VRAM 搭載量が多いモデルは次の3つです。

RTX 4090(24GB)

RTX 4070 Ti SUPER(16GB)

RTX 4060 Ti(16GB)

RTX 4060 Ti には VRAM の容量が違う2種類のモデルがあり、画像生成を含む AI 用途に適しているのは VRAM 容量の多い 16GB のモデルです。

計算速度は上位のモデルほど処理が速く、Tensor コアの数が概ね処理速度に匹敵すると考えて良いでしょう。

VRAM の容量を重視した RTX xx60 シリーズ

ハイエンドの GPU は性能は申し分ないですが、費用を抑えたい場合はミドルレンジの GPU が候補に上がります。

NVIDIA はミドルレンジ帯の RTX 4060 Ti と RTX 3060 に VRAM の大容量モデルを投入しています。

手頃な価格で AI 用途の GPU が欲しい場合、この 2つのモデルが有力な候補になります。

保証のついた中古の GPU もある

GPU は機械部品なので、中古品でもほとんど問題なく動作 します。

PC ショップでは返金保証のついた中古 GPU も販売していて、私の経験上は購入後 1週間以内に不具合が出なければ、まず問題なく使用できます。

中古GPUの不具合で多いのが冷却ファンの回転不良ですが、これはより大きな通常ファンに交換すれば、冷却効率もアップします。

RTX 4060 Ti は、発売からあまり時間が経っていないので中古品の割安感はありませんが、RTX 3060 は中古品をかなり手頃な価格 で入手できます。

これはどこまでリスクを許容するかになりますが、保証が必要なければメルカリなどでさらに安く購入できるでしょう。

RTX 5000 シリーズはどうなるの?

RTX シリーズは 2年ごとに新シリーズが登場していて、本来は今年中に RTX 5000 シリーズが発売される予定でしたが、発売は 来年に延期 されるようです。

RTX 5000 シリーズ の VRAM は、Samsung 製の新しい GDDR7 3GB チップがラインナップに加わる可能性があり、そうすると 従来の 2GB チップの 1.5 倍の VRAM 容量 が実現する可能性があります。

なお、最上位モデルの RTX 5090 は、従来の 2GB チップを利用した VRAM 32GB になると見られていて、これを上回る容量の製品がリリースされることはないでしょう。

RTX 5060 の価格は?

NVIDIA の業績は絶好調で、特に AI用途の GPU については完全にシェアを独占しています。そのため、RTX 5000 シリーズはかなり強気の価格設定になるとみられています。

最近は円安の影響もあり、日本での GPU の価格は上昇していて、RTX 4060 Ti 16 GB はすでに旧来のハイエンドクラスの価格帯に近くなっています。

新しく発売される RTX 5060 の価格もおそらく上昇すると思われるので、画像生成で利用する GPU を購入するとき、必ずしも新製品の発売を待つのが良いとは言えない でしょう。

オンラインサービスと、ローカルPC はどっちが安い?

オンラインサービスは高性能な計算資源を利用できますが、使い続けるにはレンタル費用がかかります。

一般的に、300日以上使用する場合 は、オンラインサービスよりもローカルで GPU を購入する方が割安になると言われています。

また、以前に紹介した SeaArt AI をはじめ、オンラインで Flux.1 / SD 3.5 / AuraFlow を使えるサービスの多くは FP8 形式に最適化 されていて、FP16 の利用が制限 されています。

AIイラストで画質を重視する場合は、FP16 形式が使えるローカルの環境に分があるでしょう。

まとめ:GPU は VRAM を意識しよう!

画像生成AIで利用する GPU について概説しました。

GPUを購入するなら NVIDIA

Flux.1 / SD 3.5 large / AuraFlow を快適に使うなら、VRAM 16GB が必要

RTX 4060 Ti 16GB または RTX 3060 12GB がオススメ

今回は GPU と VRAM について見てきましたが、次回はメモリを節約する新しい GGUF 形式 を取り上げたいと思います。

今回の記事が、皆さんの GPU 選びのご参考になれば幸いです。

最後までお読みいただきありがとうございます!

クリエイター紹介

さて、恒例の note クリエイターさんを紹介するコーナーです。

今回ご紹介するのは 夏目 龍頭 さんです!

夏目さんは、画像編集プラットフォームの Canva を使って創作をされています。

こちらの記事では、前回ご紹介した あゆなさん とのコラボで、あゆなさんの着物妖精のイラストに加筆修正して作品を仕上げています。

このような 大胆な修正ができるのは、AI イラスト ならでは だと思います。

また、こちらの作品ではモノクロとカラーを融合させた新しい表現を追求されています。

いずれも AIイラストの新しい世界を追求した作品で、必見です!