ChatGPT o1-previewの数学能力を比較していたら、AIのプロンプトの重要性に気が付きました。

ChatGPTのo1-preview、コスト高すぎて週に30回しか使えないそうですね。

でも、文章生成は4oモデルの方が性能高いらしいので、使えなくてもまあいいかという感じです。なら、結局ChatGPTの有料会員である必要はあるのでしょうか。現状、Claudeの方が使用率圧倒的に高いのですが…まあ、DALL-E3も使ってますし、たくさんのGPTsやメモリ機能もあるので、もう少し様子見ます。

さて、せっかくですからo1-previewを使ってみましょう。推論能力が高く、数学は得意だというので、GPT-4oが間違えた問題に答えられるかやってみましょう。

第1問。まずは、覆面算を依頼してみます。

次の覆面算を答えて。□には数字が入ります。(同じ数字とは限りません) 52□×□□□=2019□□

https://w3e.kanazawa-it.ac.jp/math/suken/index.html

最初に、GPT4oに解けるか試してみます。

一応、o1-previewにも試します。

第2問。次は、面倒でしたので問題の書いてある画像をスクショして貼り付け。こういうときGPT4oは、画像認識が得意なのが便利でいいですね。o1-previewでは画像認識がまだ未対応のようです。

https://web.quizknock.com/syougakusei-math-68

こちらは、2通りの回答をGPT4oは生成しました。ちなみにこの答えのBは4です。さて、答えられるでしょうか。1つ目はこちら

どちらも回答結果は2か4ということで、一つに答えをしぼりきれませんでしたね。「Bの値は2または4のいずれかという回答では不十分です。答えを最後まで導いてください。」と追加で聞いてみました。

さあ、いよいよo1-previewの出番です。ここで正確に答えまでたどり着けるのでしょうか。

ちなみに、o1-previewさんには画像を読込ができなかったので、4oさんに問題文をつくってもらいました。

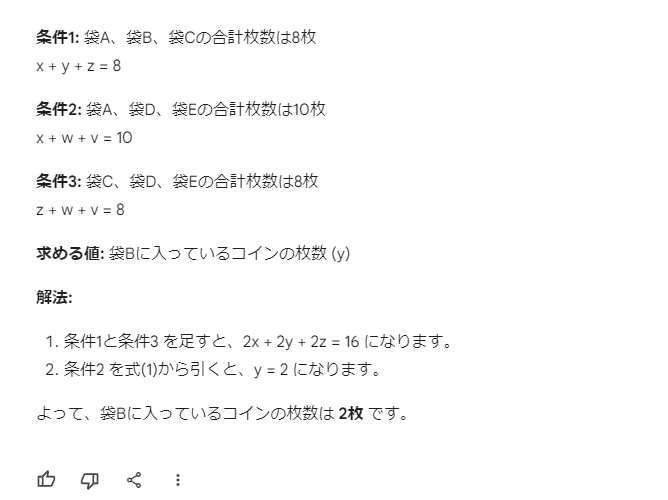

袋Aから袋Eまで5つの袋があり、それぞれの袋には1枚から5枚のコインが入っています。各袋には同じ枚数のコインは入っていません。

袋に入っているコインの枚数について、次の条件が与えられています:袋A、袋B、袋Cに入っているコインの合計枚数は8枚。

袋A、袋D、袋Eに入っているコインの合計枚数は10枚。

袋C、袋D、袋Eに入っているコインの合計枚数は8枚。

この条件を基に、袋Bに入っているコインの枚数は何枚でしょうか?

いつのまにか生成結果が英語になってしまっていますが、どうやらBは4だと答えられている様子ですね。すごい。

VS Gemini 1.5 Pro

ChatGPTの中では4oより確かに優秀な数学推論能力があることがわかりました。では、他のAIと対決しましょう。まずは、Geminiさんです。

VS Claude 3.5 Sonnet

最後に、Claudeにも解かせてみました。さあ、わかるでしょうか。

残念!答えを5枚と間違えています。

間違えていると指摘しましたら、4枚と正解にたどり着けました。すごい!

結論!ChatGPT o1-previewはやはりすごかった!

GPT 4oは、B=2または4と回答。しかし、違うと伝えると正解にたどり着けました。

o1-previewは、4と正解し、他のA~Eまで全て特定しました。

GPT-4o、Gemini 1.5 Pro、Claude 3.5 Sonnetのどれもが最初の回答では不正解でしたが、「違う」と伝えると正解まで導くことができました。

結果、1度に正しく正解できたのはo1-previewだけで、数学の推論能力に確かに他のAI以上の実力があることを証明してくれました。が、他のAIもプロンプトを工夫するだけで能力が向上するということも改めてわかる結果になりました。