【本文無料】Sustainability拾遺集(02)ノーベル物理学賞・化学賞の衝撃

「集計範囲を拡大する方向のベイズ更新」すなわち過去投稿への追補。今回取り組むのはこちら。

2024年ノーベル物理学賞について分かりやすく解説!『人工ニューラルネットワークによる機械学習を可能にする基礎的発見と発明』

ヒントン氏は、サイモン・オシンデロ氏やイー・ワイ・テー氏と共に、制限付きボルツマンマシンを使って、層を1つずつトレーニングする「プレトレーニング (事前学習)」と呼ばれる方法も開発したんだよね。これは現在のAIに使われる「深層学習 (ディープラーニング)」に繋がる、非常に重要な手法の開発になるよ。

2024年ノーベル化学賞について分かりやすく解説!『計算によるタンパク質設計』と『タンパク質の構造予測』

計算によって新たなタンパク質の構造を設計したのは1997年にバシル・ダヒヤット氏とスティーブン・メイヨー氏であると言われているんだよね。2人は「ジンクフィンガー」と呼ばれる、亜鉛イオンを構造に持つタンパク質の構造を、計算科学的に決定したよ。

ダヒヤット氏とメイヨー氏が設計した「FSD-1 (フルシーケンスデザイン-1)」というタンパク質は、既に知られていたどの天然のタンパク質とも似ていない構造をしているので、計算によってイチから設計したde novoなタンパク質の初めての事例としても知られているよ。

ただ、この成果そのものはすごいけれども、ジンクフィンガーという一定の構造を基盤としており、かつ比較的小さなタンパク質しか設計できないという点で、あくまで限定的なものなんだよね。多種多様なタンパク質を設計する意味では、まだまだ手に届かない部分があったよ。

だからこそ、今回の1人目のノーベル化学賞受賞者であるデイヴィッド・ベイカー氏の成果はものすごかったんだよね。2003年にベイカー氏と同僚が設計した「Top7」というタンパク質は、その大きさと構造、なにより計算でイチから設計したという点でとんでもないんだよね。

Top7タンパク質は93個のアミノ酸から成り、2個のαヘリックスと5個のβストランドから成るβシートを持つかなり大きなタンパク質だよ。さっき書いたFSD-1は1個のαヘリックスと2個のβシートを基本にしていることを考えれば、ずっと大きいことはすぐにわかるよね?

しかも、この構造は事前に計算で予測されただけでなく、Top7を合成する遺伝子を組み込んだ細菌が合成したTop7は、事前の予測とよく一致していた点がすごいんだよね。そして、タンパク質の折り畳み方向や全体の構造は、既に知られているどの天然タンパク質とも似ていない、という点もすごいよ。

つまりベイカー氏と同僚は、天然には存在せず、類似品も存在しない人工タンパク質を、計算のみでイチから設計したんだよね!

これはもはやパラダイム・シフト!! 今回はまずこのうちノーベル物理学賞の範囲について既存投稿との内容擦り合わせを行っていきたいと思います。

本文(2136文字)

当初人類の知性(Intelligence)は自分がどう構成されているか知る術もないまま、自らを囲む森羅万象とそれに向けられる想像力を元データとする「教師あり学習」として進化してきました。ネイピア数e(2.718282…)と統計学における「十分小さい分割単位」の概念を対応させる60進法(1時間の$${\frac{1}{60}}$$が1分、1分の$${\frac{1}{60}}$$が1秒)が成立したのもこの時期。

そして占星術から天文学へ。イタリア・ルネサンスを経験した欧州においては魔術・数秘術的段階を脱して「(天体)物理学と数学の二足草鞋の大学者達の時代」が訪れ、19世紀に入ると変分法(Variational Calculus)研究などを契機として「あくまで現実に発生する現象の説明に留まろうとする」近代物理学と「純粋に数理による説明可能性の極限を追求する」近代数学の分離が始まります。

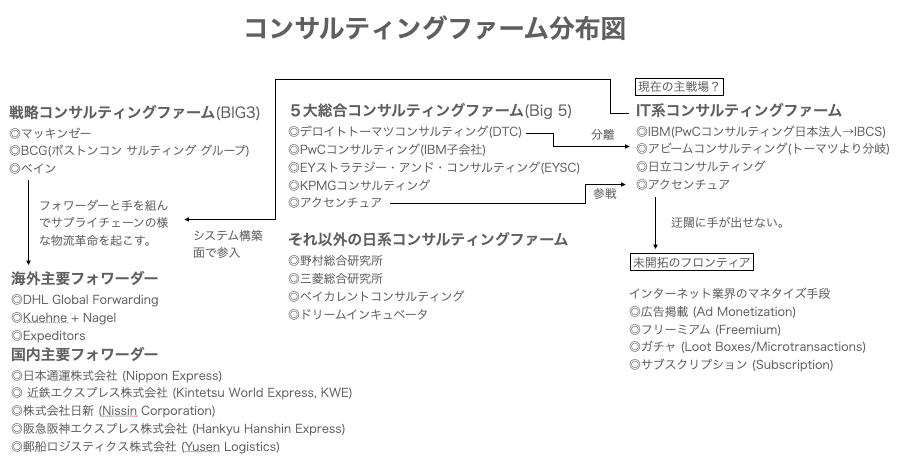

これ以降の時代においては変化が加速。何しろ産業核減りによる新しい機械の導入と生産速度の向上により、アメリカだけで1890年から1958年にかけて労働時間当たりの製造業における生産高が約5倍に急増しています。ナチスによる迫害を逃れて米国に亡命してGM(General Motors Company)のコンサルタントに就任したピーター・ドラッカー(Peter Ferdinand Drucker, 1909年~2005年)が「(大衆の絶望を煽って全権を握ろうとする)ナチズムへの最大の抑止力」と確信した爆発的成長力。ただしその一方で変化の速度についていけず倒産を余儀なくされる企業も続出し、その救済に商機を見出したマッキンゼー(McKinsey & Company, Inc.)のマービン・バウワー(Marvin Bower,1903年~2003年)が戦略的コンサルティング事業の創始者となったり、生理学や生物学における準安定状態概念を情報理論に射映したサイバネティクス(Cybernetics)構想とFA(Factory Automation)やOA(Office Autometion)の進行がERP(Enterprise Resource Planning=企業資源計画)理論によって統合され、今日における「事業・IT系コンサルティング」事業の基礎が固められたりしたのです。

人工知能(Artificial Intelligence)概念はまさに、かかる「20世紀後半の知的混沌状態」の最中に産声を上げたのです。1958年における単層パーセプトロン発表に由来するニューラルネットワークの場合、

当初は「生理学や生物学における準安定状態概念を情報理論に射映する」サイバネティクス構想同様「情報の神経間における電気的伝達のイメージ」から出発。

しかしながら、これより派生して今回ノーベル物理学の対象となった(局所最適解しか求められなかった)ホップフィールド(John Joseph Hopfield,1933年~)のホップフィールド・ネットワーク(Hopfield Network,1982年)や、(確率論的揺らぎの概念を導入する事によってその欠陥を克服しようとした結果、組合せ爆発問題を抱えてしまった)ヒルトン(Geoffrey Everest Hinton, 1947年~)らのボルツマン・マシン(Boltzmann machine, 1985年)はどちらかというと「スピンの安定条件をもとめる物理学モデル」援用によって成立。

さらに(隠れ層概念導入によって組合せ爆発問題を克服するHarmonium=限定ボルツマン・マシン(1986年)を考案した)ポール・スモレンスキー(Paul Smolensky,1955年~)によって分布意味論的解釈を付与されつつ、(やはり同様に隠れ層概念導入によって組合せ爆発問題を克服する)ヒルトンの誤差逆伝播法(Backpropagation)発見(1986年)によって生理学的モデルでも物理学的モデルでもない純粋な数理モデルへと進化。

こうして現在は深層学習(Deep Learning)と呼ばれる様になった人工知能技術はその黎明期を生き延びる事に成功したのです。

とはいえ深層学習アルゴリズムがその本領を発揮するには、21世紀に入ってインターネット・トラフィックが劇的に急増し、それに伴ってコンピューター関連機器と全世界を結ぶネット網も進化を促される「デジタル革命」を待つ必要がありました。

同時期にはIT革命を受けて国際的サプライチェーン展開が加速。その一方で東北大震災(2011年)やコロナ禍(2019年末~2023年)によりその脆弱性も顕現。とはいえIT革命はそれによってますます加速し、戦略的コンサルや業務・IT系コンサルの活躍の場も増え、それに伴う業務負荷の緩衝材としての人工知能の進化に多大な期待が寄せられる様になったのです。

その全てがサイバネティック構想における準安定性概念=回路方程式における定常解(コンピュータOSにおけるメインループのイベント待ち状態)を中心に展開していると想定可能なのが興味深いところ。とりあえずはそんな感じで以下続報…

プロダクション・ノート

「この文章、どうやってまとめたの?」という部分に興味が出てきた方は是非以下をご覧になって下さい。文章量の関係で削除したトピックなども掲載されております。是非お手にとってお確かめ下さい。

ここから先は

この記事が気に入ったらチップで応援してみませんか?