【ローカルLLMはどこまで使える?④】ローカルLLM×業務特化型AIの活用事例と企業が今やるべきこと

株式会社WEEL、メディア部の三谷です。

12月10日(火)に開催されたセミナー「ローカルLLMはどこまで使える?〜2つの実証事例をもとに徹底討論!〜」のレポート④をお届けします。

※前回のレポートをご覧いただいていない方は、ぜひ先にご一読いただくことで、今回の内容がより深く理解いただけると思います。

①セミナーの概要とローカルLLMについて解説

②ローカルLLM×営業!実際の事例をもとに徹底解説

③商談力を強化!実際の成功事例と活用ポイントを徹底解説

今回は、ローカルAIの具体的なユースケースや企業が考えるべきことについて詳しく解説します!

5. 営業以外でのローカルAI活用は?

他にどんなビジネスケースが考えられるか?

営業はあくまで例であって、非構造化データやセキュリティレベルが高い情報を分析するといったケースであったり、ハイブリッド方式でセキュリティ情報はローカルで処理しながら、クラウドで処理するケースは多くのビジネスシーンで汎用性があると思っております。

これからは、手元でやった方がいいことはAI PCが処理してくれて、それ以外の難しいところはクラウドも応用しながらやっていくケースが様々な業種や職種で使えると考えてますね。

人材・金融とか医療とかの業界からスタートしていくのかなと思います。

あとは大手さんだと、ローカルで生成AIを活用するニーズが高いので、うまく繋げていけるとAI PCやワークステーションが活きると考えています。

以前、「RAGの「生成」までしない感じのものって何かありますか?」と聞かれた時に、検索したファイルなどを表示するだけでも結構需要があると思いました。

この場合だとGPUはあまり使わず、CPUだけでも動くものもあるので、そういった使い方をするとローカルは更に活用できると思います。

これから企業はローカルAIについて どう考えて、どう動いていけばいいのか?

ローカルAIは企業における最重要テックの1つだと思ってます。それを裏付けるかの如く、NVIDIAが今年の途中でAI Foundryっていうサービスを出していますよね。

今はほとんど汎用のAI・汎用のOSが使われているので、ChatGPT-4oやGemini、Claudeをどう使うかが基盤になっていると思います。

しかし、これからはタスクごとに最適化された処理が求められるようになり、外部サービスに依存せず、企業自身で管理できるAIが求められるようになるはずです。

今回紹介したローカルAIを基盤として活用しつつ、ファインチューニングによる学習やプロンプトの改善を重ね、企業固有のニーズに応じたAIを構築する動きが高まるはずです。

1つの業務において1つのAIではなく、10個のプロセスに分けて、プロセスの1から8まではそれぞれ別のAIが行い、最後の9と10だけ人間がやるといった業務フローに変わっていくと考えています。

その中の重要な手段の1つがローカルAIです。

企業ごとの独自性を反映したローカルAIが増える背景には、例えばLlamaがすでに3億回以上ダウンロードされ、グローバルで月間数千万回利用されている現状があります。

日本においても同じような流れが加速すると思うので、まずは選択肢として知っておき、スモールトライを繰り返しながら、「こんなことができるのか」と言う可能性を探っていくことが鍵になると思います。

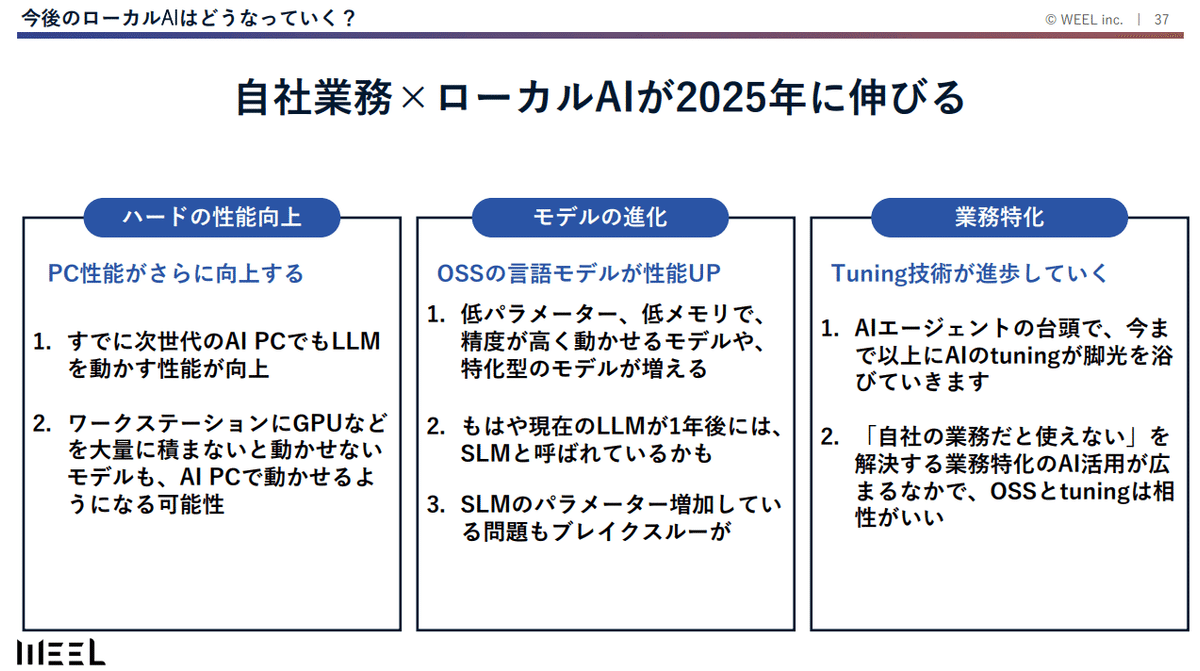

2025年以降は、業務に特化するために、ローカルAIのファインチューニングなどがもっとフォーカスされてくると思います。

クラウドとローカルを組み合わせて、「ここはローカルで業務に特化するためにチューニングされたもので」や、「ここはクラウドで汎用的に」という使い方、つまりはどっちも使っていきましょう。というのが今後重要になってきます。

逆に言えば、今の段階からスモールトライを行い、ローカルAIでデータを整理したり、一部の業務をデータ化していくことで、AI導入のハードルを大幅に下げることができます。

すぐにローカルAIを使わないにしても、後から使えるようにデータを溜めていこう、使える状態に向けて人間がやってる様々な業務の一部分だけはデータ化していこうなど、そういった発想が多少なりとも得られるようになります。

この取り組みを進めている企業とそうでない企業の間には、数年後に埋めがたい差が生まれる可能性があります。

AIが将来的に対応できそうなタスクを見極め、それに必要なデータやプロセスを先回りして整えておくことが企業にとって求められます。

現時点では性能が十分でないと感じるタスクでも、数年後には技術が追いつき、十分に活用できるようになる可能性が高いです。その時に備えて、インプットやアウトプットの正解データをどれだけ準備できているかが、企業の競争力を大きく左右すると思います。

ローカルAIの可能性は今後ますます広がると考えています。

すでに第2世代の第3世代のチップが出ていますし、ワークステーションも良いものが登場しています。

ハードとモデルの進化があるので、ローカルは結構伸びるだろうなと思っています。

一方で、AIモデル自体の進化も著しく、特にチューニング技術の進展が顕著です。

AIエージェントとの親和性が高いチューニング技術は、RAG(Retrieval-Augmented Generation)とともに再び注目されています。これにより、企業が自分たちの業務に特化したAIを効率的に構築し、活用できる環境が整いつつあります。

さらに、ローカル環境で動作するAIモデルが進化することで、セキュリティやプライバシーの課題をクリアしながら、高性能なAIを活用するシナリオが現実的になっています。

【今後の可能性についておさらい】

業務特化型AIの普及:各企業が自社ニーズに合わせたAIを構築・運用可能に。

ハイブリッド運用:ローカルAIとクラウドAIの特性を生かした組み合わせ運用が主流になる。

以上が、生成AI事業部統括の田村が登壇した「ローカルLLMはどこまで使える?〜2つの実証事例をもとに徹底討論!~」のレポートになります。

セミナーの中では、実際にデモでローカルのRAGを使用した記事検索する場面があったのですが、話と映像を一緒に見ないと伝わりづらいと思ったので記載できませんでした。

定期的にセミナーを開催しておりますで、気になった方はセミナーへ参加してみてくださいね!(イベント一覧)

企業でのローカルAIやローカルLLMの活用について、

・活用を検討している

・アドバイザリーを探している

・ローカルAIの使い方や情報セキュリティが課題である

という方がいましたら、ぜひ弊社にお問い合わせください。

弊社は、50件以上の生成AI開発の実績がある【生成AIのシステム開発会社】です。様々な業種での開発などを幅広く行っております。

また、「すぐに話を聞きたい」という方は、以下の日程調整リンクより、お打ち合わせの日程を選択していただけますと幸いです。