G検定チートシート(cheat sheet)(2024年第三回G検定 2024.5.11)

せっかく作ったので公開しておきます。Ctrl+Fで検索で利用してください。

私の勉強方法などの経験は「G検定受けてみた」を参照ください。

2024.11月から試験の新しいシラバス対応版はこっち

人工知能とは

学習目標:人工知能や機械学習の定義を理解する

学習項目:人工知能とは何か、人工知能のおおまかな分類、AI 効果、人工知能とロボットの違い

推論 (Inference)

特徴: 推論は、与えられた事実やデータから新しい結論を導き出す過程です。

目的: 未知の情報を既知の事実から導き出し、意思決定や問題解決に役立てること。

説明: 例えば、天気予報で「今日は雲が多い」という情報があれば、「雨が降る可能性が高い」と推論することができます。AIではこの論理的な推論を自動化し、データから新しい知識や結論を生成します。

認識 (Recognition)

特徴: 認識は、センサーやデータからパターンを識別する能力です。

目的: 環境や入力データから有用な情報を識別し、それに適切に反応すること。

説明: 顔認識システムがカメラで捉えた画像から個々の顔を識別するプロセスです。この技術はセキュリティシステムやスマートフォンのロック解除などに利用されます。

判断 (Judgment)

特徴: 判断は、利用可能な情報を基に最善の選択肢を選び出す過程です。

目的: 効率的かつ効果的な意思決定を行うため。

説明: 自動運転車が道路の状況を分析し、停止するか続行するかを判断するプロセスです。車は周囲の状況を評価し、安全を最優先に判断を下します。

エージェント (Agent)

特徴: エージェントは、自身の知覚をもとに行動を決定し、環境に作用するエンティティです。

目的: 環境内で自動的にタスクを実行し、目標を達成すること。

説明: オンラインカスタマーサービスのチャットボットは、ユーザーからの質問を理解し、適切な回答を提供するエージェントの一例です。

古典的な人工知能 (Classical AI)

特徴: 論理的推論やルールベースのシステムに重点を置いたAIのアプローチです。

目的: 明確なルールやアルゴリズムを通じて問題を解決すること。

説明: ショッピングカートの推薦システムなど、あらかじめ設定されたルールに基づき、関連商品を推薦します。

機械学習 (Machine Learning)

特徴: データからパターンを学習し、その学習を基に予測や分類を行うAIのサブフィールドです。

目的: 手作業によるプログラミングを減らし、データ自体から直接学習すること。

説明: メールシステムが受信したメッセージからスパムを自動で識別するフィルタリング機能です。

ディープラーニング (Deep Learning)

特徴: 多層のニューラルネットワークを用いて複雑なパターンを学習する機械学習の手法。

目的: 音声、画像、テキストなどの複雑なデータから高度な特徴を抽出し、より精度の高い予測や分類を行うこと。

説明: 自動写真タギング機能が、写真の中の物体や人物を識別し、タグ付けするプロセスです。

学習目標:ブームと冬の時代を繰り返してきた人工知能研究の歴史を学ぶ 学習項目:世界初の汎用コンピュータ、ダートマス会議、人工知能研究のブームと冬の時代

エニアック (ENIAC)

特徴: 第二次世界大戦中に開発された、世界初の電子式汎用コンピュータ。

目的: 軍事的な計算ニーズ、特に弾道計算表の作成を自動化するため。

説明: ENIACは真空管を数千個使用し、重量は約30トンありました。その計算能力は当時としては画期的で、手作業で行う場合よりもはるかに速く計算を行うことができました。

ダートマス会議

特徴: 1956年に開催された、人工知能分野の創成期に位置づけられる会議。

目的: 人工知能研究の基盤を形成し、学問としての地位を確立するため。

説明: この会議でジョン・マッカーシーが「人工知能」という用語を初めて使い、その後の研究の方向性や分野の定義が議論されました。

ロジック・セオリスト

特徴: アレン・ニューウェルとハーバート・サイモンによって開発された、最初期のAIプログラムの一つ。

目的: 数学的定理を自動で証明すること。

説明: ロジック・セオリストは、人間の問題解決プロセスを模倣しようとする試みであり、初めてコンピュータが数学的な証明を生成した例とされています。

Logic Theorist:AI黎明期の革新者

Logic Theoristは、1955年から1956年にかけてアレン・ニューウェル、ハーバート・サイモン、J・C・ショーによって開発されたコンピュータプログラムです。人工知能の最初の実用的なプログラムと称され、AI研究に大きな影響を与えました。

Logic Theoristの目的と役割

Logic Theoristの目的は、論理学における定理を自動的に証明することでした。当時、コンピュータは主に数値計算に使用されていましたが、Logic Theoristは論理的な推論を行うことを可能にし、AIの可能性を示しました。

Logic Theoristは以下の役割を果たしました。

論理学における定理の自動証明: 論理的な推論規則に基づいて、定理を自動的に証明することができました。

人工知能の可能性の提示: 当時としては画期的な成果であり、人工知能の可能性を広く知らしめました。

問題解決手法の開発: ヒューリスティック法と呼ばれる問題解決手法の開発に貢献しました。

トイ・プロブレム

特徴: 複雑さを制限した簡単な問題で、AI研究でよく使用されます。

目的: 新しいアルゴリズムや理論を試験するための簡易モデルを提供する。

説明: これらは現実の問題よりも単純化されており、新しいアプローチの有効性を評価するのに役立ちます。例えば、チェスの終盤やパズルゲームなどが含まれます。

エキスパートシステム

特徴: 特定の分野の専門家の知識を模倣して設計されたコンピュータプログラム。

目的: 専門家の判断を代替し、その知識を広く提供する。

説明: エキスパートシステムは、医療診断や工学設計など、特定の専門知識を要する分野で利用されました。

第五世代コンピュータ

特徴: 1980年代に日本で開始された、知的なコンピュータシステムを開発するための国家プロジェクト。

目的: AIとコンピュータ科学の進歩を通じて、次世代のコンピュータ技術をリードする。

説明: プロジェクトでは、並列処理やロジックプログラミングを重視し、AIアプリケーションを強化しようとしましたが、商業的には大きな成果を上げることはできませんでした。

ビッグデータ

特徴: 非常に大規模で複雑なデータセット。通常、従来のデータ処理アプリケーションソフトウェアでは扱いきれない規模です。

目的: 大量のデータからパターン、トレンド、関連性を発見し、ビジネスや科学の意思決定を支援する。

説明: ビッグデータは、インターネット検索、金融市場分析、ヘルスケア、科学研究など、多岐にわたる分野で活用されています。

機械学習

特徴: データからパターンを学習し、その学習を基に予測や分類を行う技術。

目的: 手作業によるプログラミングを減らし、データ自体から直接学習することで、自動化と効率化を図る。

説明: 機械学習は、スパムメールのフィルタリングや顔認識、推薦システムなど、日常生活の多くの側面に影響を与えています。

特徴量 (Feature)

特徴: データの入力として使用される、計算可能な属性または特性。

目的: データを効果的に表現し、機械学習モデルの性能を最大化する。

説明: たとえば画像認識では、エッジ、コーナー、色などが特徴量として使われ、画像の内容を数値化します。

ディープラーニング

特徴: 多層のニューラルネットワークを用いて複雑なパターンを学習する機械学習の一分野。

目的: 音声、画像、テキストなどの複雑なデータから高度な特徴を抽出し、より精度の高い予測や分類を行うこと。

説明: ディープラーニングは、自動運転車の視覚システムや、自然言語処理、医療画像分析などに利用されています。

ディープブルー

特徴: IBMによって開発されたチェスプレイングコンピュータ。1997年に世界チェスチャンピオン、ガリー・カスパロフを破ったことで有名です。

これはディーブラーニングを利用していない。

目的: コンピュータの計算能力とAI技術を組み合わせ、人間の専門家を超えるパフォーマンスを実現する。

説明: ディープブルーの勝利は、AIが特定の専門的なタスクにおいて人間を上回る可能性があることを世界に示しました。

ディープブルーは、以下の技術を用いて開発されました。

ミニマックス法: チェス盤上の全ての局面を探索し、最善の手を選択するアルゴリズム

αβ剪定: ミニマックス法の計算量を削減するための技術

評価関数: チェス盤上の局面を評価するための関数

並列処理: 複数のコンピュータを用いて計算を並列化

人工知能をめぐる動向

学習目標:第1次ブームで中心的な役割を果たした推論・探索の研究について学ぶ

学習項目:探索木、ハノイの塔、ロボットの行動計画、ボードゲーム、モンテカルロ法

推論・探索の時代

特徴: AIが論理的な推論や問題解決能力を中心とした時代。主にルールベースのアプローチや探索アルゴリズムが中心でした。

目的: 汎用的な問題解決能力をコンピュータに実装することで、より広範なタスクに対応可能なAIシステムを開発する。

説明: この時代は、AIがチェスやパズル解決などの特定のタスクで人間の能力を模倣または超越することに重点を置いていました。論理的推論やシンボリックAIの進歩が見られ、問題空間を効率的に探索するアルゴリズムが開発されました。

知識の時代

特徴: AI研究が知識表現と知識ベースの推論に焦点を当てた時代。

目的: 特定のドメインに関する専門知識をAIシステムに組み込むことで、より正確かつ効率的な推論を可能にする。

説明: この時期にはエキスパートシステムが広く研究され、開発されました。これらのシステムは特定の領域の専門家の推論プロセスを模倣しようとし、医療診断、金融分析、工学設計などの分野で応用されました。

機械学習と特徴表現学習の時代

特徴: データ駆動型アプローチが主流となり、特徴表現学習が重要視されるようになった時代。

目的: 生データから直接有用な特徴を学習し、より一般化されたAIモデルを構築する。

説明: 機械学習と特にディープラーニングの技術が急速に発展し、画像、音声、テキストなどの複雑なデータから意味のある情報を自動で抽出する能力が向上しました。これにより、AIはより広範囲なタスクとシナリオでの適用が可能となりました。

探索木 (Search Tree)

特徴: 状態空間を階層的に表現したデータ構造。各ノードが状態を、エッジが状態間の遷移を表す。

目的: 可能なすべての状態や行動の系統的な探索を可能にする。

説明: 探索木は、問題の解決策を見つけるための選択肢を段階的に展開し、各段階での選択肢を木の形で視覚化します。これにより、最適な解決策を効率的に探索するための道筋を提供します。

幅優先探索 (Breadth-First Search, BFS)

特徴: 探索木の各レベルを横断的に探索する方法。

目的: 最短経路問題など、最小のステップで目的地に達する解を見つける場合に適用。

説明: 幅優先探索は、探索木のルートから始まり、隣接するすべてのノードを探索し、その後でそれらのノードの隣接ノードへと進みます。これにより、最短経路が保証されます。

深さ優先探索 (Depth-First Search, DFS)

特徴: 探索木をできる限り深く掘り下げる探索手法。

目的: 解が深いレベルに存在する場合に効率的に探索するため。

説明: 深さ優先探索は、一つの枝を可能な限り深く探索し、解を見つけられない場合にバックトラックして別の枝を探します。これはメモリ効率が良いが、最短経路を保証しない。

プランニング (Planning)

特徴: 事前に目標達成のための行動序列を計画するプロセス。

目的: 効率的かつ効果的な行動計画を立てることで、目標を達成する。

説明: プランニングは、与えられた初期状態から目標状態への最適または満足できる経路を生成することに焦点を当てています。これはロボティクスや自動化システム設計で広く用いられます。

STRIPS (Stanford Research Institute Problem Solver)

特徴: アクションの効果を記述する形式言語を使用した初期のプランニングシステム。

目的: 自動プランニングと問題解決能力を機械に提供する。

説明: STRIPSは、特定のアクションが状態にどのように影響を及ぼすかを定義し、これを基にプランを作成します。主に人工知能研究で使用され、その後の多くのプランニングシステムの基盤となりました。

SHRDLU

特徴: テリー・ウィノグラードによって開発された自然言語理解システム。

目的: 自然言語の命令を理解し、仮想世界内で行動を実行する。

説明: SHRDLUは、ユーザーからの単純な英語の命令を解釈し、仮想のブロック世界でブロックを移動するなどのタスクを実行しました。これにより、言語理解と行動計画が組み合わさった初の例となります。

アルファ碁 (AlphaGo)

特徴: DeepMindによって開発された、囲碁のプロプレイヤーに勝利したAIプログラム。

目的: 深層学習とモンテカルロ木探索を組み合わせることで、囲碁という高度に戦略的なゲームで人間を超える。

説明: アルファ碁は、自己対戦による学習と強化学習を用いて囲碁の知識を獲得し、2016年に世界チャンピオンの李セドルを破りました。この成功は、AIが直感とされる領域でも人間を超えうることを示しました。

詳細説明

AlphaGo

AlphaGoは、2016年に世界チャンピオンのイ・セドルに対して勝利し、その名を世界に知らしめました。このモデルは、大量の人間の対局データに基づいて教師あり学習を行い、その後自己対戦による強化学習を通じてさらにスキルを向上させました。モンテカルロ木探索を利用し、実際のゲーム中に最適な手を選択するための複雑な探索アルゴリズムが組み込まれています。

AlphaGo Zero

AlphaGo Zeroは、人間の対局データを一切使用せず、「タブララサ(白紙の状態)」からスタートし、完全に自己対戦のみで学習を進めることで、AlphaGoを超える性能を発揮しました。このアプローチにより、バイアスのない、より創造的で強力なプレイスタイルが生まれ、囲碁の理解に新たな洞察をもたらしました。

AlphaZero

AlphaZeroは、AlphaGo Zeroのアプローチをさらに一般化し、囲碁だけでなくチェスや将棋など他のボードゲームにも適用する能力を持っています。これにより、特定のゲームに依存することなく、一般的なアルゴリズムとして様々なゲームにおいて最高レベルのプレイを実現することが可能になりました。各ゲームでトップクラスの既存のプログラムと比較しても優れた結果を示しました。

ヒューリスティックな知識

特徴: 特定の問題を解決するための経験則や指針。

目的: 探索空間を効率的に絞り込み、計算リソースを節約しながら解を迅速に見つける。

説明: ヒューリスティックな知識は、問題に対する直感的なアプローチや短絡的なルールを利用して、より効果的な探索を実現します。例えば、チェスのプレイで特定の局面で有利な手を優先的に探索します。

Mini-Max 法

特徴: ゼロサムゲームにおいて、最小の損失を最大にする戦略を選択する探索アルゴリズム。

目的: 対戦相手の可能な手を考慮に入れ、最悪のシナリオに対して最適な手を選択する。

説明: ミニマックス法は、特にボードゲームのAIにおいて、自分の手番で最大の利益を、相手の手番では最小の損失を目指す手を選びます。

αβ 法 (Alpha-Beta Pruning)

特徴: ミニマックス法の効率を向上させるために不必要な枝を剪定(プルーニング)する技術。

目的: 探索時間の短縮と効率の向上を図る。

説明: αβ法は、勝敗が確定しているゲームの局面や、他の手より明らかに劣る手は探索から排除します。これにより、処理すべきノードの数が大幅に削減され、より迅速な意思決定が可能になります。

ブルートフォース (Brute Force)

特徴: すべての可能なケースを系統的に試す探索手法。

目的: 確実に最適解を見つけ出すため。

説明: ブルートフォース法は、すべての可能性を一つずつ試すため、計算量が多くなりがちですが、問題のサイズが小さい場合や、他のアルゴリズムが適用困難な場合に有効です。

学習目標:第2次ブームで中心的な役割を果たした知識表現の研究とエキスパートシステムを学ぶ

学習項目:人工無脳、知識ベースの構築とエキスパートシステム、知識獲得のボトルネック(エキスパートシステムの限界)、意味ネットワーク、オントロジー、概念間の関係 (is-a と part-of の関係)、オントロジーの構築、ワトソン、東ロボくん。

イライザ (ELIZA)

特徴: 1960年代に開発された最初のチャットボットの一つで、自然言語処理の技術を使用してユーザーとの会話を模倣します。

目的: コンピュータとの対話が人間の会話と似ているという錯覚(イライザ効果)を利用して、人工知能の対話能力を探究する。

説明: ELIZAは特に「ロジャーシアン心理療法者」としてプログラムされ、ユーザーの質問によっては繰り返しや質問形式で返答し、まるで理解しているかのように振る舞います。

イライザ効果

特徴: 人々が比較的単純なソフトウェアとの対話において、それが実際よりもはるかに高度な理解を持っているかのように感じる心理現象。

目的: この効果を理解することで、人間と機械のインタラクションの設計を改善する。

説明: ELIZAの対話は実際には非常に機械的でありながら、ユーザーが深い感情的な接続を感じることがあります。

マイシン (MYCIN)

特徴: 1970年代に開発された医療診断支援を目的としたエキスパートシステム。

目的: 感染症の診断と抗生物質の選択を支援する。

説明: MYCINは医学的知識ベースを利用して個々の症例に最適な抗生物質療法を推薦し、その推薦の根拠を示すことができます。

DENDRAL

特徴: 化学物質の構造を特定するために開発された最初のエキスパートシステムの一つ。

目的: 科学者が実験データから化合物の構造を導き出す過程を自動化する。

説明: DENDRALは質量分析データを用いて、可能な化学構造の候補を生成し評価します。

インタビューシステム

特徴: ユーザーからの情報を収集し、質問に基づいてさらに情報を導出するシステム。

目的: ユーザーからの情報収集を効率化し、特定の問題に対するソリューションを提供する。

説明: インタビューシステムは、特定の問題に対するユーザーのニーズを明らかにし、適切な情報やサービスを提供します。

オントロジーとは

オントロジーは、特定の領域における概念やエンティティ、それらの間の関係性を形式的に表現するためのフレームワークやモデルです。主に知識表現、情報科学、人工知能などの分野で利用され、複雑なデータ構造を理解しやすく整理するための手段として活用されます。オントロジーを用いることで、データ間の意味的なつながりを明確にし、機械が人間のように情報を理解し処理するのを助けます。

オントロジーの主な特徴

概念の階層構造:

オントロジーは、領域内の概念やエンティティを階層的に整理します。上位概念と下位概念の関係(一般的に「is-a」関係と呼ばれる)を通じて、より具体的な事物から抽象的な事物までカテゴリー分けされます。

関係の定義:

エンティティ間のさまざまな関係を定義することが可能です。これには、所有関係、位置関係、因果関係などが含まれます。

共有可能:

オントロジーは、共通の理解や標準化された知識構造を提供するため、異なるシステムや組織間でのデータ共有と連携を容易にします。

再利用性:

一度作成されたオントロジーは、他のプロジェクトやアプリケーションで再利用することができます。これにより、新たなシステム開発の際の労力と時間を節約することが可能です。

オントロジーとは?

オントロジーは、特定のドメインに関する概念とその間の関係を体系的に記述したものです。具体的には、以下の要素で構成されます。

概念: ドメインにおける基本的な事柄を表します。例えば、「犬」、「猫」、「人間」などの概念が挙げられます。

関係: 概念間の関係を表します。例えば、「犬は哺乳類である」、「猫はペットである」などの関係が挙げられます。

属性: 概念の性質を表します。例えば、「犬は毛皮を持つ」、「猫は夜行性である」などの属性が挙げられます。

オントロジーは、論理学、哲学、計算機科学などの分野で研究されています。

オントロジー研究の目的

オントロジー研究の目的は、以下のとおりです。

知識の共有: オントロジーを使用することで、異なるシステム間で知識を共有することができます。これにより、システム間の連携や協調が可能になります。

推論: オントロジーを使用することで、システムは新しい知識を推論することができます。これにより、システムの知能化が可能になります。

学習: オントロジーを使用することで、システムは新しいデータから学習することができます。これにより、システムの精度向上が可能になります。

オントロジー研究の現状

オントロジー研究は、様々な分野で活発に研究されています。特に、以下の分野で多くの研究が行われています。

人工知能: オントロジーは、AIシステムの知識表現と推論に不可欠な要素です。AIシステムの開発にオントロジーが活用されています。

セマンティックWeb: セマンティックWebは、Web上の情報を意味的に理解できるようにする技術です。オントロジーは、セマンティックWebの基盤となる技術です。

情報検索: オントロジーを使用することで、より高度な情報検索システムを実現することができます。

自然言語処理: オントロジーを使用することで、自然言語処理システムの精度を向上させることができます。

オントロジー研究の展望

オントロジー研究は、今後もますます発展していくことが期待されています。特に、以下の分野での発展が期待されています。

大規模オントロジーの構築: より大規模で複雑なオントロジーを構築することで、より高度な知識表現と推論が可能になります。

マルチドメインオントロジーの構築: 異なるドメインのオントロジーを統合することで、より幅広い知識を扱うことができるようになります。

学習型オントロジーの開発: 新しいデータから自動的に学習できるオントロジーを開発することで、より柔軟で適応性の高い知識表現が可能になります。

オントロジー研究は、AI技術の発展に大きく貢献することが期待されています。今後、オントロジー技術がどのように活用されていくのか、注目されます。

is-a の関係

特徴: オントロジー内で、一つのエンティティ(子)が別のエンテ

ィティ(親)の特殊なインスタンスであるという関係。

目的: 知識の階層構造を構築し、知識の再利用と理解を促進する。

説明: 「カラス is-a 鳥」はカラスが鳥の一種であることを示し、カラスは鳥のすべての特性を継承します。

has-a の関係

特徴: あるオブジェクトが別のオブジェクトを部品や属性として含む関係。

目的: オブジェクト間の組織的関連を表現し、複雑なデータ構造を効率的に管理する。

説明: 「車 has-a エンジン」は車がエンジンを部品として持っていることを表し、車の機能にエンジンが必要であることを示します。

part-of の関係

特徴: オブジェクトが他のオブジェクトの一部であるという関係。

目的: オブジェクト間の物理的または概念的な包含関係を明確にする。

説明: 「指 part-of 手」は、指が手の一部であることを示します。これにより、手の構造や機能に関する知識が整理されます。

Cycプロジェクト

特徴: 広範な一般常識知識を持つエキスパートシステムを構築するためのプロジェクト。

目的: AIが人間のような推論能力を持つために必要な広範な背景知識の提供。

説明: Cycは数百万の事実や規則を含む知識ベースであり、AIが常識的な判断を下すのに役立ちます。

推移律

特徴: 論理的な推論規則で、ある関係が連鎖する場合に適用される。

目的: 推論プロセスにおける正確性と一貫性の確保。

説明: もし「A is-a B」かつ「B is-a C」ならば、「A is-a C」が成立します。これにより、知識の正確な伝播が可能になります。

ウェブマイニング

特徴: ウェブデータから有用な情報を抽出するプロセス。

目的: ウェブ上の膨大なデータからパターンや関連性を発見し、ビジネスインテリジェンスを向上させる。

説明: ウェブマイニングは、ユーザーの行動パターン、リンクの構造、ページの内容などから洞察を得るために用いられます。

データマイニング

特徴: 大量のデータセットからパターンや規則性を発見する技術。

目的: ビッグデータから価値ある情報を抽出し、意思決定を支援する。

説明: データマイニングは、顧客データ、販売履歴、天気データなどから有用な洞察や予測モデルを生成します。

ワトソン

特徴: IBMが開発した質問応答システム。ジェパディ!クイズショーで人間のチャンピオンに勝利しました。

目的: 自然言語処理と機械学習を用いて、複雑な質問に対する正確な回答を生成する。

説明: Watsonは構造化されていないデータから情報を抽出し、特定の問いに対する回答をリアルタイムで提供します。

セマンティック Web

特徴: ウェブデータに意味情報(メタデータ)を追加し、ウェブの読解と利用を自動化するためのフレームワーク。

目的: ウェブ上の情報を機械が解釈可能にし、より効率的な検索、データ連携、知識の再利用を実現する。

説明: セマンティック Webは、リソースに対してRDFやOWLを用いて意味的なタグ付けを行い、情報の検索と統合を改善します。

学習目標:機械学習、ニューラルネットワーク、ディープラーニングの研究と歴史、それぞれの関係について学ぶ

学習項目:データの増加と機械学習、機械学習と統計的自然言語処理、ニューラルネットワーク、ディープラーニング

ビッグデータ

特徴: 非常に大規模で複雑なデータセット。通常、従来のデータベース管理ツールでは処理が困難。

目的: 大量のデータから洞察を得ることで、ビジネスインテリジェンスや科学研究を推進する。

説明: ビッグデータは、ソーシャルメディア、トランザクションレコード、センサーデータなどから集められ、パターン、トレンド、相関関係を分析するのに使用されます。このデータの解析により、より良い意思決定が可能になります。

レコメンデーションエンジン

特徴: ユーザーの過去の行動や好みに基づいて、商品やサービスを推薦するシステム。

目的: 個々のユーザーに合わせたパーソナライズされた体験を提供することで、顧客満足度の向上と販売促進を図る。

説明: レコメンデーションエンジンは、NetflixやAmazonのようなプラットフォームで利用され、ユーザーの視聴履歴や購入履歴から次に楽しむであろう商品や映画を推薦します。

スパムフィルター

特徴: 不要または不適切なメールを自動的に識別し、ユーザーのメールボックスから除外するシステム。

目的: ユーザーのメール体験を向上させ、セキュリティリスクを減らす。

説明: スパムフィルターは、特定のキーワードや送信者の信頼性、過去のユーザーの行動に基づき、スパムメールをフィルタリングします。

統計的自然言語処理

特徴: 言語データから統計的手法を用いて意味を抽出する分野。

目的: テキストや音声データから情報を効率的に理解し、抽出する。

説明: 統計的自然言語処理は、コーパスから学習したモデルを用いて、テキストの意味を解析する。これには、機械翻訳や感情分析などが含まれます。

コーパス

特徴: 特定の言語の使用例を集めたテキスト集。

目的: 言語研究や自然言語処理システムのトレーニングに使用する。

説明: コーパスは、様々な言語の構造や用法を解析するために使われ、言語モデルの構築やテキスト分析の基礎データとして重要です。

コーパスは、大量の言語データの集まりです。このデータは、書籍、論文、ニュース記事、ソーシャルメディア投稿など、様々な形式で存在します。コーパスは、言語学、自然言語処理、人工知能などの分野で広く利用されています。

コーパスの種類

書かれた言語コーパス: 書籍、論文、ニュース記事など、文字で書かれた言語のデータを集めたものです。

音声コーパス: 音声データを集めたものです。会話、講演、インタビューなど、様々な形式の音声データが含まれます。

マルチモーダルコーパス: 音声と映像、または音声とテキストなど、複数の形式のデータを組み合わせたものです。

人間の神経回路

特徴: 人間の脳内で情報を処理するための細胞(ニューロン)のネットワーク。

目的: 人間の学習と思考のプロセスを模倣することで、より自然なAIシステムを開発する。

説明: ニューラルネットワークは、この人間の神経回路に触発されており、多数の接続されたユニット(ニューロンに相当)を用いてデータを処理します。

単純パーセプトロン

特徴: 最も基本的な形のニューラルネットワークで、入力層と出力層のみから構成される。

目的: 単純な分類問題を解くためのモデルを提供する。

説明: パーセプトロンは、入力に重みを掛け、合計がある閾値を超えた場合に1を出力するシンプルなアルゴリズムです。

誤差逆伝播法

特徴: ニューラルネットワークを訓練するためのアルゴリズムで、出力層から入力層へと誤差を逆伝播させて重みを更新します。

目的: ニューラルネットワークの性能を最適化し、正確な予測を可能にする。

説明: 誤差逆伝播法は、ネットワークが予測した結果と実際の結果との差(誤差)を用いて、各層の重みを効率的に調整します。誤差逆伝搬法(Backpropagation)は、ニューラルネットワークを訓練する際に用いられる中心的なアルゴリズムで、ネットワーク内の各重みについて、どのように調整すれば出力層の誤差を最小限に抑えられるかを効率的に計算します。このアルゴリズムは、多層ニューラルネットワークにおいて特に有効で、ディープラーニングの成功には欠かせない技術です。

誤差逆伝搬法のプロセス

フォワードパス

入力データはネットワークの入力層から順に各隠れ層を経由し、最終的に出力層へと伝播されます。

各層でのノード(ニューロン)の出力は、その層の重み、バイアス、活性化関数によって決定されます。

誤差の計算

出力層での予測値と実際の目標値との間に発生する誤差(損失)を計算します。

損失関数(例えば、平均二乗誤差や交差エントロピー損失など)がこの誤差を数値化します。

逆伝搬

誤差を出力層から入力層に向かって逆方向に伝搬させ、各層の重みに対する誤差の影響(勾配)を計算します。

この逆伝搬により、各重みが最終的な誤差にどの程度貢献しているかが明らかになります。

重みの更新

勾配降下法(またはその他の最適化手法)を使用して、計算された勾配に基づいて各重みを更新します。

更新量は学習率と勾配の積で決定され、目的は全体の損失を減少させることです。

誤差逆伝搬法の重要性

効率的な学習: 誤差逆伝搬法は、ネットワーク内の多数のパラメータに対する誤差の効果を効率的に計算し、適切な調整を可能にします。

ディープラーニングの基盤: この手法はディープラーニングモデルの訓練に不可欠であり、画像認識、自然言語処理、強化学習など幅広い応用があります。

進化し続けるアルゴリズム: 誤差逆伝搬法をさらに発展させた最適化手法(例えば、AdamやRMSpropなど)が登場し、より高速かつ効率的な学習が可能になっています。

オートエンコーダ

特徴: 入力を受け取り、それを圧縮してから再構築することを目的としたニューラルネットワーク。

目的: 効果的なデータ圧縮と次元削減を行い、データの重要な特徴を抽出する。

説明: オートエンコーダは、入力データを内部表現にエンコードし、その後で可能な限り元のデータを再構築します。これは、画像や音声データのノイズ除去や異常検出に有用です。

オートエンコーダ (Autoencoder)

特徴: 入力データを再構築することを目的としたニューラルネットワークで、データの圧縮と復元を行う。

目的: データの低次元表現を学習し、データの本質的な特徴を抽出するため。

説明: オートエンコーダはエンコーダ部分でデータを圧縮し、デコーダ部分で元のデータに戻すプロセスを通じて、データの重要な特徴を捉えます。これは次元削減やノイズ除去にも使用されます。

積層オートエンコーダ (Stacked Autoencoder)

特徴: 複数のオートエンコーダを連続して配置し、階層的にデータの抽象的な特徴を学習するニューラルネットワーク。

目的: より複雑なデータ構造を効果的に学習し、ディープラーニングモデルの表現力を高めるため。

説明: 各オートエンコーダの出力が次のオートエンコーダの入力になる構造をしており、階層的に深い特徴を抽出することができます。

積層オートエンコーダとは?

積層オートエンコーダは、オートエンコーダを複数層に重ねたニューラルネットワークアーキテクチャです。

各層のオートエンコーダは、入力データを圧縮し、再構成するタスクを実行します。この過程を通して、モデルはデータの重要な特徴を学習していきます。

積層オートエンコーダの仕組み

積層オートエンコーダは以下の3つの主要な部分から構成されています。エンコーダ: 入力データを圧縮し、潜在表現と呼ばれる低次元の特徴ベクトルに変換します。

潜在層: 潜在表現を保持します。

デコーダ: 潜在表現を入力として、元の入力データを再構成します。

各層のオートエンコーダは、誤差逆伝播法を使用して学習されます。

積層オートエンコーダの利点

積層オートエンコーダには、以下のような利点があります。特徴抽出: 積層オートエンコーダは、データの重要な特徴を自動的に抽出することができます。

次元削減: 積層オートエンコーダは、データを低次元の特徴ベクトルに変換することができます。

ノイズ除去: 積層オートエンコーダは、データからノイズを除去することができます。

前処理: 積層オートエンコーダは、他の深層学習モデルの前処理として使用することができます。

変分オートエンコーダ (Variational Autoencoder, VAE)

特徴: エンコーダとデコーダの2部構造を持ち、入力データから潜在空間へのマッピングとその逆のプロセスを学習する。

目的: 連続的で意味のある潜在空間を構築し、新しいデータを生成する。

説明: VAEはデータの確率分布を学習することで、その分布に従った新しいデータを生成する能力を持ちます。エンコーダはデータから潜在変数へのマッピングを行い、デコーダは潜在変数からデータへの再構築を行います。

VAE: エンコーダーとデコーダーの役割と詳細な説明

VAE(変分オートエンコーダー)は、画像生成や異常検知などに活用される深層生成モデルです。VAEは、エンコーダーとデコーダーという2つのニューラルネットワークで構成されています。

1. エンコーダー

エンコーダーは、入力データ(画像、音声など)を潜在変数と呼ばれる低次元のベクトルに変換する役割を担います。

具体的な動き

入力データを受け取り、畳み込み層や活性化関数などを用いて処理します。

処理を重ねることで、入力データの特徴を抽出し、潜在変数と呼ばれる低次元のベクトルに変換します。

潜在変数は、平均と分散を持つ多変量ガウス分布に従います。

役割

入力データの本質的な特徴を圧縮して表現します。

潜在変数は、入力データを再構成するだけでなく、新たなデータを生成するためにも使用されます。

例

画像の場合:画像の特徴を、色、形状、テクスチャなどの要素に圧縮して表現します。

音声の場合:音声の特徴を、音色、ピッチ、時間情報などの要素に圧縮して表現します。

2. デコーダー

デコーダーは、潜在変数を受け取り、入力データと似たようなデータを復元する役割を担います。

具体的な動き

潜在変数を受け取り、活性化関数などを用いて処理します。

処理を重ねることで、潜在変数から元のデータを再構築します。

出力層では、入力データと同じ形式のデータを出力します。

役割

潜在変数から入力データを忠実に復元します。

復元されたデータは、ノイズが除去されたり、圧縮による劣化が補正されたりします。

例

画像の場合:潜在変数から、色、形状、テクスチャなどの要素を組み合わせて、元の画像を復元します。

音声の場合:潜在変数から、音色、ピッチ、時間情報などを組み合わせて、元の音声を復元します。

3. エンコーダーとデコーダーの関係

エンコーダーとデコーダーは、互いに情報をやり取りしながら学習します。

エンコーダーは、デコーダーが復元しやすい潜在変数を生成することを学習します。

デコーダーは、エンコーダーが生成した潜在変数から、入力データとできるだけ近いデータを再構築することを学習します。

この相互作用を通して、VAEは入力データの本質的な特徴を捉え、新たなデータを生成できるようになります。

4. まとめ

VAEは、エンコーダーとデコーダーの連携によって、データの圧縮と復元だけでなく、新たなデータの生成という強力な機能を実現します。

エンコーダーは、入力データの本質的な特徴を潜在変数に圧縮します。

デコーダーは、潜在変数から入力データと似たようなデータを復元します。

エンコーダーとデコーダーは、互いに情報をやり取りしながら学習し、生成結果の精度を向上させます。

ILSVRC (ImageNet Large Scale Visual Recognition Challenge)

特徴: 大規模な画像データセットを用いた視覚認識コンペティション。

目的: コンピュータビジョンのアルゴリズムの進歩を推進し、画像認識技術の限界を押し広げる。

説明: ILSVRCは、毎年異なるチームが画像認識に関する最新のアプローチを競い合います。特にディープラーニングの進歩がこのコンペティションを通じて大きく進展しました。

ILSVRC(ImageNet Large Scale Visual Recognition Challenge)で注目された代表的なモデルと、それらを開発した大学や企業について、詳細を年代順に以下にまとめます:

AlexNet (2012)

開発元: トロント大学

特徴: AlexNetは、畳み込みニューラルネットワーク(CNN)を用いてILSVRC-2012で優勝し、ディープラーニングのブレイクスルーとされます。ReLU、ドロップアウト、GPUを利用したトレーニングなど、多くの新しい技術を導入しました。

ZFNet (2013)

開発元: ニューヨーク大学

特徴: ZFNetは、AlexNetのアーキテクチャを改良してILSVRC-2013で優勝しました。主に畳み込み層のフィルターサイズとストライドの調整を行い、より詳細なビジュアライゼーションと解析を実現しました。

GoogLeNet (Inception v1) (2014)

開発元: Google

特徴: GoogLeNetは、Inceptionモジュールを用いた革新的なデザインでILSVRC-2014で優勝しました。深さと幅のあるネットワーク設計を採用し、計算効率と精度のバランスを大きく改善しました。

VGGNet (2014)

開発元: オックスフォード大学

特徴: VGGNetは、そのシンプルなアーキテクチャで知られ、ILSVRC-2014で2位に輝きました。最大19層の非常に深いネットワークを使用し、畳み込み層とReLU層を効果的に重ねることで高い認識性能を実現しました。

ResNet (2015)

開発元: マイクロソフト研究所

特徴: ResNetは、152層という当時としては画期的な深さのネットワーク構造を持ち、ILSVRC-2015で優勝しました。残差学習という新しいコンセプトを導入し、深いネットワークでの勾配消失問題を解決しました。

特徴量

特徴: データから抽出された、そのデータの特性や内容を表す数値またはカテゴリー。

目的: データをより扱いやすい形式に変換し、機械学習モデルの学習効率と予測精度を向上させる。

説明: 特徴量は、生のデータを機械学習アルゴリズムが処理しやすい形に変換します。例えば、画像データから色、形、テクスチャなどの属性を抽出します。

次元の呪い

特徴: 高次元データを扱う際に生じる、データポイントが疎になり、各種計算が困難になる現象。

目的: 次元の呪いを理解し、効果的なデータ処理と機械学習モデルの設計を行う。

説明: 高次元空間では、データポイント間の距離が非常に大きくなり、統計的手法が正常に機能しなくなることがあります。これを避けるために次元削減技術が用いられます。

機械学習の定義

特徴: データからパターンを学習し、その学習を通じて新しいデータに対する予測や決定を行う技術。

目的: 人間の介入を最小限に抑え、データから直接知識を抽出することで、自動化と効率化を図る。

説明: 機械学習は、データを分析し、その中の規則性や関連性を見つけ出してモデルを構築し、未見のデータに対して予測や分類を行います。

パターン認識

特徴: データから有意なパターンや構造を識別するプロセス。

目的: 複雑なデータセットから情報を抽出し、意味のある洞察を得る。

説明: パターン認識は、画像、音声、テキストデータなど、さまざまな形式のデータに適用され、特定のパターンや規則性を自動的に認識します。

画像認識

特徴: コンピュータが画像データからオブジェクトやパターンを識別する技術。

目的: 自動化された環境で画像コンテンツを解析し、関連するタスクを実行する。

説明: 画像認識技術は、セキュリティシステムの顔認識から医療画像の分析まで、幅広い応用が可能です。

特徴抽出

特徴: データから最も情報的な属性または特徴を選択または変換するプロセス。

目的: データをより効果的に解析し、処理するために必要な情報を抽出する。

説明: 特徴抽出は、データの次元を減らし、学習アルゴリズムがより効率的に機能するようにします。例えば、画像からエッジやテクスチャを抽出することがこれに該当します。

一般物体認識

特徴: 任意のカテゴリの物体を認識する能力。

目的: 多種多様なオブジェクトを正確に識別し、分類する。

説明: 一般物体認識は、異なる環境や状況下での物体を識別するために重要で、自動運転車やロボット工学で特に重要です。

OCR (Optical Character Recognition)

特徴: 印刷または手書きのテキストをデジタルテキストに変換する技術。

目的: 紙のドキュメントをデジタル形式に変換し、テキストの編集や検索を可能にする。

説明: OCR技術は、スキャンされた書類や写真の中の文字を読み取り、それを編集可能なテキストファイルに変換します。これにより、データ入力の作業が大幅に効率化されます。

学習目標:人工知能の研究で議論されている問題や、人工知能の実現可能性を考察する

学習項目:トイ・プロブレム、フレーム問題、チューリングテスト、強い AI と弱いAI、シンボルグラウンディング問題、身体性、知識獲得のボトルネック、特徴量設計、シンギュラリティ

人工知能分野の問題

学習目標:人工知能の研究で議論されている問題や、人工知能の実現可能性を考察する

学習項目:トイ・プロブレム、フレーム問題、チューリングテスト、強い AI と弱いAI、シンボルグラウンディング問題、身体性、知識獲得のボトルネック、特徴量設計、シンギュラリティ

トイ・プロブレム

特徴: 複雑な問題を単純化したモデル。

目的: 実世界の複雑な問題を理解しやすくするために、単純で解決しやすい問題に変換します。

説明: トイ・プロブレムは、主に研究や学習の文脈で使用され、アルゴリズムや理論をテストしやすくするために設計された単純な問題です。これにより、基本的な原理やアプローチを明確に理解することができます。

フレーム問題

特徴: AIが特定のアクションによる変化のみを識別し、無関係な情報を無視する問題。

目的: AIが環境内でのみ関連する変数を効果的に扱えるようにすること。

説明: フレーム問題は、AIがどの情報がアクションにとって本当に重要かを判断する際の困難さを指します。これは特に、複雑な環境下での意思決定においてAIが直面する課題です。

チューリングテスト

特徴: 人間の判断者が機械と人間との会話を区別できない場合、その機械は知的であると評価される。

目的: AIの知性を評価するための実用的なテストを提供すること。

説明: チューリングテストは、AIが人間と区別がつかないほど自然な会話を行えるかどうかを評価するために、アラン・チューリングによって提案されました。これは、機械が「思考」する能力を持つかどうかを判定する方法として知られています。

強い AI と弱い AI

特徴: 強い AI は人間のような知性を持ち、自我や意識を有する可能性があります。弱い AI は特定のタスクに特化しています。

目的: 強い AI は全般的な問題解決能力を目指し、弱い AI は特定のタスクでの効率化を目指します。

説明: 強い AI は理論上、あらゆる知的活動を人間と同等またはそれ以上にこなすことができるとされています。一方、弱い AI は音声認識や画像認識など、限定されたタスクに優れています。

シンボルグラウンディング問題

特徴: 抽象的なシンボルが具体的な実体や状況とどのように関連づけられるかの問題。

目的: AIがシンボルの背後にある実世界の意味を理解し、適切に行動できるようにすること。

説明: シンボルグラウンディング問題は、AIがただシンボルを処理するだけでなく、それ

らが指し示す実世界の要素を理解する必要があるという課題です。

身体性

特徴: AIやロボットが物理的な体を持つことによる影響。

目的: AIが実世界の物理環境と相互作用し、より効果的に行動すること。

説明: 身体性は、AIが実世界の環境において自身の身体を使ってタスクをこなすことがどのように影響するかを研究する概念です。これは、AIが環境から直接学習し、その身体を通じて世界を「感じる」ことができるという考え方に基づいています。

知識獲得のボトルネック

特徴: AIが新しい知識を獲得する過程で直面する困難。

目的: AIの学習効率を向上させ、より迅速かつ広範囲にわたる知識の獲得を可能にすること。

説明: 知識獲得のボトルネックは、AIが新しい情報を効率的に学習し、既存の知識ベースに統合する際に遭遇する障害を指します。これを克服することが、AIの発展にとって重要です。

特徴量設計

特徴: データから有効な特徴量(特徴ベクトル)を抽出または設計するプロセス。

目的: 機械学習モデルのパフォーマンスを最適化するため。

説明: 特徴量設計は、機械学習においてモデルがデータから学習するための「入力」をどのように準備するかに関わる重要なステップです。適切な特徴量を設計することで、モデルの学習効率と予測精度が向上します。

シンギュラリティ

特徴: 技術的特異点とも呼ばれ、人工知能が人間の知能を超えると予想される未来の時点。

レイ・カーツワイルはシンギュラリティは2045年と主張

2029年は人工知能が人間より賢くなる年目的: この概念は、AI技術の将来的な影響と、それが人類にもたらす可能性のある変革を議論するために用いられます。

説明: シンギュラリティは、AIが自己改善能力を持つようになり、その知能が加速度的に成長する点を指します。この時点を境に、AIは人間の知能を超え、予測不能な変化が起こるとされています。

ローブナーコンテスト

特徴: コンピュータと人間がテキストベースの会話を行うコンペティション。チューリングテストを模倣した形式で実施されます。

目的: プログラムが人間のように会話できるかどうかを評価し、自然言語処理の進歩を推し進める。

説明: ローブナーコンテストでは、ジャッジがコンピュータプログラムと人間との会話を行い、どちらがコンピュータかを識別する試みがなされます。この競技はAIが人間らしい会話能力を持つかどうかを探るための一つの試金石とされています。

中国語の部屋

特徴: ジョン・サールによって提唱された思考実験で、部屋の中の人間が中国語の質問に対して中国語で答えるシステムを示します。

目的: シンボル処理システムが実際に「理解」をしているかどうかについての哲学的問いを投げかける。

説明: 中国語の部屋の実験は、外部から見れば中国語を理解しているように見えるが、実際には単に符号化された指示に従っているだけであるため、真の「理解」は存在しないという問題を提起します。

機械翻訳

特徴: テキストまたは音声を一つの言語から別の言語に自動で翻訳する技術。

目的: 言語の障壁を越えて情報を共有し、国際的なコミュニケーションを容易にする。

説明: 機械翻訳は、グローバル化が進む世界において重要な技術であり、ウェブページや文書、会話などの翻訳に広く用いられています。

ルールベース機械翻訳

特徴: 翻訳のための規則や辞書に依存する翻訳システム。

目的: 正確で文法的に正しい翻訳を生成する。

説明: ルールベースの機械翻訳は、文法や単語の変換規則に基づきテキストを翻訳します。このアプローチは精確さには優れていますが、柔軟性に欠けることがあります。

統計学的機械翻訳

特徴: 大量の二言語テキストコーパスから学習した統計的モデルを使用して翻訳を行うシステム。

目的: コンテキストに基づいた自然で流暢な翻訳を提供する。

説明: 統計学的機械翻訳は、以前の翻訳例から確率的なパターン

を抽出し、これを用いて新たなテキストの翻訳を行います。文脈に強く依存するため、より自然な翻訳が可能ですが、大量の学習データが必要です。

特徴表現学習

特徴: データから自動的に有用な特徴を学習するプロセス。

目的: 手動で特徴を設計する作業を減らし、データの内在する構造をより効果的に捉える。

説明: 特徴表現学習は、特にディープラーニングの文脈で注目され、画像、音声、テキストなどの複雑なデータから、タスクに最適な特徴を自動的に抽出します。これにより、モデルの精度が向上し、より広範なアプリケーションが可能になります。

機械学習の具体的手法

学習目標:教師あり学習に用いられる学習モデルを理解する

学習項目:線形回帰、ロジスティック回帰、ランダムフォレスト、ブースティング、サポートベクターマシン (SVM)、ニューラルネットワーク、自己回帰モデル (AR)

線形回帰

特徴: 連続的な値を予測するために、入力(説明変数)と出力(目的変数)の間の線形関係をモデリングします。

目的: 一つまたは複数の予測変数と目的変数との関係を明らかにし、新しいデータに対する予測を行うこと。

説明: 線形回帰は最も基本的な予測モデルの一つで、データポイント間の直線的な関係を利用して、未知の値を予測します。例えば、家の大きさと価格の関係を予測する際に使われます。

線形回帰における帰無仮説と検定:統計的推論の基礎

線形回帰において、帰無仮説は、説明変数が目的変数に影響を与えていないという仮説です。これは、回帰係数が0であることを意味します。

一方、対立仮説は、説明変数が目的変数に影響を与えているという仮説です。これは、回帰係数が0ではないことを意味します。

第1種の過誤と第2種の過誤: 定義とイメージ

第1種の過誤(α誤差): 帰無仮説が正しいのに、対立仮説を支持してしまう誤り。宝探しで、宝箱が隠されていないのに石ころを宝箱と勘違いしてしまうようなものです。

第2種の過誤(β誤差): 帰無仮説が間違っているのに、帰無仮説を支持してしまう誤り。宝探しで、宝箱が隠されているのに見逃してしまうようなものです。

偽陽性と偽陰性: イメージと関係

偽陽性: 検査結果が陽性なのに、実際には病気ではない状態。宝箱が隠されていないのに、石ころを宝箱と勘違いしてしまう状態と同じです。

偽陰性: 検査結果が陰性なのに、実際には病気にかかっている状態。宝箱が隠されているのに、見逃してしまう状態と同じです。

ロジスティック回帰

特徴: 分類問題に使用され、特に二値分類(はい/いいえの答え)に適しています。

目的: 与えられた入力からカテゴリー出力の確率を予測すること。

説明: ロジスティック回帰は、出力を0と1の間の確率として表現し、特定の閾値(例えば0.5)を超えたら「1」と予測し、下回れば「0」と予測します。このモデルは、メールがスパムかどうかを判断するのに使われることがあります。

対数オッズとは

対数オッズは、イベントが起こる確率と起こらない確率のオッズを対数で表した値です。オッズとは、あるイベントが起こる確率と起こらない確率の比です。

対数オッズは、以下の式で計算されます。

対数オッズ = log(p / (1 - p))

ここで、p: イベントが起こる確率

対数オッズは、以下の特徴があります。

確率が 0 から 1 の範囲にある場合、対数オッズは -∞ から ∞ の範囲にある: 確率が 0 に近いほど、対数オッズは負の値になり、確率が 1 に近いほど、対数オッズは正の値になります。

対数オッズは、確率の変化に対して線形的な関係にある: 確率が 2 倍になると、対数オッズも 2 倍になります。

ランダムフォレスト

特徴: 複数の決定木を組み合わせたアンサンブル学習モデルです。

目的: 個々の決定木の予測を集約することで、全体としての予測精度を向上させること。

説明: ランダムフォレストは、多数の決定木をランダムに生成し、それぞれの木の予測結果を平均化または多数決により最終的な予測を行います。これにより、過学習を防ぎながら精度の高いモデルを作成できます。

ブースティング

特徴: 弱い学習器(単純なモデル)を順番に改善していくアンサンブル技術。

目的: 弱い学習器の予測を改善し、強力な予測モデルを構築すること。

説明: ブースティングは、一連の弱いモデルを徐々に改善していくことで、全体として強い予測力を持つモデルを作成します。各ステップでの誤りを次のモデルの学習に反映させ、徐々に誤差を減らしていきます。

サポートベクターマシン (SVM)

特徴: 高次元空間で最もマージンが大きい境界線を見つけることで、クラスを分割します。

目的: クラス間の明確な境界を確立し、新しいデータ点のクラスを効果的に予測すること。

説明: SVMはデータセットを最適に分割する線や平面(または超平面)を見つけることで、異なるカテゴリーのデータを効果的に分類します。特にマージン(クラス間の距離)が最大となる線を見つけ出すことが特徴です。

ニューラルネットワーク

特徴: 人間の脳のニューロンのネットワークを模倣したモデルで、複数の層から構成されます。

目的: 非常に複雑なパターンを学習し、分類、回帰、特徴抽出など多様なタスクに対応すること。

説明: ニューラルネットワークは、画像認識、音声認識、言語処理など、複雑な問題を解決するために使用されます。深層学習とも呼ばれるこの手法は、多数の隠れ層を通じてデータから高度な特徴を抽出する能力があります。

自己回帰モデル (AR)

特徴: 時系列データにおいて、過去の値を基に未来の値を予渤するモデル。

目的: 過去のデータパターンから未来を予測し、時系列分析における予測精度を向上させること。

説明: 自己回帰モデルは、過去の時点のデータ点(ラグ)に基づいて現在のデータ点を予測します。金融市場の分析や気象予測など、時系列データが豊富な分野で広く使用されています。

分類問題

特徴: カテゴリーに基づいてデータを分類するタイプの問題。

目的: ラベル付きデータを用いてモデルを訓練し、未知のデータに対する正確なカテゴリー予測を行う。

説明: 分類問題では、メールがスパムか非スパムかを判定するなど、データを事前定義されたクラスに分類します。これには、ロジスティック回帰やサポートベクターマシンなどが利用されます。

回帰問題

特徴: 連続値(実数値)を予測するタイプの問題。

目的: ラベル付きデータを基にして、未来の値や連続する数値を予測する。

説明: 回帰問題では、家の価格予測や気温

ラッソ回帰 (Lasso Regression)

特徴: 線形回帰の一種で、L1正則化を使用している。

目的: 重要でない特徴の係数を0に近づけ、モデルの解釈を容易にすること。

説明: ラッソ回帰は、不要な特徴量を削減し、モデルの過学習を防ぐために特に有用です。これにより、よりシンプルで効果的なモデルを作成することができます。

リッジ回帰 (Ridge Regression)

特徴: 線形回帰の一種で、L2正則化を使用している。

目的: 係数の大きさを制限することで過学習を防ぐ。

説明: リッジ回帰は、特に予測変数が多い場合に過学習を防ぐために有効です。これは、係数の大きさにペナルティを課すことで行われます。

決定木 (Decision Tree)

特徴: データを分類または回帰するために、質問を連鎖させるツリー構造のモデル。

目的: 単純明快なルールに基づいてデータを分割し、クラスを予測する。

説明: 決定木は、データをいくつかの質問に基づいて分岐させ、最終的に予測を行います。各質問はノードを形成し、最終的な予測は葉に到達することで行われます。

決定木と情報利得の最大化

決定木は、機械学習における代表的なアルゴリズムの一つであり、分類や回帰などの様々なタスクに利用することができます。

決定木は、データを階層的に分割していくことで、分類や予測を行うモデルです。

決定木を構築する際には、情報利得 を最大化するように分割点を決定することが重要です。

決定木のメリット

決定木は、以下のような多くのメリット を持ちます。

1. わかりやすい解釈性

決定木は、木構造 で表現されるため、論理的な思考過程 を視覚的に理解 しやすいという大きな利点があります。

複雑なモデルでは、なぜそのような結果が出力されるのか を理解するのが難しい場合がありますが、決定木であれば各ノード がどのような条件 でどのように分岐 しているのかを一目瞭然 で確認できます。

2. 高い汎用性

決定木は、分類 や回帰 などの様々なタスクに幅広く適用 できます。

教師あり学習 だけではなく、教師なし学習 にも利用できるため、データの種類 に縛られることなく活用できます。

3. 少ない前処理

決定木は、欠損値 やカテゴリカルデータ などに対しても比較的頑健 であり、データの前処理 に多くの時間を費やす必要がありません。

そのため、データ分析初心者 でも比較的簡単に 導入することができます。

4. 柔軟性の高さ

決定木は、剪定 やアンサンブル などの手法を組み合わせることで、精度 を向上させることができます。

また、新しいデータ が追加された場合にも、容易にモデルを更新 することができます。

5. 頑健性

決定木は、ノイズ や外れ値 に対しても比較的強い という特徴があります。そのため、信頼性の高いモデル を構築することができます。

決定木のデメリット

決定木にも、いくつかのデメリット があります。

1. 過学習

決定木は、データに過剰に適合 してしまう過学習 に陥りやすいという弱点があります。

過学習が発生すると、訓練データ では高い精度を達成できるものの、未知のデータ では精度が低下してしまう可能性があります。

2. 分岐の多さ

決定木は、分岐が多くなるほど モデルが複雑 になり、解釈が難しく なるという問題があります。

また、計算量 も増加するため、学習に時間がかかる というデメリットもあります。

アンサンブル学習 (Ensemble Learning)

特徴: 複数の学習モデルを組み合わせて、一つの最終的な予測モデルを作成する手法。

目的: 個々のモデルよりも優れた予測性能を達成する。

説明: アンサンブル学習は、バギング、ブースティング、スタッキングなどの技法を用いて、複数のモデルからの予測を組み合わせ、より正確な予測を行います。

バギング (Bagging)

特徴: ブートストラップサンプリングを使用して、複数のモデルを訓練し、その結果を平均化するアンサンブル技法。

目的: 分散を減少させ、過学習を防ぐ。

説明: バギングでは、元の訓練データセットからランダムに再サンプリングして複数のサブセットを作成し、それぞれでモデルを訓練します。その後、各モデルの予測を平均化することで最終的な予測を得ます。

勾配ブースティング (Gradient Boosting)

特徴: 弱い予測モデルを順番に改善していくブースティングの一種。

目的: 弱い学習器の予測を反復的に改善し、強い予測モデルを構築する。

説明: 勾配ブースティングは、前のモデルの誤差を次のモデルが修正するように設計されており、各ステップで損失関数の勾配を利用してモデルを更新します。

ブートストラップサンプリング (Bootstrap Sampling)

特徴: 元のデータセットから重複を許してランダムにサンプルを抽出する方法。

目的: データセットのランダムな部分集合を生成し、モデルの堅牢性を評価する。

説明: ブートストラップサンプリングは、特にバギングなどのアンサンブル学習法で用いられ、個々のサンプルが複数回選ばれることがあります。これにより、モデルの一般化能力をテストできます

マージン最大化 (Margin Maximization)

特徴: 分類器が異なるクラス間で最大のマージン(距離)を持つように設計するプロセス。

目的: モデルの汎用性と堅牢性を高め、新しいデータに対しても良好な性能を維持する。

説明: サポートベクターマシン(SVM)はこの原理を使用しており、最も近い訓練データ点(サポートベクター)から最大の距離を持つ決定境界を見つけます。

カーネル (Kernel)

特徴: データの非線形変換を行い、元の特徴空間よりも高次元の特徴空間でデータを表現する関数。

目的: 非線形のパターンを持つデータに対して、より効果的な学習モデルを構築する。

説明: カーネルはSVMなどのアルゴリズムで利用され、複雑なデータ関係をより単純な形で扱うことができるように変換します。

カーネルトリック (Kernel Trick)

特徴: 高次元へのデータの明示的な変換を避けながら、データをより高次元の空間で扱う手法。

目的: 計算の複雑性を増大させることなく、非線形問題を解決する。

説明: カーネルトリックを使用することで、サポートベクターマシンは複雑な非線形分類問題を、元の空間で線形分類問題として扱うことが可能になります。

単純パーセプトロン (Simple Perceptron)

特徴: 最も基本的な形のニューラルネットワークで、一層の前方向のみのフィードを持つ。

目的: 線形分類問題を解くためのモデルを提供する。

説明: 単純パーセプトロンは入力を受け取り、それに重みを掛け、合計値が閾値を超えるかどうかに基づいて出力します。

多層パーセプトロン (Multilayer Perceptron, MLP)

特徴: 複数の層を持ち、少なくとも一つの隠れ層が含まれるニューラルネットワーク。

目的: より複雑なパターンを識別できるようにモデルの能力を向上させる。

説明: MLPは、非線形活性化関数を使用しているため、単純パーセプトロンよりも複雑な問題を解くことが可能です。

活性化関数 (Activation Function)

特徴: ニューラルネットワークの各ノード(ニューロン)で使用される、入力信号の合計を出力信号に変換する関数。

目的: ネットワークに非線形性を導入し、より複雑な関数の近似を可能にする。

説明: 活性化関数には、シグモイド関数、ReLU関数、ソフトマックス関数などがあり、それぞれが異なる特性を持ち、用途に応じて選択されます。

非線形活性化関数

ネットワークに非線形性を導入し、複雑な関数を学習可能にする。非線形活性化関数はさらに以下のように細分化できる。

※非線形な関数を用いられるのは線形ではネットワークを多層にする意味がない

飽和型活性化関数

特性: 出力がある範囲内に限定される(飽和する)。勾配消失問題の原因になることがあるが、出力の正規化に役立つ。

例: Sigmoid, Tanh, Softmax

非飽和型活性化関数

特性: ある条件下で出力が飽和しない。これにより、勾配消失問題を軽減できる。

例: ReLU, Leaky ReLU, Parametric ReLU (PReLU), ELU

適応型活性化関数

特性: パラメータを持ち、学習プロセス中にこれらのパラメータが調整される。

例: Parametric ReLU (PReLU), ELU (ある意味で適応的), GELU

高度な非線形活性化関数

特性: 複雑な計算を行い、モデルの学習能力を向上させることができる。しばしば特定の問題に特化している。

例: Swish, GELU

シグモイド関数 (Sigmoid Function)

特徴: S字型の曲線を描く活性化関数。

目的: 出力を0から1の間に制限し、確率として解釈できるようにする。

説明: シグモイド関数は、特に二値分類問題の出力層で使用され、出力を確率として解釈することができます。

ソフトマックス関数 (Softmax Function)

特徴: 各クラスに対する確率を計算するために使用される活性化関数。

目的: 多クラス分類問題の出力層で、それぞれのクラスに属する確率を出力する。

説明: ソフトマックス関数は、ネットワークの最後の層で使用され、各クラスに対する相対的な確率スコアを提供します。

誤差逆伝播法 (Backpropagation)

特徴: ニューラルネットワークを訓練するためのアルゴリズムで、出力誤差を元に各重みを効率的に調整する。

目的: ネットワークの予測誤差を最小化し、正確なモデルを構築する。

説明: 誤差逆伝播法は、ネットワークの出力と期待される出力との間の誤差を計算し、この誤差をネットワークの層を逆方向に伝播させながら各ニューロンの重みを更新します。これにより、ネットワーク全体のパフォーマンスが向上します。

ベクトル自己回帰モデル (VARモデル)

特徴: 複数の時系列データ間の線形関係をモデリングするための統計モデル。

目的: 複数の変数の動的な関係を捉え、将来の値を予測する。

説明: VARモデルは、各変数が他の変数の過去の値にどのように依存しているかを表し、経済学、金融などの分野で広く使用されています。これにより、システム内の全変数の相互作用を同時に分析することが可能です。

隠れ層 (Hidden Layer)

特徴: 入力層と出力層の間にあるニューラルネットワークの層。

目的: データのより抽象的な特徴を学習し、モデルの表現力を向上させる。

説明: 隠れ層はネットワークが複雑なパターンや非線形の関係を学習するのに不可欠で、その数やサイズはモデルの複雑性や学習能力を決定します。

疑似相関 (Spurious Correlation)

特徴: 統計的には相関が認められるものの、実際には因果関係が存在しない関係。

目的: データ分析の際に誤解を避け、より信頼性の高い結論を導く。

説明: 疑似相関は、たまたまの一致や共通の原因によって生じることがあり、データ科学者はこのような誤った相関に基づく結論を避けるために注意が必要です。

重回帰分析 (Multiple Regression Analysis)

特徴: 複数の説明変数を用いて一つの従属変数を予測する統計手法。

目的: 複数の要因が従属変数にどのように影響を与えるかを同時に評価する。

説明: 重回帰分析は、各説明変数の効果を分離して量定することができ、ビジネス、経済学、生物学など多岐にわたる分野で用いられます。

AdaBoost

特徴: 弱い学習器を順番に改良しながら組み合わせ、強い学習器を作成するブースティングアルゴリズム。

目的: 分類器の性能を段階的に向上させる。

説明: AdaBoostは、誤分類されたインスタンスに次第に重みを加えていくことで、学習過程でこれらにより注目し、分類精度を高めます。

多クラス分類 (Multiclass Classification)

特徴: 二つ以上のクラスにデータを分類する問題。

目的: より複雑な分類問題に対応し、多様なカテゴリーを識別する。

説明: 多クラス分類は、例えば動物の画像を犬、猫、鳥といった複数のカテゴリに分類する際に使用されます。この問題は、ソフトマックス関数を使用して解決することが一般的です。

プルーニング (Pruning)

特徴: 決定木などのモデルの成長を制限し、過学習を防ぐために枝を剪定するプロセス。

目的: モデルの汎用性を向上させる。

説明: プルーニングは、特に決定木で有効で、ノードの追加がモデルの性能向上に寄与しない場合にその部分を削除します。これにより、モデルはより一般化され、新しいデータに対しても強い性能を発揮します。

学習目標:教師なし学習の基本的な理論を理解する

学習項目:k-means 法、ウォード法、主成分分析 (PCA)、協調フィルタリング、トピックモデル

クラスタリング

特徴: データを類似性に基づいてグループに分けるプロセス。

目的: 類似の特性を持つデータポイントを同じグループに分類し、データの構造を明確にする。

説明: クラスタリングは、データを複数のクラスタに自動的に分けることで、データセット内の自然なグルーピングやパターンを発見するのに役立ちます。例えば、顧客データから類似の購買行動を示す顧客グループを識別することができます。

Q1. クラスタリングとは何か簡単に説明してください。 A1. クラスタリングとは、与えられたデータ集合を、そのデータ間の類似性に基づいて複数のグループ(クラスタ)に分割する手法のことです。同じクラスタ内のデータは類似性が高く、異なるクラスタ間ではデータは異なる性質を持つように分割されます。

Q2. クラスタリング手法の代表的なアルゴリズムを2つ挙げてください。 A2. 代表的なクラスタリング手法には、k-means法と階層的クラスタリング法があります。k-means法は事前にクラスタ数kを指定し、それぞれのデータを最も近いクラスタに割り当てていきます。階層的クラスタリングは、デンドログラムと呼ばれる木構造を構築し、任意の高さでクラスタを分割します。

Q3. クラスタリングの目的は何か、2つ挙げてください。 A3. 1つ目はデータの可視化と解釈が容易になることです。大量のデータを少数のクラスタに分割することで、データの背後にある構造をつかみやすくなります。2つ目は、将来のデータに対する予測や分類が容易になることです。学習済みのクラスタリングモデルに新しいデータを入力すれば、そのデータがどのクラスタに属するかを判断できます。

Q4. クラスタリングの評価指標としてよく使われるものを答えてください。 A4. クラスタリングの評価指標としてよく使われるのは、手法内分散(Within-Cluster Sum of Squares)です。これは各クラスタ内のデータ点間の距離の総和を小さくすることで、クラスタ内の凝集度を最大化します。また、手法間分散(Between-Cluster Sum of Squares)は、クラスタ間の距離を最大化するための指標です。

Q5. クラスタリングの利用例を2つ挙げてください。 A5. クラスタリングの利用例としては、マーケティングにおける顧客セグメンテーションがあげられます。顧客データをクラスタリングすることで、類似した嗜好や行動パターンを持つ顧客グループを発見できます。また、金融分野においては、不正検知のためにクレジットカード利用履歴をクラスタリングし、異常なパターンを検出する例があります。

クラスタ分析

特徴: データセットを意味のあるクラスタに分割し、分析するプロセス。

目的: データ内の自然なグループを同定し、データの理解を深める。

説明: クラスタ分析はマーケティング、生物学、社会科学など多岐にわたる分野で利用され、データの特徴や構造を把握するのに役立ちます。

レコメンデーション

特徴: ユーザーの好みや行動に基づいて製品やサービスを提案するプロセス。

目的: ユーザー体験を個人化し、関連性の高いアイテムを推薦する。

説明: レコメンデーションシステムは、オンラインショッピングや映画の推薦などに利用され、ユーザーの以前の行動や評価から新しいアイテムを推薦します。

デンドログラム (樹形図)

特徴: ヒエラルキカルクラスタリングの結果を表す樹形図。

目的: クラスタ間の関係性や距離を視覚的に表現し、データの階層的な構造を理解する。

説明: デンドログラムは、各クラスタがどのように組み合わさり、最終的に単一のクラスタになるかを示します。これにより、データセットの詳細な洞察が可能になります。

デンドログラムが利用されるクラスタリング手法:群平均法

デンドログラムは、階層型クラスタリング手法において、データの類似性に基づいてグループ化していく過程を可視化するために利用されます。

群平均法は、階層型クラスタリング手法の一つであり、以下の手順でクラスタリングを行います。

初期化: 最初に、すべてのデータを個別のクラスタに割り当てます。

クラスタ間の距離計算: 次に、すべてのクラスタ間の距離を計算します。距離計算には、様々な方法がありますが、群平均法ではユークリッド距離を用いるのが一般的です。

最小距離のクラスタ結合: 最も近い2つのクラスタを結合します。このとき、結合される2つのクラスタ間の距離を新しいクラスタの中心距離とします。

2.と3.を繰り返す: 2.と3.の手順を、すべてのデータが一つのクラスタになるまで繰り返します。

デンドログラムは、この群平均法におけるクラスタ結合の過程を図示したものです。デンドログラムには、以下の情報が示されます。

横軸: データのIDまたはクラスタのID

縦軸: クラスタの中心距離

水平線: クラスタ結合のタイミング

図1は、群平均法で生成されたデンドログラムの例です。

[図1: 群平均法によるデンドログラムの例]

このデンドログラムから、以下のことが読み取れます。

データは4つのクラスタに分類されている

クラスタ1とクラスタ2は最も類似しており、最初に結合された

クラスタ3とクラスタ4は次に類似しており、その後結合された

デンドログラムは、以下の目的で使用されます。

クラスタリング結果の可視化: クラスタリング結果を視覚的に確認するために用いられます。

最適なクラスタ数の決定: デンドログラムの形状から、最適なクラスタ数を判断するために用いられます。

異常値の検出: デンドログラムから、異常値とみられるデータ点を検出するために用いられます。

群平均法におけるデンドログラムは、以下の点に注意する必要があります。

距離計算方法: 距離計算方法によって、デンドログラムの形状が変化することがあります。

リンク距離: デンドログラムの横軸に表示される距離は、リンク距離と呼ばれるものであり、クラスタ間の距離とは異なります。

解釈: デンドログラムはあくまでも可視化ツールであり、クラスタリング結果を解釈する際には、他の情報も考慮する必要があります。

まとめ

デンドログラムは、群平均法をはじめとする階層型クラスタリング手法において、クラスタリング結果を理解し、分析するために役立つツールです。デンドログラムを活用することで、データの構造や異常値などをより深く理解することができます。

特異値分解 (SVD)

特徴: マトリックスを特異ベクトルと特異値の積に分解する線形代数の手法。

目的: データの本質的な特性を抽出し、次元削減を行う。

説明: SVDはデータ圧縮、ノイズリダクション、レコメンデーションシステムなどで使用され、効率的なデータ表現を提供します。

多次元尺度構成法 (Multidimensional Scaling, MDS)

特徴: 高次元データを低次元空間に表現し、元の距離関係を保持するように配置する手法。

目的: データ間の相対的な距離を保持しながら視覚化し、データのパターンを理解しやすくする。

説明: MDSは、類似性や距離が重要な分析で利用され、複雑なデータ関係を直感的に解釈するのに役立ちます。

多次元尺度構成法の概要

MDSは、対象間の類似性や相違性のデータから、それらの対象を低次元の空間上に配置する手法です。

対象間の距離が近いほど、それらの対象が類似していると判断できます。

対象を低次元の空間上に配置することで、対象間の関係性を視覚的に把握できるようになります。

MDSの特徴

定量的なデータ(メトリックMDS)や順序データ(ノンメトリックMDS)を扱うことができます。前者を量的データ、後者は質的データとして扱う。

対象間の類似性や相違性を数値化したデータを入力として使用します。

出力される配置図では、類似した対象が近くに、異なる対象が離れて表示されます。

MDSの応用

市場調査: 商品やブランドの位置づけを把握するために使用されます。

心理学: 人の認知構造を分析するのに活用されます。

情報可視化: 高次元データを低次元の空間に表現できるため、データの構造を視覚的に理解できます。

MDSの手順

対象間の類似性や相違性のデータを収集する

MDSアルゴリズムを使って、低次元の空間上に対象を配置する

配置図を分析し、対象間の関係性を解釈する

MDSは、多変量解析の手法の1つで、主成分分析と同様に分類対象物の関係を低次元空間に表現することができます。

多次元尺度構成法

多次元尺度構成法(Multidimensional Scaling、MDS)は、アイテム間の類似性または距離データを基にして、それらアイテムを低次元の空間(通常は2次元または3次元)に配置する統計手法です。この方法は、複雑な類似性関係を視覚的に表現するために使用され、心理学、マーケティング、社会科学、生物学など様々な分野で応用されています。

基本原理

MDSの目的は、アイテム間の距離または類似性を可能な限り忠実に空間に表現することです。具体的には、各アイテムを点として空間に配置し、与えられた距離データと空間内の点同士のユークリッド距離が一致するようにします。このプロセスは、アイテム間の距離の構造を解釈しやすくするために、高次元の関係性を低次元で表現します。

手順

距離行列の作成: 全てのアイテムペアの間の距離または類似性を測定し、それを距離行列としてまとめます。距離は直接測定するか、類似性スコアから変換して導出します。

初期配置: アイテムをランダムまたはある程度の仮定に基づいて空間に初期配置します。

ストレス関数の最小化: 空間内の点同士の距離が、元の距離行列に記載されている距離とできるだけ一致するように、配置を調整します。このために一般的には「ストレス関数」と呼ばれる目的関数を最小化することで、配置を反復的に調整します。

解の解釈: 結果の空間配置を解析し、アイテム間の関係を解釈します。この配置から、アイテム群のクラスタリングやパターンの特定が可能になります。

種類

計量(古典的)MDS(Metric MDS): 元の距離行列が正確な距離を表している場合に使用され、距離の二乗行列に基づく固有値分解を用いて解を求めます。

非計量MDS(Non-metric MDS): 距離行列が厳密な距離ではなく、順序尺度などの類似度のランキング情報のみを含む場合に使用されます。ここでは、距離の順序を保持するように配置を求めるため、距離の正確な値よりもその相対的な大小が重視されます。

メリット

複雑なデータの構造を直感的に可視化できる。

アイテム間の類似性やクラスタを容易に把握できる。

デメリット

計算コストが高い場合がある。

結果の解釈が主観的になる可能性がある。

初期値の選択や解の多様性により、異なる解が得られることがあります。

t-SNE (t-Distributed Stochastic Neighbor Embedding)

特徴: 高次元データを低次元で表現するための統計的手法。

目的: 高次元データのクラスタリングやパターンを低次元で視覚的に表現する。

説明: t-SNEは特にデータサイエンスで人気があり、類似したデータポイントが低次元で密集して表示されるようにデータをマッピングします。

コールドスタート問題

特徴: 新しいユーザーやアイテムに対して十分なデータがないためにレコメンデーションが困難になる問題。

目的: レコメンデーションシステムの効果を初期段階から高める。

説明: コールドスタート問題は、特に新規ユーザーや新商品の場合に顕著であり、過去のデータに基づく推薦ができないために起こります。

コンテンツベースフィルタリング

特徴: ユーザーが過去に好んだアイテムの内容(コンテンツ)を分析し、類似のアイテムを推薦する手法。

目的: ユーザーの個別の好みに合わせたパーソナライズされた推薦を提供する。

説明: コンテンツベースフィルタリングは、アイテム自体の特徴(例えば映画のジャンルやキャスト)を利用して推薦を行い、ユーザーの個々の嗜好に応じたアイテムを提示します。

潜在的ディリクレ配分法 (Latent Dirichlet Allocation, LDA)

特徴: トピックモデルの一種で、文書を複数のトピックの混合としてモデル化する。

目的: 大量のテキストデータから潜在的なトピックを抽出し、文書の構造を理解する。

説明: LDAは文書集合からトピックを学習し、各文書がどのトピックにどれだけ関連しているかを推定します。これにより、文書の主要なテーマを把握できます。

Latent Dirichlet Allocation (LDA) は、自然言語処理およびテキストマイニングにおいて広く使用される統計的なトピックモデルです。LDAは2003年にDavid M. Blei、Andrew Y. Ng、およびMichael I. Jordanによって導入されました。このモデルは文書内に存在する隠れたトピック(テーマ)を発見することを目的としています。以下に、LDAの基本的な仕組み、プロセス、およびその特徴について詳しく説明します。

LDAの基本概念

LDAは、各文書が複数のトピックから生成されるという生成モデルです。文書集合を通じて共通のトピックを識別し、それぞれの文書がどのトピックにどれだけ関連しているかを示します。LDAは以下のような基本的な仮定に基づいています:

トピックは単語の分布:各トピックは特定の単語が出現する確率分布として表されます。

文書はトピックの混合:各文書は一つ以上のトピックの混合であり、それぞれのトピックは文書内の一定の割合を占めます。

LDAのプロセス

LDAの処理プロセスは、以下のステップに大別されます:

パラメータの設定:トピックの数 𝐾K を設定します。これはモデルによって識別されるトピックの総数です。

ディリクレ分布の割り当て:文書におけるトピックの分布と各トピックにおける単語の分布にディリクレ分布を使用します。これにより、文書とトピック、トピックと単語の関係が確率的にモデリングされます。

ランダム初期化:最初に、文書の各単語にランダムにトピックを割り当てます。

反復アルゴリズムの適用:ギブスサンプリングや変分ベイズ推論などのアルゴリズムを用いて、各単語のトピック割り当てを最適化します。この過程で、文書内の他の単語のトピック割り当てや他の文書のトピック分布を考慮し、反復的に更新を行います。

LDAの特徴と応用

トピックの解釈性:LDAはトピックを単語の確率分布としてモデル化するため、生成されたトピックは人間が解釈可能です。

非監視学習:LDAはラベルのないテキストデータからトピックを学習するため、非監視学習の一形態です。

多様な応用:LDAはニュース記事、科学論文、顧客レビューなど、さまざまな種類のテキストデータに適用可能です。文書分類、情報検索、コンテンツ推薦など、多岐にわたる分野で利用されています。

LDAは、文書の隠れたトピック構造を理解するのに強力なツールであり、テキストデータの潜在的な意味構造を解明するために広く使われています。

次元削減

特徴: データセットの特徴量の数を減少させるプロセス。

目的: データの本質的な情報を保持しつつ、計算負担を軽減し、データの可視化を容易にする。

説明: 次元削減は、PCAやt-SNEなどの技術を使用して高次元データの複雑さを低減し、データ解析の効率を向上させます。

次元圧縮

特徴: データの情報をできるだけ保ちながら、データの表現をより少ない量で表す技術。

目的: ストレージ要件の削減と計算効率の向上。

説明: 次元圧縮は、データの重要な特性を保持しながら、不要な情報を取り除くことでデータのサイズを小さくします。特異値分解 (SVD) がこの目的でよく使用されます。

次元圧縮手法の種類と詳細

次元圧縮は、高次元データを低次元空間に射影することで、データ量を削減し、処理速度を向上させる手法です。様々な手法が存在し、それぞれの特徴と利点・欠点があります。以下では、代表的な次元圧縮手法をいくつか詳しく説明します。

1. 主成分分析 (PCA)

主成分分析 (PCA) は、線形変換を用いた次元圧縮手法であり、最も広く用いられている手法の一つです。データの分散を最大化するような方向ベクトルを基底として、低次元空間に射影します。

PCAの利点

計算効率が高い *解釈しやすい

多くの場合、効果的に次元圧縮できる

PCAの欠点

非線形な関係性を考慮できない

すべての情報を保持できない

PCAの適用例

画像圧縮

音声圧縮

テキストマイニング

異常検知

2. 線形判別分析 (LDA)

線形判別分析 (LDA) は、分類問題に特化した線形変換を用いた次元圧縮手法です。複数のクラス間の判別性を最大化するような方向ベクトルを基底として、低次元空間に射影します。

LDAの利点

分類精度を向上させることができる

LDAの欠点

クラス間の分布が正規分布に従っている必要がある

PCAよりも計算コストが高い

LDAの適用例

顔認識

スパムフィルタリング

医療診断

3. 多重スケールエンコーダ・デコーダ (MSAED)

多重スケールエンコーダ・デコーダ (MSAED) は、畳み込みニューラルネットワークを用いた非線形変換による次元圧縮手法です。入力データを複数のスケールでエンコーダに入力し、デコーダで低次元空間に再構成します。

MSAEDの利点

非線形な関係性を考慮できる

PCAよりも高い精度で次元圧縮できる

MSAEDの欠点

PCAよりも計算コストが高い

学習データが必要

MSAEDの適用例

画像圧縮

音声圧縮

自然言語処理

4. t-SNE

t-SNE は、確率的な手法を用いた非線形変換による次元圧縮手法です。高次元空間と低次元空間におけるデータ点間の距離を保ちながら、低次元空間に射影します。

t-SNEの利点

高次元データの可視化に有効

t-SNEの欠点

計算コストが高い

収束に時間がかかる

t-SNEの適用例

高次元データの可視化

異常検知

5. UMAP

UMAP は、t-SNEと同様に、確率的な手法を用いた非線形変換による次元圧縮手法です。t-SNEよりも計算効率が高く、より高精度な次元圧縮が可能であると言われています。

UMAPの利点

t-SNEよりも計算効率が高い

t-SNEよりも高精度な次元圧縮が可能

UMAPの欠点

t-SNEと同様に、収束に時間がかかる

UMAPの適用例

高次元データの可視化

異常検知

その他の次元圧縮手法

上記以外にも、様々な次元圧縮手法が存在します。代表的なものとして、以下のようなものがあります。

独立成分分析 (ICA)

非負値行列因子分解 (NMF)

特異値分解 (SVD)

カーネルPCA (KPCA)

スパースコーディング

それぞれの次元圧縮手法は、異なる特徴と利点・欠点を持っています。最適な手法は、データの種類や目的によって異なります。

次元圧縮手法の選び方

次元圧縮手法を選ぶ際には、以下の点を考慮する必要があります。

データの種類: 画像データ、音声データ、テキストデータなど、データの種類によって適した手法が異なります。

目的: 次元圧縮を行う目的によって、適した手法が異なります。例えば、データ量を削減したい場合はPCAが適していますが、分類精度を向上させたい場合はLDAが適しています。

計算コスト: 計算コストの高い手法は、大規模なデータセットには適していません。

解釈性: 解釈しやすい手法は、結果の理解が容易になります。

学習目標:強化学習の基本的な理論を理解する 学習項目:バンディットアルゴリズム、マルコフ決定過程モデル、価値関数、方策勾配

強化学習の学習:詳細解説

強化学習は、エージェントと呼ばれる主体が、試行錯誤を通じて最適な行動を学習していく機械学習の一種です。従来の教師あり学習とは異なり、正解データを与えられるのではなく、報酬と呼ばれる評価指標のみを与えられ、自律的に学習していく点が特徴です。

強化学習の学習プロセスは、以下の3つのステップで構成されます。

1. 環境とのインタラクション

エージェントは、環境と相互作用することで、状態と報酬の情報を得ます。

環境は、エージェントの行動に応じて、状態を変化させ、報酬を与えます。

例:ロボット掃除機が部屋を掃除する、ゲームでキャラクターを操作する

2. 方策の更新

エージェントは、得られた状態と報酬の情報に基づいて、方策と呼ばれる行動選択確率を更新します。

方策は、状態における各行動を選択する確率を表します。

方策は、経験に基づいて改善されていきます。

例:ロボット掃除機が汚れている場所を掃除する確率を高める、ゲームで勝率の高い行動を選択する確率を高める

3. 繰り返し

エージェントは、1と2を繰り返し行うことで、最適な行動を学習していきます。

経験を積み重ねることで、方策が改善され、より多くの報酬を得られるようになります。

例:ロボット掃除機が部屋を効率的に掃除できるようになる、ゲームでより高いスコアを獲得できるようになる

強化学習の学習アルゴリズム

強化学習には、様々な学習アルゴリズムが存在します。代表的なアルゴリズムは以下の通りです。

Q学習: 現在の状態における各行動の期待報酬を学習し、最大期待報酬に基づいて行動を選択します。

SARSA: 現在の状態と次の状態における行動のペアの期待報酬を学習し、最大期待報酬に基づいて行動を選択します。

Policy Gradient法: 方策のパラメータを直接更新することで、報酬を最大化する方策を学習します。

強化学習: 従来の機械学習との違いを解き明かす

強化学習は、人工知能の一分野であり、試行錯誤を通じて最適な行動を学習する手法です。まるで、ゲームのキャラクターが経験を積み重ねて最強の攻略方法を身につけるように、自律的に学習していくイメージです。

従来の機械学習との主な違いは以下の3点です。

1. 学習方法の違い

従来の機械学習: 大量の教師データ(正解ラベル付きデータ)を与えられ、教師あり学習と呼ばれる方法で学習します。

強化学習: 教師データは不要で、報酬と呼ばれる評価指標のみを与えられ、試行錯誤を通じて最適な行動を学習します。

2. 目標の違い

従来の機械学習: 特定のタスク(画像分類、音声認識など)を高精度に実行することを目標とします。

強化学習: 長期的な報酬を最大化することを目標とします。これは、ゲームで高得点を獲得したり、ロボットが自律的に目標地点に到達したりすることに例えられます。

3. 応用分野の違い

従来の機械学習: 画像認識、音声認識、自然言語処理など、データ分析に適した分野で広く利用されています。

強化学習: ゲーム、ロボット制御、自動運転、電力制御など、複雑な環境で最適な行動を決定することが求められる分野で注目されています。

強化学習は、自律的な学習と長期的な報酬という2つの特徴により、従来の機械学習では対応が難しかった複雑な問題を解決する可能性を秘めています。

マルコフ決定過程 (MDP) の要素:詳細解説

マルコフ決定過程 (MDP)は、強化学習における重要な概念であり、エージェントと環境の相互作用を確率的なモデルで表現します。MDPは、以下の5つの要素で構成されます。

1. 状態 (S)

エージェントが環境に置かれている状況を表します。

時間によって変化し、有限個または無限個の状態が存在します。

例:ロボットの位置、ゲームの盤面、株式市場の状態

2. 行動 (A)

エージェントが環境に対して取ることのできる行動を表します。

有限個または無限個の行動が存在します。

例:ロボットの移動方向、ゲームにおけるアクション、株式の売買

3. 状態遷移確率 (P)

ある状態である行動を取ったとき、次の状態に遷移する確率を表します。

P(s'|s, a) で表され、0 ≦ P(s'|s, a) ≦ 1 を満たします。

例:ロボットが上方向に移動しようとしたとき、実際に上方向に移動する確率

4. 報酬 (R)

エージェントがある状態に遷移したとき、またはある行動を取ったときに得られる報酬を表します。

数値で表され、正の報酬 (好ましい状態) と負の報酬 (好ましくない状態) があります。

例:ロボットが目標地点に到達したとき得られる報酬、ゲームでポイントを獲得したとき得られる報酬

5. 報酬関数 (R)

状態と行動の組み合わせに対して、期待される報酬を定義する関数です。

R(s, a) で表されます。

エージェントの目標を定量的に表現します。

例:ロボットが特定の状態に滞在したとき得られる報酬、ゲームで特定のアクションを取ったとき得られる報酬

MDPの例:ロボット掃除機

ロボット掃除機を例に、MDPの要素を説明します。

状態 (S): ロボット掃除機の現在位置と部屋の状態 (汚れている/綺麗)

行動 (A): 前進、後退、左旋回、右旋回

状態遷移確率 (P): ロボット掃除機の行動と部屋の状態に基づいて、次の状態が決定される確率

報酬 (R): ロボット掃除機が汚れている場所を掃除したとき、正の報酬。ロボット掃除機が壁にぶつかったとき、負の報酬

報酬関数 (R): ロボット掃除機が掃除した場所の割合に基づいて、報酬を計算

MDPの重要性

MDPは、強化学習における基本的なフレームワークであり、以下の理由で重要です。

エージェントと環境の相互作用を確率的にモデル化できる

様々な強化学習アルゴリズムの基礎となる

問題を状態**、行動、報酬というシンプルな要素に分解できる。

バンディットアルゴリズム(Bandit Algorithms)

バンディットアルゴリズムは、強化学習の一形態で、特に「マルチアームドバンディット問題」に対する解決策を提供します。この問題では、複数の選択肢(「アーム」と呼ばれる)から一つを選び、それに応じた報酬を受け取ることができます。各アームがもたらす報酬の分布は未知であり、アルゴリズムの目的は、限られた試行回数の中で最大の報酬を獲得することです。

主な特徴

単純な意思決定: バンディットアルゴリズムは、一連の選択肢の中から最も良い選択を迅速に見つけることに焦点を当てています。各選択は独立しており、前の選択からの複雑な状態遷移は考慮しません。

探索と活用のトレードオフ: バンディット問題の核心は、既知の選択肢から最大の報酬を得る(活用)か、未知の選択肢を試して将来的な報酬を最大化するか(探索)の間のバランスを見つけることです。

主なバンディットアルゴリズム

ε-greedyアルゴリズム

定期的にランダムな選択を行い(探索)、それ以外の時はこれまでに最も高い報酬を与えた選択を行います(活用)。

UCB(Upper Confidence Bound)

各アームの報酬の推定値とその不確実性を考慮し、それに基づいてアームを選択します。不確実性が高いアームは報酬の潜在能力が高いと考えられるため、探索の機会が与えられます。

トンプソン・サンプリング

ベイジアンアプローチを使用して、各アームの報酬分布の確率モデルを更新し、その分布からサンプリングしてアームを選択します。この方法は、確率的に探索と活用のバランスを取ります。

応用例

広告の最適化: ウェブサイトにおいてどの広告が最もクリックされるかを試行錯誤しながら学習し、最終的には最も効果的な広告を表示します。

推薦システム: ユーザーに最適な推薦を行うために、異なる推薦アイテムの中から最も反応が良いものを特定します。

臨床試験: 新しい医薬品の効果を試験する際に、患者に対して最も有効な治療法を探索します。

バンディットアルゴリズムは、その単純さと強力なパフォーマンスにより、多くの実用的な問題解決に有効な手段として広く使用されています。特に、オンラインでの意思決定プロセスに

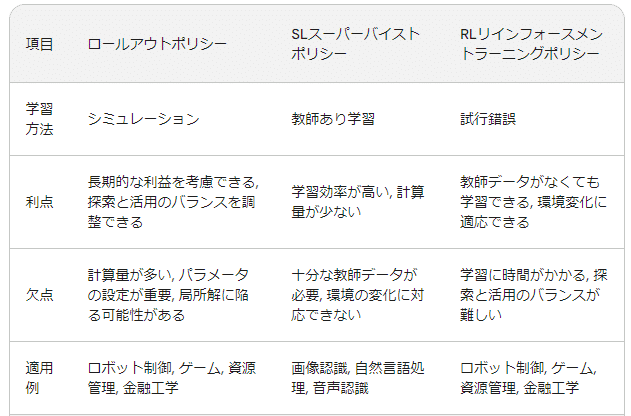

Rollout POLICY、SL POLICY、RL POLICYの特徴と比較

ロールアウトポリシー、SL スーパーバイストポリシー、RL リインフォースメントラーニングポリシーの比較

ロールアウトポリシー、SLスーパーバイストポリシー、RLリインフォースメントラーニングポリシーは、それぞれ異なる強化学習における方策であり、それぞれ異なる特徴と利点・欠点を持っています。以下では、それぞれの詳細と比較を行います。

1. ロールアウトポリシー

概要:

シミュレーションを用いて未来の報酬を推定し、最適な行動を選択する方策

長期的な利益を考慮できる

探索と活用のバランスを調整できる

計算量が多い

パラメータの設定が重要

利点:

短期的な利益だけでなく、長期的な利益も考慮して行動を選択できる

探索と活用のバランスを調整できるため、未知の環境でも学習しやすい

欠点:

シミュレーションを実行する必要があるため、計算量が多い

パラメータの設定が重要であり、適切な設定が難しい場合がある

局所解に陥る可能性がある

適用例:

ロボット制御

ゲーム

資源管理

金融工学

2. SLスーパーバイストポリシー

概要:

教師あり学習を用いて、正解データから方策を学習する方策

学習効率が高い

計算量が少ない

十分な教師データが必要

環境の変化に対応できない

利点:

教師あり学習を用いるため、学習効率が高い

計算量が少ない

欠点:

十分な教師データが必要であり、データ収集が難しい場合がある

環境の変化に対応できない

適用例:

画像認識

自然言語処理

音声認識

3. RLリインフォースメントラーニングポリシー

概要:

試行錯誤を通じて、報酬を最大化する方策を学習する方策

柔軟性が高い

環境変化に適応できる

学習に時間がかかる

探索と活用のバランスが難しい

利点:

教師データがなくても学習できる

環境変化に適応できる

欠点:

学習に時間がかかる

探索と活用のバランスが難しく、学習がうまくいかない場合がある

適用例:

ロボット制御

ゲーム

資源管理

金融工学

比較表

まとめ

ロールアウトポリシー、SLスーパーバイストポリシー、RLリインフォースメントラーニングポリシーは、それぞれ異なる特徴と利点・欠点を持っています。どのポリシーが最適かは、タスクや環境によって異なります。

長期的な利益を考慮する必要がある場合は、ロールアウトポリシーが適しています。

学習効率を重視する場合は、SLスーパーバイストポリシーが適しています。

教師データがない場合は、RLリインフォースメントラーニングポリシーが適しています。

割引率 (Discount Factor)

特徴: 将来の報酬を現在価値に割り引いて評価するためのパラメータ。

目的: 長期的な目標に焦点を合わせつつも、近い将来の報酬を重視するバランスを取る。

説明: 割引率は0から1の間で設定され、値が低いほど即時の報酬を重視し、高いほど将来の報酬を重視します。これにより、エージェントは即時の利益と長期的な利益のトレードオフを管理します。

ε-greedy 方策 (Epsilon-Greedy Policy)

特徴: 一定の確率εでランダムな行動を選択し、残りの1-εの確率で最大の報酬をもたらす行動を選択する方策。

目的: 探索と活用のバランスを取り、局所的最適解に固執することなく多様な行動を試す。

説明: ε-greedy 方策は、初期の学習段階でランダムな行動を多く取り入れることで探索を促進し、学習が進むにつれて最適な行動を活用する比率を高めます。

UCB 方策 (Upper Confidence Bound Policy)

特徴: 行動の選択において、推定された報酬の不確実性も考慮に入れる方策。

目的: 探索と活用のトレードオフを効率的に管理し、不確実性が高い行動を適度に探索する。

説明: UCB方策は、既に試された行動の報酬とその行動が選択された回数に基づいて、次にどの行動を取るかを決定します。これにより、探索が不十分な行動に自動的に重みを置くことができます。(試行数が少ない行動を優先的に選択)

UCB(Upper Confidence Bound)方策は、強化学習における一つの戦略で、報酬が最大となるような行動を選択するためにその行動に関する情報が必要です。UCB方策は、この情報を収集する際に、これまでに選択された回数が少ないものを優先的に選択します。

UCB方策は、期待値の高い選択肢を選ぶ一方で、それまで施行数が少ない選択肢を優先的に選択されるようにする方策です。これにより、探索と利用のバランスを取りながら、最適な行動を見つけ出すことが可能となります。

このような特性から、UCB方策はバンディット問題などの問題解決に広く利用されています。バンディット問題とは、未知の報酬が設定された選択肢が多数存在し、その中から一つを選択するという問題で、選んだ選択肢に対する報酬を得ることができます。この問題では、報酬を最大化するためには、良い選択肢の探索と過去に選んだ選択肢に対する知識の利用のバランスが重要になります。

UCB 方策 vs ε-greedy 方策:探索と利用の戦い

UCB 方策と ε-greedy 方策はどちらも、強化学習における 探索と利用 のバランスをとるアルゴリズムですが、アプローチが異なります。

共通の目的:

未知の行動を試して報酬を最大化するための情報を集める(探索)

学習済みの情報をもとに、現時点で最も報酬の高い行動を選択する(利用)

相違点:

探索の考え方

UCB 方策: 各行動のUCB値を計算し、値が高い(探索ボーナスが大きい)行動を選択。UCB値は、平均報酬と探索度 (選択回数が少ないほど大きくなる) を考慮します。

ε-greedy 方策: 一定の確率 (ε) でランダムに行動を選択し、残りの確率 (1-ε) でこれまでで一番報酬が高かった行動を選択。εは固定値なので、探索の度合いが一定です。

計算量

UCB 方策: 各行動のUCB値を計算する必要があるため、ε-greedy 方策より計算量が多いです。

ε-greedy 方策: 非常にシンプルなアルゴリズムのため、計算量は少ないです。

学習初期の効率

UCB 方策: 探索ボーナスを考慮するため、学習初期はより多くの行動を試すことができ、新しい情報収集に効率的です。

ε-greedy 方策: ε が大きすぎると探索が多くなり、学習が遅れることも。ε が小さすぎると探索が不十分になり、局所解に陥る可能性があります。ε の設定が難しく、学習初期の効率が不安定になりがちです。

学習後期の安定性

UCB 方策: 探索ボーナスが小さくなり、学習後は徐々に利用に寄せていきます。

ε-greedy 方策: ε を下げても、一定の確率でランダムな行動を選択し続けるため、学習後も探索が混ざることがあります。

マルコフ性 (Markov Property)

特徴: 現在の状態が過去の履歴に依存せず、将来の状態とのみ関係がある性質。

目的: 状態の遷移と意思決定を単純化し、計算の複雑性を減少させる。

説明: マルコフ性を持つシステムでは、現在の状態のみが未来の状態を決定するため、過去の状態について考慮する必要がありません。これは特にマルコフ決定過程モデルで重要です。

状態価値関数 (State Value Function)

特徴: ある状態から開始して特定の方策に従った場合の、期待される累積報酬を示す関数。

目的: 状態の価値を評価し、最適な方策決定に役立てる。

説明: 状態価値関数は、その状態がどれだけ「良い」か、つまりその状態から始めてどれだけの報酬を得られるかを示します。これは方策の評価や改善に用いられます。

行動価値関数 (Action Value Function), Q値

特徴: ある状態で特定の行動を取った際の、期待される累積報酬を示す関数。

目的: 各行動の価値を評価し、最適な行動選択に役立てる。

説明: 行動価値関数またはQ値は、特定の状態で取りうる各行動の価値を数値化します。これにより、どの行動が最も有益かを判断できます。

Q学習 (Q-learning)

特徴: オフポリシー学習アルゴリズムの一種で、行動価値関数を更新しながら最適な方策を学習する。

目的: 最適な方策を方策外から学習し、環境に依存しない汎用的な学習を実現する。

説明: Q学習では、エージェントが行動を選択し、その結果として得られる報酬と次の状態に基づいてQ値を更新します。このプロセスは、最適な方策を導き出すために繰り返されます。

DQNとQ学習の比較:詳細

DQNとQ学習は、どちらも強化学習における重要なアルゴリズムですが、それぞれ異なる特徴を持ち、長所と短所があります。

DQNの利点

複雑な状態空間や高次元な問題に対応可能: ニューラルネットワークを用いることで、より複雑な状態空間や高次元な問題にも対応することができます。これは、従来のQ学習では困難だった問題を解くことを可能にします。

学習速度の向上: 経験リプレイを用いることで、学習効率が向上し、より短時間で学習することができます。

柔軟性の高さ: ニューラルネットワークのアーキテクチャを変更することで、様々なタスクに適用することができます。

DQNの課題

計算量の増加: ニューラルネットワークを用いるため、Q学習よりも計算量が多くなります。

ハイパーパラメータの調整: ニューラルネットワークには多くのハイパーパラメータが存在し、適切な値を設定することが重要です。

過学習: 十分なデータがない場合、過学習を起こしやすくなります。

Q学習の利点

シンプルなアルゴリズム: Q学習は、比較的シンプルなアルゴリズムであり、実装しやすいという利点があります。

オフライン学習可能: Q学習は、オンライン学習だけでなくオフライン学習にも適用することができます。これは、シミュレーション環境などで学習できることを意味します。

解釈性: Q値を直接確認することで、エージェントの行動を理解しやすいという利点があります。

Q学習の課題

探索と活用: エージェントは、新しい行動を試す探索と、既知の最適な行動を選択する活用のバランスを取る必要があります。

収束: エージェントが常に最適な行動を選択できるよう、Q値が適切に収束する必要があります。

次元性の呪い: 状態空間の次元が高い場合、Q値を学習することが困難になります。

DQNとQ学習の選び方

DQNとQ学習のどちらを選ぶべきかは、問題の性質によって異なります。

複雑な状態空間や高次元な問題の場合は、DQNの方が適しています。

シンプルな問題や、計算量を制限したい場合は、Q学習の方が適しています。

オフライン学習が必要な場合は、Q学習を選択する必要があります。

REINFORCE (Monte Carlo Policy Gradient)

特徴: 方策ベースの強化学習アルゴリズムで、完全なエピソードの報酬を用いて方策を直接更新する。

目的: 方策のパラメータを最適化し、期待される報酬を最大化する。

説明: REINFORCEは、エピソードが完了するごとに得られる報酬を使用して方策のパラメータを調整し、長期的に最も報酬が大きい行動を選択するように学習します。

方策勾配法 (Policy Gradient Methods)

特徴: 方策を直接パラメータ化し、期待される報酬を最大化する方向に方策パラメータを勾配上昇法で更新する。

目的: より一般的な問題設定での学習を可能にし、連続的な行動空間にも適用可能。

説明: 方策勾配法は、方策の確率的な性質を利用して探索と活用のバランスをとりながら、最適な行動選択戦略を学習します。

方策勾配法:詳細解説

方策勾配法は、強化学習における代表的な学習アルゴリズムの一つであり、エージェントの方策を直接更新することで報酬を最大化する手法です。従来のQ学習やSARSAなどの価値関数ベースのアルゴリズムとは異なり、方策を直接パラメータ化し、勾配法を用いて最適な方策を探索します。

方策勾配法の具体的な手順は以下の通りです。

1. 方策のパラメータ化

まず、エージェントの方策をパラメータで表現します。代表的なパラメータ化方法として、ソフトマックス関数やガウス分布などが用いられます。

2. 勾配の計算

次に、現在の方策における期待報酬の勾度を計算します。勾配は、報酬を最大化する方向を示します。

3. 方策のパラメータ更新

最後に、計算された勾配に基づいて、方策のパラメータを更新します。パラメータ更新には、勾配降下法やAdamなどの最適化アルゴリズムを用います。

4. 繰り返し

1から3までの手順を繰り返し行うことで、方策を改善し、より多くの報酬を得られるようにしていきます。

方策勾配法の特徴

直接的な方策更新: 方策を直接更新することで、探索と活用のバランスを調整しやすくなります。

柔軟な表現: 方策をパラメータで表現することで、様々な種類の行動を表現することができます。

モデルフリー学習: 環境モデルを必要としないモデルフリー学習であり、未知の環境でも学習することができます。

方策勾配法の課題

サンプル効率: 多くの経験が必要となるため、学習に時間がかかる

局所解: 必ずしも最適な解を見つけられない可能性がある

ハイパーパラメータ: 適切なハイパーパラメータを設定することが重要

Actor-Critic

特徴: 方策勾配法と価値関数アプローチを組み合わせた強化学習アルゴリズム。

目的: 方策(Actor)と価値関数(Critic)の双方を同時に学習し、より効率的な学習を実現する。

説明: Actor-Criticアルゴリズムでは、Actorが行動を決定し、Criticがその行動の価値を評価します。このフィードバックにより、Actorはより良い方策を学習し、Criticはより正確な価値予測を行います。

A3C (Asynchronous Advantage Actor-Critic)

特徴: 複数のエージェントが非同期に環境と相互作用しながら学習を進めるActor-Criticの一形態。

目的: 複数のエージェントが異なる経験を同時に学習することで、学習プロセスを加速し効率を向上させる。

説明: A3Cでは各エージェントが独立して行動価値を学習し、定期的にグローバルネットワークにその学習結果を統合します。これにより、学習が安定し、速度も向上します。

学習目標:学習されたモデルの精度の評価方法と評価指標を理解する

学習項目:正解率・適合率・再現率・F 値、ROC 曲線と AUC、モデルの解釈、モデルの選択と情報量

交差検証 (Cross-validation)

特徴: データセットを複数の部分に分割し、一部を訓練データとして、残りをテストデータとして使用するプロセスを繰り返す。

目的: モデルの汎化能力を評価し、過学習を防ぐ。

説明: 交差検証では、データセット全体を効率的に使用し、各サブセットでモデルを試すことで、異なるデータに対するモデルの性能を確認します。交差検証法(Cross-Validation)は、機械学習モデルの性能評価と選定において広く使用される手法です。この方法は、データの一部を訓練用に、別の一部をテスト用に分割することを繰り返し、モデルの学習と評価を複数回実施します。このプロセスを通じて、モデルが未知のデータに対してどの程度うまく一般化できるかを評価することができます。

交差検証の主な特徴

一般化能力の向上:

交差検証は、データセット全体を使用してモデルの一般化能力を評価します。これにより、特定のサンプルに過剰適合するリスクを減少させることができます。

効率的なデータ利用:

全データを訓練と評価に利用するため、データの限られた状況でも効率的にモデルの性能を検証できます。特にデータ量が少ない場合に有効です。

異なるバリエーション:

交差検証にはいくつかの異なる形式があり、代表的なものにk-分割交差検証(k-fold cross-validation)、層化k-分割交差検証(stratified k-fold cross-validation)、そしてリーブ・ワン・アウト(leave-one-out)があります。

交差検証のタイプ

k-分割交差検証:

データセットをk個の部分に分割し、そのうちの一つをテストデータとして使用し、残りの ( k-1 ) 個でモデルを訓練します。このプロセスをk回繰り返し、それぞれ異なる部分をテストデータとして使用します。

層化k-分割交差検証:

分類問題において、各クラスのサンプルが均等に分布するようにデータセットを分割します。これにより、クラス間での偏りを防ぎながらモデルを評価することができます。

リーブ・ワン・アウト:

この方法では、データセットの各サンプルが一度はテストデータとして使用されます。データセットから一つのサンプルを抜き出してテスト用に使用し、残りのデータでモデルを訓練します。データポイントが少ない場合に特に有効ですが、計算コストが非常に高いです。

応用

交差検証は、モデルのパラメータをチューニングする際にも非常に有効です。例えば、異なるハイパーパラメータのセットを試して、最も高い検証スコアを持つパラメータを選択します。これにより、モデルの過剰適合を避け、実際の運用環境でより良いパフォーマンスを発揮するモデルを得ることができます。

ホールドアウト検証 (Holdout Validation)

特徴: データセットを一定の比率で訓練データとテストデータに分割する。

目的: モデルの性能をシンプルに評価する。

説明: ホールドアウト検証は、データの一部を完全に分離してテストに使用することで、訓練中にモデルが見ていないデータに対する性能を評価します。

k-分割交差検証 (k-Fold Cross-validation)

特徴: データセットをk個のサブセットに分割し、交替でテストセットとして使用する。

目的: データのランダムなサブセットに対するモデルの性能を評価し、より信頼性の高い性能評価を提供する。

説明: k-分割交差検証は、データ全体が均等に評価に使用されるため、単一のホールドアウトセットを使用するよりも一般的に信頼性が高いです。

混同行列 (Confusion Matrix)

特徴: 実際のクラスと予測クラスの関係を表す行列。

目的: 分類モデルの性能を詳細に理解し、正解、偽陽性、偽陰性、真陰性を識別する。

説明: 混同行列は、分類問題において、モデルがどのクラスをどれだけ正確に予測できているか、また誤分類の種類を明確にします。

混同行列(Confusion Matrix)は、分類問題においてモデルのパフォーマンスを評価するためのツールです。この行列は、実際のカテゴリーと予測カテゴリーの組み合わせに基づいて、モデルがどのように動作しているかを視覚的に表現します。混合行列は特に二値分類問題において一般的で、以下のような情報を提供します。

混合行列から、以下の指標を算出することができます。

正解率: (TP+TN / 全体) * 100

再現率: (TP / 実際の陽性) * 100

適合率: (TP / 予測の陽性) * 100

F1スコア: (2 * 再現率 * 適合率) / (再現率 + 適合率)

特異度: (真陰性 / 実際の陰性) * 100

混同行列を使用するメリット

モデルの正確性の評価:

正確さ(Accuracy)や感度(Sensitivity / Recall)、特異性(Specificity)、適合率(Precision)など、分類モデルのパフォーマンスを評価するためのさまざまな指標を導出できます。

エラーのタイプの理解:

モデルがどのタイプのエラー(偽陽性または偽陰性)を多く生じているかを明らかにし、特定のアプリケーションにおいてそのバランスを取るための改善策を講じることができます。

クラスの不均衡の影響の評価:

データセットにおいて一部のクラスが過少表現されている場合の影響を評価し、それに対処する戦略を立てるのに役立ちます。

混同行列は、特に医療分野の診断テスト、スパムメールのフィルタリング、金融詐欺の検出など、誤分類のコストが高い場面でその真価を発揮します。モデルの改善点を明確にし、さらに精度の高いモデルへと改良を加えるための基礎データとして非常に有効です。

混同行列(Confusion Matrix)は、分類問題における予測の正確さを評価するための表です。この表は、予測結果と実際のカテゴリーがどのように一致しているか(または一致していないか)を示します。主に二値分類問題において使用されることが多いですが、多クラス分類においても応用されます。

混同行列の要素

混合行列は以下の4つの基本要素から構成されます。

真陽性(True Positive, TP):

実際に「陽性」であるデータを正しく「陽性」と予測した件数です。この値が高いほど、陽性のデータを見逃さずに捉える能力が高いことを示します。

真陰性(True Negative, TN):

実際に「陰性」であるデータを正しく「陰性」と予測した件数です。この値が高いほど、陰性のデータを正確に識別できることを示します。

偽陽性(False Positive, FP):

実際には「陰性」であるデータを誤って「陽性」と予測した件数です。これは「タイプIエラー」とも呼ばれます。

偽陰性(False Negative, FN):

実際には「陽性」であるデータを誤って「陰性」と予測した件数です。これは「タイプIIエラー」とも呼ばれます。

F値(F-scoreまたはF1スコア)

F値(F-scoreまたはF1スコア)は、分類モデルの性能を評価するために用いられる指標です。このスコアは、適合率(Precision)と再現率(Recall)の調和平均として計算されます。適合率はモデルが正と予測したケースの中で実際に正であるケースの割合を示し、再現率は実際に正であるケースの中でモデルが正と予測したケースの割合を示します。F値はこれら二つの指標をバランスよく考慮するために設計されており、一方が高くても他方が低い場合には全体のスコアが低くなるようになっています。

・Precision(適合率) は、正と予測されたデータのうち実際に正である割合を表します。これは正確な予測の重要性を示す指標です。

Recall(再現率) は、実際に正であるデータのうち、モデルが正と予測した割合を表します。これは全ての正のケースを捉える能力を示す指標です。

F値の利点

バランスの取れた評価:

F値は適合率と再現率のバランスを取ることに重点を置いています。そのため、どちらか一方だけが非常に高い値を示しても、もう一方が低い場合はF値全体としては低くなります。これにより、モデルが一方の指標に偏ることなく、全体的にバランスの取れた性能を持つかを評価できます。

異なるモデルの比較:

異なるモデルやアプローチを公平に比較するための一つの指標として利用できます。特に、クラスの不均衡が存在する場合や、誤分類のコストが異なる場合に有効です。

F値の制限

適用状況の選択:

F値は適合率と再現率の調和平均を取るため、どちらかが極端に低い場合には低い評価を受けます。したがって、特定の状況では適合率または再現率のどちらか一方が重要である場合、F値ではそのニュアンスを捉えることができないことがあります。

クラスごとの性能評価の欠如:

F値は二値分類問題においてよく用いられますが、多クラス問題においてはそれぞれのクラスに対して個別にF値を計算し、平均を取るなどの追加の処理が必要になる場合があります。

過学習 (Overfitting)

特徴: モデルが訓練データに対して過度に最適化され、未知のデータに対して性能が低下する現象。

目的: 訓練データのノイズや非代表的な特徴にモデルが適応しないようにする。

説明: 過学習は、モデルが訓練データの詳細を「覚える」ことで起こり、新しいデータに対する予測が不正確になります。これを防ぐためには正則化技術などが用いられます。

過学習が起こった場合の予測値と誤差の変化

過学習が起こると、**モデルは訓練データに対しては高い精度を達成するものの、テストデータ(学習に使用していないデータ)に対しては精度が低くなるという現象が発生します。これは、モデルが訓練データのノイズや個々の特徴を過剰に学習し、一般化能力が低下してしまうためです。

過学習が起こりやすい状況を一覧

モデルが過度に複雑

ニューラルネットワークの層が多すぎる

パラメータ数が多すぎる

特徴量が多すぎる

トレーニングデータが不足している

サンプル数が少ない

データの多様性が乏しい

データにノイズが多い

ラベル付けの誤りがある

外れ値が多い

正則化が不足している

L1/L2正則化の強さが弱い

ドロップアウトが不適切

バッチ正規化を使っていない

学習が過度に進んだ

学習エポック数が多すぎる

早期停止していない

学習率が不適切

初期学習率が高すぎる

減衰スケジュールが適切でない

訓練とテストの分布が異なる

ドメインシフトやデータシフトがある

ハードコーディングしている

特殊なケースを想定している

目的関数がデータに合っていない

損失関数が適切でない

モデルの自由度が高すぎる

カーネルトリック等で高次元化しすぎている

これらの要因が単独または複合して影響することで過学習が引き起こされやすくなります。データとモデルの特性に合わせて適切な対策を行う必要があります。

未学習 (Underfitting)

特徴: モデルが訓練データのパターンを十分に学習しておらず、訓練データおよび新しいデータに対しても性能が低い状態。

目的: モデルの複雑さを増やすことで、データの基本的なパターンを捉える能力を向上させる。

説明: 未学習は、モデルが単純すぎるために発生し、訓練データの特性を適切に表現できていない状態を指します。モデルの複雑度を高めることで解決可能です。

正則化 (Regularization)

特徴: モデルの複雑さにペナルティを与える手法。

目的: 過学習を防ぎ、モデルの汎化性能を向上させる。

説明: 正則化は、モデルの重みに対して制約を加えることで、その複雑さを制限します。例えば、L1、L2正則化は重みを制限することでモデルがデータの本質的な特徴だけを学習するのを助けます。

正則化の概要

正則化は機械学習において過学習を防ぐための重要な手法です。

過学習とは、モデルがトレーニングデータに過度に適合してしまい、一般化性能が低下してしまうことを指します。

正則化は、損失関数に罰則項を追加することで、モデルの複雑さを制限し、過学習を防ぐことができます。

正則化の種類

主な正則化手法には以下のようなものがあります:

L1正則化(ラッソ正則化):

重みパラメータの絶対値の和を損失関数に追加する手法

重みパラメータを0に近づけ、スパース性を高める

L2正則化(リッジ正則化):

重みパラメータの二乗和を損失関数に追加する手法

重みパラメータの大きさを抑制する

Elastic Net正則化:

L1正則化とL2正則化を組み合わせた手法

L1正則化とL2正則化のバランスを調整できる

これらの正則化手法により、過学習を防ぎ、一般化性能の高いモデルを構築することができます。

正則化の効果

正則化を適用することで、モデルの複雑さを制限し、過学習を防ぐことができます。

これにより、トレーニングデータに対する適合性は下がりますが、テストデータに対する一般化性能が向上します。

適切な正則化手法と強さを選択することで、バリアンスとバイアスのバランスを取ることができ、高精度なモデルを構築できます

L0正則化、L1正則化、L2正則化

特徴: L0正則化は非ゼロのパラメータの数を最小化し、L1正則化はパラメータの絶対値の和を最小化し(ラッソ回帰)、L2正則化はパラメータの二乗和を最小化します(リッジ回帰)。

目的: モデルの過学習を防ぐため、特にL1はスパースソリューションを促進し、L2はパラメータ値を小さく抑える。

説明: L1正則化は不要なパラメータをゼロにする効果があるため、特徴選択に役立ちます。L2正則化はパラメータの値を小さくすることでモデルの過学習を防ぎ、より滑らかなモデル予測を促します。

L1正則化とマンハッタン距離の関係

L1正則化とマンハッタン距離は、以下の2つの点で深く関係しています。

幾何的な解釈: L1正則化は、モデルのパラメータ空間におけるL1距離を最小化する問題として解釈することができます。L1距離とは、2つの点間の座標の絶対値の差の和を意味します。つまり、L1正則化は、パラメータ空間における原点に近いほど小さいL1距離を持つモデルを選択することになります。これは、パラメータの値を0に近いほど小さいモデルを選択することと同じ意味です。

特徴量選択: L1正則化は、重要度の低い特徴量のパラメータの値が0になりやすくなります。これは、L1距離の意味から考えると、原点から最も遠い特徴量が排除されることになります。つまり、L1正則化は、距離という概念を利用して、重要度の低い特徴量を自動的に選択することができるのです。

L2正則化とユークリッド距離の関係

L2正則化とユークリッド距離は、以下の2つの点で深く関係しています。

幾何的な解釈: L2正則化は、モデルのパラメータ空間におけるL2距離を最小化する問題として解釈することができます。L2距離とは、2つの点間の座標の2乗の差の和の平方根を意味します。つまり、L2正則化は、パラメータ空間における原点に近いほど小さいL2距離を持つモデルを選択することになります。これは、パラメータの値を全体的に小さくするモデルを選択することと同じ意味です。

過学習の防止: L2正則化は、モデルの複雑さを制御することで、過学習を防ぎます。過学習とは、モデルが訓練データに過剰に適応してしまう現象です。L2正則化によって、パラメータの値が小さくなることで、モデルが訓練データに依存しすぎないように抑制することができます。

LIME (Local Interpretable Model-agnostic Explanations)

特徴: 個々の予測に対して局所的な説明を提供するモデル解釈手法。

個々の予測に対して局所的な説明を提供します。

元のモデルの予測周辺で線形モデル(などの単純なモデル)を学習させ、その予測の解釈を試みます。

モデルに依存しない方法であり、複雑なモデルの予測を近似することで理解を助けます。

目的: 複雑なモデルの予測を理解しやすくする。

説明: LIMEは、特定の予測周辺のデータを使って単純なモデルを訓練し、どの特徴が予測に最も影響を与えたかを示します。これにより、複雑なモデルの決定を人間が解釈しやすくなります。

SHAP (SHapley Additive exPlanations)

特徴: ゲーム理論に基づいたモデル予測の解釈を提供する手法。

ゲーム理論に基づいたアプローチで、各特徴が予測にどのように貢献するかを定量的に評価します。

各特徴の影響度をシャプリー値として算出し、モデルの予測に対する各入力特徴の寄与を明らかにします。

モデルに依存しないため、任意の機械学習モデルに適用可能です。

目的: モデルの予測に対する各特徴の貢献度を定量的に評価する。

説明: SHAP値は、ある特徴がモデルの予測にどのように影響を与えるかを示し、モデルの予測全体に対する各特徴の公平な貢献を計算します。

オッカムの剃刀 (Occam's Razor)

特徴: 等しく予測可能な複数の仮説がある場合、最も単純な仮説を選択すべきであるという原則。

目的: 不必要な複雑さを避け、より単純で理解しやすい解釈を提供する。

説明: オッカムの剃刀は、科学的な仮説形成やモデル選択において、不必要な仮定を排除するための指針として使用されます。より単純なモデルは、しばしばより高い汎化性能を持ちます。

オッカムの剃刀とスパースモデリング手法

オッカムの剃刀は、14世紀の神学者ウィリアム・オブ・オッカムによって提唱された考え方です。これは、「事柄を説明するには必要以上に多くのものを仮定すべきではない」という原則を意味します。

スパースモデリング手法は、このオッカムの剃刀の考え方に基づいています。スパースモデリング手法は、データから最も重要な特徴のみを選び出し、その特徴に基づいてモデルを構築する手法です。これは、モデルをできるだけシンプルにし、複雑な仮定を避けるというオッカムの剃刀の精神に則っています。

スパースモデリング手法を用いることで、以下の利点があります。

モデルの解釈性向上: スパースモデルは、複雑なモデルよりも解釈しやすいという特徴があります。これは、モデルがどのような特徴に基づいて予測を行っているのかを理解しやすいためです。

過学習の抑制: スパースモデルは、過学習を起こしにくいという特徴があります。これは、モデルがデータのノイズではなく、真の特徴を学習するためです。

計算コストの削減: スパースモデルは、複雑なモデルよりも計算コストが低くなります。これは、モデルのパラメータ数が少ないためです。

スパースモデリング手法の例

スパースモデリング手法には、様々な種類があります。代表的な例としては、以下のようなものがあります。

LASSO回帰: LASSO回帰は、L1正則化を用いてモデルのパラメータを制限する手法です。L1正則化は、各パラメータの絶対値の和を最小化するようにモデルを学習します。これにより、多くのパラメータが0になり、スパースなモデルが得られます。

Ridge回帰: Ridge回帰は、L2正則化を用いてモデルのパラメータを制限する手法です。L2正則化は、各パラメータの二乗和を最小化するようにモデルを学習します。これにより、すべてのパラメータが小さくなり、スパースなモデルが得られます。

Elastic Net: Elastic Netは、L1正則化とL2正則化を組み合わせた手法です。Elastic Netは、LASSO回帰よりも多くの特徴を選択することができ、Ridge回帰よりも解釈しやすいモデルを得ることができます。

スパースモデリング手法の応用例

スパースモデリング手法は、様々な分野で応用されています。代表的な例としては、以下のようなものがあります。

画像処理: 画像圧縮、画像認識、画像分類

音声処理: 音声圧縮、音声認識、音声分類

自然言語処理: テキストマイニング、文書分類、情報検索

機械学習: 特徴量抽出、異常検知、回帰分析

まとめ

オッカムの剃刀は、スパースモデリング手法の背景にある重要な考え方です。スパースモデリング手法は、オッカムの剃刀の精神に基づいて、シンプルで解釈しやすいモデルを構築することができます。スパースモデリング手法は、様々な分野で応用されており、今後ますます重要になっていくと考えられます。

赤池情報量基準 (AIC: Akaike Information Criterion)

特徴: モデルの良さを評価するための統計的指標で、モデルの複雑さとデータへの適合度をバランスさせる。

目的: 最も良いモデルを選択する際に、適合度とモデルの複雑さのトレードオフを考慮する。

説明: AICは、モデルの適合度を示す尺度からモデルのパラメータ数に対するペナルティを引いた値です。数値が小さいほど良いモデルと評価されます。

赤池情報量基準(AIC)について

赤池情報量基準(AIC)は、統計モデルの適合度を評価するための指標です。値が小さいほどモデルの当てはまりが良いとされ、モデルの予測性能と複雑さのバランスを考慮しています。

赤池情報量基準(AIC)の概要

定義: AICは、モデルの予測性能を評価するための統計量で、残差を用いて計算されます。値が小さいほど、モデルの当てはまりが良いとされます。

計算方法: AICは、モデルの複雑さ(パラメータの数)とデータへの当てはまりの良さ(尤度)を考慮して計算されます。具体的には、

AIC = -2 (最大対数尤度 - パラメータの数) で表されます。AIC = 2k - 2ln(L)

AICの応用

モデル選択: AICは、複数の統計モデルの中から最適なモデルを選択する際に用いられます。モデルの複雑さとデータへの当てはまりの良さのバランスを考慮することで、過学習を避けつつ、適切なモデルを選択することができます。

赤池情報量基準(AIC)は、統計モデルの適合度を評価し、複数のモデルの中から最適なものを選択するための重要な指標です。モデルの予測性能と複雑さのバランスを考慮することで、より信頼性の高い統計分析を行うことが可能になります。

説明変数選択と AIC

説明変数選択において、AICは以下のように用いられます。

すべての説明変数を用いたモデルを構築する

順次、説明変数を1つずつ削除し、AICを計算する

AICが最小になるまで、説明変数を削除していく

この手順により、過学習と欠学習のバランスが良く、モデルが良いと評価される説明変数の組み合わせを選択することができます。

汎化誤差 (Generalization Error)

特徴: モデルが新しい、未見のデータに対してどの程度うまく機能するかを示す誤差。

目的: モデルの実世界での性能を推定し、その信頼性を評価する。

説明: 汎化誤差は、モデルが訓練データセット以外のデータにどれだけ適応できるかを測る指標であり、低い汎化誤差はモデルが未知のデータにもうまく対応できることを意味します。

学習率 (Learning Rate)

特徴: 機械学習アルゴリズムにおいて、各ステップでモデルのパラメータがどれだけ更新されるかを制御するパラメータ。

目的: 学習プロセスの速度と安定性を調整し、適切な収束を促す。

説明: 学習率が高すぎると学習過程で振動または発散するリスクがあり、低すぎると学習が遅くなり、最適な解に収束しない可能性があります。

学習率が大きい場合と小さい場合の特徴

学習率は、機械学習において、モデルのパラメータを更新する際のステップ幅を表す値です。

学習率が大きすぎると、以下のような問題が発生する可能性があります。

パラメータが最適解を飛び越えてしまう: 学習率が大きすぎると、パラメータの更新幅が大きくなり、最適解を飛び越えてしまう可能性があります。

振動が発生する: 学習率が大きすぎると、パラメータの更新方向が大きく変化し、振動が発生する可能性があります。

訓練が不安定になる: 学習率が大きすぎると、訓練が不安定になり、収束しにくくなる可能性があります。(発散する)

一方、学習率が小さすぎると、以下のような問題が発生する可能性があります。

学習が遅くなる: 学習率が小さすぎると、パラメータの更新幅が小さくなり、学習が遅くなります。

局所解に陥る: 学習率が小さすぎると、局所解に陥る可能性が高くなります。

十分な精度が得られない: 学習率が小さすぎると、十分な精度が得られない可能性があります。

一般的には、学習率を最初は大きめに設定し、訓練が進むにつれて徐々に小さくしていくのが一般的です。

これは、初期段階ではパラメータを素早く更新し、ある程度最適解に近づけた後、より精密な調整を行うためです。

具体的な学習率の設定値は、データセットやモデルによって異なるため、試行錯誤しながら最適な値を見つける必要があります。

学習率を調整する際のヒント

学習曲線を監視する: 学習曲線を監視することで、学習率が適切かどうかを確認することができます。

検証データセットを用いる: 検証データセットを用いることで、学習率が過学習を引き起こしていないかどうかを確認することができます。

異なる学習率を試してみる: 異なる学習率を試してみることで、最適な値を見つけることができます。

学習率スケジューリングを用いる: 学習率スケジューリングを用いることで、訓練が進むにつれて学習率を自動的に調整することができます。

まとめ

学習率は、機械学習において重要なハイパーパラメータの一つです。

学習率を適切に設定することで、より良いモデルを学習することができます

誤差関数 (損失関数)(Error Function)

特徴: モデルの予測が実際の値からどれだけ離れているかを定量化する関数。

目的: モデルの訓練中に最小化を目指すことで、最適なパラメータを見つける。

説明: 誤差関数(または損失関数)は、モデルがどれだけ「間違っている」かを示す指標であり、訓練中にこの値を最小化することでモデルの精度を向上させます。

代表的な誤差関数

機械学習には様々な誤差関数がありますが、代表的なものは以下の3つです。平均二乗誤差 (MSE): 予測値と正解値の二乗差の平均を計算します。最もシンプルな誤差関数の一つであり、回帰タスクによく用いられます。

平均絶対誤差 (MAE): 予測値と正解値の絶対差の平均を計算します。外れ値の影響を受けにくいという特徴があります。

交差エントロピー誤差: 確率的な分類タスクにおいて用いられる誤差関数です。予測された確率分布と正解の確率分布間の情報量に基づいて誤差を計算します。

誤差関数の選び方

誤差関数は、学習タスクやデータによって適切なものが異なります。回帰タスク: 平均二乗誤差 (MSE) や平均絶対誤差 (MAE) がよく用いられます。

分類タスク: 交差エントロピー誤差がよく用いられます。

外れ値の影響が大きい場合: 平均絶対誤差 (MAE) が適しています。

ディープラーニングの概要

学習目標:ディープラーニングを理解する上で押さえておくべき事柄を理解する。

単純パーセプトロン (Simple Perceptron)

特徴: 最も基本的な形のニューラルネットワークで、単一のニューロンから成る。

目的: 線形分離可能なデータセットに対する分類問題を解く。

説明: 単純パーセプトロンは、入力に重みを掛け、合計がある閾値を超えた場合に1を出力し、超えない場合には0を出力します。このモデルは基本的なバイナリ分類タスクに利用され、その学習規則は線形分離可能なパターンを学習するのに適しています。

多層パーセプトロン (Multilayer Perceptron, MLP)

特徴: 複数の層を持ち、少なくとも一つの隠れ層を含むニューラルネットワーク。

目的: 非線形問題を解く能力を持ち、より複雑な関数を近似する。

説明: 多層パーセプトロンは、入力層、一つまたは複数の隠れ層、および出力層から成り立ちます。各層のニューロンは前の層の全ニューロンと接続されており、非線形活性化関数を使用することで複雑なデータパターンを学習できます。

ディープラーニングとは

特徴: 多層のニューラルネットワークを使用して、大量のデータから複雑な特徴を自動で学習する技術。

目的: 画像認識、自然言語処理、音声認識など、多岐にわたるタスクで人間に近い、またはそれを超える性能を達成する。

説明: ディープラーニングは、データから自動的に高度な特徴を抽出する能力を持っており、特に大量のデータが利用できる場合に強力なパフォーマンスを発揮します。これにより、事前に特徴を手動で設計する必要がなくなります。

勾配消失問題 (Vanishing Gradient Problem)

特徴: ネットワークが深くなるにつれて、誤差逆伝播時に勾配が急速に小さくなり、入力層に近い層の学習が進まなくなる問題。

目的: ニューラルネットワークの効果的な訓練を妨げるこの問題を克服する。

説明: 勾配消失は、特に深いネットワークで顕著であり、勾配が非常に小さくなるため、重みの更新がほとんどまたは全く行われなくなります。これを解決するために、ReLU活性化関数や、より効果的な重み初期化方法などが導入されています。

信用割当問題 (Credit Assignment Problem)

特徴: 強化学習において、どの行動が最終的な報酬にどのように貢献したかを判断するのが難しい問題。

目的: エージェントがどの行動が良い結果に貢献したかを正確に理解し、効果的な学習を促進する。

説明: 信用割当問題は、特に長い行動シーケンスが関与する場合に困難となります。エージェントが適切な行動に適切な「信用」を割り当てることができれば、より効果的に学習し、最適な方策を見つけることができます。

信用割当問題の解決手法

誤差逆伝播法の改善:

誤差逆伝播法では、出力層から入力層に向けて誤差を逆伝播させることで、各ノードの重要度を評価します。

しかし、この手法では勾配消失問題などの課題があるため、改善が必要です。

深層残差学習(Deep Residual Learning)などの手法が提案されています。4

自己符号化器の活用:

自己符号化器(Autoencoder)は入力を圧縮・復元するニューラルネットワークで、

潜在変数の学習を通じて、各ノードの重要度を評価することができます。

変分自己符号化器(VAE)やベクトル量子化VAE(VQ-VAE)などの手法が提案されています。4

新しい学習アルゴリズムの開発:

誤差逆伝播法以外の新しい学習アルゴリズムの開発も進められています。

東京大学の松尾ゼミでは、誤差逆伝播法を用いない深層ニューラルネットワークの学習方法について研究が行われています。

誤差逆伝播法 (Backpropagation)

特徴: ニューラルネットワークを訓練するためのアルゴリズムで、出力からの誤差を用いて各層の重みを効率的に調整する。

目的: ネットワークの予測誤差を最小化し、最適な重みを見つける。

説明: 誤差逆伝播法は、出力層から入力層に向かって誤差を逆方向に伝播させることで、各重みを適切に更新します。この方法はディープラーニングで広く用いられ、効果的な学習プロセスを可能にします。

学習目標:ディープラーニングがどういった手法によって実現されたのかを理解する。

事前学習 (Pre-training)

特徴: ニューラルネットワークが特定のタスクの訓練を開始する前に、一般的なデータセットを使って初期の特徴を学習するプロセス。

目的: モデルがより関連性の高い特徴を抽出し、最終タスクの性能を向上させるため。

説明: 事前学習は、ラベルのない大量のデータを利用してネットワークを訓練し、その後具体的なタスクに適用する前にファインチューニングを行います。これにより、データが限られている場合でも効果的に学習が進められます。

事前学習:ディープラーニングにおける重要な手法

事前学習は、ディープラーニングモデルを学習させる前に、大量のデータを用いてモデルを初期化する方法です。これにより、モデルは学習の開始段階からより良い性能を発揮することができ、学習時間を短縮し、過学習を防ぐことができます。

事前学習の種類

事前学習には、大きく分けて以下の2種類があります。

教師あり事前学習: ラベル付きのデータを用いてモデルを初期化します。

教師なし事前学習: ラベルなしのデータを用いてモデルを初期化します。

教師あり事前学習は、画像分類や自然言語処理などのタスクによく用いられます。教師なし事前学習は、画像生成や異常検知などのタスクによく用いられます。

事前学習の代表的な手法

事前学習の代表的な手法は以下の通りです。

ImageNet: ImageNetは、1000万以上の画像と1000種類のクラスを含む大規模な画像データセットです。ImageNetは、画像分類の事前学習によく用いられます。

BERT: BERTは、自然言語処理の事前学習によく用いられるモデルです。BERTは、Transformerと呼ばれるニューラルネットワークアーキテクチャを用いており、文章の全体的な意味を理解することができます。

ELMo: ELMoは、BERTと同様に自然言語処理の事前学習によく用いられるモデルです。ELMoは、双方向LSTMと呼ばれるニューラルネットワークアーキテクチャを用いており、文章中の単語の意味を理解することができます。

事前学習の利点

事前学習には、以下の利点があります。

学習時間の短縮: 事前学習により、モデルは学習の開始段階からより良い性能を発揮することができ、学習時間を短縮することができます。

過学習の防止: 事前学習により、モデルは学習データに過度に依存することを防ぎ、過学習を防ぐことができます。

汎化性能の向上: 事前学習により、モデルは未知のデータに対する汎化性能を向上させることができます。

事前学習の注意点

事前学習には、以下の注意点があります。

データバイアス: 事前学習データにバイアスが含まれている場合、モデルもそのバイアスを反映してしまいます。

計算コスト: 事前学習には、大量の計算コストが必要となります。

転移学習: 事前学習モデルを異なるタスクに適用する際には、転移学習と呼ばれる手法を用いてモデルを微調整する必要があります。

まとめ

事前学習は、ディープラーニングにおける重要な手法であり、学習時間の短縮、過学習の防止、汎化性能の向上などの利点があります。しかし、データバイアス、計算コスト、転移学習などの注意点も理解する必要があります。

ファインチューニング (Fine-tuning)

特徴: 事前学習済みのモデルに対して、特定のタスクのデータを使って追加の訓練を行うプロセス。

目的: 事前学習で獲得した知識を活用しつつ、特定のタスクに最適化することでモデルの性能を最大化するため。

説明: 事前学習済みのネットワークを特定のタスクに再適用する際、ファインチューニングを行うことで、既存の知識を保持しつつ新しいデータに適応させ、より精度の高い予測を実現します。

ファインチューニング:詳細解説

ファインチューニングは、機械学習における重要な手法の一つであり、事前学習済みモデルを特定のタスクに特化させるために微調整を行う手法です。

ファインチューニングの仕組み

ファインチューニングは、以下の手順で行われます。

事前学習済みモデルの選択: 汎用的なタスクで学習済みのモデルを選択します。

モデルの調整: 選択したモデルの最後の層を削除し、新しい層を追加します。

微調整: 新しい層と既存のモデルのパラメータを、特定のタスクのデータを用いて微調整します。

ファインチューニングの利点

ファインチューニングには、以下の利点があります。

学習効率の向上: ゼロからモデルを学習するよりも、事前学習済みモデルをベースにすることで、学習効率を大幅に向上させることができます。

少ないデータでの学習: 少量しかデータがない場合でも、事前学習済みモデルをベースにすることで、モデルを学習することができます。

高い精度: 適切なファインチューニングを行うことで、高い精度を実現することができます。

ファインチューニングの課題

ファインチューニングには、以下の課題があります。

過学習: 訓練データに過度に適応し、訓練データ以外のデータに対して良い精度を出せない状態になる可能性があります。

データ量: ファインチューニングには、ある程度の量のデータが必要です。データ量が少ない場合、十分な精度が得られない可能性があります。

計算量: 複雑なモデルの場合、ファインチューニングに時間がかかることがあります。

ファインチューニングの応用例

ファインチューニングは、画像認識、自然言語処理、音声認識など、様々な分野で応用されています。

画像認識: 画像分類、オブジェクト検出、セマンティックセグメンテーションなど

自然言語処理: 機械翻訳、文書分類、感情分析など

音声認識: 音声認識、音声合成、音声翻訳など

ファインチューニングの注意点

ファインチューニングを行う際には、以下の点に注意する必要があります。

適切な事前学習済みモデルを選択: タスクに適した事前学習済みモデルを選択することが重要です。

過学習を防ぐ: 過学習を防ぐために、検証データを用いてモデルの精度を評価し、必要に応じて正則化などの手法を用いる必要があります。

データ量: ファインチューニングには、ある程度の量のデータが必要です。データ量が少ない場合、十分な精度が得られない可能性があります。

まとめ

ファインチューニングは、機械学習において強力な手法であり、学習効率の向上、少ないデータでの学習、高い精度の達成など、様々な利点があります。しかし、過学習、データ量、計算量などの課題も存在するため、注意して利用する必要があります。

深層信念ネットワーク (Deep Belief Network, DBN)

特徴: 複数の制限付きボルツマンマシン (RBM) またはその他の確率的グラフィカルモデルを積層して構成されるディープラーニングアーキテクチャ。深層信念ネットワーク(Deep Belief Networks, DBNs)は、2006年にジェフリー・ヒントンと彼の同僚たちによって提案されました。これは、多層の生成的確率モデルであり、特にディープラーニングの分野で重要な役割を果たしています。

多層構造: DBNsは複数の層から構成されており、各層は制限付きボルツマンマシン(RBM)またはオートエンコーダで構成されています。

事前学習と微調整: DBNsは、層ごとに事前学習を行い、その後、バックプロパゲーションによる微調整を通じて全体を最適化します。

教師なし学習(事前学習)を行って教師あり学習を行う。

この事前学習は計算コストがかかるため現在はあまり使われない。生成的モデル: DBNsは生成的モデルであり、入力データの生成分布を学習します。

目的: 複数の隠れ層を通じてデータから高度な特徴を効率的に学習し、複雑なデータ表現を実現するため。

特徴抽出: DBNsはデータから抽象的な特徴を効果的に抽出する能力を持ちます。

分類: 抽出された特徴を使用して、画像、音声、テキストなどのデータを分類します。

データ生成: 学習したモデルを使用して、新しいデータインスタンスを生成することが可能です。

説明: DBNは最初の数層を事前学習によって効率的に訓練し、その後の層に対してファインチューニングを適用することで、高度な特徴抽出とデータ表現を可能にします。これは特に画像や音声などの複雑なデータセットに有効です。

提案者 ジェフリー・ヒントン: トロント大学の教授であり、ディープラーニングの先駆者の一人。DBNsの開発に大きく貢献しました。

派生形

畳み込み深層信念ネットワーク(Convolutional Deep Belief Networks): 畳み込み層を取り入れたDBNsで、主に画像データの処理に使用されます。条件付き深層信念ネットワーク(Conditional Deep Belief Networks): 特定の条件やクラスに依存するデータ生成が可能です。

制限付きボルツマンマシン (Restricted Boltzmann Machine, RBM)

特徴: 可視層と隠れ層の二層から構成されるニューラルネットワークで、層間は完全に結合しているが、同じ層内のユニット間には接続がない。

二部グラフ構造: RBMは可視層(入力層)と隠れ層(特徴層)の2つの層から構成されており、層内のユニット間には接続がありませんが、異なる層間には接続が存在します。

エネルギーベースモデル: システムのエネルギーを定義し、低エネルギー状態が高確率で発生するように設計されています。

確率的学習と推論: 学習プロセスは、データからモデルパラメータを推定するために確率的な手法(例:コントラスティブ・ダイバージェンス)を使用します。

目的: 入力データの確率的な特徴を学習し、これをディープラーニングモデルの初期値や特徴抽出器として使用するため。

特徴抽出: 入力データから重要な特徴を学習し、データの理解を深める。

次元削減: 高次元のデータを低次元の表現に変換し、データの本質的な特性を捉えます。

生成モデル: 学習した確率分布に基づいて、新しいデータのサンプル生成を可能にします。

説明: RBMはデータの生成モデルとしても利用され、データの特徴を捉えるための重みを学習します。これらは単独で使用されることも、DBNの構成要素として使用されることもあります。

制限付きボルツマンマシン(Restricted Boltzmann Machine, RBM)は、1986年にジェフリー・ヒントンとテリー・セジノウスキーによって紹介されました。このモデルは、教師なし学習のためのエネルギーベースのニューラルネットワークであり、ディープラーニングや機械学習の分野で広く使われています。

製作者

ジェフリー・ヒントンとテリー・セジノウスキーによって開発されました。ヒントンはディープラーニングとニューラルネットワークの先駆者の一人であり、多くの重要な貢献をしています。

深層生成モデル:詳細解説

深層生成モデルは、ディープラーニングと生成モデルを組み合わせた強力なツールであり、画像、音声、テキストなどのデータを生成することができます。従来の生成モデルとは異なり、複雑なデータや現実的なデータを生成することができ、様々な分野で注目を集めています。

深層生成モデルの仕組み

深層生成モデルは、確率モデルと呼ばれる数学的なモデルを学習することで、データを生成します。確率モデルは、データの生成確率を計算することができます。深層生成モデルは、ニューラルネットワークと呼ばれる複雑な関数を使って、確率モデルを学習します。

深層生成モデルの種類

深層生成モデルには、様々な種類があります。代表的な種類は以下の通りです。

生成敵対ネットワーク (GAN): 2つのニューラルネットワークから構成されるモデルで、生成ネットワークと識別ネットワークと呼ばれる2つのネットワークが競い合いながら学習します。生成ネットワークは、偽のデータを生成し、識別ネットワークは、本物のデータと偽のデータを区別することを学習します。

変分オートエンコーダ (VAE): エンコーダとデコーダと呼ばれる2つのニューラルネットワークから構成されるモデルで、潜在変数と呼ばれる変数を用いてデータを表現します。エンコーダは、入力データを潜在変数に変換し、デコーダは、潜在変数を入力データに戻します。

オートエンコーダ: 入力データを圧縮して再構築するモデルで、特徴抽出や異常検知などに用いられます

学習目標:ディープラーニングを実現するために必要ものは何か、何故ディープラニングが実現できたかを理解する

CPU と GPU

特徴: CPU(Central Processing Unit)は一般的な計算タスクに使用されるプロセッサで、複雑なロジックや制御タスクに適しています。GPU(Graphics Processing Unit)は元々は画像処理用に設計されましたが、大量のデータに対する並列計算が得意です。

目的: ディープラーニングでは、特にGPUが重要で、その強力な並列処理能力によって大規模なニューラルネットワークの訓練が現実的な時間内に可能になります。

説明: ディープラーニングの訓練プロセスには膨大な数の行列計算が含まれるため、GPUの並列処理能力がこれを大幅に加速し、訓練時間を短縮します。CPUと比較して、GPUはこの種の計算においてはるかに効率的です。

GPGPU (General-Purpose computing on Graphics Processing Units)

特徴: GPUをグラフィックス以外の一般的な計算用途に使用する技術。

目的: GPUの計算資源を活用して、科学技術計算やデータ分析、機械学習などの分野で高速な計算を実現する。

説明: GPGPUは、GPUの強力な計算能力を利用して非グラフィックスタスクを処理し、特にディープラーニングのような計算集約的なタスクにおいて顕著な性能向上をもたらします。

ディープラーニングのデータ量

特徴: ディープラーニングモデルの訓練には、通常、大量のデータが必要です。

目的: 大量のデータを使用することで、モデルが現実世界の複雑なパターンを学習し、より正確な予測が可能になります。

説明: ディープラーニングはデータ駆動のアプローチであり、大量のデータからパターンを抽出して学習することで、モデルの汎用性と正確性が向上します。データ量が多いほど、モデルはより多様なシナリオと変動に対処できるようになります。

TPU (Tensor Processing Unit)

特徴: Googleによって開発された、特にテンソル計算と機械学習に特化したプロセッサ。

目的: ディープラーニングのような高度な機械学習タスクにおける計算効率と速度を最大化する。

説明: TPUは、特にディープラーニングモデルの訓練と推論に最適化されており、複数の計算を高速に並列実行することが可能です。TPUはGPUよりも一部のタスクで優れた性能を発揮し、特に大規模なニューラルネットワークの訓練において効果的です。

学習目標:ニューラルネットワークにおいて重要な役割をになう活性化関数を理解する

tanh 関数 (Hyperbolic Tangent Function)

特徴: 双曲線正接関数とも呼ばれ、出力範囲が-1から1の間である。

目的: ニューラルネットワークの中間層で使用され、データの正規化を助けることで学習プロセスを安定化させる。

説明: tanh 関数はシグモイド関数に似ていますが、出力が-1から1の範囲であるため、ゼロ中心であることから勾配消失の問題を緩和しやすいです。これにより、ニューラルネットワークの学習がスムーズに進みます。

ReLU 関数 (Rectified Linear Unit Function)

特徴: 入力が0を超えている場合はその入力をそのまま出力し、0以下の場合は0を出力する。

目的: 非線形性を導入しつつ、計算の単純さを保持し、効率的な学習を促進する。

説明: ReLUは現代のディープラーニングで最も広く使用される活性化関数の一つで、特に深いネットワークでの勾配消失問題を防ぐのに効果的です。そのシンプルさから、学習が早くなります。

シグモイド関数 (Sigmoid Function)

特徴: S字型の曲線を描き、出力範囲が0から1の間である。

目的: ニューラルネットワークの出力層で使用され、確率として解釈できる出力を生成する。

説明: シグモイド関数は特に二値分類問題での出力層に適しており、出力値を0から1の間の確率として解釈できるため、特定のクラスに属する確率をモデル化できます。

ソフトマックス関数 (Softmax Function)

特徴: クラスが複数ある場合に各クラスに属する確率を計算するために使用される。

目的: 多クラス分類問題の出力層で使用され、各クラスへの所属確率を出力する。

説明: ソフトマックス関数は、各クラスの指数関数的なスコアを正規化して、出力和が1になるように変換します。これにより、ニューラルネットワークの出力を直接確率分布として解釈できます。

Leaky ReLU 関数 (Leaky Rectified Linear Unit Function)

特徴: ReLU関数の変種で、入力が0以下の場合にもごく小さい値を出力する。

目的: ReLUの持つ死んだニューロンの問題を緩和し、すべてのニューロンが活動する可能性を保持する。

説明: Leaky ReLUは、入力が負の場合にも非ゼロの小さな勾配を持つことで、ニューラルネットワークがアクティブな状態を維持しやすくなり、学習中にニューロンが完全に無効化されることを防ぎます。

学習目標:ディープラーニングの学習に用いられるアルゴリズムである勾配降下法を理解する。そして勾配降下法にはどのような課題があり、どうやって解決するかを理解する

勾配降下法 (Gradient Descent)

特徴: 誤差関数の勾配(最も急な上昇方向)に基づいて、パラメータを逐次的に更新し、誤差を最小化する最適化手法。

目的: モデルのパラメータを最適化して、誤差を最小限に抑える。

説明: 勾配降下法は、誤差関数の勾配を計算し、その勾配が示す方向の反対へパラメータを少しずつ移動させることで、関数の最小値(最適解)を見つける手法です。

勾配降下法の問題と改善

特徴: 学習率の選択、局所最適解への収束、鞍点、非効率な収束速度などが主な問題点。

目的: 勾配降下法の性能と効率を向上させる。

説明: 問題に対処するため、異なる勾配降下法のバリエーション(モーメンタム、AdaGradなど)や適切な学習率の設定、ハイパーパラメータの調整が用いられます。

勾配降下法と訓練誤差

勾配降下法は、機械学習において最も基本的な最適化アルゴリズムの一つであり、損失関数を最小化することでモデルの学習を行う手法です。訓練誤差は、学習中のモデルが訓練データに対してどれほど良い精度を出せているかを表す指標です。

勾配降下法と訓練誤差の関係

勾配降下法を用いてモデルを学習させると、訓練誤差は一般的に以下のような動きをします。

初期段階: 訓練誤差は大きく、モデルの精度が低くなります。

学習進行: 勾配降下法によってモデルのパラメータが更新され、訓練誤差は徐々に小さくなります。

収束: モデルのパラメータが最適解に近づくと、訓練誤差は一定値に近づきます。

訓練誤差と過学習

訓練誤差が常に小さくなるとは限りません。モデルが訓練データに過度に適応し、訓練データ以外のデータに対して良い精度を出せない状態を過学習といいます。過学習を防ぐためには、検証データと呼ばれる別のデータセットを用いてモデルの精度を評価し、過学習が始まらないように調整する必要があります。

勾配降下法の注意点

勾配降下法は、以下の点に注意する必要があります。

学習率: 勾配降下法における学習率は、モデルのパラメータを更新する際のステップの大きさを決めます。学習率が大きすぎると、最適解を飛び越えてしまう可能性があり、小さすぎると収束が遅くなります。

局所解: 勾配降下法は、必ずしもグローバルな最適解を見つけるとは限りません。局所解に陥ってしまう可能性もあるため、注意が必要です。

まとめ

勾配降下法と訓練誤差は、機械学習において密接な関係にあります。訓練誤差を監視することで、モデルの学習状況を把握することができ、過学習などの問題を防ぐことができます。

学習率 (Learning Rate)

特徴: 勾配降下法でパラメータを更新する際のステップサイズ。

目的: 効率的かつ効果的に最適解に収束させる。

説明: 学習率が高すぎるとオーバーシュートが起こり、低すぎると収束が遅くなる。適切な学習率の設定は最適化の成功に不可欠です。

誤差関数 (Error Function)

特徴: モデルの予測が実際の値からどれだけ離れているかを示す関数。

目的: モデルの性能を評価し、最適化する基準を提供する。

説明: 誤差関数(または損失関数)は、訓練データに対するモデルの誤差を測定し、この値を最小化することでモデルの精度を向上させるための指標となります。

交差エントロピー (Cross-Entropy)

特徴: 分類問題においてよく使用される損失関数で、予測された確率分布と実際の分布との間の差異を計測する。

目的: モデルの予測が実際のカテゴリにどれだけ適合しているかを評価する。

説明: 交差エントロピーは特に多クラス分類問題で有効で、モデルが正しいクラスに高確率を割り当てるように促します。

イテレーションとエポック

特徴: イテレーションはデータセット全体またはサブセットに対する単一の更新ステップを指し、エポックは全データセットが一度完全に処理される周期を指す。

目的: モデルの訓練プロセスを定義し、進捗を監視する。

説明: 通常、複数のエポックを通じて訓練が行われ、各エポックでモデルのパフォーマンスが改善されることを目指します。イテレーションはエポックを細かく分けた単位です。

局所最適解と大域最適解

特徴: 局所最適解はある近傍で最も良い解であり、大域最適解は全域で最も良い解。

目的: 最適なモデルパラメータを見つける。