自動運転 その1

最近、AI(Artificial Intelligence、人工知能)を活用した自動運転が話題になっています。そのキーワードを記載します。

NN(Nural Network)

人間や動物の脳神経回路であるニューロンをモデルに作成。入力層・中間層・出力層の3層で構成される。中間層は1層。

ML(Machine Learning)

機械学習。データの分析や解析から特徴や規則を学習して予測する技術。特徴や規則をコンピュータに覚え込ませる必要がある。なお、統計学はデータを分析して本質を見抜くことを重視しているが、AIの機械学習は何らかの手法やアルゴリズム(Nural Networkなど)を使ってデータから予測することを重視している。

DL(Deep Learning)

深層学習。深層学習は機械学習の中の1つ。Nural Networkの中間層が複数になっているため、Deep(多層)Learningと呼ばれる。多層化することで、データの特徴をさらに深く学習することが可能。多層化により特徴や規則の抽出とモデリングを自動に行い、識別の精度をより上げている。自動運転での物体や標識などの認識で活用されている。

Transformer

米国Googleで開発されたDeep Learningのアーキテクチャ。単語を意味に基づいて数値で置き換え、単語の位置情報を考慮しながら文法を学習するモデル。

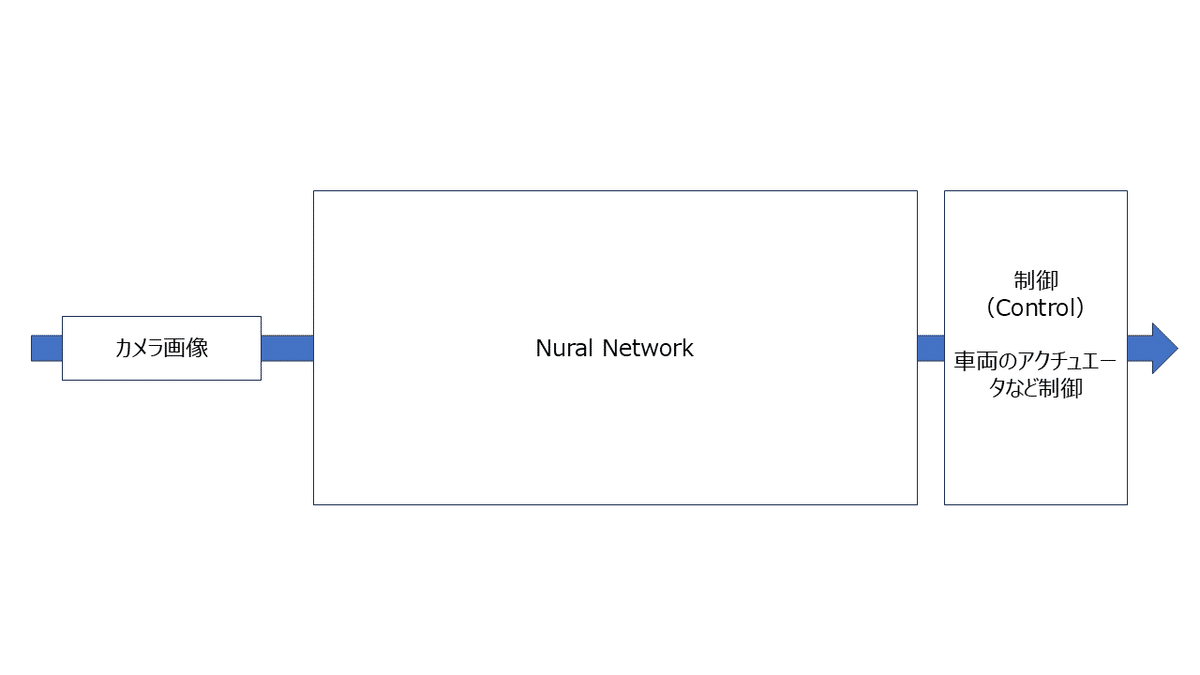

E2E(End-to-End)

従来の自動運転は、多くのソフトウェアが複雑に連動(図1)。

E2Eの自動運転は、全ての判断をMLモデルに任せるため(図2)、MLモデルとそのデータの作り込みが重要。

E2Eの自動運転の開発には、MLエンジニアに加え、大規模なデータ処理のパイプラインを構築するためのデータ基盤エンジニアも重要になる。

E2Eのメリットとして、再現性が難しいロングテール問題の解決に効果があると言われている一方で、デメリットとして、MLモデルがブラックボックスなため安全性の説明が不安視されている。

補足)23年に公開された米国TeslaのFSD(Full Self Driving)V12がE2Eの自動運転を実装し、ほぼ人間レベルの運転を実現。中国Huawei(ファーウェイ)もE2Eの自動運転を開発していることから、E2Eの自動運転が注目されている。

なお、TeslaのFSDのE2Eは、複数カメラのデータを直接入力し、ステアリング、ブレーキ、加速信号などを出力するフルスタック(複数の開発工程で使われるツールや機能などが統合されており、単体でシステム構築や運用などを実現)のNural Networkが実装されている。

TeslaのFSDは、GPTのようなLLMがインターネットのデータを圧縮するのと同様に、数千万ものビデオ画像から人間の運転知識をNural Networkパラメータに圧縮し、運転知識を習得する(E2E Large Mode)。

LLM(Large language Models)

大規模言語モデル。大量のデータとDeep Learningによって構築された言語モデル。言語モデルは文章や単語の出現確率を用いてモデル化したものであり、文章作成などの自然言語処理で用いられる。LLMと従来の言語モデルでは、「データ量(入力される情報量)」「計算量(コンピューターが処理する計算量)」「パラメータ量(確率計算を行うための係数量)」が大きく異なる。LLMは、2017年に発表されたTransformerがトリガとなり構築されたと言われている。

LLMは、次のような仕組みで構築されている。「トークン化:入力文を最小単位に分別」「文脈理解:プロンプト内の各トークンとの関連性を計算」「エンコード:特徴量の抽出」「デコード:次のトークンを予測」「入力文の次のトークンの確率を出力」

LLMは基本的にTransformerの仕組みを利用。従来の言語モデルでは、テキストデータであれば単語に分割した後に人がラベル付けをする必要があったが、LLMでは大量のテキストデータを与えることで、トークンから文脈や言葉の意味を学習できる。この学習した結果から、特定の言葉に続く確率が高いと考えられる言葉・文章を並べられるものがLLMである。

LLMの一例として挙げられるGPT(Generative Pre-trained Transformer、米国OpenAIが開発)-4は、2023年にアップデートされたGPTの最新版であり、テキストだけでなく画像などの入力を受け取ってテキストを出力できるマルチモーダルなモデル。GPT-3.5で扱えるトークンの最大数は4097であったのに対し、GPT-4では3万2768トークンと約8倍に増加。そのため、GPT-3.5よりも複雑な質問にも回答できる。

LLMは、人間のような自然な受け答えや文章の作成が可能であることから、文章の作成や校正、リアルタイム翻訳、プログラムのバグチェック、カスタマーサポートで活用されている。

ONNX(Open Neural Network Exchange)

オニキス。米国Meta(旧Facebook)と米国Microsoftが2017年に発表。Deep LearningやMLモデルのようなAIモデルを表現するためのフォーマット。AIモデルとは、PyTorch、TensorFlowなどの各フレームワークで学習したモデルを指します。異なるフレームワーク間でモデルを使用することが可能になります。

複数のフレームワークを使っていると、あるフレームワークで学習したモデルを別のフレームワークで活用したい場合があります。フレームワーク間で共通使用できるフォーマットに変換することで(ONNX)、フレームワーク間でモデル共有が可能になります。複数のAIモデルを組合わせることで予測の精度を高めることを目指す。

なお、PyTorchはMetaが開発しているDeep Learning向けフレームワーク。TensorFlowは米国Googleが開発しているDeep Learning向けフレームワーク。

補足)フレームワークはアプリケーションの「型」を提供するツール。開発者はフレームワークで用意されたコードを修正したり、新たにコードを追加して使用。ライブラリは「部品」であり、自作プログラムで部分的に使用。

セレンス

米国セレンス(Cerence)は、2019年10月、車載機器のAI音声認識技術を手掛ける米国ニュアンス・コミュニケーションズ(Nuance Communications)からの分社化によって設立。自動車メーカーと提携しながら自動車業界向けの独自ソリューションの開発に携わる。具体的な専門領域は、AIや言語理解、声紋認証、ジャスチャーや視線の検知、AR(拡張現実)など。