生成AIを使った画像付き英語リスニング動画の制作方法

以下の動画を視聴し,空欄の英文を書き取ってください。

※答えはこの記事の最後に載せてあります。

これは私が最近作成した英語のリスニング教材の1つです。本稿では,こうした教材をどのように作成したかを紹介したいと思います。

注意:ここで紹介するのは,私が加入しているChatGPT Plus会員(月額$20),ElevenLabsクリエーター会員(月額$22)を通して行っていることです。その点をご注意いただければと思います。

はじめに

書き下ろし英文の外注

2022年11月30日にOpenAI社がChatGPTを公開し,もう少しで1年が経とうとしています。同年の12月末頃から私も利用し始めましたが,今では手放せない存在になっています。英語教員である私が特に重宝している使い方は,「特定の英語表現を拡張し例文や文脈を生成させる」ということです。従来は,長い時間をかけてて英語の文章の骨組みを考え,母語話者の知人等に見せて校閲をしてもらって教材等に利用することが多かったのですが,このやり方だと大量に制作することが難しく,校閲をお願いする頻度も増えてお願いするのに気が引けてしまうという問題がありました。ChatGPT(とりわけ2023年3月に登場した最新モデルGPT-4)は,第二言語としての英語の使用者が苦手であることの多い「語法的・ディスコース的に問題のない(または限りなく問題が少ない)英文」を生成することに長けています。生成AIを利用して作成した英文も校閲してもらうことはありますが,修正されることは圧倒的に少なくなりました(今では授業で使用するレベルのものであれば校閲はお願いしなくなりました)。

声優の外注

英語母語話者ではない英語教員にとって,英文の原稿を読み上げて音声にするのもまた大変なことでした。自分で録音をして形に残すというレベルまでは自信がなく,同僚の英語母語話者の先生にお願いして録音してもらう。このようなことをされてきた先生方も多かったのではないかと思います。しかし,録音をお願いするということは,校閲以上にその人を拘束して時間を奪ってしまうことになり,頻繁に誰かに録音をお願いするのは現実的ではありません。

2023年1月にElevenLabsという会社がText to Speech(以下,TTS)の音声読み上げのサービスを公開しました。それまでも,Amazon PollyやMicrosoft Asureなどで比較的良質なTTSのサービスはありましたが,ElevenLabsのTTSで作成した音声は,私が知っている中でも圧倒的に質が高く,英語母語話者が自然に話している状態に近い音声だと感じました(特にそう感じたのは旧Twitterでこちらの投稿を目にしたときでした)。私は元々英文を朗読するのが好きで,授業では自分で録音した音声を利用することが多かったのですが,2人以上の会話の作成には自分以外にも誰かに録音をお願いしなければならず,その点で限界を感じていました。ElevenLabsで利用できる声は現在ではかなり多く,自分の声をベースにしたクローン音声を使って読み上げさせることもできます。これは授業に利用しない手はないなと感じ,早速利用し始めました。

イラストの外注

元々私は文単位で英文を書き取らせるディクテーションタスクを重要だと考えていました。文単位のディクテーションで特に大切だと思っているのが,ターゲットの英文の前後の文脈をある程度提示することです。私たちが話し言葉を理解する際,様々な形状をした音声の物理的特徴を絶対値に照らし合わせて解析しながら聞き取っているだけではなく,むしろ,既存の知識(語彙,文法,文脈などの知識)に照らし合わせ,その都度で修正等を加えながら最適な解釈を選択していることが多いのではないかと考えています。内容が想像しやすい英文であれば,その英文だけ提示して書き取らせるタスクも十分に妥当性はありますが,実際の聞き取りは,多くの場合文脈が付属して不完全な状態で提示されることも多いので,文単位のディクテーションをさせる際も何かしらの方法で文脈を補填するのがよいのではと考えています。

文単位のディクテーション問題を作成する際に文脈を補填する方法はいくつか考えられます。1つは,前後に英文を加えることです。英文読解の際も同様ですが,前後の英文の内容を正確に読み取ってはじめてターゲットの英文の意図や意味が正確に理解できるということも多いかと思います。2つ目は,画像や映像などの視覚的情報を加えることです。現実の言語使用(とりわけ話し言葉の使用)は視覚情報が与えられた状態でなされることが多く,話し言葉のやり取りで重要な「聞き取り」をする際も,視覚情報が補填されていることには大きな妥当性があります。また,話し言葉の媒体である音声は,辞書等で提示されている音声記号から逸脱し「くずれた形」で提示されることも多いので,むしろ文脈なしに正しい聞き取りは考えられないといってもいいかもしれません。

上であげた2つの文脈の補填方法は,人間だけの力でもできないことはありませんが,多くの音声教材を作成していくには時間と労力がかかります。ChatGPTのような生成AIはそれを大きく減らしてくれました。ベースとなるアイディアを人間が提示し,補填する英文や画像は生成AIを使って生み出す,そういうことが可能になりました。

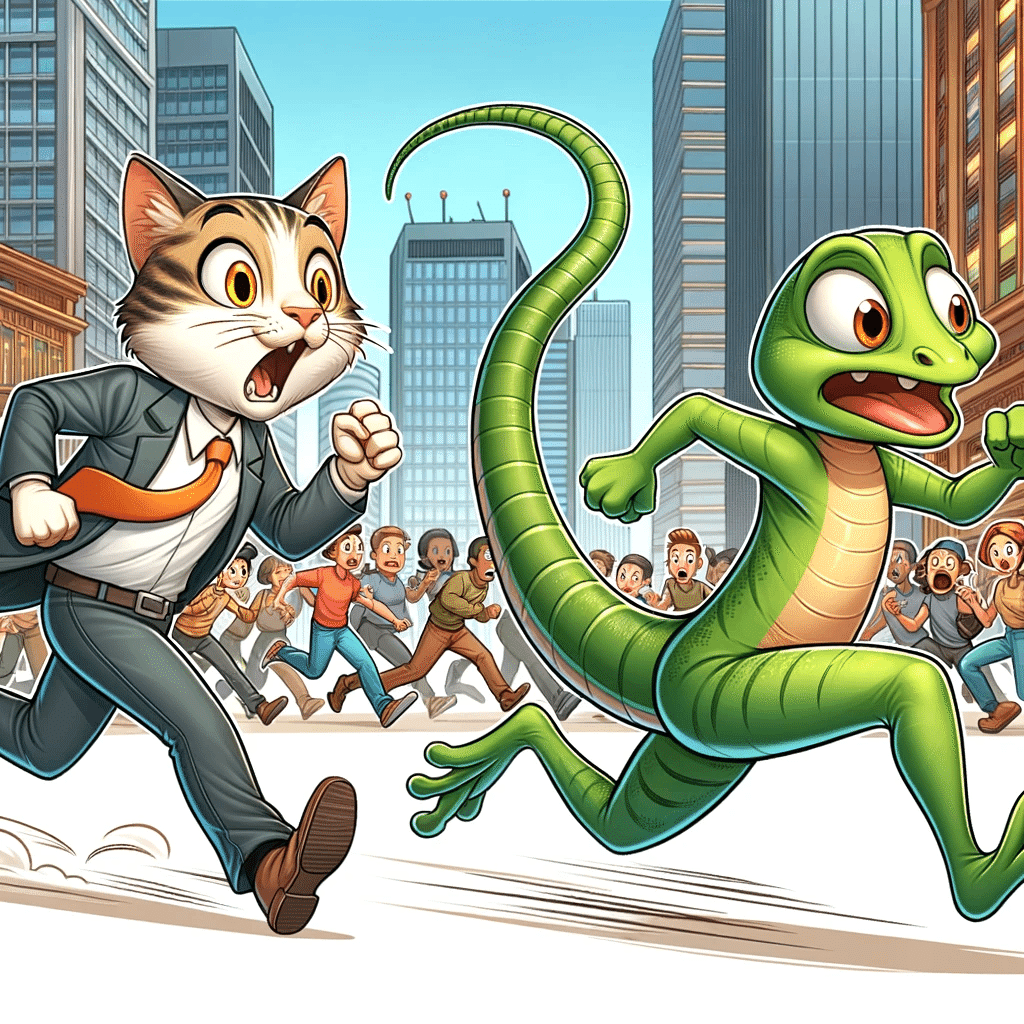

以下に,冒頭に提示した「猫とトカゲの会話」の教材を私が制作したやり方を具体的に紹介します。

制作方法

題材を選ぶ

FNNニュースで,大型のトカゲが住宅街に逃げ出してしまったという内容の動画が紹介されていました。動画の中で,茂みからトカゲが飛び出し,すぐ後からそれを追いかける猫の姿も収められていました。トカゲも猫もすごい勢いで公道を走っています。

クスクスと笑みが溢れてしまうようなこの滑稽な状況。この2匹の動物の会話を教材にしたら面白いかもしれない,そんな風に思ったのが「猫とトカゲの会話」の動画を作ったきっかけでした。

会話文の生成

モチーフが決まったら,ChatGPTに会話文の骨組みを作ってもらいます。私は有料版のChatGPT Plus会員のため,現在の最新版であるGPT-4を使って生成させます。今回私が入力したプロンプトは以下のようなものです(今回は日本語でプロンプトを作成しました)。

私:市街地から大トカゲが飛び出してきたニュース映像を見ました。なんと猫が追いかけています。思わず笑ってしまいました。 これを題材にした,英語のダイアローグを考えてほしいです。トカゲと猫が会話をしている,というシーンでお願いします。

これを受けてGPT-4が生成したダイアローグは以下のようなものです。

GPT-4:

Lizard (L): Good heavens! What a bustling city this is!

Cat (C): Hey, wait up! What do you think you're doing, running through the streets like that?

L: Oh, you startled me! I didn't expect to be chased by a cat in such a lively urban environment.

C: You're not the only one who's surprised. You don't usually see a lizard of your size gallivanting around town. What's the deal?

L: I was merely exploring, trying to get a sense of what life is like for humans. They have these fascinating structures they call "buildings."

C: Ah, yes. Buildings. They're full of delightful nooks and crannies, not to mention the potential for food scraps. But you're causing quite a commotion, you know.

L: I apologize for that. My size does tend to make things a bit... chaotic.

C: Well, how about you explore a bit more quietly, maybe in a less populated area? Humans aren’t as welcoming of giant lizards as you might think.

L: That sounds like a reasonable suggestion. Thank you for your guidance, feline friend.

C: No problem. Just trying to keep the peace, one way or another.

L: Farewell, then. I shall take your advice to heart.

C: Goodbye, and stay out of trouble!

このダイアログは都市環境で珍しい出来事に対するトカゲと猫の視点を探る一例です。皮肉とユーモアも織り交ぜていますので、言語使用に対する興味を持つ方々にとっては面白いものになるかと思います。

なかなか面白い表現(gallivant, nooks and crannies, potential for food scraps, commotion, How about SV?, 呼びかけのfeline friend, one way or another, take O to heart)が使われているものの,FNNの動画で紹介されていたスピード感のある追いかけっこの中でこんな込み入った会話はできないだろうなと思い,追加のプロンプトを入力しました。

私:2匹は会話中も全力で走っている訳です。

かなり限定的なプロンプトですが,経験的にこのような短いプロンプトでも,今までのやりとりからこちらの意図を理解してくれることが多いのを知っていたので,このような指示を追加してみました。以下はそれに対する応答です。

GPT-4: なるほど、その追加の情報を考慮に入れると、ダイアログがさらに面白くなるでしょう。以下に修正版を示します。

Lizard (L): (Panting) Good heavens! What a bustling city this is!

Cat (C): (Running alongside) Hey, wait up! (Huffing) What do you think you're doing, sprinting through these streets?

L: (Glancing over) Oh, you startled me! I didn't expect to be chased by a cat at this speed in such a lively urban environment!

C: (Dodging a pedestrian) You're not the only one who's surprised! You don't usually see a lizard of your size gallivanting around town at full tilt. What's the deal?

L: (Jumping over a trash can) I was merely exploring, trying to get a sense of what life is like for humans. They have these fascinating structures they call "buildings."

C: (Leaping gracefully over the same trash can) Ah, yes. Buildings. They're full of delightful nooks and crannies, not to mention the potential for food scraps. But you're causing quite a commotion, you know.

L: (Swerving to avoid a lamppost) I apologize for that. My size and speed do tend to make things a bit... chaotic.

C: (Taking the swerve smoothly) Well, how about you explore a bit more quietly, maybe in a less populated area? Humans aren’t as welcoming of giant, sprinting lizards as you might think.

L: (Nodding) That sounds like a reasonable suggestion. Thank you for your guidance, feline friend, even at this speed.

C: (Accelerating slightly) No problem. Just trying to keep the peace, one way or another. Now, shall we exit stage left?

L: (Picking up pace) Farewell, then. I shall take your advice to heart!

C: (Keeping up effortlessly) Goodbye, and stay out of trouble!

いくつか面白い表現(e.g., Now, shall we exit stage left?)に変更され,セリフの前に演技指示(Stage Directions)が加えられました。だいぶイメージができるようになりましたが,これでは長すぎるので次のような追加のプロンプトを加えました。

私:もう少し短めのものをお願いします。

GPT-4: もちろん、以下に短縮版のダイアログを示します。

Lizard (L): (Panting) What a city!

Cat (C): (Huffing) Slow down! Causing a scene here!

L: (Glancing over) Didn't expect a cat chase!

C: (Dodging a pedestrian) You're a spectacle! Why?

L: (Jumping a trash can) Exploring "buildings!"

C: (Leaping over the can) You're a ruckus! Go somewhere quiet!

L: (Swerving) Fair point. Thanks, cat!

C: (Accelerating) Just keeping peace. Exit now?

L: (Picking up pace) Will do! Farewell!

C: (Keeping up) Bye, and be careful!

この短縮版では、言葉が少なくとも意味はしっかりと伝わるように工夫しました。緊急状況や動きながらのコミュニケーションにおいては、言葉が短くなる傾向がありますので、その点も興味深いかと思います。

1つ1つのセリフがだいぶ短くなり,FNNの動画にあったようなスピード感のある映像にあったダイアローグになってきました。しかし,主語などがだいぶ省略されてしまっていて,学習者のレベルによってはわかりにくいので,少し手を加えることにしました(これもGPT-4にやらせてもいいのですが,望まぬ結果になることもあるので,この辺りは手作業です)。結果出来上がったものは以下のようなものです。これでスクリプトは完成です。

Lizard: What a city!

Cat: Slow down! You’re causing a scene here!

Lizard: I didn’t expect a cat chase! Ahhhh!

Cat: You’re a spectacle! Why are you doing this?

Lizard: Exploring “buildings!”

Cat: You’re a ruckus!* Go somewhere quiet!

Lizard: Fair point! Thanks, cat!

Cat: I’m just keeping the peace here! Do you want to exit now?

Lizard: Will do! Farewell!

Cat: Bye! And be careful!

追記:知人の英語母語話者(60代英国人)にスクリプトを示したところ,You're a ruckus!という表現は「あまり自然な英語ではない」という指摘をもらいました。そもそも,ruckusは「喧騒;口論」という意味なので,「人間 = ruckus」となるのはおかしく,You are causing a ruckus.やYou are making a ruckus.などというのが一般的なようです。私は,「略式ならばこういう言い回しも可能なのだろうな…」と思い込んで確認を怠ってしまったのですが,容認性は今ひとつ…という英文かもしれません。

画像の生成

次に,上で作成したダイアローグにあった画像を作ります。画像の生成には,Chat GPT plus会員で利用できるDALL-E3を使いました(ちなみにこのDALL-Eは,PIXARのロボットキャラのWALL-Eと画家のSalvador Dalíの名前を合わせた「かばん語(portmanteau word)」で,英語での発音は/ˈdɑːli/となることが多いようです)。ChatGPTで「新しいチャット」を開き,GPT-4のタブにカーソルをあて,「DALL-E3 (Beta)」をクリックします。最初に指示を出したプロンプトは以下の通りです。

私:

Lizard: What a city!

Cat: Slow down! You’re causing a scene here!

Lizard: I didn’t expect a cat chase! Ahhhh!

Cat: You’re a spectacle! Why are you doing this?

Lizard: Exploring “buildings!”

Cat: You’re a ruckus! Go somewhere quiet!

Lizard: Fair point! Thanks, cat!

Cat: I’m just keeping the peace here! Do you want to exit now?

Lizard: Will do! Farewell!

Cat: Bye! And be careful!

Make a cartoon drawing of this scene. Please do not include any balloons.

ダイアローグの原稿を貼り付け,それにあった漫画風のイラスト(cartoon drawing)を描いほしい,という内容です。今回英語のプロンプトにしたのは,深い理由はありません。漫画風のイラストを指定すると,吹き出し(balloons)が出てきてしまうことがあり,その中に誤った綴り字や文字を含む言語や存在しない言語が適当に生成されてしまうことがあるため,それを防ぐために"Please do not include any balloons."と追加の指示を出しました。

GPT-4: Here are the cartoon drawings based on the scene you provided. Please let me know if they align with your vision or if you have any feedback or adjustments in mind. Additionally, I'd like to hear your opinions on the representation and any other aspects you find noteworthy.

上記のようなイラストが生成されました。吹き出しを出さないように指示を出したのにも関わらず画像1では吹き出しが出てきてしまっています。また,追いかけっこのシーンにはなっていません。修正を試みます。

私:You know the cat is running chasing the lizard.

私がよく使うプロンプトの体裁は,普通に人と話しているような会話体であることが多く,今回もこのようにカジュアルな文体で修正を試みました。

GPT-4: I apologize for the oversight. Here are the revised cartoon drawings showing the cat actively chasing the lizard through the city streets. Please examine them and share your thoughts. If further adjustments are needed or if you have any specific preferences, do let me know. Your feedback is greatly appreciated.

だいぶ近くなってきましたが,ニューヨークのビル街のような絵なので,やはりイメージと異なります(画像4ではなぜか二足歩行…)。再び修正を試みます。

私:The background should be Japanese houses.

GPT-4: Thank you for your patience. Here are the cartoon drawings illustrating the scene with the cat chasing the lizard against a backdrop of traditional Japanese houses. Please review them and inform me of your opinions or if any other modifications are required. I value your feedback and strive to meet your expectations.

あらら,時代劇のような街中になっていました。いっぺんに修正できるようプロンプトを工夫することもできるかもしれませんが,私はいつもGPT-4との会話を楽しみつつ少しずつ修正を加えています。

私:I mean "modern" Japanese houses.

以下が修正された画像です。

GPT-4: Thank you for the clarification. Here are the cartoon drawings depicting the scene set against modern Japanese houses. Please take a moment to review them. I would be most grateful for any feedback you might provide, or if you have further refinements in mind. Your satisfaction is of utmost importance.

現代の日本の住宅街が登場しましたが,何が何を追いかけているのかわからない仕上がりになっています(なぜか画像7ではトカゲが少年を追いかけています)。

私:The one on the left (画像7のこと) looks good. Make a cat chase the lizard, not a human boy.

GPT-4: Thank you for pointing that out. Here are the updated cartoon drawings with the cat chasing the lizard against the backdrop of modern Japanese houses. Please review them and let me know if this rendition meets your requirements. I value your input and am here to assist further if necessary.

だいぶ近くなってきましたが,スピード感が足りません。

私:Getting better. Make them look a bit speedier.

GPT-4: Thank you for your feedback. Here are the updated cartoon drawings with an enhanced sense of speed, emphasizing the cat's pursuit of the lizard. The dynamic lines and positioning should convey the swiftness of their chase against the backdrop of modern Japanese houses. Please review them and let me know if this meets your expectations. Your input is invaluable, and I'm here to ensure your satisfaction.

ようやく,FNNのニュースで報じられていたようなシーンが再現できてきました。画像12が気に入ったので採用することにしました。

音声の生成

ダイアローグの原稿と画像が整った後,音声の作成に移りました。こちらは英文の原稿ができていればすぐに取り掛かれるので,画像を生成する前に行っても全く問題はありません。画像を見てはじめて音声をイメージできる人は多いかもしれませんが,この辺りは人によって異なるかもしれません。

音声の生成には「はじめに」の「音声生成」で述べたElevenLabsを使用します。異なったキャラクターの声を割り当てながら作成できて便利なProjectsという機能を使っています。事前に作成しておいたダイアローグのセリフを編集画面に貼り付け,キャラクターの名前("Cat:"や"Lizard:"の部分)を読み上げてしまわないよう削除をします。以下のような画面で作業をします。

この画面では,Dan Danというpremadeの声を使って猫のセリフ(奇数行)に割り当てています。1行単位でセリフの生成ができるので便利です。以下の音声がある程度納得いくまで作業をし作成したものです(画面右上の3点リーダからmp3をダウンロードできます)。

だいぶ骨格が出来上がってきましたが,ポーズの長さがおかしかったり,イントネーションが不自然に感じられるところがいくつかあるので,音声編集ソフトのAudacityに入れて,追加で編集します。イントネーションが不自然なところは,ElevenLabsのSpeech Synthesisモード(先ほど紹介したような異なる話者のセリフを割り当てるモードではなく,単にテキストを貼り付けて音声を生成する最も一般的なモード)で差し替え用の音声を作成します。Audacity上でポーズを調整しいくつか音声を差し替えたらほぼ完成です。

これだけでもそれなりにオーセンティックな雰囲気のある教材には仕上がるのですが,私の場合さらにBGMや効果音を入れたくなることも多いので,フリーの素材をインターネット上で検索し,気に入ったものがあればダウンロードしてAudacity上でセリフの音声と合わせます。今回はFesliyanStudiosさんよりPredator and Preyと題されたBGMをお借りしました(はじめと終わりは,それぞれフェードイン,フェードアウトのエフェクトをつけています)。足音の効果音は今回はこちらの効果音ラボさんよりお借りしました。

追記:この後の作業で画像と音声を合わせる際にiPhoneの「画面録画」の機能を使っているのですが,iPhone上で再生ボタンを押してから画像を表示するまでの間に音声が始まってしまわないよう,編集した音声の冒頭に1秒程度の無音を挿入しておくことをおすすめします。

画像と音声を合わせる

ここまでくればあとは簡単です。画像と音声を合わせるためには,動画編集ソフトなどが思いつきますが,私の場合は面倒なのでiPhoneの「画面録画」の機能を利用しています。

完成した音声はDropboxなどに入れておき,iPhoneの「写真」に作成した画像を表示して,画面録画を始めます。画面録画を開始したらすぐにバックグラウンドでDropboxの音声を再生します。あとは,音声の再生が終わるまで待って画面録画を終了します。

Dropboxの音声の再生ボタンを押してすぐに音声が始まってしまうと,「写真」に保存しておいた画像を表示する前に音声が再生されてしまうため,Audacityで音声を編集する際に,あらかじめ冒頭に1秒程度の無音を挿入しておくといいかもしれません。これで英語リスニング動画が完成します。

かなり長く説明してきましたが,慣れてしまえば案外簡単にできてしまいます。

さいごに

読解にせよリスニングにせよ,オリジナル教材を作ることができる時代になったというのは,私のような教員にとってはなんともいえない喜びがあります。しかし,便利な世の中になったとはいえ,気をつけなければならないことがあります。

生成された文章はよく確認した方がいい

生成された音声はよく確認した方がいい

生成AIは,現在のところ生成される文章も音声も完全ではなく何度かやり取りを繰り返して修正などを加えないと質の悪い英語教材になってしまう可能性があります(生成される文章の内容に問題が生じる理由の一つに「プロンプトが不十分であったから」ということもある)。英語の文章や音声はかなり質が高いものが生成されるのは確かですが,細かいところに目を光らせていないといけないと思っています。結局のところ,「教材としてこれを使おう!」と最終的に決断をするのは人間である教員であるわけなので。こうしたオリジナル教材に限らず,日々教材の選定をする英語教員は普段からできるだけたくさんの英語を聞き,読んでいかなければならないと思っています。

ここで示したやり方は一例に過ぎませんが,少しでも何かお役に立てたのであれば幸いです。

ディクテーションの答え

【正解】Will do!

訳例:いいですよ!

以下は『ジーニアス英和辞典(G6)』の説明をまとめたもの。

Wìll dó!はI will do as you request.の省略表現。

e.g., “Can you revise these reports by Monday?” “Sure, will do!”

「月曜日までにこの報告書を修正してくれないか」 「はい, いいですよ」

記事を書き続けるのはモチベーションとの戦いです.書きたい内容はたくさんあります.反応を示していただくのが一番の励みになります.よろしくお願いします.