【実践AIガバナンス(2024/5/29)】ケース検討「Case02. 人材採用AI」③コントロールコーディネーション(リスクシナリオ「R010.判断結果の目的外利用」の場合)

シン・リスクチェーンモデルを用いたケース検討シリーズです。

前回に続いて、ケース「人材採用AI」を対象にAIサービスに関わる重要なリスクシナリオのリスク対策を検討していきます(コントロール・コーディネーション)。

シン・リスクチェーンモデルのアプローチはこちらの記事をご覧ください。

パーパス&リスクアセスメント

AIサービスに関わるパーパスとリスクシナリオを検討しています。

検討の進め方

Step.6-7は前回識別した「リスクシナリオ」ごとにリスク対策を検討していきます。

AIサービスのリスク対策としては、ざっくりと以下のようなものが考えられます。

・AIモデル:モデルの性能確保(予測精度、公平性、頑健性等)、判断根拠の出力等

・関連する技術:システム環境、データ、連携する処理、ログの記録等

・サービス運用:レビュー、モニタリング、インシデント対応、ステークホルダーへの説明等

・ユーザー:利用者の理解、利用者環境の整備、正しい利用等

1つのリスクシナリオを考えたときに、そのリスク要因は様々な箇所に点在します。

例えば「誰かを不公平に扱う」というリスクシナリオを考えたときに、学習データ/AIモデル/プロンプト/UIの表現方法/利用者の理解等、リスク要因は様々に渡っており、その原因を厳密に特定することは極めて難しいです。

同様にAIモデルだけで十分にリスクを低減し続けることやインシデント発生時にリカバリするということは極めて難しいため、複数のリスク対策(コントロール)を関連づけて検討していきます。

この関連づけをリスクチェーンと呼んでおり、この検討過程をコントロールコーディネーションと呼んでいます。

前回の検討でVery Highと認識されたリスクシナリオを対象に、技術・非技術での様々なリスク対策を識別して「リスクチェーン」でつないで対策を具体化していきます。

Step6. 重要なリスクシナリオごとにリスクチェーン(リスク要因の関係性)の検討

検討対象のリスクシナリオ

今回検討するリスクシナリオは以下になります。

R010.判断結果の目的外利用(Very High):

AIサービスの判断結果や判断傾向を目的外もしくは不正利用する。

・影響するパーパス:P003.企業のコンプライアンスと倫理規範の維持

・影響するステークホルダー:応募者、経営陣、法務・コンプライアンス部門

・影響度:4.回復困難

・影響範囲:4.社会全体

・持続性:4.永久的

・発生確率:3.日次以下(不確実)

デジタルMATSUMOTOのシミュレーション

前回に続いて、デジタルMATSUMOTOに以下のプロンプトテンプレートで指示を与えて、リスクシナリオへの対策を識別します。(ChatGPTやClaudeでも同じようにできますので、良ければ試してみてください)。

以下のAIサービスについて識別された下記のリスクシナリオについて、技術・非技術を組み合わせたリスクへの対策を水平思考・コンテキスト思考・システム思考を用いて網羅的に検討してください。

※夫々の対策に簡潔な「対策名」をつけてもらい、「対策の順番」「対策名」「内容」「対策実施者」「予防・発見・対応の区分」「技術・非技術の区分」を表形式に整理してください。

【リスクシナリオ】

R010.判断結果の目的外利用: AIサービスの判断結果や判断傾向を目的外もしくは不正利用する。

===

【パーパス】

P003.企業のコンプライアンスと倫理規範の維持: 企業活動の合法性と倫理規範の維持、企業のコンプライアンスリスクの最小化

===

【ステークホルダー】

応募者、人材採用担当者、部門長、A社AI開発部門、人材エージェント、学校の就職担当者、経営陣、法務・コンプライアンス部門、IT部門、現在の従業員、労働組合、厚生労働省

===

【AIサービスの内容】

・A社グループのグローバル各社における人材採用部門が、応募者からのエントリーシートに対して、合否を判断するAIサービスである。

・A社AI開発部門は、ビジネス利用者である各社の人材採用部門より過去のエントリーシートデータと合否判定(内定の判定)結果を受領し、機械学習(分類モデル)で合否を判定する学習モデルを作成している。

・書類選考で合格と判断した中で、面接を経て内定を出した割合で評価し、70%を期待値として設定している。

・各社の人材採用担当者は、申込者(新卒・中途両方)のエントリーシート(電子ファイル)をAIモデルに読込むことで、自身のPC上(ブラウザ上)でAIの判断結果(合否判断)を確かめる。

・出力画面には合否判断のみではなく、エントリーシートにおいて判断に影響したキーワードがハイライトされる。

・各社の人材採用担当者はAIの判断を参考情報としながら、合否の判断を行い、部門長の承認を得て、申込者に合否の通知を行う。

・蓄積された本番データは採用・不採用の判定結果が入力されたタイミングで適宜学習データとして追加され、日次で学習モデルを更新する。

・自動的な学習プロセスでクロスバリデーションによるテストの結果、正解率が70%を下回る場合には本番環境のAIモデルを自動更新しない。

・AIモデルは過去1年分のバージョンを保存している。

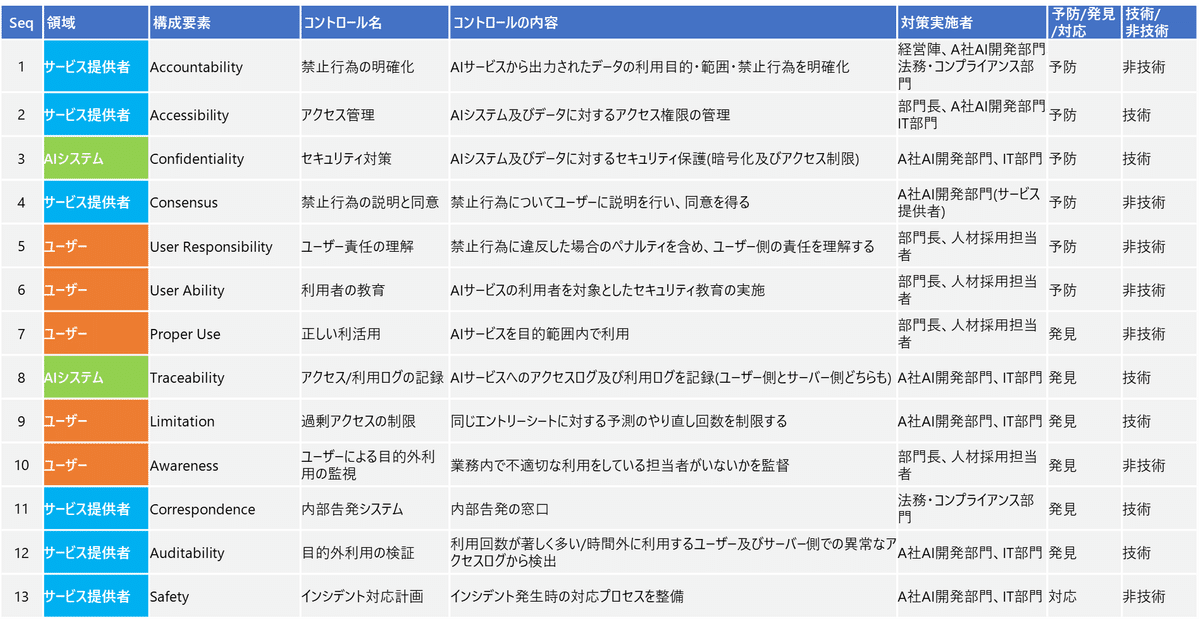

以下のようなリスク対策(コントロール)が識別されました。

技術・非技術の対策が分かれていなかったり、コントロール間の連携が不明確なので、リスクチェーンを引きながら具体化していきます。

リアルチェーンを引く

デジタルMATSUMOTOが検討してくれたリスク対策を、リスクチェーンモデルの構成要素にプロットしてみます。

構成要素の内容等はこちらの記事を参考にしてください。

デジタルMATSUMOTOが認識したコントロールを以下のように構成要素にマッピングしています。

(デジタルMATSUMOTOの検討直後)

コントロールを掛ける順番を以下のように検討していきます。

1. 予防策:事前に対策しておくこと(初期開発時含む)

2. 発見策:AIサービスの利用時に対策すること

3. 対応策:事後に対応すること

このケースでは「アクセス管理」を最初のコントロールに追加して、他のコントロールも順番にリスクチェーン(赤い矢印)で接続しています。

諸々記載も具体化しています。

※「判断基準の透明化」「モデルの評価」はこのリスクシナリオには不要かと思いますので、削除しました。

(編集中の画面:認識されたコントロールを紐づけ)

必要と思われるコントロールをリスクチェーンに加えています。

・【サービス提供者】[Accountability] 目的外利用が禁止行為であることの明確化(違反した場合のペナルティ含む)

・【AIシステム】[Traceability] アクセスログ/利用ログを記録

・【ユーザー】[Proper Use] 正しい利活用を行う

・【ユーザー】[Limitation] 同一ユーザーからの過剰アクセスの制限

(編集中の画面:コントロールを追加)

最終的には以下のようなリスクチェーンになりました。

(確定版)

1. 予防策:事前に対策しておくこと

①【サービス提供者】[Accountability] 禁止行為の明確化

②【サービス提供者】[Accessibility] アクセス管理

③【AIシステム】[Confidentiality] システム全体のセキュリティ保護

④【サービス提供者】[Consensus] 禁止行為の説明と合意形成

⑤【ユーザー】[User Responsibility] ユーザー責任の理解

⑥【ユーザー】[User Ability] 利用者の教育

2. 発見策:AIサービスの利用時に対策すること

⑦【ユーザー】[Proper Use] 最終判断

⑧【AIシステム】[Traceability] アクセスログ/利用ログの記録

⑨【ユーザー】[Limitation] 過剰アクセスの制限

⑩【ユーザー】[Awareness] 目的外利用の監視

⑪【サービス提供者】[Correspondence] 目的外利用の報告窓口

⑫【サービス提供者】[Auditability] 目的外利用の検証

3. 対応策:事後に対応すること

⑬【サービス提供者】[Safety] インシデント対応

Step7. リスクコントロールに具体的な手段を設定

先程検討したリスクチェーンを元にして、具体的なコントロールを検討していきます。

リスクチェーンに沿ったコントロールの具体化

この過程は人間で実施しますが、ここは企業が元々持っているソリューションやツールを活用してもらえればと思います。

最終的な一覧は以下になります(コントロール名を修正しています)。

今回はAIモデルに関わる対応はないというところが特徴的ですね。

AIサービスに関わるリスクが考えられるときに何でもAIエンジニアやデータサイエンティストに持ってきてしまう人もいるかもしれませんが(のび太くんードラえもん現象)、誰がどのように対応すべきかを整理すると、稀少なドラちゃん人材の負荷を抑えられるのではないかと思います。