<実験>静止画からのAIアバターで二か国語ニュース番組を作る(HeyGen✕Eleven Labs)

<実験> ニュース動画をパパっと作る

架空の二か国語AIニュース番組「GENAI NEWS(ジェナイ・ニュース)」を作りました↓

<下準備>

▼ アバター作成

バストアップをiPhoneで自撮り

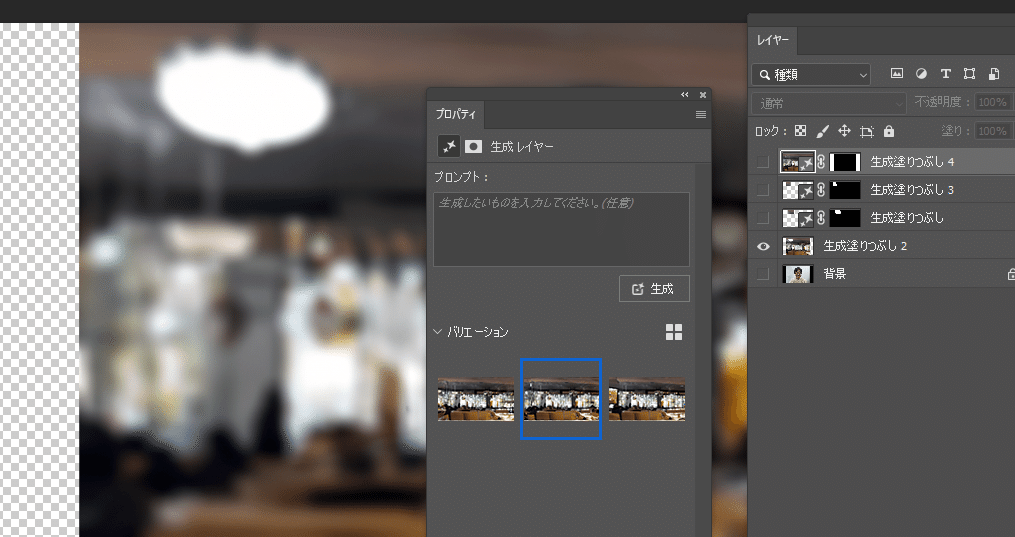

Photoshopの自動生成でオフィスのカフェのような背景を生成

自撮りと合成したものをLeonardで多重影分身

ほどよく違う顔になるまで調整

MagnificAIでリアルさをちょい足し

Photoshopで微調整して完成

▼ ついでにニュース番組のロゴも生成

ChatGPT経由でDall-Eに出力してもらいます

RunwayGen2で動かしてフライングロゴ化しました

<日本語でのニュース読み上げ>

▼オリジナルの原稿

JP / 日本語

AI合成音声モデル生成サービスのEleven Labsが

シリーズBで約120億円相当を調達

ユニコーンとしての地位が確実になったとのこと

自分の音声をクローンして

アバターで英語で喋らせることが可能

しかし本当はその資本で

世界で完全に置いていかれている

日本語のモデル強化も

お願いしたいところ

スマホカメラで生の読み上げを録画

音声ファイルを切り出して

上で作ったアバター画像とともに

HeyGenのフォトアバター機能へ入力

たったこれだけでOKです

あとは「Submit」ボタンを押せばパパっと数分で生成されます↓

少し気になった点

を先にあげておくと…

▼ リップシンク

口の開閉がタイミング、形ともに微妙に合っていない(例えばサ行の口の形が英語の"s"になっている)

生成モデルのローカライズの問題なので、そのうち改善されるはず

日本語への対応は後回しになりそうですが・・・

▼ 顔のハイライト

鼻筋などのハイライトが顔を動かしても変化せず張り付いたままで不自然です

ここはフォトアバターを準備する段階で気をつけるポイントかもしれません

▼ 顔ジェスチャーの動きがランダム

話している内容と顔の表現のタイミングがあまり一致しておらず、かつ少し大袈裟です

タイミングはパターンの蓄積で解決していく気がしますが、文化の差による違和感は残りそうです

▼ 前歯!

モンゴロイドのアバターを作ろうとすると、男女ともに、口元のニュートラルポジションがなぜか「f」の形になり、前歯が妙に目立つ傾向が見られます

競合サービスの生成ではこうはならないので気になりました

とはいえ読み上げアバターとしては相当な完成度ですよね

1年後には実写と見分けがつかなくなっていそうです

<二か国語化>

HeyGenには、開発版扱いの言語変換機能「Video Translate」があります

これが既にかなり高い精度なのですが

今回はニュースの内容で語っている、

より「喋り」に特化したサービスEleven Labsを使います

一発変換だと誤訳、ニュアンスの脱落などがどうしても生じますが、Eleven LabsのDubbing Studio機能を使えば、変換後に手動に手動でインタラクティブに修正できます

自分がある程度理解できる言語であれば、GPT等にサポートしてもらってかなり詰める事ができるでしょう

▼ 日本語から英語へ

こちらが、Eleven Labsでの英語変換を再びHeyGenで口パクさせたものです

日本語話者が発音しそうなやや平板な英語になっている…と思いきや

よく聞くと元の声主の発話のトーンや抑揚を忠実に再現しているようです

比較としてHeyGenのVideo Translate機能による英語変換を聞いてみましょう

こちらの方が発音がネイティブっぽく、翻訳も英語としてナチュラルな感じがします

編集機能の有無を抜きで言えば現状

「元の話者の雰囲気を保ちたい」ならEleven Labs

「ネイティブペラペラ感を出したい」のであればHeyGen

といったところでしょうか?

ただ謎なのが、よく見てみると

HeyGenの発話エンジンはEleven Labsを使っているという点です

面白いですね

▼ (おまけ)英語から再び日本語へ

ふと「もう一回日本語に戻したらどうなるんだろう」と思い試したのがこちらです

AI的なイントネーションの平板さが増し、漢字の読み下しエラーも生じているようです(おそらく中国語のモデルに引っ張られていますね)

それでも最初の話者からの同一性が残っているのを感じます

<完成>

AfterEffectsでニュース番組風に仕上げてフィニッシュです!

Eleven LabsのDubbing Studioでの「劣化」を意図的にコンテンツ制作に利用したクレイジーな実験記事がこちら ↓

X(Twitter)で

AIニュースをポストしています

フォロー頂けると嬉しいです!

note @note_PRで、AIの考察/検証/コンテンツ実験の眺めの記事を書いていますhttps://t.co/3ijSKrZdsE#note pic.twitter.com/mexlhvbudS

— psymen @AI CREATOR (@PsymenJ) March 14, 2024