映像と音の同期について - 前編 : 同期の感じ方、考え方

映像作品やゲームなどのコンテンツにおいて、「映像と音の同期」は重要な要素の 1 つです。

「映像と音の同期」と一口に言っても、効果音付けの話であったり音楽に合わせた映像演出の話であったりと話題が幅広く、これに対して混同されにくいように整理した上で触れている資料が案外無いな?ということに気がついたので本稿を書いてみることにしました。

同期を完成させるところまでの話を一気にしてしまうと長ーーくなってしまうので、まずは前後編の前編ということで「同期の感じ方、考え方」について押さえていきます!

後編としては、実際に同期を創るためのポイントをインタラクティブコンテンツ由来のものも含めてまとめる予定です!(いつになるかはわかりませんが……笑)

1. 同期のパターン分類

「映像と音の同期」にはいくつかパターンがあり、それぞれ論点が異なってきます。一旦大きく分類してみると、下記のようになります。

映像への効果音付け

音楽に合わせた映像演出

映像と音で同時に行う合図

上記に含まれない映像と音で共通のものを表すもの。映像と音の緩い同期

この分類をもとに、それぞれのパターンに合わせた「同期の感じ方、考え方」を紹介していきます!

2. 映像への効果音付け

まずは、「物が落ちて地面に当たる映像とその時の衝突音」のように直接の因果がある効果音付けを行う場合を考えていきます!

2-1. ぴったり同期

直接の因果があるということで、素直に因果関係の箇所をぴったり同時にすることで、同期して見えることになります。

玉が地面に当たって音が鳴る

2-2. 距離感を加味した同期

しかし、いつでも「ぴったり」が一番良いとは限りません。

発音源が遠くにある(ように見える)とき、音側を若干遅らせることでリアリティが増す場合があります。何故でしょうか……?

玉が地面に当たって音が鳴る(遠)、ぴったり同期

玉が地面に当たって音が鳴る(遠)、音を遅らせる(66.7ms)

(結構微妙な違いで、人によっては区別が付かないかもしれません……。また、実際に距離感を表現するときは音質変化をさせることも多いのですが今回は省略しています)

これは、「距離感の表現」であるといえます。現実世界では光の速さに対して音の速さは遅く、観測者と発音源の距離に応じて音側が遅れて聞こえます。

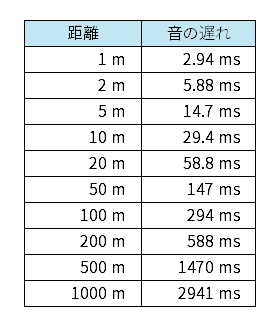

音速は条件によっても異なりますが大体 340 m/s ほどとなっていて、それに対して光速は概ね無視できるほど速いため、距離による遅れは下記のようになります。

観測者との距離と音の遅れの関係 (音速を 340m/s とした場合)

11m ほど離れただけで 30fps での 1 フレーム (約 33.3ms) 程度となり、スケールの大きい表現を行う場合には無視できない遅れであることが分かると思います。

また、ここで言う「距離感」は発音源とカメラとの距離などを単純に採用するだけでよいというものではなく、「どういう距離感を想定して鑑賞しているのか?」を考えて合わせていくことで、よりしっくりとくる表現になります。これは実例を紹介しないと分かりづらいと思いますので、次項からいくつかケースに分けて紹介していきます。

2-3. 「スケール感を出す」距離感想定

現実で大きな爆発音などのスケールの大きい音を近くで聴くのは困難です。そういった音を聴く場合、ある程度遠い距離から聴いている状況を自然と想定することになります。

一方で、映像に関しては距離はカメラのズームなどである程度吸収できてしまうのでさほど距離が気にされない場合があります。

そのため、音の距離感は映像の距離感とは別に考えて遅延時間を調整することで、自然な表現に繋げることができます。

玉が地面に当たって音が鳴る(大)、距離分以上に音を遅らせる(100ms)

2-4. TPV の距離感想定

映像作品でのカメラの視点は、主人公の視点である FPV(First-Person View、一人称視点) ではなく TPV(Third-Person View、三人称視点) になっている場合が多いです。ゲームにおいても TPV のものが多く存在します。

TPV の場合、オーディオ表現を主人公の体験に寄せるべきか?カメラ位置にマイクがある体での再現に寄せるべきか?などのいろいろな悩みが生じます。

まず「リスナー」の悩みがあります。「リスナー」については以前にまとめているのでこちらも参照していただけると嬉しいです!

「距離感想定」を考える場合にも、いい具合の位置 (距離感想定リスナーの位置とも言えます) などを検討する必要がありそうです。個人的にはリスナー位置よりも更に主人公(プレイヤー)寄りで考えられるケースが多いかな?と思っています。

色々な考え方があると思いますが、大切なのは「受け手に感じて欲しい距離感」を表現することです。

2-5. 「昔のアニメや映画」の距離感想定

昔のアニメや映画 (1930〜1980 年くらい) を見ていると、映像に対して 30fps での 2〜4 フレーム程度 (距離感でいうと 22〜45m 程度) の音の遅れが採用されている場合が多いことに気がつきます。

この遅れについては「動画先行の原則」などとして触れている資料を見つけることができます。クリエイターの経験則によって採用されてきたもので、由来は諸説あるようです。

ただし、「映像への効果音付け」の文脈におけるこの傾向はある程度昔の作品に特徴的に多く見られるもので、昨今の作品ではあまり見られません。そこについては誤解されているケースがあると感じています。

(後術する「音楽に合わせた映像演出」も多用されている作品で言及されているために他の理由での映像先行と混同しやすいのだと思います……)

この遅れについて、個人的には一つの仮説を立てて納得しています。真偽のほどは分からないので、詳しく確認してくださる方がいましたらお願いします……笑

仮説 :「昔の人が映像作品を見るとき、距離感の印象の基準として舞台演劇が意識されていたのではないか?」

舞台演劇での演者と観客の距離感は 20m〜40m 程度になると思うので、採用されていた遅れと概ね一致しています。また、最近では舞台演劇よりテレビドラマなどのような近い距離感で演出されるコンテンツのほうが馴染みが良くなってきたため、現代でこの傾向が廃れてきているということとも一致します。

2-6. 「打ち上げ花火」の距離感想定

打ち上げ花火を見るとき、音源からの距離は 300m〜数km ととても離れており、音の遅れは秒単位の大きいものとなります。

しかし、これを動画などで見てみると、あまりいい感じには見えなかったりします。

打ち上げ花火の撮影動画

これは、音源からの距離が日常に馴染みがないほど離れているために、距離感の想定が上手く機能していないと考えることができそうです。

こういった場合は実際の距離をそのまま反映せずに、感覚に沿った距離感に調整するほうがいい感じに見えることがあります。

打ち上げ花火の撮影動画、音修正

(歓声が若干前に漏れちゃっていますが御愛嬌としてください……)

このように、効果音付けの距離感想定だけでも実にいろいろなパターンがあることがわかると思います!

2-7. 不連続な映像に対しての同期

「映像への効果音付け」の最後の話は距離感想定とはまた違った観点です。

映像作品は、リミテッドアニメーションやカット割りによる映像の切り替わりなど、時に滑らかでない不連続な変化をする場合があります。

十分に滑らかな映像であれば現実に近い形で因果のタイミングを合わせられるのですが、不連続な変化の場合はどうなるでしょうか?

2-1 の例を不連続 (7.5fps) にしたバージョンを見てみましょう。元と同じタイミングで音を鳴らしたものと、若干遅らせたものを用意しました。

玉が地面に当たって音が鳴る(7.5fps)

玉が地面に当たって音が鳴る(7.5fps)、若干音を遅らせる(66.7ms)

見比べてみると、若干遅らせて鳴らすほうがタイミングが合って見えると思います。(個人差はあるかもしれません)

この現象は、確実なことは言えませんが移動するものと急に出現するものの認識の時間差が影響していそうで、「フラッシュラグ効果 (flash lag illusion)」などと関連がある感じがします。

3. 音楽に合わせた映像演出

次に、音楽に合わせた映像を作る場合の同期について考えていきます!

3-1. 因果を想定する

音楽に合わせた映像を作る場合、映像と音に直接の因果が存在しないことが多く、何を何に合わせて良いのか悩むこととなります。

(演奏をしている映像の場合も、カット割りなどの演出は音との直接の因果関係がありません)

今回はその存在しない因果関係に対して「因果を想定する」方法を紹介します。

因果の想定は、映像上の動きを見てどのタイミングで音が鳴ることが想定されるかを考え、そこで鳴る「音」と実際に音楽の中で鳴っている「リズム音」を合わせる作業になります。

次項から具体的な因果の想定のパターンについて紹介していきます。

3-2. 「叩く」因果想定

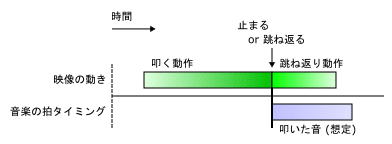

「叩く」因果想定は、映像の動きを何かにぶつかって止まったり跳ね返ったりするようなものと解釈します。止まるか跳ね返るタイミングに拍タイミングが来るように合わせます。

リズムに合わせて玉を何かに当てる

「叩く」因果想定での同期は映像の動きが先行して、映像の動きの後に拍タイミングが来る形になります。

「叩く」因果想定のタイムライン

3-3. 「振る」因果想定

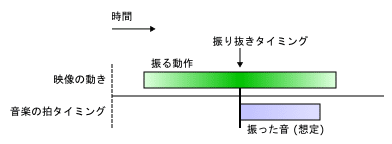

「振る」因果想定は、映像の動きを何かを素速く振り抜いたようなものと解釈します。振り抜きのピークに拍タイミングが来るように合わせます。

リズムに合わせて玉を振る

「振る」因果想定での同期は映像の動きの真っ最中に拍タイミングが来る形になります。

「振る」因果想定のタイムライン

3-4. 「吹っ飛ぶ」因果想定

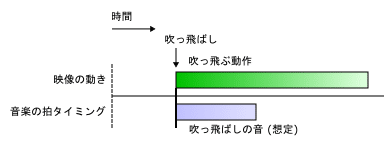

吹っ飛ぶ因果想定は、映像の動きを何かの衝撃によって吹っ飛ばされたようなものと解釈します。映像の動き出しに拍タイミングが来るように合わせます。

リズムに合わせて玉が飛ぶ

「吹っ飛ぶ」因果想定での同期は、拍タイミングが来た瞬間から映像の動きが開始する形になります。

「吹っ飛ぶ」因果想定のタイムライン

3-5. 「カット割り」の因果想定

映像の演出には「カット割り」が存在する場合が多くあります。

「カット割り」も映像の動きの 1 つとしてみなすことができるため、因果想定による同期タイミングの決定が有用です。

例えば、トランジションが入らないシンプルなハードカットの場合は、「叩く」因果想定が近そうです。また、ハードカットは不連続な変化なので 2-7 の影響もふまえて考える必要があります。

リズムに合わせて画面が切り替わる、不連続の「叩く」因果想定 (66.7ms 映像先行)

トランジションが入る場合やカット周辺に大きめなカメラの動きが入る場合は、その動きの種類によって「叩く」「振る」「吹っ飛ぶ」のどの因果想定がやりやすいかが変わってきます。

カット後にカメラを大きく動かすと、「吹っ飛ぶ」因果想定へと意識を向けることができ、「吹っ飛ぶ」因果想定の同期でカットタイミングを決めることでテンポ感の良い演出が可能になります。

分かりやすい例となる素敵な MV があるので、紹介させていただきます!

イロドリミドリ 箱部なる(cv:M・A・O) 『猫祭り』MV

いろいろな因果想定の仕方を理解することで、表現が深まる感じがしますね!

3-6. 距離感想定との組み合わせ

音楽に合わせた映像演出を行う場合、距離感はあまり考えないで作られることが多いと思いますが、状況によっては効果音付けと同じく距離感想定が効果的になりそうです。

例えば、ミュージカルをイメージした演出などでステージから客席までの距離を想定した音の遅れを反映させることは、よりしっくりくる表現に繋がるかもしれません。

4. 映像と音で同時に行う合図

続いて、「アラート通知を GUI 表示と効果音で行う」など、映像と音で同時に行う合図について考えていきます。

このケースでは映像と音に「同時に合図したい」以外の直接的な因果が無いので、これまでの考え方をそのまま使うのは難しそうです。(映像と音の内容の組み合わせによっては因果想定ができる可能性もあります)

一方「同時に合図したい」を言い換えると「同時に認識させたい」ということになり、同時に認識させるためには映像と音で認識にかかる時間が長い(遅い)ほうをその分だけ先に発生させれば良いことになります。

認識にかかる時間の差を知るためには反応時間 (映像や音の刺激から手でボタン等を押すまでの時間) の差が参考になります。視覚情報と聴覚情報に対する反応時間には差があり、調べてみると平均的には聴覚情報のほうが短い(速い)らしいという情報が見つかります。

そのため、認識を同時にするには若干映像を先に表示することが考えられます。とはいえ、認識にかかる時間には個人差があり映像や音の内容によっても異なってくるはずなので、決め打ちの遅延時間で合わせるのは難しいと思われます。(なのであえて時間を記載しません。)

5. 映像と音の緩い同期

最後は、前の 3 つに属せず同期が緩い場合を考えます。「音声に対して字幕の出るタイミング」などが該当します。

このタイプの同期は、正直なところケースバイケースというか演出意図次第なので、明確な答えはありません。

映像先行にしたほうが情報の受け取りとしては安定するなどの考え方はありそうですが、あえて音に意識を向けるために音先行にする方法も取られることがあります。「映像の場面転換に先行して音だけ次の場面の音になる」のような技法も使われることがあるくらいなので、柔軟に考えるのが良さそうです!

前編のおわりに

前編では「同期の感じ方、考え方」についていろいろと紹介してみました。完全に理論化できているような内容ではないのですが……、同期という概念の幅広さや難しさが伝われば嬉しいです!

察しの良い方は既にお気付きのことかと思うのですが、本稿は「X フレーム映像先行しとけばいい」的な雑な解説が蔓延している状況に耐えきれなくなって書いています、笑。

映像先行になるケースが多いとはいえ、あくまで同期の基本は「因果関係の箇所をぴったり同時にする」ことです。

そして、同じ映像先行だとしても「光速と音速の違い」「不連続な映像に対しての同期」「映像の動きと音の因果(想定)」「視覚と聴覚の反応時間の違い」と様々な要因から導かれ、要因ごとに先行する時間に対しての考え方も異なってきます。

いろいろなパターンを感じたり考えたりすることで、同期を創る際の参考になればと思います!

後編予告?

インタラクティブコンテンツ上での映像と音との同期を「創る」ためには、同期をある程度機械的にコントロールする必要があります。

そのため、「同期の感じ方、考え方」もルール化できるまで掘り下げることが重要でした。その内容がこの前編です。

しかし、それだけでは実際に「創る」ためにはまだ足りません!後編はいつになるか分からないので……、トピックだけでもリストアップしておいてみます。……やー大変そうですね……。

映像と音の時間制御の違い

正確なフレームレートを知る

波形の立ち上がり時間

音楽の拍の頭ってどこ?

映像の遅延、音の遅延

音楽基準の同期制御

同期が崩れる場合と復帰について

参考

映像と音の同期―「動画先行の原則」の根拠と応用

Flash lag illusion - Wikipedia

反応時間 - Wikipedia

産総研:視覚と聴覚で異なる時間判断の仕組みの一端を解明

(本稿と直接の関係は薄いのですが、場合によって時間判断が異なることについての研究が興味深いです)