Excelの定例データ処理の効率化:Power BI Desktopの活用

概要

従来の手動の複雑なExcelデータ処理を、Microsoft Power BI Desktopを活用して自動化する業務設計の例です。Power BI Desktopを無料のデータ変換ツールとして活用し、ファイルを読み込み後csvファイルにエクスポートして完了するようにしました。

ストーリー No.1

Excelデータ処理の引継ぎ

前任者:「データ処理のメモです。複雑な処理なので作業に1日かかります。」

このようなデータ処理前とデータ処理後のファイルの形式は決まっているExcelデータ処理業務の引継ぎを受けました。前任者は、Excel関数やPivotテーブルなどを活用して、毎回手作業を繰り返していたようです。

業務の再設計

目標

Excelファイルとして提供される編集前ファイルを編集して、規定のデータ処理後ファイルを作成する。

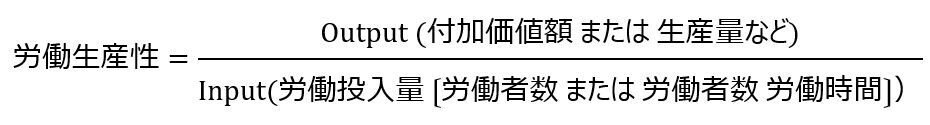

労働生産性

Output:データ処理後のファイルの形式は既定

労働生産性を向上させるには、Inputを小さくすることを考えます。

(ある期間の)作業時間合計

(ある期間の)作業時間合計=1回の作業時間×作業回数

依頼時の状況から、繰り返し同じ作業を行うことがわかります。

効率化できれば生産性向上効果が大きくなります。

作業後の検証

手動作業の場合、ミスの発生の有無が論理的にわからないため、作業後の検証も必要です。

自動化すれば、再現性が確立され検証作業はなくなります。

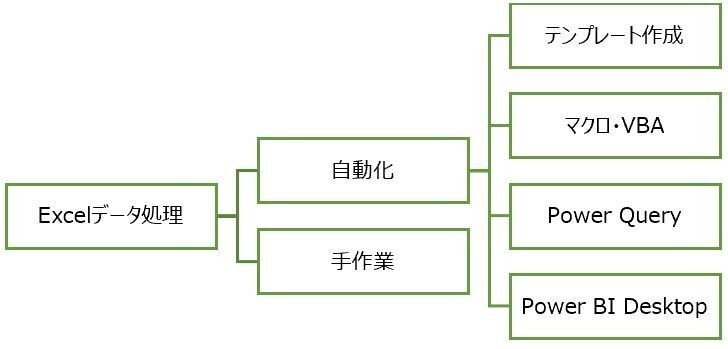

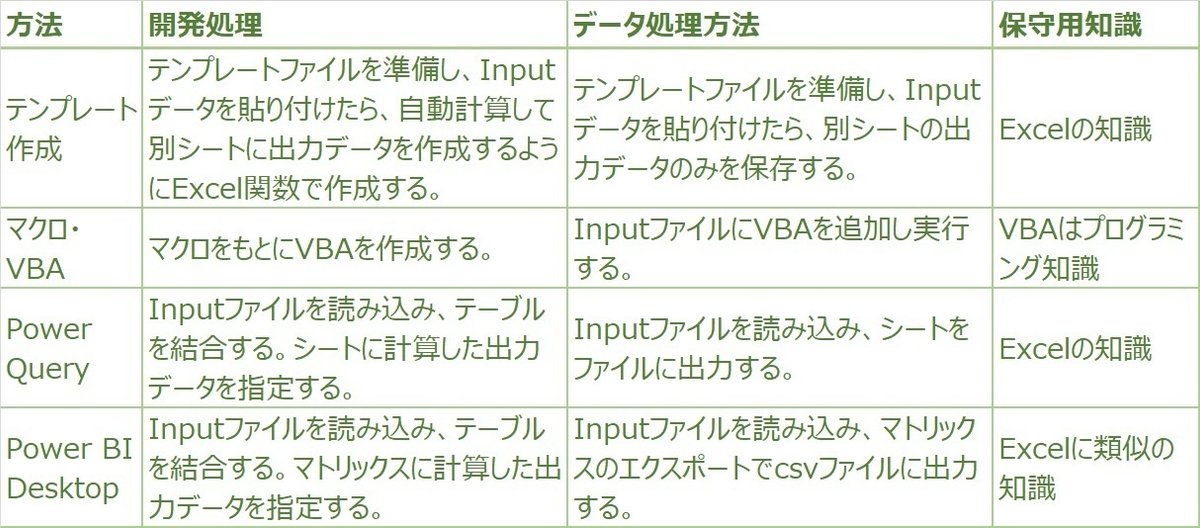

データ処理方法の検討

Excelのデータ処理方法には、どのような方法があるのか検討します。

開発・保守の検討

データ処理を効率化するには開発作業と保守作業を検討します。将来担当者が変わっても、データ仕様の変更があっても保守していくことを考慮します。

開発工数予測

開発工数を、データ仕様作成・計算関数調査・作り込み・検証と修正・手順書作成・予備に各半日、合計3日と予測しました。3回のデータ処理分の工数で、投資が回収できる見込みです。

新作業手順への移行

新データ処理方法の決定

今回は3シートあるファイルを読み込み、複数のテーブル結合やフィルタリング、変換処理を行う複雑な作業のため、Power BI Desktopを活用することにしました。

開発・検証

開発は、Excelシート間のテーブル結合をし、マトリックス上にデータ処理後の列を準備し、読み込んだExcelデータをもとに計算式を記入します。Excel関数が利用できる知識があれば、MicrosoftのPower BI Desktopドキュメントを参考に、テーブル結合とPower BI関数のローコードプログラミングを担当者自身で開発できます。

開発後の検証も、計算式を明確にしているため、問題が発生してもすぐに原因がわかり対応できました。

新データ処理手順

引き継いだExcelデータ処理は以下の作業手順となり、3分で完了するようになりました。生産性向上効果は100倍以上です。(3分/480分=0.00625)

① 毎回、Inputファイルを読み込み、マトリックスのエクスポートでcsvファイルに出力します。

② csvファイルを開き、1行目の不要文字を一括置換で削除して保存します。(xlsx形式にしたい場合は保存時にファイル形式を変更して保存します。)

保守

データ仕様・計算式・検証結果・手順書も準備できました。将来担当者変更があっても、データ仕様の変更や入出力データの変更は、Excel程度の知識があれば大丈夫でしょう。

まとめ

新ツール活用を念頭に定期的に業務手順を見直すことで、生産性向上効果が見込める可能性があります。根本的な目的の業務改革がすぐにできなくても、個人レベルの生産性向上は可能です。

プチDXでは、低コストまたは無料で利用できる方法を検討することで、投資対効果を向上させ速やかな実現を目指します。個人個人が今できる生産性向上を積み重ねて、日本の生産性向上につなげます。

※上記のExcelデータ処理の引継ぎのストーリーはフィクションです。