Google DeepMindが提案する「AGIのレベル」: 人工知能の進化を理解するための新しい枠組み

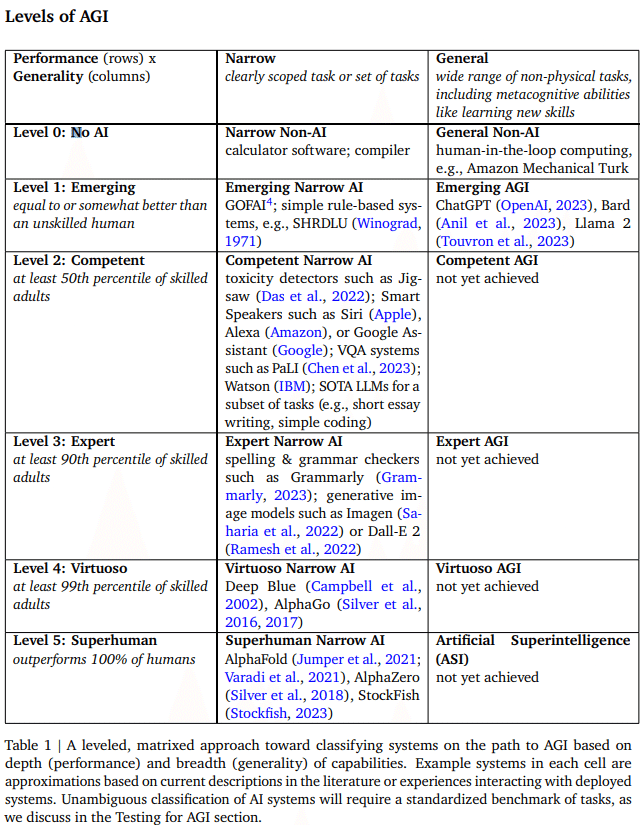

今週、Google DeepMindが発表した最新の研究論文「Levels of AGI: A Framework for Comparing the Power of Different AI Systems」では、異なるAIシステムの能力を理解し比較するための枠組みが提案されています。この記事では、そのPDF内容を詳細に解説し、人工知能(AI)が人工汎用知能(AGI)へと進化する過程を4つのレベルに分けて考察します。

https://arxiv.org/pdf/2311.02462.pdf

AGIの定義:ケーススタディ

AGIを定義する試みは多くありますが、ここでは特に注目すべき9つの例を取り上げ、それぞれの強みと限界について考察します。

ケーススタディ1: チューリングテスト チューリングテストは、AIが人間と区別がつかないほどのテキストを生成できるかを評価するものです。しかし、現代の大規模言語モデル(LLM)がチューリングテストをパスする例もあり、この基準だけではAGIを評価するには不十分であるとされています。

ケーススタディ2: 強いAI – 意識を持つシステム 意識を持つとされる「強いAI」はAGIへの一つのアプローチですが、機械が意識を持つかどうかを科学的に判断する方法には合意がありません。

ケーススタディ3: 人間の脳への類似 AGIは、人間の脳と同等かそれ以上の複雑さと速度を持つAIシステムとして定義されることがあります。しかし、人間のような学習方法に依存しないトランスフォーマーベースのアーキテクチャの成功は、厳密な脳ベースのプロセスやベンチマークがAGIに必須ではないことを示唆しています。

ケーススタディ4: 認知タスクにおける人間レベルのパフォーマンス AGIは、人間ができる認知タスクを実行できる機械としても定義されます。ただし、どのタスクか、どの人間かという選択にはあいまいさが残ります。

ケーススタディ5: タスクの学習能力 AGIは、特定のタスクに特化せず、人間と同じくらい広範囲のタスクを学習し実行できるAIとされています。この定義は、メタ認知タスク(学習)の価値を強調しています。

ケーススタディ6: 経済的に価値のある仕事 OpenAIの憲章では、AGIを「ほとんどの経済的に価値のある仕事で人間を上回る高度に自律的なシステム」と定義しています。しかし、経済的価値だけでは「一般知能」の全てを捉えているとは限りません。

ケーススタディ7: 柔軟で一般的な知能 – 「コーヒーテスト」など AGIは、人間の知能と同等かそれ以上の資源を持ち、柔軟で一般的な知能として定義されることもあります。この定義は、AGIが十分な一般性を達成するためには、新しいスキルを学ぶ能力などのメタ認知タスクを含む必要があることを示唆しています。

ケーススタディ8: 人工的な能力知能 「人工的な能力知能(ACI)」は、複雑な多段階のタスクを実世界で達成できる十分なパフォーマンスと一般性を持つAIシステムを指します。この定義は、経済的価値に基づいたものであり、複雑な実世界のタスクに焦点を当てています。

ケーススタディ9: SOTA LLMs as Generalists 最先端のLLM(例えば、2023年中期のGPT-4など)は、幅広いトピックについて議論し、多様なタスクを実行し、多言語で操作できるため、AGIと見なされることもあります。しかし、パフォーマンスの観点から、その一般性が十分に実行可能であるかどうかは明らかではありません。

AGIの6つの原則:

能力に焦点を当てる:AGIの定義は、プロセスではなく、AGIが達成できることに焦点を当てるべきです。これにより、人間のような思考や意識、感情を持つことはAGIの必要条件ではないとされています。

一般性とパフォーマンスに焦点を当てる:AGIの定義は、一般性とパフォーマンスの両方を重視すべきです。これにより、AGIが多様なタスクを高いレベルでこなす能力が重要視されます。

認知的およびメタ認知的タスクに焦点を当てる:物理的なタスクよりも認知的なタスクに重点を置くべきですが、新しいタスクを学ぶ能力や助けを求めるタイミングを知る能力などのメタ認知的能力はAGIにとって重要です。

可能性に焦点を当てる:AGIは実際に展開される必要はなく、必要なタスクを実行できる潜在能力があれば十分です。展開を定義に含めると、法的、社会的、倫理的、安全性の問題が生じる可能性があります。

生態学的妥当性に焦点を当てる:AGIの進歩を測定するためのベンチマークとして、実世界で価値のあるタスクを選ぶことが重要です。経済的価値だけでなく、社会的価値や芸術的価値も含めて広く価値を捉えるべきです。

AGIへの道のりに焦点を当てる:AGIの「レベル」を定義することで、AGIに関する政策や進捗について明確な議論が可能になります。各レベルは明確なメトリックス/ベンチマークと、そのレベルで導入されるリスク、そして人間とAIの相互作用のパラダイムの変化を関連付けるべきです。

これらの原則に基づいて、AGIの進捗を測定するためのレベルベースの分類法を次のセクションで紹介します。AGIの定義には多くの形が共存することが可能で、例えばAguera y Arcas & Norvigの定義は「新興AGI」カテゴリーに、OpenAIの労働置換の閾値は「Virtuoso AGI」に合致します。多くの既存のAGI定義に最も適合するのは「Competent AGI」レベルでしょう。

人工知能の4つのレベル

レベル1: 狭義のAGI

特徴: 特定のタスクに特化。

能力: 特定のタスクを人間以上にこなすが、その応用範囲は限られる。

事例: チェスのグランドマスターレベルでプレイするAI。

レベル2: 広域ドメインAGI

特徴: 一つのドメイン内で幅広いタスクをこなす。

能力: そのドメイン内での様々なタスクを学習し、適応することができる。

事例: 翻訳、要約、質問応答など、言語に関連する全てのタスクをこなすAI。

レベル3: 広範囲能力AGI

特徴: 多くのドメインでの能力を持つ。

能力: 多様なドメインで高いパフォーマンスを発揮し、少ない人間の指導で新しいタスクを学ぶ。

事例: 様々なゲームを高いレベルでプレイし、科学研究も行うAI。

レベル4: 完全なAGI

特徴: 人間の認知能力に匹敵する。

能力: 人間ができる任意の認知タスクを学習し、自律的に新しいドメインをマスターする。

事例: あらゆる人間の職業を高い水準で学びこなすAI。

枠組みの応用

ケーススタディ: 既存のAIシステムに対するこの枠組みの適用例。

比較分析: 提案されたレベルに基づいた異なるAIシステムの比較。

将来予測: AIシステムの発展軌道の予測。

考察と影響

倫理的考慮: AGIが進化するにつれての倫理的な影響。

政策とガバナンス: 高レベルのAGIへの移行を管理するための政策とガバナンスの推奨。

研究方向: 有益で安全なAGIの発展を確保するための研究方向性。

この論文は、研究者、政策立案者、そして一般の人々がAIのAGIへの進歩を議論し評価するための共通言語と基準を提供することを目的としています。AIシステムがより高い能力を持つようになるにつれて、社会への影響に備えることの重要性が強調されています。

専門家の視点

この枠組みは、AIの進化を段階的に捉えることで、その発展の速度と方向性を予測する上で非常に有用です。特にレベル4の完全なAGIは、今のところ理論的な概念に過ぎませんが、その到達点に向けた研究は、技術的なブレークスルーだけでなく、社会的、倫理的な準備が必要であることを示唆しています。AIの発展がもたらすポテンシャルとリスクをバランス良く管理することが、今後のAI研究における最大の課題となるでしょう。

この記事が気に入ったらサポートをしてみませんか?