いまさら聞けない!LLMを最適化する鍵、Scaling Law(スケーリング則)徹底解説【学習ソースあり】

AI技術の最前線を行く大規模モデルの開発では、「スケーリング則」がキーワードになっています。しかし、この法則を理解し活用するには、誤解を避け、正確な知識を身につけることが不可欠です。そこで、この記事ではスケーリング則の基本から応用、よくある誤解、そして計算方法に至るまで、一貫した解説を行います。

スケーリング則とは何か?

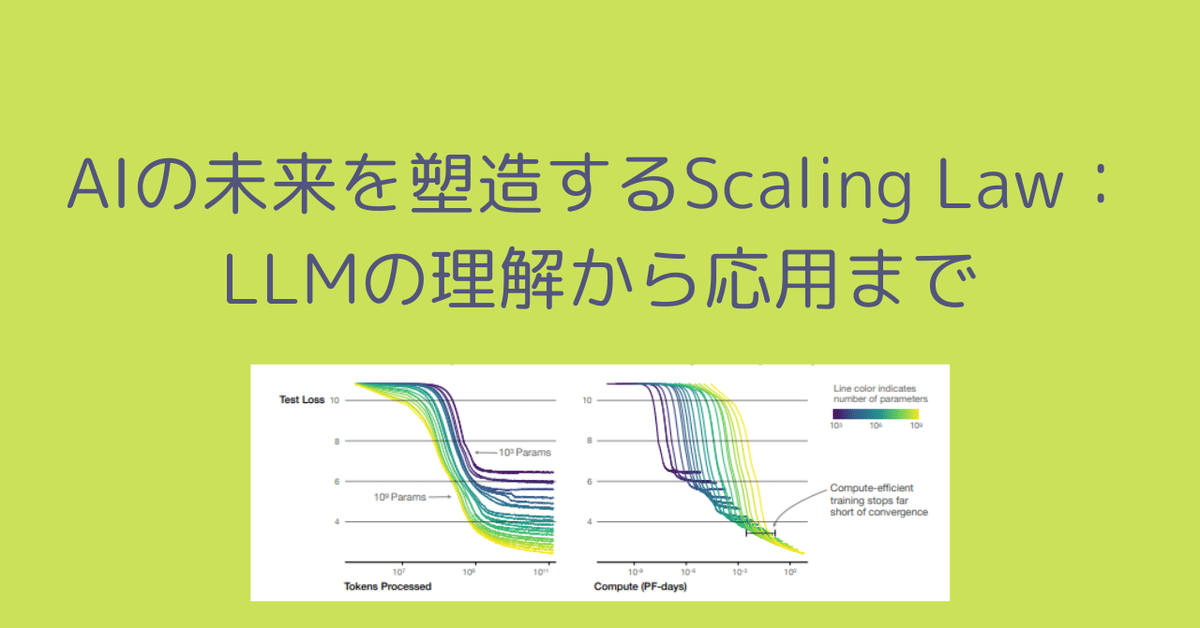

スケーリング則は、大規模な機械学習モデルにおいて、モデルのサイズ、データ量、計算リソースの増加が性能にどのように影響するかを定量的に示します。

基本概念:モデルのサイズやデータ量が増えるほど性能が向上するが、その向上率は徐々に鈍化します。

性能向上の限界:無限のリソース投入が無限の性能向上を意味するわけではない。

スケーリング則の誤解を解く

スケーリング則には、多くの誤解があります。ここでそのいくつかを明らかにしましょう。

無限の向上はない:モデルのスケーリングは、ある点で性能向上のペースが鈍化します。

一律の法則ではない:異なるモデルやタスクでは、スケーリング則の影響が異なる場合があります。

複数のメトリクスが重要:性能向上は、エラー率の減少だけでなく、モデルの一般化能力など、多面的に評価されるべきです。

スケーリング則の計算方法

OpenAIの研究は、スケーリング則を理解する上で重要な基礎を提供します。以下はその計算方法です。

スケーリング指数の推定:実験データを用いて、モデルサイズやデータセットの大きさ、計算時間と性能との関係を定量化します。

損失関数の構築:推定された指数を用いて、損失関数を構築し、性能を予測します。

リソースの最適化:計算リソースの割り当てにスケーリング則を活用し、最適なモデルサイズや計算時間を割り出します。

スケーリング則の応用

スケーリング則は、資源配分から性能の予測、新しいアーキテクチャの評価まで、幅広い応用があります。

資源配分:計算リソースをどのように割り当てるかを決定する際に役立ちます。

性能の予測:設計段階でモデルの性能を予測し、戦略を立てるのに有用です。

新しいアルゴリズムの評価:新しいモデルが従来のものと比較してどのような性能を持つかを評価します。

本文の参考と学習用ソース

基本的な理解のためのリソース

Stanford cs224n講座動画「Scaling Language Model」

スタンフォード大学のこの講座は、スケーリング則の基礎を理解する絶好の出発点です。動画では、言語モデルがどのようにスケールし、その影響がモデルの性能にどう反映されるかが詳しく説明されています。

Stanford cs324講座スライド「Scaling Laws」

より数学的なアプローチを求めるなら、スタンフォード大学のこの講座スライドが適しています。スケーリング則の数理的な背景と、それがLLMの開発にどのように応用されるかの例が示されています。

https://stanford-cs324.github.io/winter2022/assets/pdfs/Scaling%20laws%20pdf.pdf

実践的な応用を学ぶ

Chinchilla Scaling Lawの論文

DeepMindが提出したこの革新的な論文では、LLMを訓練する際に最適なデータとモデルサイズのバランスを見つけるための新しいアプローチが提示されています。特に、リソースの有限性の下で最大の効果を達成する方法に焦点を当てています。

OpenAIによるスケーリング則に関する論文

OpenAIは、スケーリング則に関する先駆的な研究を多数行っており、この論文では、モデルの性能がサイズ、データセット、計算量にどのように依存するかが詳細に分析されています。

進んだトピックと議論

Sasha RushによるSimon Instituteでの講演「Scaling Data-Constrained Language Models」

データが制約されている状況でのスケーリング則の応用に焦点を当てたこの講演は、LLMの研究者や開発者に新たな視点を提供します。

https://simons.berkeley.edu/talks/sasha-rush-cornell-university-hugging-face-2023-08-15

ブログ「Go smol or go home」

Chinchilla Scaling Lawに対する批判的な視点を提供し、スケーリング則の適用における課題と限界を探ります。進んだ知識を持つ読者には、既存の理論への挑戦となるでしょう。

https://www.harmdevries.com/post/model-size-vs-compute-overhead/

Yasaman BahriのSimon Instituteでの講演「Understanding the Origins and Taxonomy of Neural Scaling Laws」

スケーリング則の起源とその分類について深く掘り下げたこの講演は、上級者に向けた内容です。スケーリング則がなぜ機能するのか、その理論的根拠について理解を深めたい方に最適です。

https://simons.berkeley.edu/talks/yasaman-bahri-google-deepmind-2023-08-15

結論

スケーリング則は、AI技術の発展において中心的な役割を果たします。この法則を正しく理解し適用することで、リソースを最適に配分し、モデルの性能を最大化できます。ただし、その応用にあたっては誤解を避け、正確な計算方法を用いることが重要です。スケーリング則を活用することで、機械学習モデルの設計から実運用に至るまで、より効率的かつ効果的な進化が可能となるでしょう。