アートの未来を守る:Nightshadeによるデータポイズニングの可能性

アーティストたちがジェネラティブAIの進化に対抗するための新しいツールが登場しました。このツール「Nightshade」は、アーティストの作品がAI企業に無断で利用されることへの対策として開発され、デジタルアートの世界での権利と認識の闘争に新たな一石を投じています。

Nightshadeの概要と機能

開発背景: アーティストたちが自分の作品を保護するため、シカゴ大学のベン・ザオ教授(Zheng, Ben Y. Zhao Department of Computer Science, University of Chicago)が開発。

基本原理: アート作品に目に見えないピクセルの変更を加え、AIモデルがこれをトレーニングデータとして使用すると、予測不可能な出力を引き起こす。

目的と効果: AI企業がアーティストの許可なしに作品を使用することに対する強力な抑止力を提供。

隠された変更: アーティストは作品に目に見えない変更を加え、オンラインにアップロードする。この変更はAIトレーニングデータを破壊する潜在力を持つ。

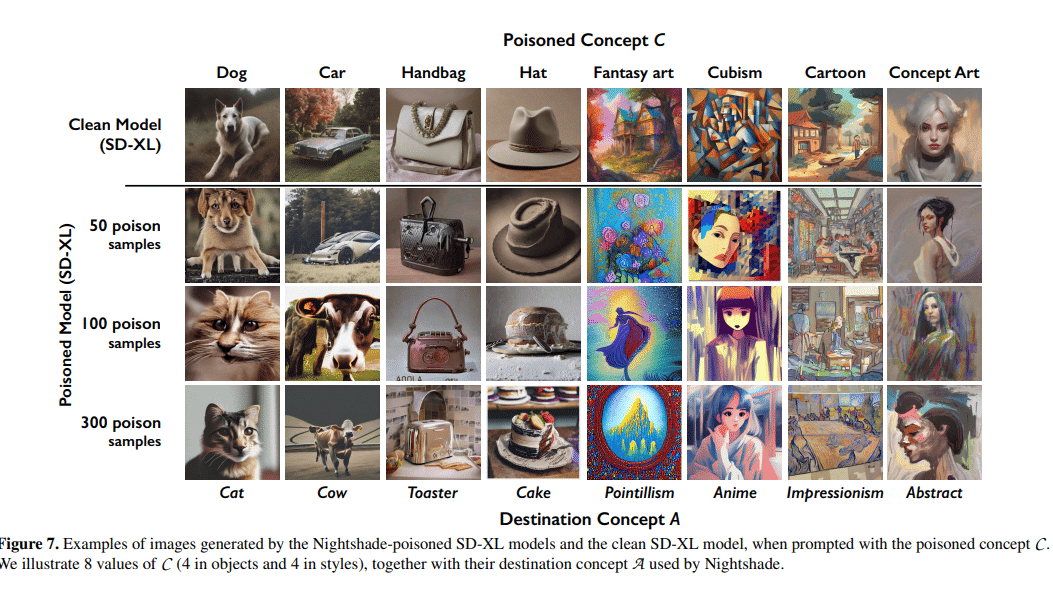

機能: AIモデルがこれらの画像を使用すると、出力が混乱し予測不能に。例えば、犬が猫に、車が牛に変わる可能性がある。

研究のプレビュー: MITテクノロジーレビューは、この研究の独占的なプレビューを得ており、Usenixコンピュータセキュリティ会議での査読が進行中。https://www.technologyreview.com/2023/10/23/1082189/data-poisoning-artists-fight-generative-ai/

著作権侵害に対する対策

訴訟の増加: OpenAI、Meta、Google、Stability AIなどのAI企業は、無断で作品や個人情報をスクレイピングしたとして、多数のアーティストから訴えられている。

権力バランスの変更: Nightshadeの開発者、ベン・ザオ教授は、このツールがアーティストの権利を守り、AI企業に対する強力な抑止力を提供することを望んでいる。

Glazeツールとの統合

個人スタイルの保護: Glazeは、アーティストのスタイルをAIから隠すために開発されたツール。Nightshadeと同様に、画像のピクセルを微妙に変更し、AIモデルが画像を異なるものと認識するように操作する。

オープンソース化: Nightshadeはオープンソースとして公開され、他者が改良し利用できるようになる。これにより、より多くの人が使用し、ツールはより強力になる。

AIモデルへの攻撃

セキュリティの脆弱性: AIモデルはインターネットから収集された大量のデータに基づいてトレーニングされる。Nightshadeはこの脆弱性を利用し、データを操作する。

汚染されたデータの影響: AI開発者がインターネットをスクレイピングして新しいモデルを構築する際、これらの汚染されたサンプルがモデルのデータセットに取り込まれ、機能不全を引き起こす。

実験結果: 研究者たちはStable Diffusionの最新モデルに対して攻撃を試み、わずか50枚の汚染画像で出力が異常になることを確認した。

法的および倫理的課題

悪用のリスク: Zhao教授は、データポイズニング技術が悪用されるリスクがあることを認めている。ただし、大規模で強力なモデルに実際のダメージを与えるには、何千もの汚染サンプルが必要とされる。

防御策の必要性: コーネル大学のVitaly Shmatikov教授は、現代の機械学習モデルに対するポイズニング攻撃に対する堅牢な防御策がまだないことを指摘し、対策の必要性を強調しています。彼は、こうした攻撃が現実に起こるのは時間の問題であり、すぐに防御策を講じるべきだと述べています。

モデルの脆弱性と今後の影響

研究の重要性: ウォータールー大学のGautam Kamath助教授は、この研究を「素晴らしい」と評価し、新しいモデルでも脆弱性が消えないことを示していると述べています。

トレーニングデータの操作: データポイズニング攻撃は、トレーニングデータを操作して機械学習モデルに予期せぬ振る舞いを導入する。特に、巨大なトレーニングデータセットを持つテキストから画像への生成モデルでは、成功した攻撃には数百万の汚染サンプルの注入が必要とされる。

総括:

NightshadeとGlazeの開発は、AIモデルのトレーニングにおけるアーティストの権利を守るための革新的なステップです。これらのツールは、著作権侵害や個人的なスタイルの無断使用に対するアーティストの抗議を具体化し、AI企業とアーティスト間の力のバランスを変える可能性があります。しかし、技術の悪用やAIモデルのセキュリティ脆弱性に対する懸念も残ります。Nightshadeの将来的な影響とAI業界における倫理的な議論は、引き続き重要な焦点であり続けるでしょう。