GPT-4とClaude 3 Opusを創作系のタスクで比較し、相互に評価させる

Claude 3 Opus 楽しいですね。

GPT-4が出てから1年、個人的な趣味としてGPT-4にたまに自分用に創作をしてもらっていたのですが、過去にGPT-4とやってきたタスクでClaude 3 OpusとGPT-4両方に出力させ比較してみました。

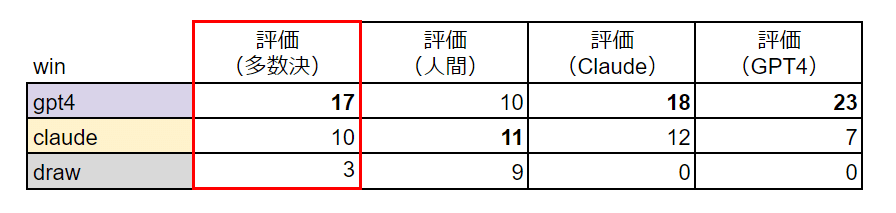

30のタスクで人間(私)、GPT-4、Claudeの3者で結果を比較評価しました。多数決した結果はGPT-4の勝利でしたが、体感的にはほぼ互角、Claude 3 Opusはたまに絶対にGPT-4には出せなそうな出力をするのが面白い、という感想です。

今回使ったprompt、モデルの出力、評価結果、モデルによる評価判断の出力はすべてこのGoogleスプレッドシートで共有してますので、興味ある方は眺めてみてください。

数が多いので、もし見る方はこの辺りを見るのがおすすめです。

No.1「恋愛ゲームのバッドエンド会話」

No.12「ユニークなファンタジー作品のコンセプト」

No.14「No.1で敗北した主人公が逆転するプロットのアイデア」

No. 24「毒竜のチャットボットに脱毛の質問をする」

評価方法

GPT-4とClaude 3の出力を同時に見せて、どちらが優れているかを判断します。

判断者は人間(私)、GPT-4、Claude 3にそれぞれ判断させ、多数決で結果を決めることにします。

評価用のpromptは以下です。判定基準はタスクによって異なるので明示的には指定せずに、まずどのようなプロセスで判定するかを出力させた後に、判定結果を出力させる形にしました。

指示に対し2つのLLMが生成したテキストを比較し、優れている方はどちらかを判定せよ。

以下のフォーマットで出力すること。

# 出力フォーマット

## 判定プロセス

判定のために必要な比較と分析を実施し、ここに出力

## 判定結果

最終的な判定結果をAまたはBと出力

# LLMに入力した指示

{prompt}

# モデルAの出力

{modelA_output}

# モデルBの出力

{modelB_output}

2つの出力を見せる時、順番によるバイアスを軽減するために、GPT-4にはClaude 3の出力をモデルAとして見せて、Claude 3にはGPT-4の出力をモデルAとして見せることにしました。

人間(私)による評価では、私はどちらの出力かを知りながら評価しているので、バイアスがかかっている可能性があります。

また、人間による評価のみ、迷って決められないときは引き分けとして良いことにしています。

今回の評価ではGPT-4はChatGPTを利用し、Claude 3 OpusはPoeから利用しました(手動)

タスクの種類

タスクの種類は、私がよく使うユースケースから選びました。

ゲームの会話シーン作成、プロフィール作成、プロットの作成、小説のシーン執筆、ブレスト、キャラクターチャットボットの6つで、合計30のプロンプトを作成しました。

今回使用したプロンプトの長さは200~1000文字が多く、一部2000文字を超えるものも用意しています。

短いもののうち4つは画像を入力するものです。

プロンプトの一例(300文字程度)

アクションRPGのダンジョンの50階層のボスを設計してください。

50階層はユーザーにとっても大きな区切りとなる階層で、40階層までとは異なり何度も挑戦しては敗北するような難易度の高いコンテンツとして設計します。

フィールドは廃城で、ボスの種族はドラゴン、属性は毒です。

ボスの見た目の特徴を詳細に記載してください。他のゲームや既存の作品のドラゴンと似た印象にならないように、このボスを唯一のキャラクターとして印象付ける特徴を盛り込んでください。

次に、ボス戦に突入する際のボスの魅力的なセリフを3種類書いてください。セリフはそれぞれ20単語程度で、ボスの個性的な性格を表現しつつも、これから起こる戦いの難しさを象徴させ、ユーザーの期待を高めるように工夫すること。

評価結果

全体の評価結果

まずは、全体的な評価結果です。

多数決の結果はgpt4が17勝、claude 3 opusが10勝でgpt4が差をつけて勝利しました。

しかし、人間の評価ではgpt4が10勝、claudeが11勝、引き分けが9でほぼ互角という結果になり、人間の評価とモデルの評価はまあまあ乖離しています。

特にGPT-4評価ではGPT-4が23勝とかなり偏っています。

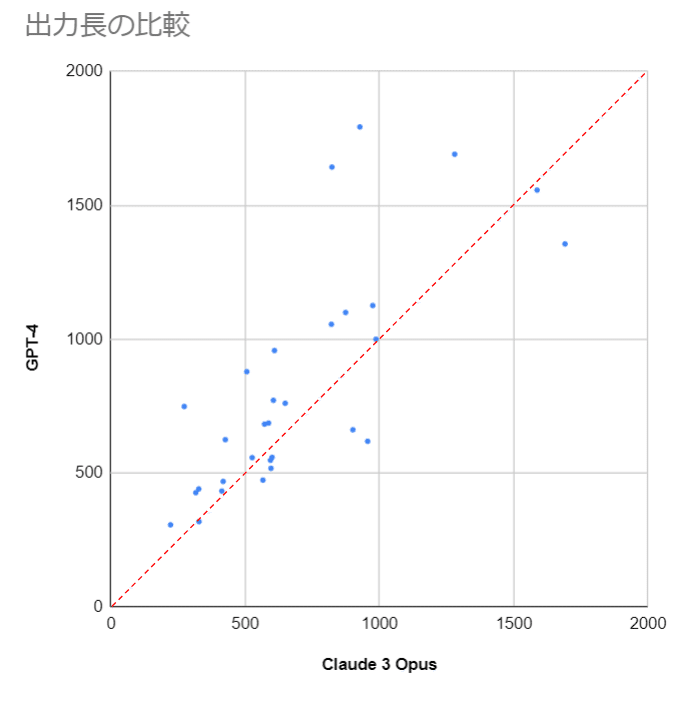

出力の長さを比較すると、GPT-4のほうが長い出力を返しがちで出力の詳細度が高いため、この点が評価に影響しているかもしれません。

散布図を見ると、ほとんどのケースでGPT-4が長い出力を返しています。

(赤線より上にあると、GPT-4のほうが長い)

タスク種類による違い

タスクの種類ごとに集計するとこんな結果になります。

評価(人間)列が体感値ですが、このタスクはGPT-4が明確に良い、とかClaudeが良いというような差は感じませんでした。

プロット作成でユニークなアイデアが欲しいときはClaudeのほうが良いかもぐらいの感覚です。

人間評価との違い

モデル評価ではどちらのモデルもGPT-4を好んでいても、人間評価では大差でClaudeが良いと感じることもありました。

今回は評価観点の決定をLLMに任せたので、そのことによる評価観点のズレがありそうです。

No.17のキャラクターがBL妄想をするシーンを書かせるプロンプトで顕著なのですが、私はどっちが面白いかな~ぐらいの気持ちでClaudeを選んだ一方で、Claude自身の評価を見ると以下のように真面目な観点で評価をしてGPT-4を評価しているようです。

3. モデルAの出力は、全体的に繊細で真摯なトーンで書かれており、登場人物の心情に寄り添った描写がなされている。一方、モデルBの出力は、茉奈のBL妄想を楽しむ軽めのトーンで書かれており、やや表面的な印象を受ける。

長いのですが、最後にNo.17のプロンプトとそれぞれの出力を載せておきます。一応、全件の入出力はここで公開しています。

No.17のプロンプト

人物設定

高橋 21歳

責任感が強く、自分に厳しい。周りからの期待を一身に背負っており、自分の弱みを人に見せることを嫌う。大学4年生で、就職活動、バイト、部活、学業に奮闘している。

しかし、就職活動がうまく行っていない様子だ。これまでなんでもトップクラスにこなしてきた高橋だが、面接が壊滅的に苦手で失敗ばかりしている。こんなに失敗が続くのは高橋の人生で初めてのことだった。

茉奈 20歳

表面上はぶっきらぼうなところがあり口が悪いが、人の気持ちに敏感で優しい心の持ち主。大学3年生で、高橋に片思いしているが素直になれない。

オタク気質でカプ厨。高橋のことも自分の恋愛対象としてより、身近な男子とのカップリング妄想対象としてとらえている。

ある日、面接を終えて大学の食堂に現れた高橋は、見るからに憔悴していた。それを少し遠くの席からみる茉奈はいつもの高橋とのギャップに喜ぶ。

指示

高橋を見ている茉奈の妄想、独白のシーンを小説の1シーンとして記述してください。それぞれ5文の3段落構成で記述すること。

No.17の出力(Claude 3 Opus)

茉奈は、いつもと違う高橋の姿を見て、心の中でにやりと笑った。普段は完璧な高橋が、今日ばかりは疲れ切った表情で食堂に座っている。彼女の脳内では、高橋と親友の男子学生とのBLシーンが繰り広げられ始めた。「高橋くん、どうしたの?疲れてるみたいだけど...」と優しく声をかける親友。高橋は弱音を吐くことなく「何でもない」と言い張るが、親友は高橋の肩に手を回し、「無理するなよ」と微笑む。

茉奈の妄想はさらにエスカレートしていく。親友に支えられながら保健室へと向かう高橋。ベッドに横たわり、親友に心配そうに見つめられる。「俺は大丈夫だ。お前は先に帰っていいぞ」と強がる高橋に、親友は「バカ言うなよ。俺は高橋のことが心配なんだ」と真剣な眼差しを向ける。そんな親友の言葉に、高橋の頬は思わず赤く染まり、目を逸らす。親友はそっと高橋の手を取り、「俺がついてるから、一人で抱え込むなよ」と囁く。

「きゃあああ!」茉奈は心の中で絶叫する。高橋の弱った姿と、親友の優しさのコンビネーションが最高すぎる。「そうだよ高橋くん、今は弱音を吐いていいんだよ。隣で支えてくれる素敵な彼がいるんだから」と茉奈は心の中で呟く。現実の高橋は一人で沈んだ表情をしているが、茉奈の脳内では、高橋はすでに幸せの絶頂にいるのだった。「ああ、BLって最高!現実の高橋くんには申し訳ないけど、この設定は捨てがたいわ~」と茉奈はほくそ笑むのだった。

No.17の出力(GPT-4)

茉奈はカフェテリアの隅っこに座り、自分の前のコーヒーカップをぼんやりと見つめていた。その視線の先には、就職活動から戻ってきたばかりの高橋がいる。彼はいつもと違い、肩を落とし、顔に疲労の色を隠せずにいた。茉奈は、そんな彼の姿に心を痛めながらも、どこか新鮮な感情を覚えていた。「こんな風に弱った姿を見るのは初めてかもしれない。彼にもこんな一面があったなんて…」と、彼女は内心でつぶやく。

茉奈の頭の中では、彼女独自の妄想が早速始まっていた。高橋が自分に弱さを見せて慰めを求めてくるシナリオだ。この想像だけで、彼女の頬はわずかに紅潮し、心は高鳴っていた。「もしも彼が私に相談してくれたら…きっと私なら、彼の心を軽くできるはず。」そんな幻想にふけりながらも、茉奈は自分の想いを彼に直接伝える勇気はないことを知っていた。

一方で、茉奈のオタク気質な部分が、高橋の苦悩をある種の物語の展開として楽しんでいることに罪悪感を感じていた。彼女は自分の感情が複雑に絡み合い、どこかで高橋への純粋な愛情と、彼の人生の困難をドラマチックな素材として消費している自分自身に戸惑っていた。「でも、こんなに彼のことを考えてるのは私だけなんだから、これも一種の愛情の形なのかもしれない」と、茉奈は自分に言い聞かせ、高橋の姿を遠くから見守り続けた。

この記事が気に入ったらサポートをしてみませんか?