Google Colab で PaLM 2 を試す

「Google Colab」で「PaLM 2」を試したので、まとめました。

1. PaLM 2 と Codey

8月22日、Googleは日本語に対応した「PaLM2」(テキスト生成モデル)と「Codey」(コード生成モデル)の一般提供を開始しました。

2. 使用料金

使用料金は、以下のページで確認できます。

3. GCPでの準備

GCP (Google Cloud Platform) での準備手順は、次のとおりです。

(1) GCPにログイン。

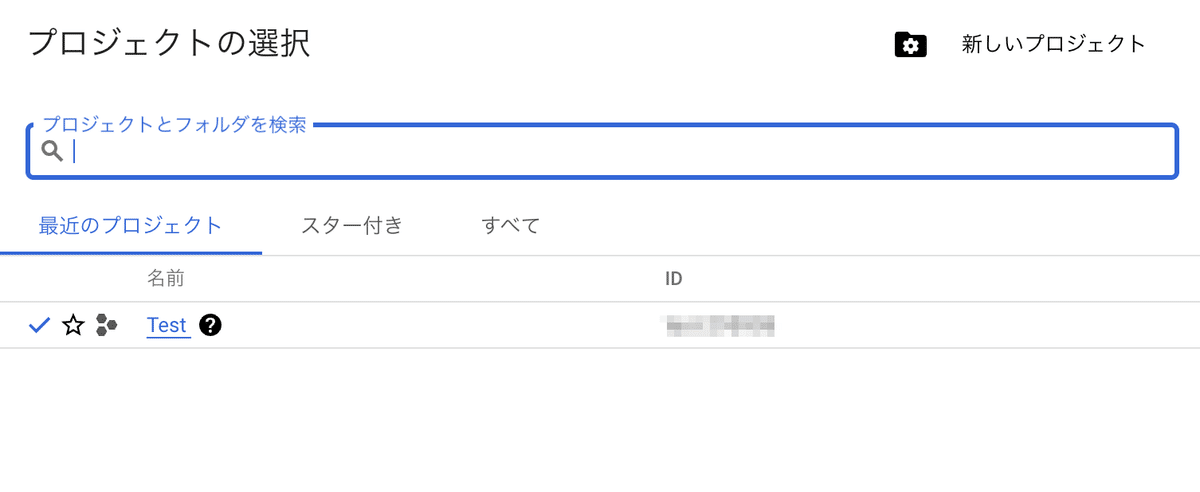

(2) プロジェクトを作成 (または既存のものを選択)。

「プロジェクトID」は、メモしておいてください。

(3) 「Vertex AI」のページを検索して開き、「すべての推奨APIを有効にする」をクリック。

4. Generative AI Studio での実行

「Generative AI Studio」は、Googleのモデル用のPlaygroundで、WebUIからGoogleのモデルを利用できます 。

2023年8月現在、以下の2つのモデルが利用できます。

・PaLM 2 (text-bison@001)

・Codey (code-bison@001)

(1) 「Vertex AI」のページを開く。

(2) メニュー「言語」を選択し、「+テキストプロンプト」ボタンを押す。

+テキストプロンプト : テキスト生成

+コードプロンプト : コード生成

+テキストチャット : 会話

+コードチャット : 会話によるコード生成

+チューニング済みモデルを作成 : モデルのチューニング

(3) プロンプト(Prompt)を入力し、「送信」ボタンを押す。

プロンプトの続きのテキストがレスポンス(Response)に出力されます。

5. Colabでの実行

Colabでの実行手順は、次のとおりです。

(1) Colabのノートブックを開く。

(2) パッケージのインストール。

# パッケージのインストール

!pip install google-cloud-aiplatform

!pip install shapely==1.8.5(3) メニュー「ランタイム→ランタイムを再起動」で再起動。

(4) 環境変数の準備

以下の<プロジェクトID>に自分のプロジェクトIDを記述します。

# 環境変数の準備

project_id = "<プロジェクトID>" # プロジェクトID

location = "us-central1" # ロケーション(5) Google認証。

ログイン画面が開くのでログインします。

from google.colab import auth as google_auth

# Googleの認証

google_auth.authenticate_user()(6) vertexaiの初期化とモデルの準備。

import vertexai

from vertexai.preview.language_models import TextGenerationModel

# vertexaiの初期化

vertexai.init(project=project_id, location=location)

# モデルの準備

model = TextGenerationModel.from_pretrained("text-bison@001")(7) 推論の実行。

# プロンプトの準備

prompt = """User:まどか☆マギカでは誰が一番かわいい?

Assistant:"""

# 推論の実行

response = model.predict(

prompt,

temperature=0.2,

max_output_tokens=256,

top_p=0.8,

top_k=40,

)

print(response.text)まどか☆マギカで一番かわいいのは、間違いなく鹿目まどかです。彼女は純粋で無垢な心を持った少女で、魔法少女として戦いながらも、常に平和を願っています。彼女の優しさと強さは、多くの人を魅了しています。

「language_models」パッケージのAPIリファレンスは、以下で参照できます。