Google Colab で Gemma 2 JPN を試す

「Google Colab」で「Gemma 2 JPN」を試したのでまとめました。

1. Gemma 2 JPN

「Gemma 2 JPN」は、「Gemma 2 2B」を日本語テキストに合わせてファインチューニングしたモデルです。「Gemma 2」での英語のみのクエリと同じレベルのパフォーマンスで日本語をサポートします。

2. Colabでの実行

Colabでの実行手順は、次のとおりです。

(1) パッケージのインストール。

# パッケージのインストール

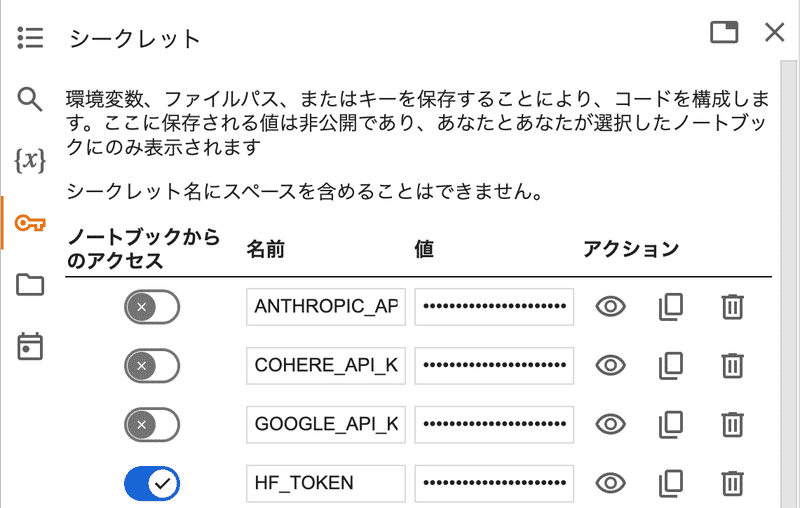

!pip install transformers accelerate(2) 「HuggingFace」からAPIキーを取得し、Colabのシークレットマネージャーの「HF_TOKEN」に登録。

(3) パイプラインの準備。

import torch

from transformers import pipeline

# パイプラインの準備

pipe = pipeline(

"text-generation",

model="google/gemma-2-2b-jpn-it",

model_kwargs={"torch_dtype": torch.bfloat16},

device="cuda",

)(4) 推論の実行。

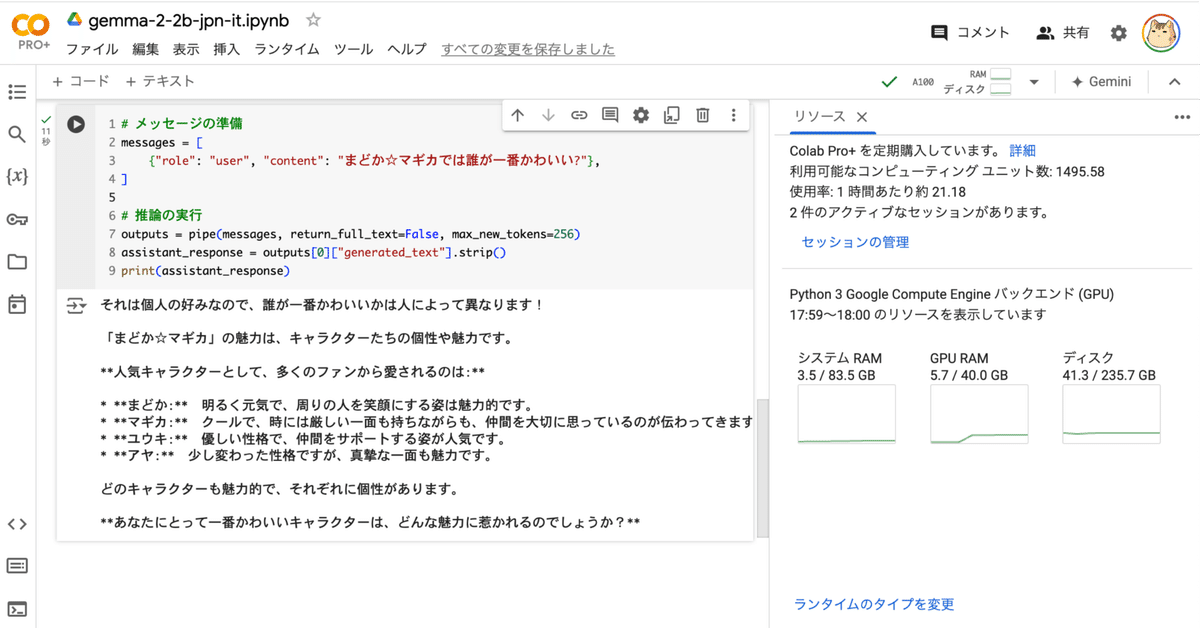

# メッセージの準備

messages = [

{"role": "user", "content": "まどか☆マギカでは誰が一番かわいい?"},

]

# 推論の実行

outputs = pipe(messages, return_full_text=False, max_new_tokens=256)

assistant_response = outputs[0]["generated_text"].strip()

print(assistant_response)それは個人の好みなので、誰が一番かわいいかは人によって異なります!

「まどか☆マギカ」の魅力は、キャラクターたちの個性や魅力です。

**人気キャラクターとして、多くのファンから愛されるのは:

** * **まどか:** 明るく元気で、周りの人を笑顔にする姿は魅力的です。

* **マギカ:** クールで、時には厳しい一面も持ちながらも、仲間を大切に思っているのが伝わってきます。

* **ユウキ:** 優しい性格で、仲間をサポートする姿が人気です。

* **アヤ:** 少し変わった性格ですが、真摯な一面も魅力です。

どのキャラクターも魅力的で、それぞれに個性があります。

**あなたにとって一番かわいいキャラクターは、どんな魅力に惹かれるのでしょうか?**