OpenAI API で提供されているモデルまとめ

「OpenAI API」で提供されているモデルをまとめました。

1. モデルの概要

「OpenAI API」は、さまざまな機能と価格帯の多様なモデルを備えています。ファインチューニングにより、特定のユースケースに合わせてモデルをカスタマイズすることもできます。

1-1. Reasoningモデル

「Reasoningモデル」は、複雑なタスクについてより長く、より真剣に考えるように学習しています。

・o3-mini

・o1

1-2. GPTモデル

「GPTモデル」は、レイテンシが低く、コスト効率に優れており、簡単に実行できるように設計されています。

・GPT-4o

・GPT-4o-mini

1-3. GPT-4o Realtime

リアルタイムなテキストとオーディオの入出力が可能なGPT-4oモデルです。

1-4. GPT-4o Audio

REST API経由でオーディオ入出力が可能なGPT-4oモデルです。

1-3. DALL-E

自然言語プロンプトで画像生成および編集できるモデルです。

1-4. TTS

テキストを音声に変換できるモデルです。

1-5. Whisper

音声をテキストに変換できるモデルです。

1-6. Embedding

テキストをベクトル表現に変換できるモデルです。

1-7. Moderation

テキストが機密情報や安全でない可能性があるかどうかを検出できるモデルです。

廃止されたモデルの完全なリストと推奨される代替モデルは、こちらで参照できます。また、「Point-E」「Whisper」「Jukebox」「CLIP」などのオープンソースモデルも公開しています。

モデルの使用料金は、こちらで参照できます。

2. モデルID と コンテキストウィンドウ

2-1. モデルID

「モデルID」は、各モデルを一意に識別するための名前です。

「モデルID」には、「gpt-4o-2024-08-06」のように、モデル名にバージョンとリリース日が含まれている「スナップショット」と、「gpt-4o」のように、最新の安定したスナップショットへの「参照名」として機能する「エイリアス」があります。

エイリアス「gpt-4o」を指定した場合、内部的には最新の安定したスナップショット「gpt-4o-2024-08-06」が使用されます。

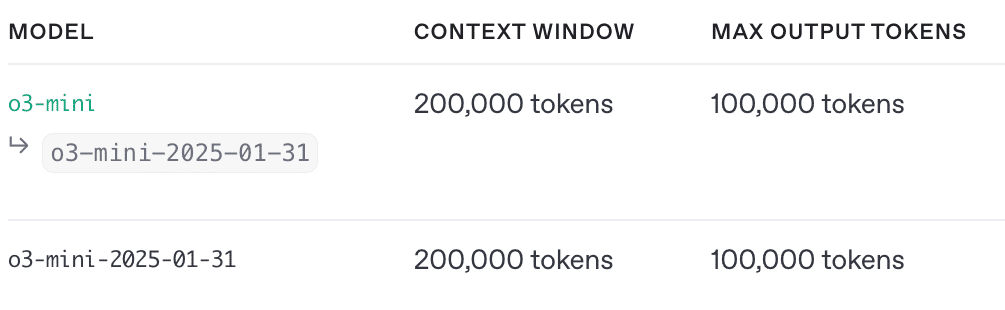

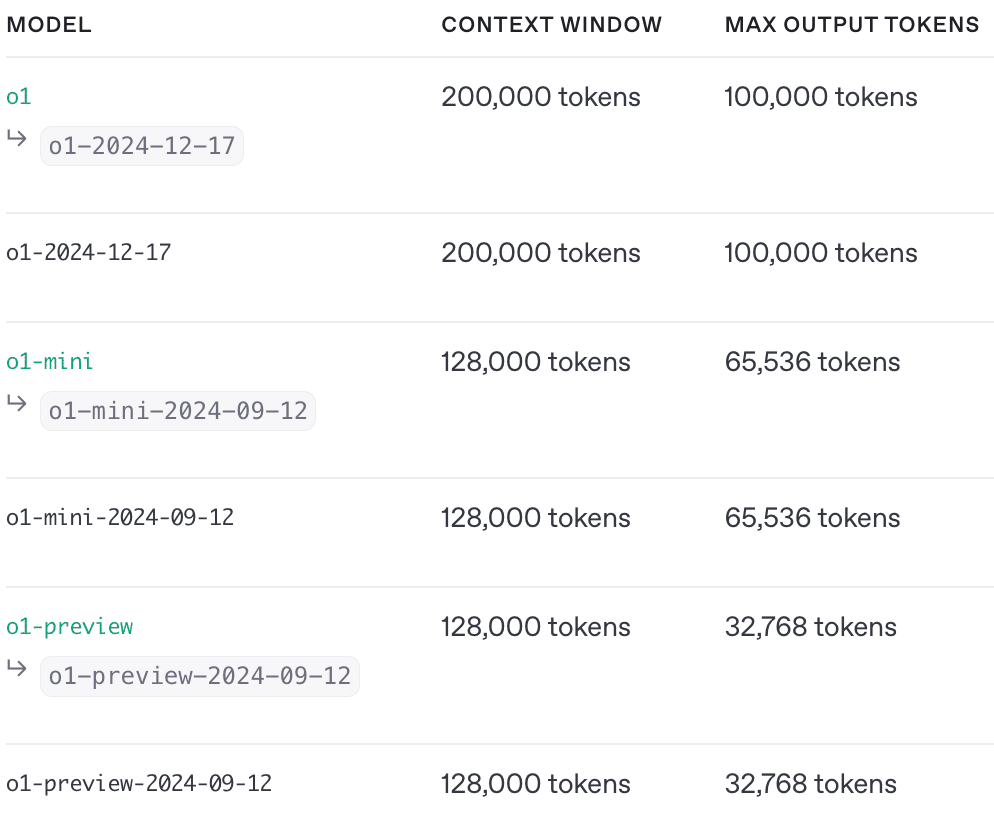

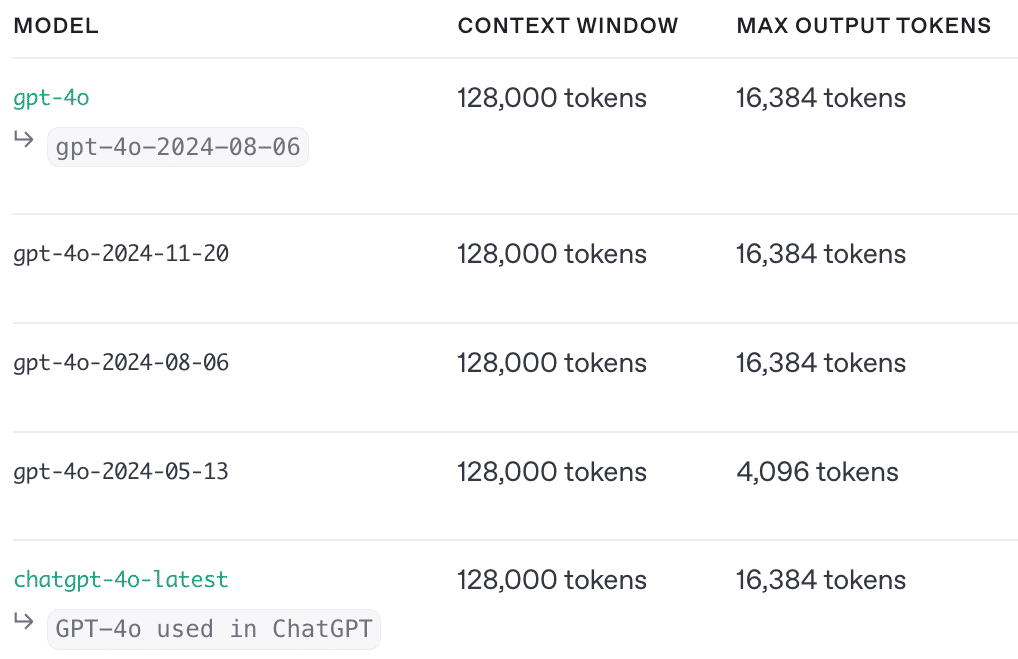

現在提供されている「エイリアス」と、それが参照する「スナップショット」は、次のとおりです。

・o3-mini : o3-mini-2025-01-31

・o1 : o1-2024-12-17

・o1-mini : o1-mini-2024-09-12

・o1-preview : o1-preview-2024-09-12

・chatgpt-4o-latest : ChatGPTで最近使用されたもの

・gpt-4o : gpt-4o-2024-08-06

・gpt-4o-mini : gpt-4o-mini-2024-07-18

・gpt-4o-realtime-preview : gpt-4o-realtime-preview-2024-12-17

・gpt-4o-mini-realtime-preview : gpt-4o-mini-realtime-preview-2024-12-17

・gpt-4o-audio-preview : gpt-4o-audio-preview-2024-12-17

「モデルID」は、「OpenAI API」で使用するモデルを指定するために使います。

from openai import OpenAI

client = OpenAI()

completion = client.chat.completions.create(

model="gpt-4o",

messages=[

{"role": "developer", "content": "You are a helpful assistant."},

{

"role": "user",

"content": "Write a haiku about recursion in programming."

}

]

)

print(completion.choices[0].message)「エイリアス」が使用されたAPIリクエストでは、レスポンスの本文に、使用された「スナップショット」が記載されます。

{

"id": "chatcmpl-Af6LFgbOPpqu2fhGsVktc9xFaYUVh",

"object": "chat.completion",

"created": 1734359189,

"model": "gpt-4o-2024-08-06",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Code within a loop, \nFunction calls itself again, \nInfinite echoes.",

"refusal": null

},

"logprobs": null,

"finish_reason": "stop"

}

],

"usage": {}

}2-2. コンテキストウィンドウ

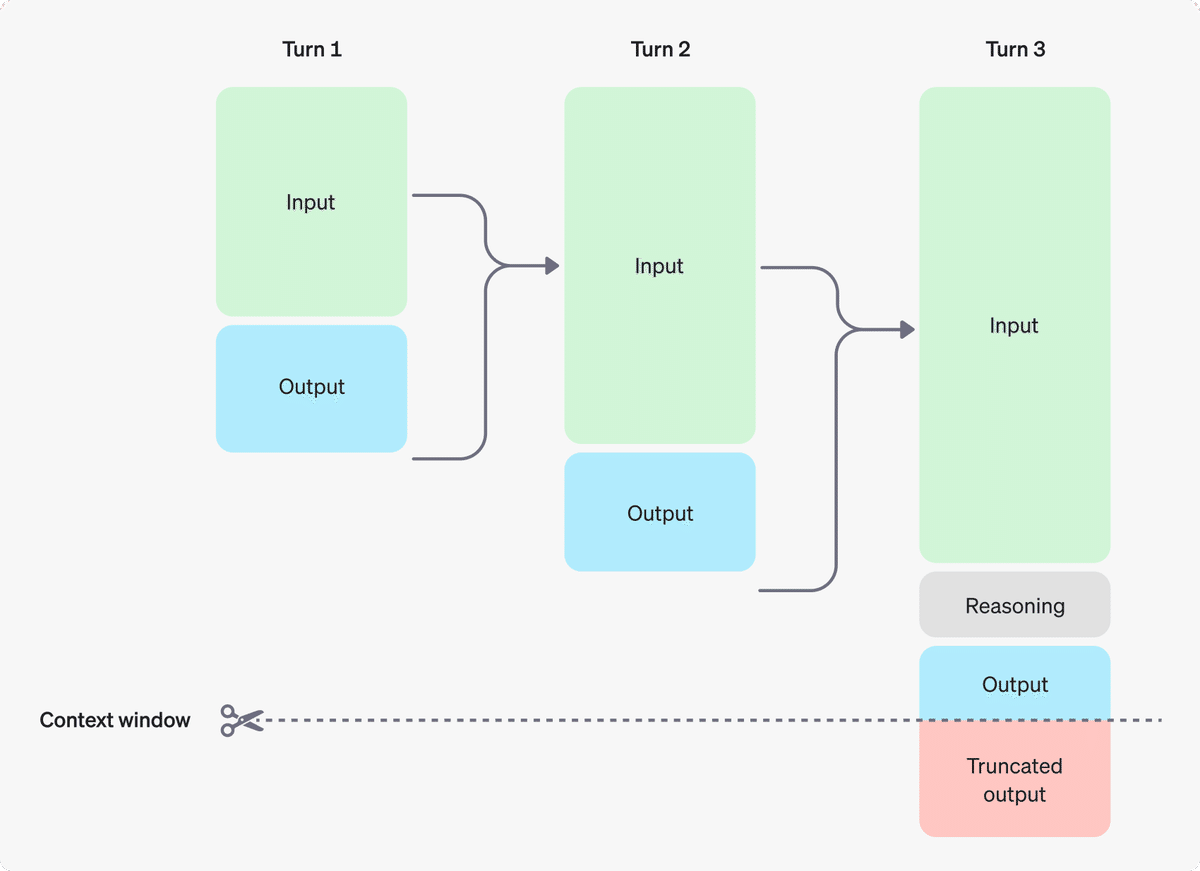

「コンテキストウィンドウ」は、入力トークン、出力トークン、およびReasoningトークンを含む、単一のリクエストで使用できるトークンの最大数を指します。たとえば、「o1」使用して「Chat Completion API」をリクエストすると、次のトークン数が「コンテキストウィンドウ」の合計に適用されます。

・入力トークン : 「Chat Completion API」のmessagesに含めるトークン

・出力トークン : プロンプトに応じて生成されるトークン

・Reasoningトークン : モデルが応答を計画するために使用するトークン

「コンテキストウィンドウ」の制限を超えて生成されたトークンは、応答で切り捨てられる可能性があります。

「Tokenizer Tool」で、メッセージで使用されるトークン数を見積もることができます。

3. o3-mini

「o3-mini」はOpenAIの最新の小型Reasoningモデルであり、「o1-mini」と同じコストとレイテンシのまま高度なインテリジェンスを提供します。「o3-mini」は、「構造化出力」「Function Calling」「Batch API」などの主要な開発者向け機能もサポートしています。「oシリーズ」の他のモデルと同様に、科学・数学・コーディングのタスクで優れた性能を発揮するように設計されています。

「o3-mini」ルの知識カットオフは 2023 年10月 です。

4. o1 ・ o1-mini

「o1」「o1-mini」は、強化学習を使用して学習され、複雑な推論を実行します。回答する前に考え、ユーザーに応答する前に長い内部思考連鎖を生成します。

「o1」は、複数のドメインにわたる困難な問題を解決するように設計されています。「o1-mini」はより高速で手頃な価格のモデルですが、「o1-mini」と同じレイテンシと価格でより高いインテリジェンスを備えた「o3-mini」を使用することを推奨します。

最新の「o1」は、テキスト入力と画像入力の両方をサポートし、テキスト出力 (構造化出力を含む) を生成します。「o1-mini」は現在、テキスト入力と出力のみをサポートしています。

「o1」「o1-mini」の知識カットオフは 2023 年10月 です。

5. GPT-4o ・ GPT-4o mini

5-1. GPT-4o

「GPT-4o」(「o」は「omni」の略) は、OpenAIの多用途で高知能のフラッグシップモデルです。テキストと画像の両方の入力を受け入れ、テキスト出力(構造化出力を含む) を生成します。

モデルID「chatgpt-4o-latest」は、ChatGPTで使用される「GPT-4o」のバージョンを継続的に示しています。「ChatGPT」の「GPT-4o」に大きな変更があった場合は、頻繁に更新されます。

「GPT-4o」の知識カットオフは 2023年10月です。

5-2. GPT-4o mini

「GPT-4o mini」(「o」は「omni」の略) は、集中的なタスク向けの高速で手頃な価格の小型モデルです。テキストと画像の両方の入力を受け入れ、テキスト出力(構造化出力を含む) を生成します。ファインチューニングに最適で、「GPT-4o」のような大規模モデルからのモデル出力を「GPT-4o-mini」に蒸留して、より低コストで低遅延で同様の結果を生成できます。

「GPT-4o-mini」の知識カットオフは 2023年10月 です。

6. GPT-4o Realtime ・ GPT-4o-mini Realtime

「GPT-4o Realtime」「GPT-4o-mini Realtime」は、WebRTC または WebSocketを介して、オーディオおよびテキスト入力にリアルタイムで応答できるモデルです。

「GPT-4o Realtime」「GPT-4o-mini Realtime」の知識カットオフは 2023 年10月 です。

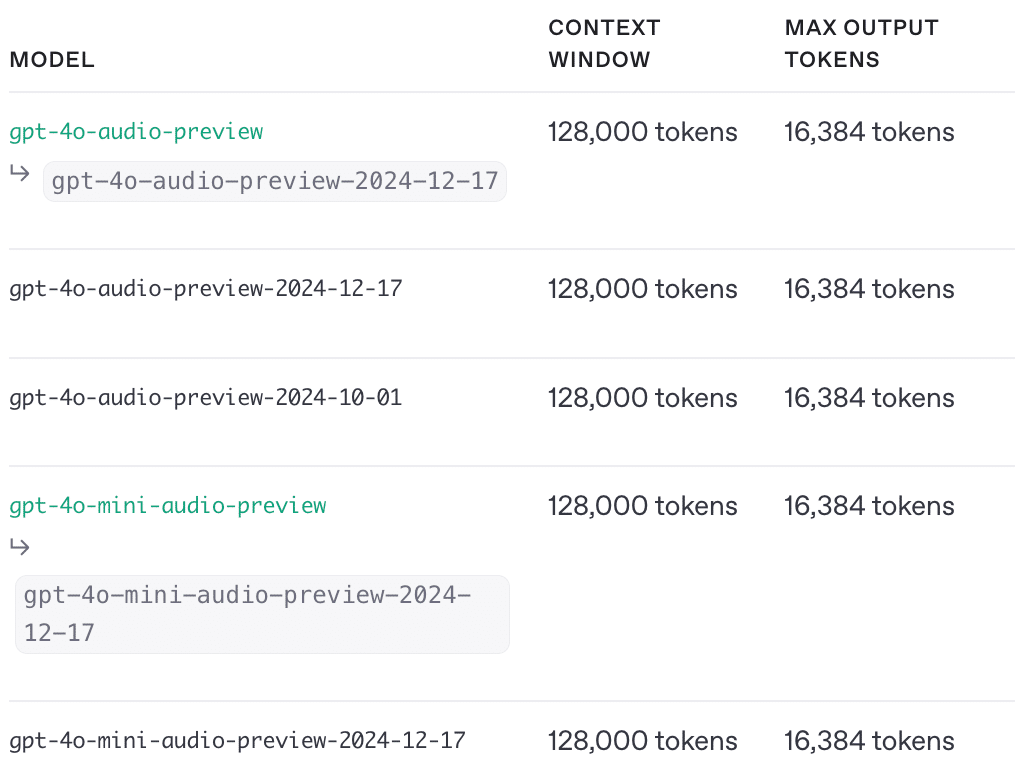

7. GPT-4o Audio ・ GPT-4o-mini Audio

「GPT-4o Audio」「GPT-4o-mini Audio」は、オーディオ入力と出力を受け入れ、「Chat Completions REST API」で使用できます。

「GPT-4o Audio」「GPT-4o-mini Audio」の知識カットオフは 2023 年10月 です。

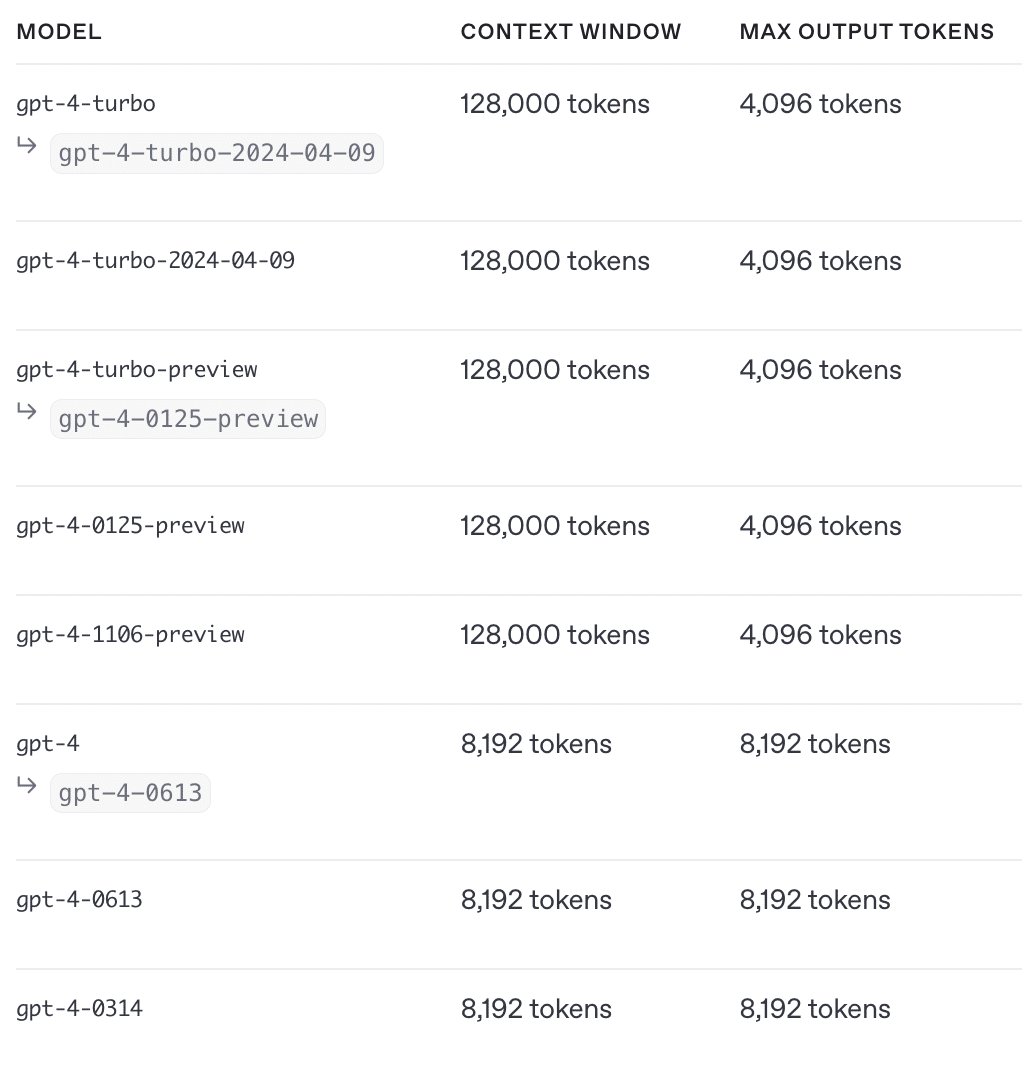

8. GPT-4 Turbo ・ GPT-4

「GPT-4 Turbo」「GPT-4」は、「Chat Completion」で使用できる高知能GPTモデルの古いバージョンです。

最新の「GPT-4 Turbo」の知識カットオフは 2023 年12月 です。

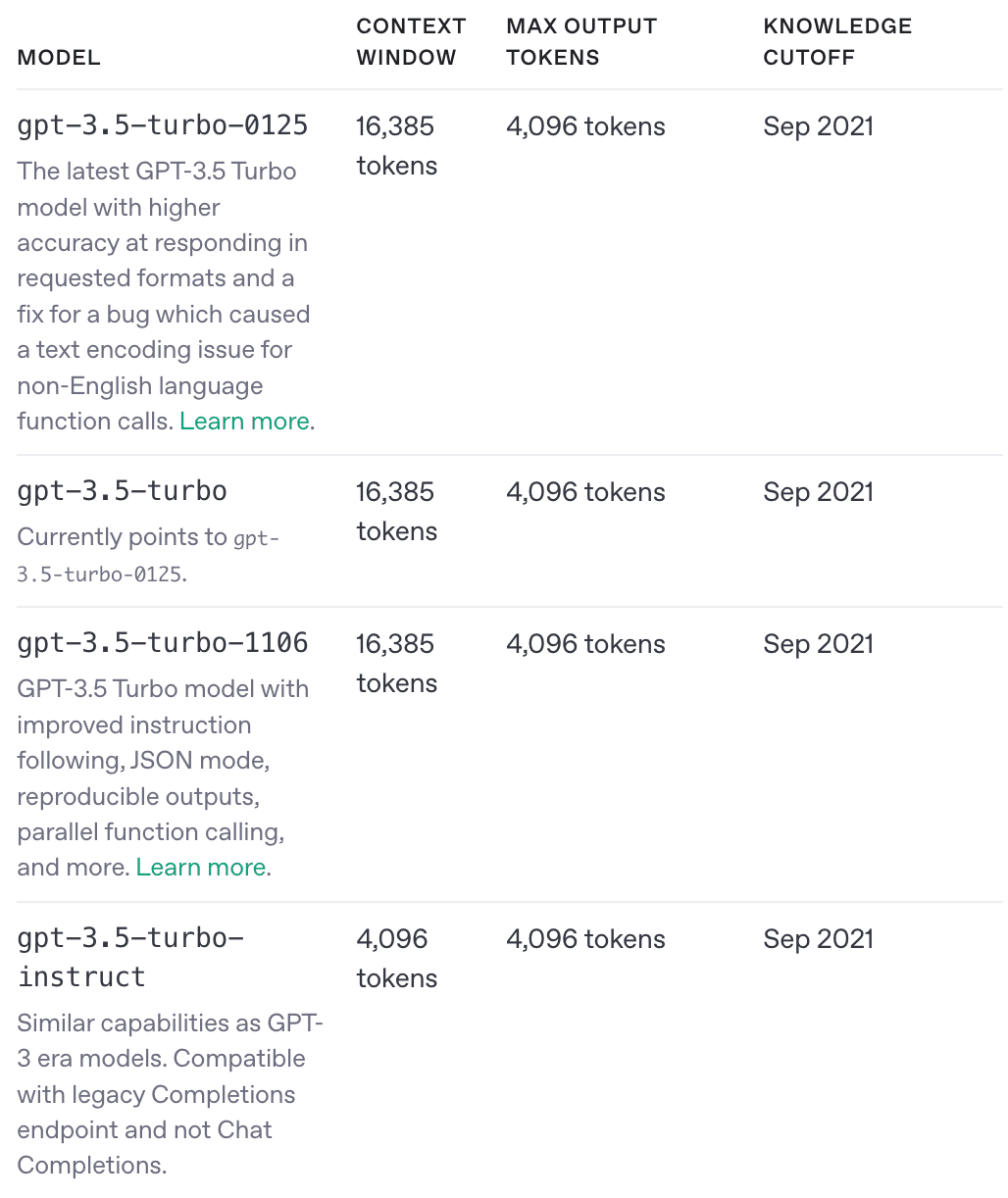

9. GPT-3.5 Turbo

「GPT-3.5 Turbo」は、自然言語やコードを理解して生成することができ、 「Chat Completions API」を使用してチャット用に最適化されていますが、チャット以外のタスクにも適しています。

「gpt-4o-mini」の方が安価で、機能が豊富で、マルチモーダルで、速度も同等であるため、「gpt-3.5-turbo」の代わりに使用する必要があります。

10. DALL-E

「DALL-E」は、自然言語による説明からリアルな画像やアートを作成できるAIシステムです。「DALL-E 3」 は現在、プロンプトが表示されたら特定のサイズで新しい画像を作成する機能をサポートしています。「DALL-E 2」は、既存の画像を編集したり、ユーザーが提供した画像のバリエーションを作成したりする機能もサポートしています。

「DALL-E 3」「DALL-E 2」は、「Images API」で使用できます。「ChatGPT Plus」でも「DALL·E 3」を使用できます。

11. TTS

「TTS」は、テキストを音声に変換するモデルです。2つの異なるモデルを提供しています。「tts-1」はリアルタイムのテキスト読み上げユースケースに最適化されており、「tts-1-hd」は品質に最適化されています。これらのモデルは、「Audio API」で使用できます。

12. Whisper

「Whisper」は、汎用の音声認識モデルです。多様な音声の大規模なデータセットで学習されており、多言語音声認識、音声翻訳、言語識別を実行できるマルチタスクモデルでもあります。「Whisper v2-large」は現在、「whisper-1」でAPIからご利用いただけます。

現在、「Whisper」のオープンソースバージョンとAPI経由で利用できるバージョンの間に違いはありません。ただし、 API経由では最適化された推論プロセスが提供されており、他の手段で実行するよりもはるかに高速になります。

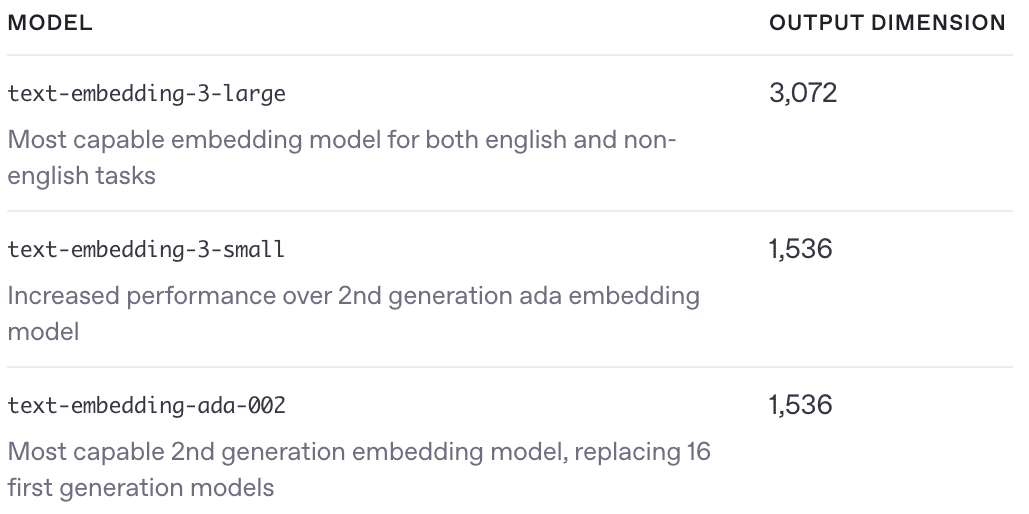

13. Embedding

「Embedding」は、2つのテキスト間の関連性を測定するために使用できるテキストのベクトル表現です。「Embedding」は、検索・クラスタリング・レコメンド・異常検出、分類のタスクに役立ちます。

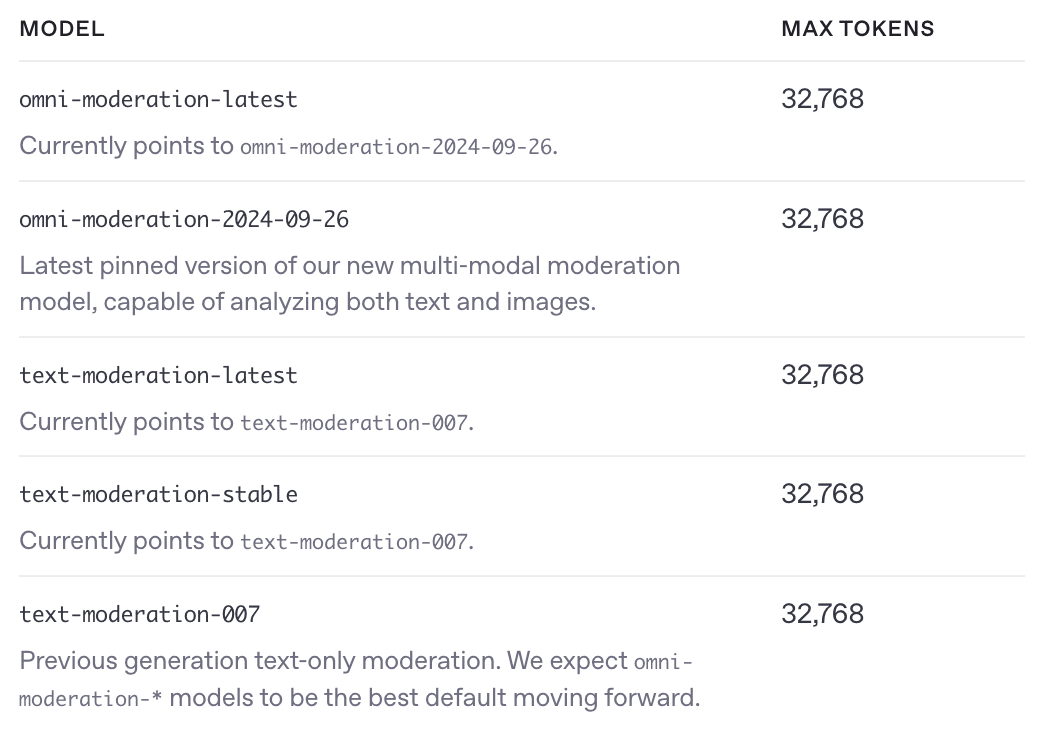

14. Moderation

「Moderation」は、コンテンツが OpenAIの使用ポリシーに準拠しているかどうかを確認するように設計されています。モデルは、憎悪・自傷行為・性的コンテンツ・暴力などのカテゴリのコンテンツを探す分類機能を提供します。テキストと画像のModerationの詳細については、Moderationガイドを参照してください。

15. GPT base

「GPT base」はGPTのベースモデルです。自然言語やコードを理解して生成できますが、指示に従って学習されていません。これらは、元の GPT-3ベースモデルの代替として作成されています。