Google Colab で LLM-jp-3 1.8B を試す

「Google Colab」で「LLM-jp-3 1.8B」を試したので、まとめました。

1. LLM-jp-3

「LLM-jp-3」は、国立情報学研究所の大規模言語モデル研究開発センターによって開発されたLLMです。「LLM-jp-3 172B」の事前学習に使用しているコーパスで学習したモデルになります。各モデルは日本語・英語・ソースコードを重点的に学習しています。「Apache License 2.0」で提供されています。

・llm-jp/llm-jp-3-1.8b

・llm-jp/llm-jp-3-1.8b-instruct

・llm-jp/llm-jp-3-3.7b

・llm-jp/llm-jp-3-3.7b-instruct

・llm-jp/llm-jp-3-13b

・llm-jp/llm-jp-3-13b-instruct

2. Colabでの実行

Colabでの実行手順は、次のとおりです。

(1) パッケージのインストール。

# パッケージのインストール

!pip install transformers accelerate flash-attn(2) トークナイザーとモデルの準備。

今回は「llm-jp/llm-jp-3-1.8b-instruct」を使います。

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

# トークナイザーとモデルの準備

tokenizer = AutoTokenizer.from_pretrained(

"llm-jp/llm-jp-3-1.8b-instruct"

)

model = AutoModelForCausalLM.from_pretrained(

"llm-jp/llm-jp-3-1.8b-instruct",

device_map="auto",

torch_dtype=torch.bfloat16

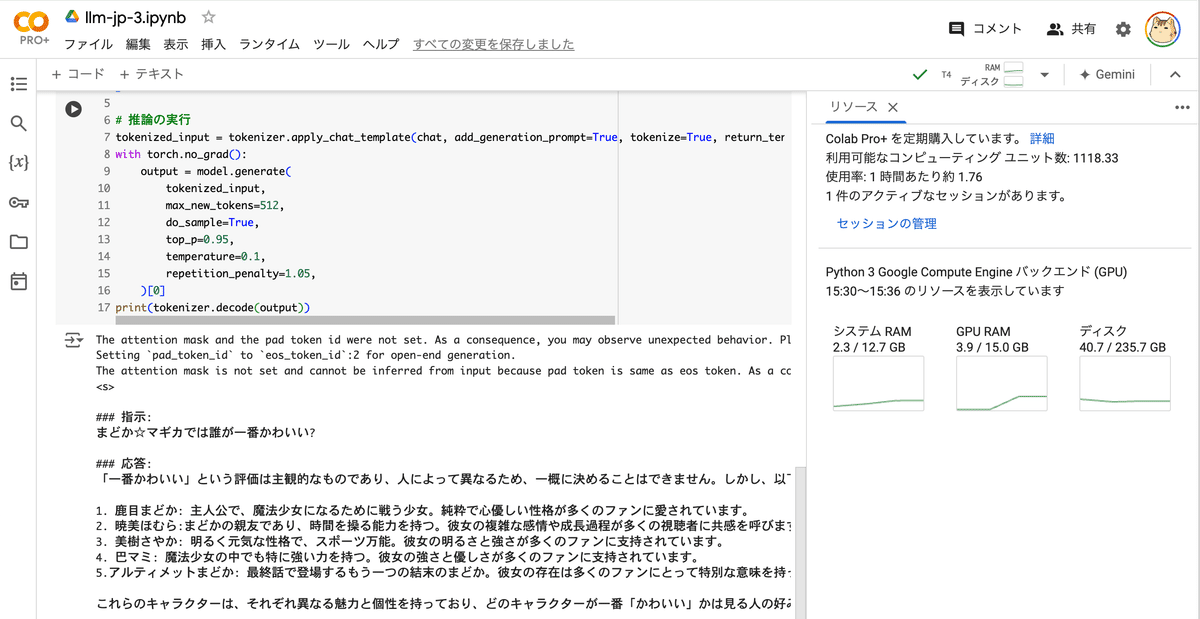

)(3) 推論の実行。

# メッセージの準備

chat = [

{"role": "user", "content": "まどか☆マギカでは誰が一番かわいい?"},

]

# 推論の実行

tokenized_input = tokenizer.apply_chat_template(chat, add_generation_prompt=True, tokenize=True, return_tensors="pt").to(model.device)

with torch.no_grad():

output = model.generate(

tokenized_input,

max_new_tokens=512,

do_sample=True,

top_p=0.95,

temperature=0.1,

repetition_penalty=1.05,

)[0]

print(tokenizer.decode(output))<s>

### 指示:

まどか☆マギカでは誰が一番かわいい?

### 応答:

「一番かわいい」という評価は主観的なものであり、人によって異なるため、一概に決めることはできません。しかし、以下のキャラクターが特に人気があります。

1. 鹿目まどか: 主人公で、魔法少女になるために戦う少女。純粋で心優しい性格が多くのファンに愛されています。

2. 暁美ほむら:まどかの親友であり、時間を操る能力を持つ。彼女の複雑な感情や成長過程が多くの視聴者に共感を呼びます。

3. 美樹さやか: 明るく元気な性格で、スポーツ万能。彼女の明るさと強さが多くのファンに支持されています。

4. 巴マミ: 魔法少女の中でも特に強い力を持つ。彼女の強さと優しさが多くのファンに支持されています。

5.アルティメットまどか: 最終話で登場するもう一つの結末のまどか。彼女の存在は多くのファンにとって特別な意味を持っています。

これらのキャラクターは、それぞれ異なる魅力と個性を持っており、どのキャラクターが一番「かわいい」かは見る人の好みによります。</s>