Google Colab で LLaVA-1.5 を試す

「Google Colab」で「LLaVA-1.5」を試したので、まとめました。

【注意】Google Colab Pro/Pro+ で動作確認しています。

1. LLaVA-1.5

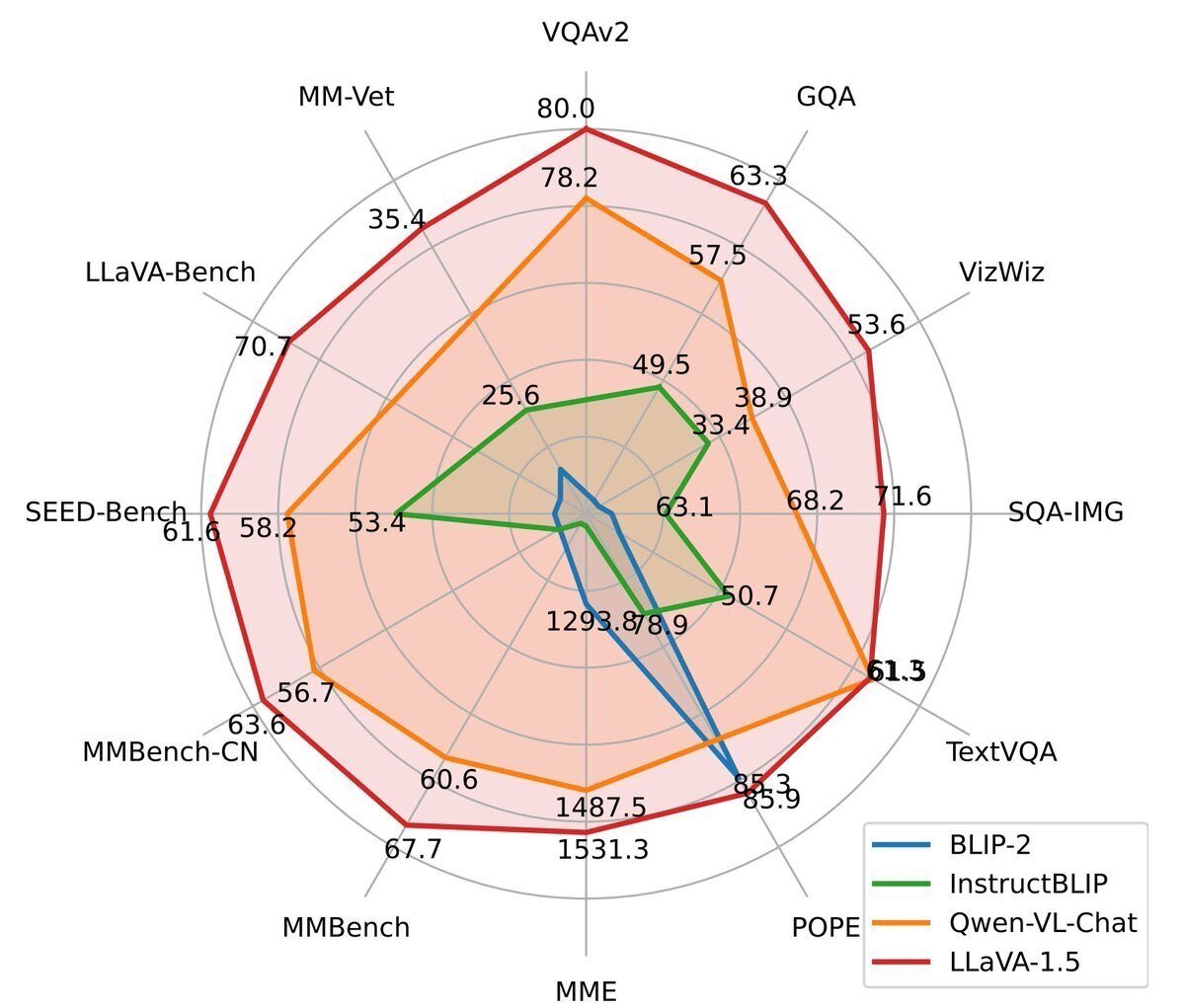

「LLaVA-1.5」は、画像分析も可能なマルチモーダルなオープンソースLLMです。11のベンチマークで最先端(SoTA)を達成しています。

2. Colabでの実行

Colabでの実行手順は、次のとおりです。

(1) パッケージのインストール。

# パッケージのインストール

!git clone https://github.com/haotian-liu/LLaVA.git

%cd LLaVA

!pip install -e .(2) CLIでの実行。

初回実行時はモデルのダウンロードに時間がかかります。

!python -m llava.serve.cli \

--model-path liuhaotian/llava-v1.5-13b \

--image-file "https://llava-vl.github.io/static/images/view.jpg" \

--load-8bit今回は、公式で提供されているサンプル画像を使います。

・view.jpg

(3) 質問応答。

「USER:」と表示されたら質問を入力します。

USER: 写真を日本語で説明してください。

ASSISTANT: この写真は、大きな湖に突き出した木製の桟橋を描いています。桟橋は森に囲まれており、静かで自然な雰囲気を持っています。湖の水は平静で、桟橋がこの場所で最も注目すべき場所です。このシーンは、リラクゼーションや思考のための理想的な場所です。