【AI漫画実験/第1回】画像AIのSDXL+加筆で、手描きに近い白黒漫画を作れないか実験してみた

これは「今までガチガチに手描きで漫画を描いてきた奴が、AIをフルに作って従来の白黒漫画と同じフォーマットの原稿を作るとどうなるか」という実験の記録です。私は手描き漫画にAIを生かせないかと思っており、その上で期待しているのは、

①原稿作成の時間短縮

②クオリティアップ

です。AIで超絶クオリティの漫画が描きたい!というよりは、普段の自分と同じクオリティで構わないから、AIを使う事で時短できたらいいな~と。せっかくなら適度にクオリティも上がったらいいなと。

今の画像AIローカルの主流SD1系はNAIリーク問題という爆弾を抱えているのであまり触れないようにしていましたが、先日SDの新バージョンSDXLが出てきて試したところ、これは実用でも使えるな?と手ごたえを感じ、今回の実験を思い立ちました。

そんなわけで生成画像は全てSDXLベースモデル製です。

今回は下記のモデルとネガティブTIを使用しました。

モデル:

白黒線画:XeLblend 1(https://huggingface.co/cella110n/celblend)

カラー部分:blue_pencil-XL-v0.1.0(https://civitai.com/models/119012/bluepencil-xl)

ネガティブTI:

negativeXL_C(https://huggingface.co/gsdf/CounterfeitXL/tree/main/embeddings)

unaestheticXLv1(https://civitai.com/models/119032/unaestheticxl-or-negative-ti?modelVersionId=129199)

SDXLモデルでの生成にはautomatic1111さんのwebuiの1.6.0バージョンを使用してます。それ以前のバージョンだとSDXLのネガティブTIが未対応だったりしますので、最新版の使用をお勧めします。

automatic1111さんのwebuiって何?という方は、初心者向けの良記事がありますのでこちらをどうぞ。(ご本人に引用許可済)

今からAIイラストを覚えたい方向けに、これまで得た知見を一つの記事にまとめました!2万字以上あるのですが、これだけ読めばAIイラストの基本は網羅できるはず。無料で全部読めますわ~。

— 賢木イオ@スタジオ真榊 (@studiomasakaki) August 20, 2023

【全体公開】AIイラストが理解る!StableDiffusion超入門https://t.co/gbbaacD7mt pic.twitter.com/lIQEKJ16r6

ではやっていきましょう。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

■1/クリスタでネームを描く

今回の実験は内容よりも「AIをフルに使用し従来の手描きと同じフォーマットの白黒漫画を作成」を重視しているため、AIが生成しやすいもの、既にAI漫画ではおなじみの「女の子と喋り中心」の構成にしました。

…とかかっこよく言いたかったんですが、正直なんも考えずマジで適当に描きました。長年漫画描いててもこの程度の奴もいるなんだな、と勇気をもらえる素晴らしい仕様になっています。

■2/AIで生成しやすいキャラクターの外見を考えてプロンプトを作り、ひたすら生成

主要人物は女子2人。AIで特徴が出しやすく、自分の好みな

・黒髪ロングポニーテール+シンプルな白タンク+デニムホットパンツ+巨乳

・白髪ショート+ノースリーブのタートルネックセーター+ミニスカ+並乳

にしました。ノースリーブのタートルネックセーターは思ったより打率が低くよく袖ありになりましたが、袖くらいなら加筆ですぐ消せるので無問題。

思い付きで始めた漫画制作だったので作り置きなどなく、生成しながらコマに当てはめていきます。と言ってもコマごとにプロンプトを練って生成するわけではなく、色んなアングルやポーズを入れたランダムなプロンプトで一気に生成し、使えそうなものを選んで当てはめていくやり方です。

黒ポニは合計250枚弱、白ショートは合計100枚強生成しました。加筆前提で衣装や表情の整合性にそこまで拘らなかったので、AI漫画制作でのキャラ生成枚数としては少ない方なんじゃないでしょうか。

■3/希望の絵に近い生成結果をコマに当てはめて加筆

■4/1P2コマ目と2P2コマ目を下絵からi2i

俯瞰構図なので、下絵を描いて背景と人物を一緒に生成しようと思いました。地獄。本製作中一番の「描いた方が早い」案件

■5/それっぽい背景を生成して二値化し人物の後ろに入れ、簡単にトーン仕上して完成

それでは、はい、完成したものがこちらになります。

■性癖が正反対のオタク百合■(1/3)

— のび城 (@nobisiro_2023) August 21, 2023

SDXL系モデル+加筆で仕上げた白黒漫画です。出来るだけ従来の手描き漫画の画面に寄るよう頑張りました。現時点でSDXL縛りでどういう事がやれるのか興味ある方はどうぞ見てってください。#AI漫画 #SDXL pic.twitter.com/lDKEaHFQaX

今まで製作したAI漫画のまとめ読みはこちら↓

■全6Pの製作時間

リアルタイムで生成しながらなので生成時間も含め、総作業時間は大体10~12時間くらいですかね。空き時間にもちょこちょこ修正したのでもっとかかってるかも? 夜だけ作業して、日数的には6ページで2日かかりました。

普段は手描きですが、私は手だけは早く、このくらいの内容の原稿なら素材などを駆使して1枚1~2時間で描けるので「手描きと全く同じ事をAIにさせたい」場合はAIを使った方が時間がかかる、というのが率直な感想です。プロンプト考えて生成待つってかなりの手間だし、なんというか、手描きのように思い通りにはいかないストレスがあります。

ただAIを使用した方がクオリティは上がります。特に背景。

ちゃんとやるならコマごとの線の太さや描き込み量の均一化、構造の破綻修正など、かなりの時間を要するでしょう。私は「それっぽければOK」という適当人間なのでその辺あまり気にしないのですが、それでもこのくらい時間がかかりました。参考までに。

■工夫した事

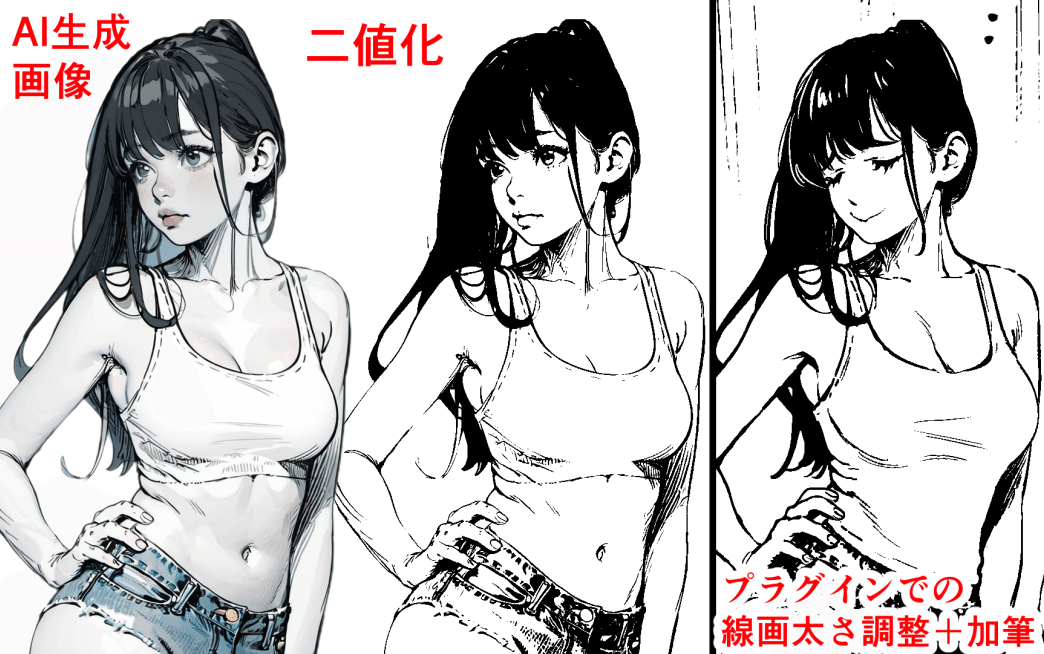

・絵は白黒二値化する

普段手描きでは白黒二値で描いているので、AI生成も出来るだけ白黒線画が出るプロンプトを入れ、クリスタで色調補正して白黒二値で作業しました。カラーやグレスケより二値の原稿の方が加筆修正が断然楽です。前後の整合性を統一する時も色やグレーの階調を気にしなくてよく、時短になります。

カラー漫画は前後の整合性を合わせるのも加筆するのも大変なので、漫画初心者の方ほど白黒やグレースケールでの製作をお勧めします。

白黒二値化のコツ(2023/8/27追加)↓

https://t.co/lVz6MmLWTp

— のび城 (@nobisiro_2023) August 27, 2023

こちらの記事で説明が面倒で省略した「グレーからラスター二値線画化のやり方」の詳細を追加で載せておきます。

1/白黒グレー化プロンプトでAI生成

2/クリスタに持ってきてレイヤーを2枚コピーし、2値化する時に数値をいじって、太い&細いバージョン2通り用意します pic.twitter.com/rXMHJjAj7L

・線画の太さを出来るだけ統一する

生成画像を拡大縮小すると線画の太さがコマごとに変わります。これ個人的に結構気になるので、クリスタで白黒化してからプラグイン「加筆」で線画の太さを調整した上で情報量を削りました。線画太くする用の自作アクションを普段使いしているので、線画の太さはボタン一つで加工できました。線画の太さを調整するならベクターレイヤーに変換する手もあるでしょうが、今回はキャラの髪を黒にしたのでやりませんでした。

ちなみにAI線画のベクターレイヤー化は元絵に黒が多く入ってると2枚目のようになる&線画がガタついて修正が大変になるので、完全な線画の時&印刷するものの場合あまりおすすめしません。webや電子だけならそこまで気にならないと思う! pic.twitter.com/Awi5V1MavC

— のび城 (@nobisiro_2023) August 28, 2023

・白黒化→ゴミ取りツールで絵の情報量を減らす

使用モデルの絵がそこそこ緻密だったのもあり、拡大縮小すると細部の細かさの差が目立ちました。しかし解像度を変えてi2iするとか、手動で線の太さや密度を全て修正するとか面倒でやってられませんので、白黒化した後にゴミ取りツールで適当に囲って線の量を減らしてます。

・表情は加筆で直す

そのまんまです。表情の差くらいならわざわさ生成ガチャするより加筆の方が断然早いし、自分の考える表情の機微をダイレクトに表現できます。良い感じのポーズや顔が出たらあとは加筆で「わからせ」です。SD生成はツリ目になりがちですが、そんなもんクリスタのゆがみツールで一瞬でたれ目にしたるわ!

■漫画へのAI使用で便利だと思った事

・背景コマが一瞬で終わる(最大のお勧め)

これでしょう。最高。一生AIに背景描いて欲しい。

「AIの描いた背景は破綻やパースが云々」言われますが、私は背景に拘りないのでほぼ気にならないです。どこに居るかわかりゃいいんで。さすがに壁から人が生えてたり窓と外の風景が融合してたりしたら直しますが、今回使ったモデルではそういう修正もほとんどいりませんでした。SD1系はそういう破綻が多かったですが、SDXLになって背景の破綻はかなり減ったと思います。

・白黒自分絵Lora

自分の白黒絵でSDXLのLoraを作ったんですが、自分絵に寄せると言うより白黒化&漫画顔に寄せるのに便利でした。全て0.5くらいで軽めにかけてます。今回主に使用した「XeLblend1」というモデルが白黒線画化が上手いので、それで作ってそのモデルで生成しました。自分の絵でLora作るの面白いし、自分の絵の特徴が客観的に見えて勉強になるのでおすすめ!

・ABG Remover(SDwebUI拡張機能)

これを指定すると、生成した人物の背景を自動で透明にしてくれます。最高。AIで漫画の人物作る時は欠かせない拡張機能です。

■漫画へのAI使用で向かないと思った事

・コントロールネット

意外に思われるかもしれませんが、簡単な漫画制作だけならコントロールネットはほとんどいらないです。生成重くなるし、時短を考えるといちいち設定するのも面倒です。

あとこれは私が使いこなせていないだけかもしれませんが、何故かコントロールネットを使用すると、目に見えて生成画像のクオリティが落ちました。どうにも窮屈さを感じる絵になるというか…。t2iでプロンプトで生成した方がAIはのびのび良い絵を描いてくれるし、同じプロンプトでも自分の考えつかなかったいい絵を出してくれたりもするので、インスピレーションも広がります。

ある程度描ける人なら、コントロールネットを使うよりt2iでいいポーズが出るまでガチャ回して加筆した方が断然早いです。ただこれは2023年8月現在の話なので、今後コントロールネットの性能が上がったら状況が変わってくるかもしれません。

・i2i

ものによりますがかなり難航しました。

背景を写真素材でi2iするとかは問題ないんですが、人物のi2iが壊滅的に下手で参りました。コントロールネットと同じで、目に見えて生成画像のクオリティが落ちます(下図)。デノイズを下げると絵が変わらないし、上げれば崩壊するしで、いくらやっても良い感じにならない。拡張機能のループバックなども駆使しましたが、結局狙った構図が出せそうなプロンプトでt2iガチャが時間的にも質的にも一番いい結果が得られました。多分破綻するのはカラーじゃないのも影響しているんじゃないかと。AIはそもそも白黒が苦手です。出来る限りプロンプトでのt2iガチャで頑張りましょう。

・複数人数の生成

生成するなら一人ずつ生成して合成する方がいいです。複数人の個別の外見指定が難しい上、絵が崩れます。そこそこ綺麗に下絵を描いたi2i(下図)でも厳しいです。

・ペンタッチに違和感が出る

AI絵が精緻なため、加筆するのも中々技量が求められます。下手にやると加筆部分が浮きます。今回は人物までAI絵なのでそこまで気になりませんでしたが、手描きの絵にAI絵の背景が入ると、ペンタッチや情報量が違い過ぎて浮きそうだと思いました。この辺はモデルの絵柄やLoraなどでなんとかなるかもしれません。

■最後に:自分がなぜAI実験をしているか

生成AIに対しては様々な意見がありますが、私は生成(画像)AIを「お絵かきツールの一つ」と考えています。

一度技術として確立した以上、今後生成AIが完全に消える事はないでしょう。ならば、これがどういうものなのか、良い所も悪い所も、実際に自分で使って知りたいと思いました。良い部分は活用したいし、悪い部分は正しく怖がり、どのように対策したらいいのか考えたいからです。

下記から自分の作品がSDに学習されたか検索できます。

https://gigazine.net/news/20220915-have-i-been-trained/

私の手描きの絵も学習されており、自分が革新的技術の礎の一部になるなんて夢があるとワクワクしましたが、SNSなどを見ていると私の感覚はあまり一般的ではないのかもしれません。法がどうとか置いといて人が嫌がる事を強要するのは好ましくないので、AI学習されたくない方の絵は学習できなくなる方法が確立されて欲しいです。

↓このような技術も出てきているので、学習されたくない方はチェックしておくといいのではないでしょうか。

https://prtimes.jp/main/html/rd/p/000000001.000127618.html

とりあえず自分は以下を守って使うよう心がけています。

・日本の法律で違法になる事はしない

・手描きでやって駄目な事はAIでやるのも駄目

なので、もし今後Stable Diffusionなどの画像生成AIの使用が日本の法で禁止されたら使用をやめます。出来るだけ新しい情報を取り入れ、その時々で使用するか否か判断していくつもりです。

画像生成AIも万能ではありません。実際自分で触って使用してみないとわからない事がたくさんあります。どのような事ができてどのような事ができないのか、皆さんも一度実験してみてはいかがでしょうか。

長々お付き合いありがとうございました!

今回はギャグの画面作りをしたので、余裕があれば次はシリアスがいけるかも実験してみたいです。

※普段はフリーでクリエイター系の仕事をしております。

AIを活用できる仕事にも興味があるので、お仕事の依頼がありましたらnoteの「お問い合わせ」もしくはnobisiro2023@gmail.comまでご連絡ください。よろしくお願いいたします。