東京造形大学 #CSLAB #現場派 |映像と音|その2 データ編| #展示技術講座

この記事は東京造形大学CSLABで行われた講座の原稿です。「その1」の続きとなっていますので、前回の記事も合わせてお読みくださると幸いです。

今回の記事は「映像データ」に着目しています。作家だけでなく、企画側含む映像展示に関わる全ての人に役立つよう考えて書きました。企画者側の人達のデータに対する理解が深まれば、インストーラーへの相談タイミングが変わると思います(データをみなければ機材選択ができない場合も多い)。

また、展示指示書の制作や企画運営や作品を取り扱う上での責任分解など、ある程度のデータの知識がなければ美術館やギャラリーで映像作品を取り扱うのは難しいと思われます。そういった方々が困った時に参考にできるような記事になれば良いなと思っています。

業界全体のリテラシー向上を願って書いていますが、こういった話が苦手な人も多いと思います。全てを理解するというよりは、詰まった時に参照できるよう広く浅くまとめてあります。気軽な気持ちで読み進めてもらえると嬉しいです。

繰り返しになりますが、独学と経験から学んできたことが多いため、もし間違いなどありましたらコメントいただけると幸いです。修正いたします。

また、個人が書いている記事ですので趣味趣向や個人の考えが入りがちになります。他の業界では通用しない考えもあるかもしれません。柔軟な姿勢で読んでもらえれば幸いです。

以下原稿

映像ファイルの基礎知識

「なぜか映像が流れない!」の原因は映像データに対する理解で解決できる場合が多いです。ある程度の基本知識をここでおさえることで「なぜか映像が流れない!」をできるだけ防いでいきましょう。

映像の中身って何?

解像度:Resolution

フレームレート:Frame rate

色域:Gamut

色深度:Color depth

ダイナミックレンジ:Dynamic range

クロマサブサンプリング:Chroma subsampling

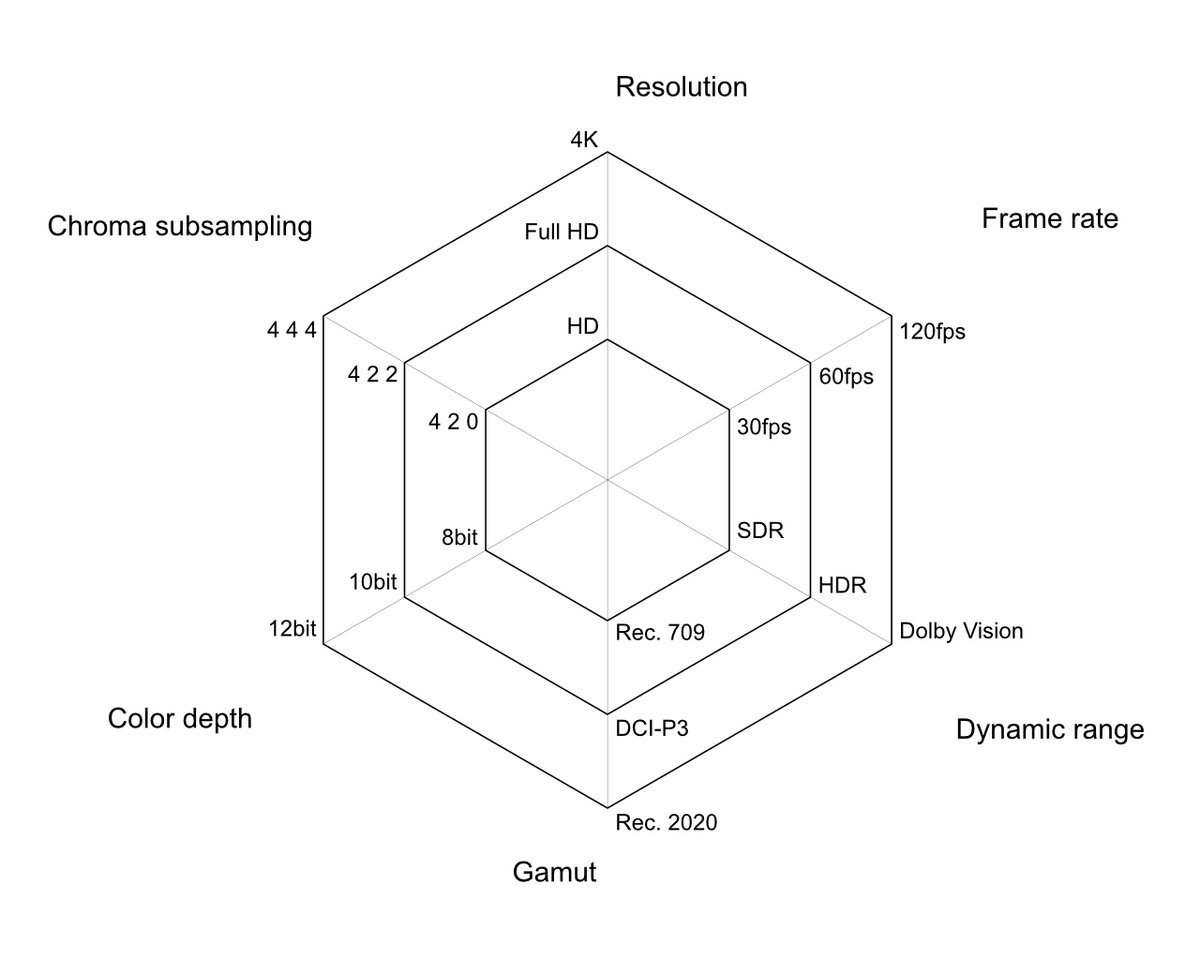

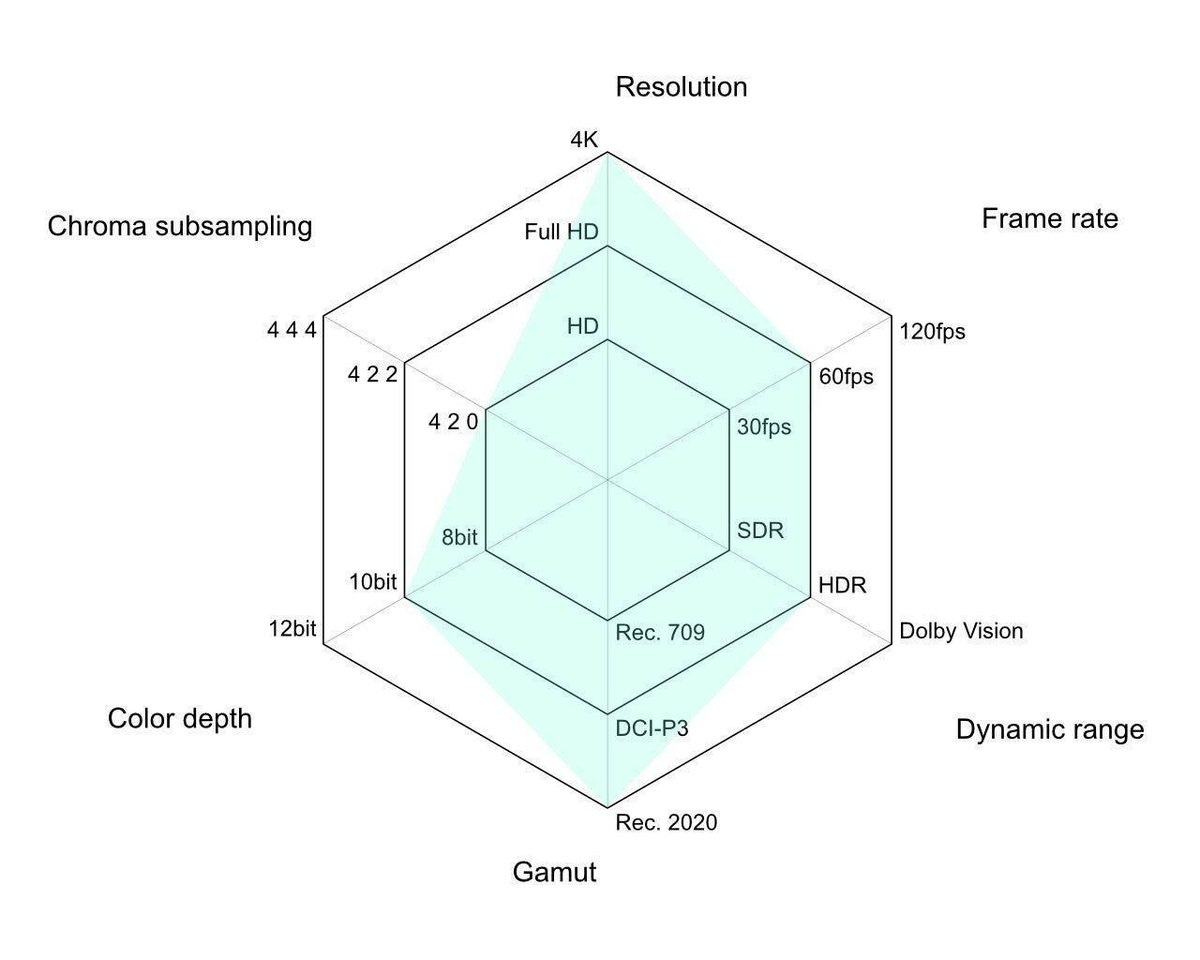

まずは映像データを理解するための要素を見ていきましょう。映像データの中身には色んな要素があるのですが、メインで気にするべき6つの要素を紹介します。

解像度:Resolution

解像度はかなり知名度高い言葉だと思います。映像はピクセルデータ(ビットマップ or ラスタ形式とも言う)でできた画像の連続でできています。ベクターとビットマップの違いは美術大学では必須知識だと思いますが補足リンクを2つはっておきます。

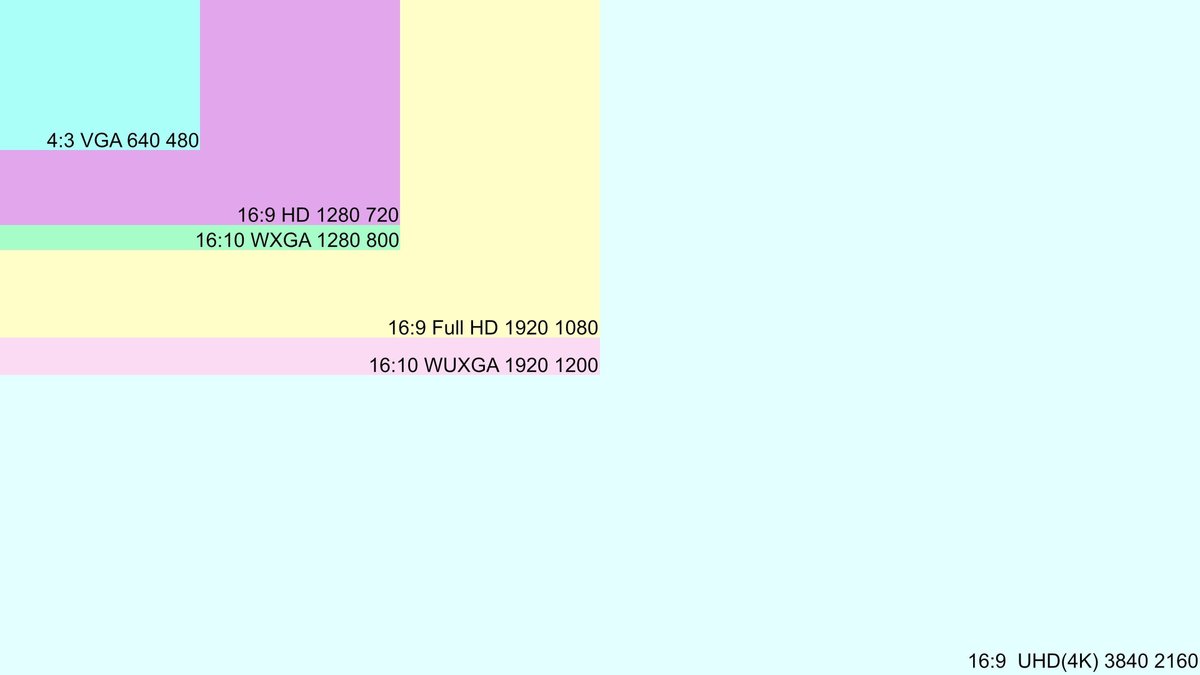

解像度とは、映像のピクセルの細かさや数を指します。ちなみに、以下のような種類があります。縦横比は4:3や16:9がメジャーです。21:9や3:2や5:4など色々なデータを見てきました。縦横比はモニター展示の場合は特に注意が必要ですね。プロジェクションのスクリーンを作る場合も気を付けましょう。

4K(UHD)はフルHD(FHD/FullHD)の4倍の面積になっています。

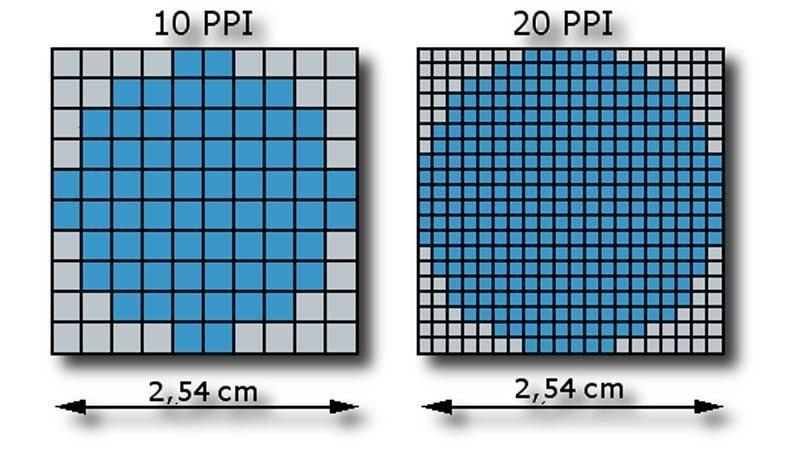

補足で、ppi(pixel per inch)という単位もあります。1inch内のピクセル数を表します。多ければ多いほど1ピクセルが小さいということになります。印刷のdpi(dot per inch)にかなり近い概念になります。

1inch = 25.4mmm

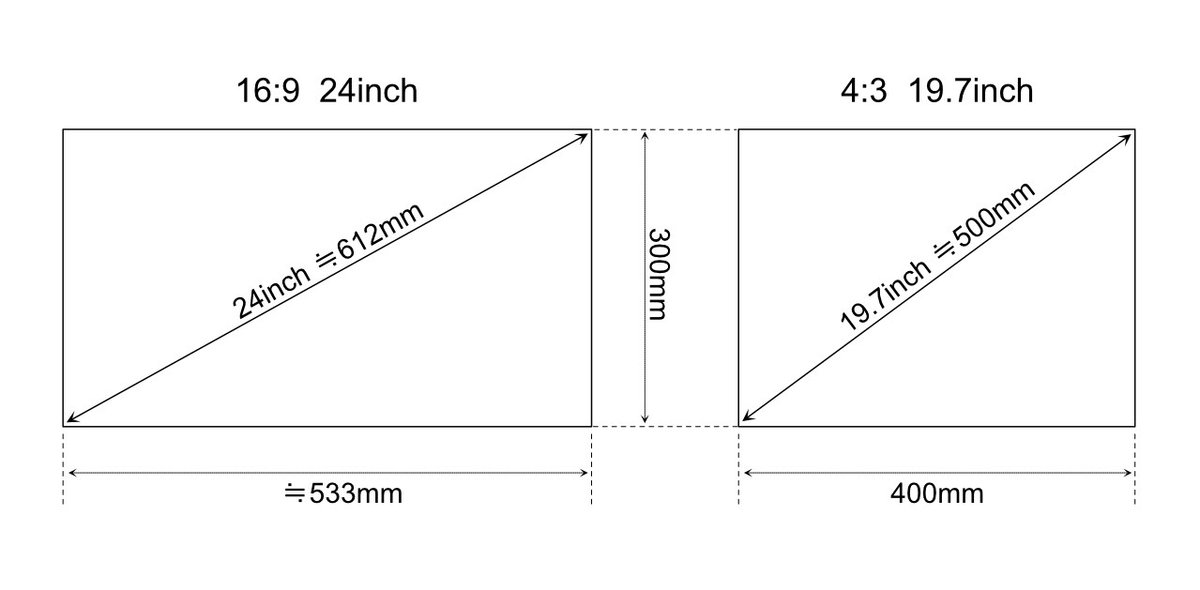

ややこしいのですが、モニターサイズのインチは対角線の長さを意味します(下の画像)。ppiはモニターを購入する時に気にしたりもします(上の画像)。インスタレーションに組み込んで近くで見るような映像表現の場合は解像度よりppiを気にしたりします。それぞれ、他の数値と関連して大きさなどが変わってくるので計算が必要です。

(余談ですが、4K=UHDのように違う名前で同じ意味を表すもの。4K=3840:2160 or 4096:2160のように同じ名前で違う内容を表すものが映像及びコンピューターの世界は多いです。このあたりが苦手な人を量産している原因かも?)

フレームレート:Frame rate

次に、パラパラ漫画でも重要になるフレームレートです。こちらもYoutubeなどの影響でかなり一般的になりました。映像がいかになめらかに動くかという点で重要です。滑らかであれば良いというわけではありませんが、Youtubeなどによってカクついた映像に鑑賞者は敏感になってきていると思われます(個人の感想)。

フレームレートはfps(frame per second )という単位で表されます。1秒間に何枚の画像が入るのかという意味です。必要であるかどうかは置いておいて、大抵のゲーミングモニターが144hzくらいなので120fpsの映像が流せます。ただし、再生機の方が追いついてない印象です。

(hzとfpsは微妙に違うのですが省略)

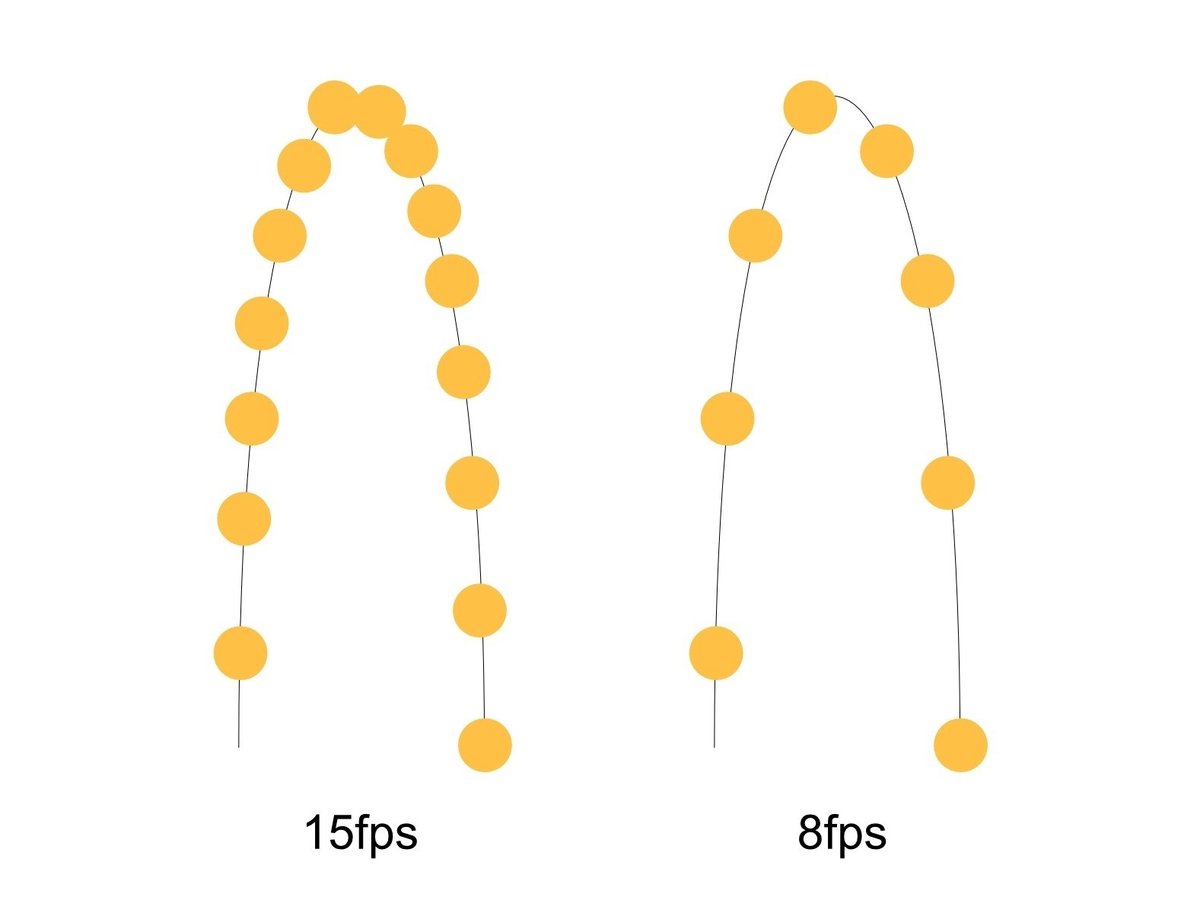

あまり上手な絵ではないですが、1秒間に1回弾んだボールを撮影したとします(絵の都合上15fpsと8fpsにしました)。15fpsの動画だと15枚の絵が1秒間に流れます。8fpsだと8枚ですね。ボールが止まっていることは無いので、fpsが高ければ高いほど途中の絵が増えるというわけです。一般的には23.9~60fpsくらいの間の映像が多いと思います。

色域:Gamut

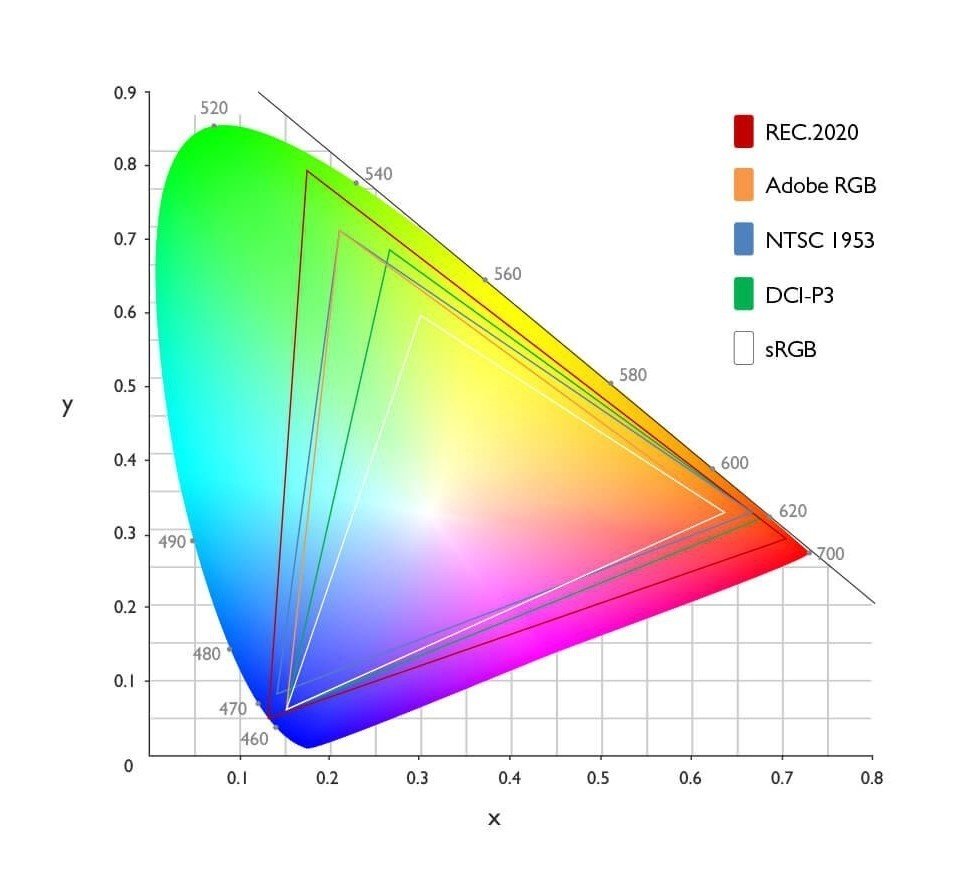

色域は表示できる色の範囲なのですが、機材依存のため難しい部分があります。下の図のように三角形が大きければ大きいほど色幅はあるということになります。表示できる色数とはまたちょっと違うのがポイントです!

作家の場合は、小さくても良いので(DCI-P3100%などの)しっかり色がでるモニターを使って制作すると良いかもです。将来のために、保管用として良いデータを残すことをお勧めします。僕は展示機材にあわせて作家の許可をとりデータの書き換えも行います。シドニービエンナーレのような書出しが多い現場はきちんとデータがチェックできる部屋が用意されたりもします(データチェック用のモニターやスピーカーが並んでいる)。

色深度:Color depth

個人的にはかな〜〜り重要だと思います。なのに、あまり気にされてない部分です。特に、3DCGアニメーションや夕焼けのような色のグラデーションがある映像では凄い違いが出ます!!(実写の場合撮影データに依存)

色深度は色を何段階で分けるか?という話になります。混色禁止で17色の絵の具で描かれた絵と102色で描かれた絵を想像してみて下さい。歴然として描ける表現が変わってくるのが想像できると思います。

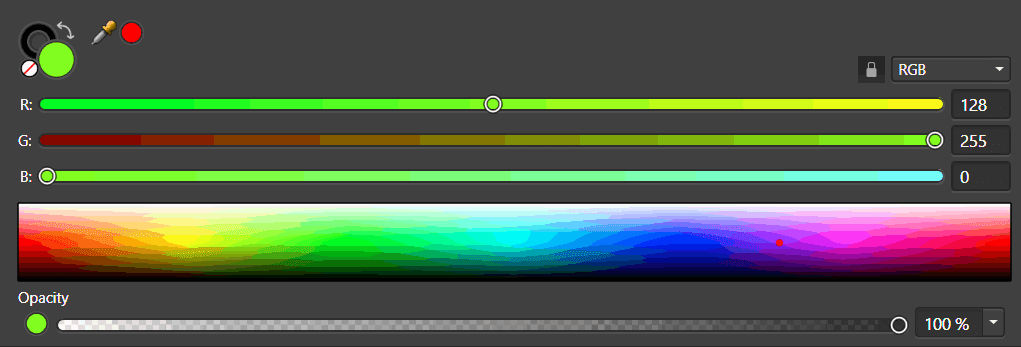

データの量の話で出てきた8bitという概念がここでも登場します。8bitは256段階でした。8bitの色深度というのは色を256段階で分けることいいます。上の画像のようにRGBがそれぞれ256段階(0~255)で段階わけされています。つまり、256段階3チャンネルの組合せの数だけ色を表示できることになります。

256✕256✕256

=16777216色(約1700万色)

では最近の良いスマホでも撮影のできる10bitとは何色になるのでしょうか?RGBをそれぞれ10bit=2の10乗=1024段階で分割します。同様に3チャンネル分あるので以下のような計算になります。

1024×1024×1024

=1073741824色(約10億7千4百万色)

8bitの64倍も色数があります!

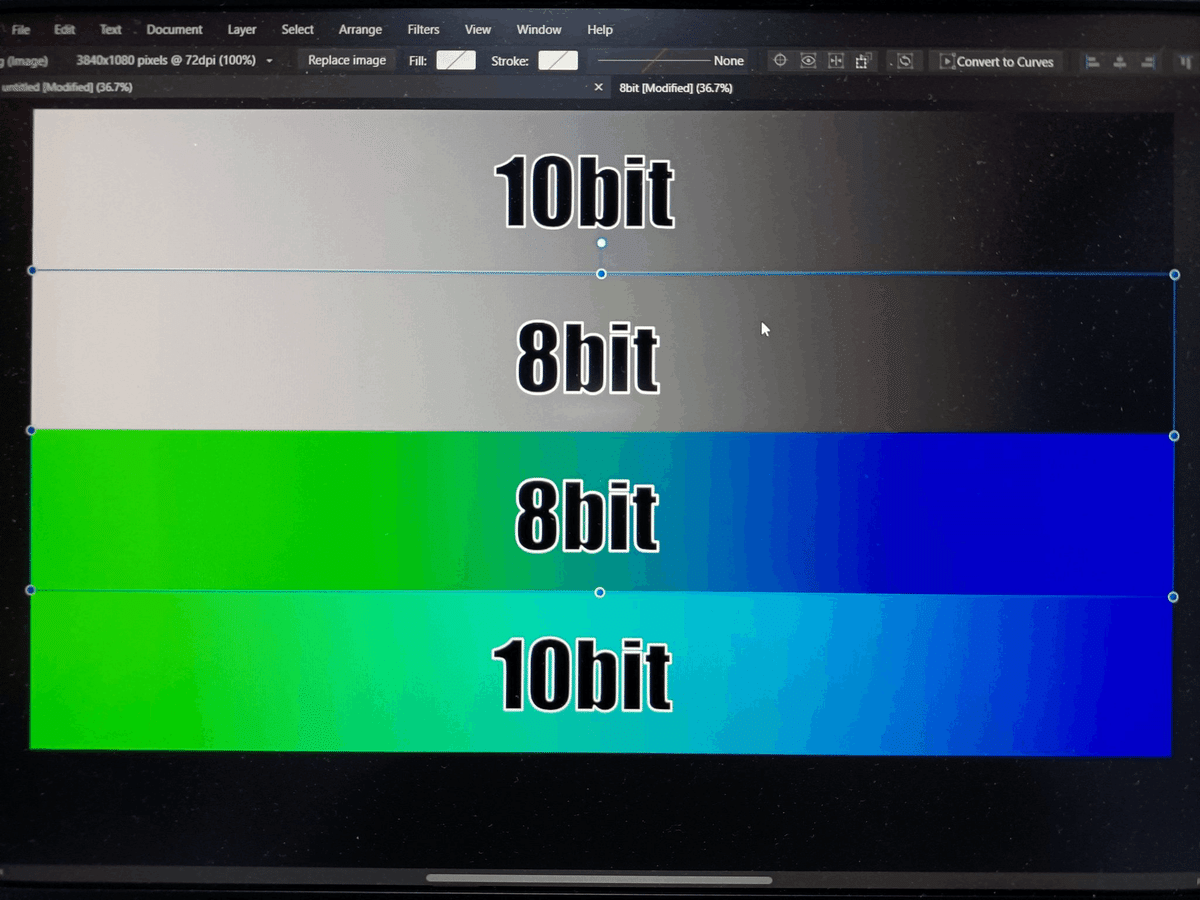

色数は読者のモニター環境に依存するので、あまりあてにはなりませんが画像を用意しました。中間色の色や白から黒へのグラデーションの滑らかさが違うのがわかりますでしょうか?わかんないですね……すみません。下の画像は色域内の白から黒と緑から青を8bitで分割したのか10bitで分割したのかの違いになります。

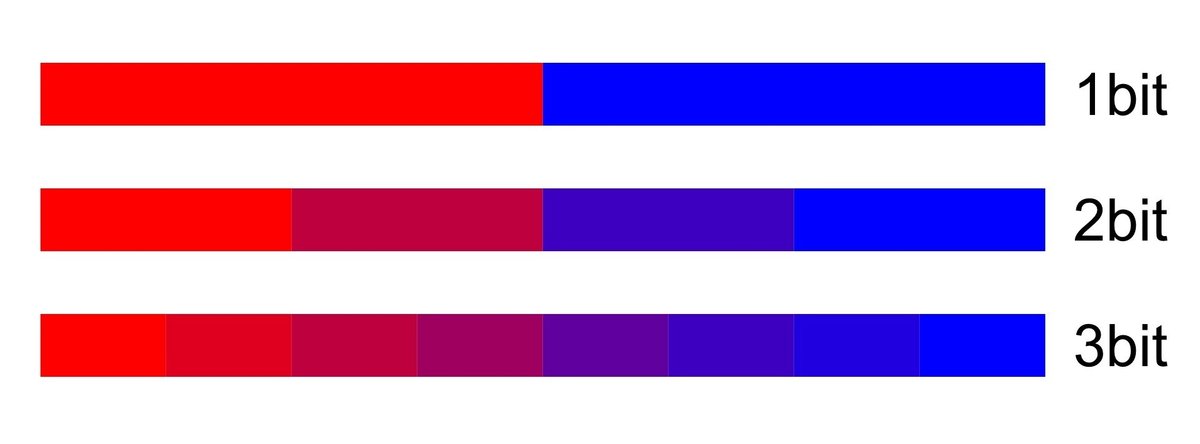

基本は8bitか10bitかで迷うことが多いと思います(2022年現在)。上の画像でもギリ10bitのほうのみ絶妙な黄緑や水色があるのがわかるかと思います。一応、分かりやすさを強調するために1bit~3bitまでの色の諧調を下に用意しました。この調子で色数が増えていきます。データにはあるのに、表示できてない色があるって凄くもったいないことだと思いませんか?

パソコンからの10bit表示はGPUからの設定などが必要になりますが。2020年あたりにでてきたM1チップってどうなの?と疑問に思ってました。M1 macが10bit表示できるのか?という実験、面白かったので一応共有。

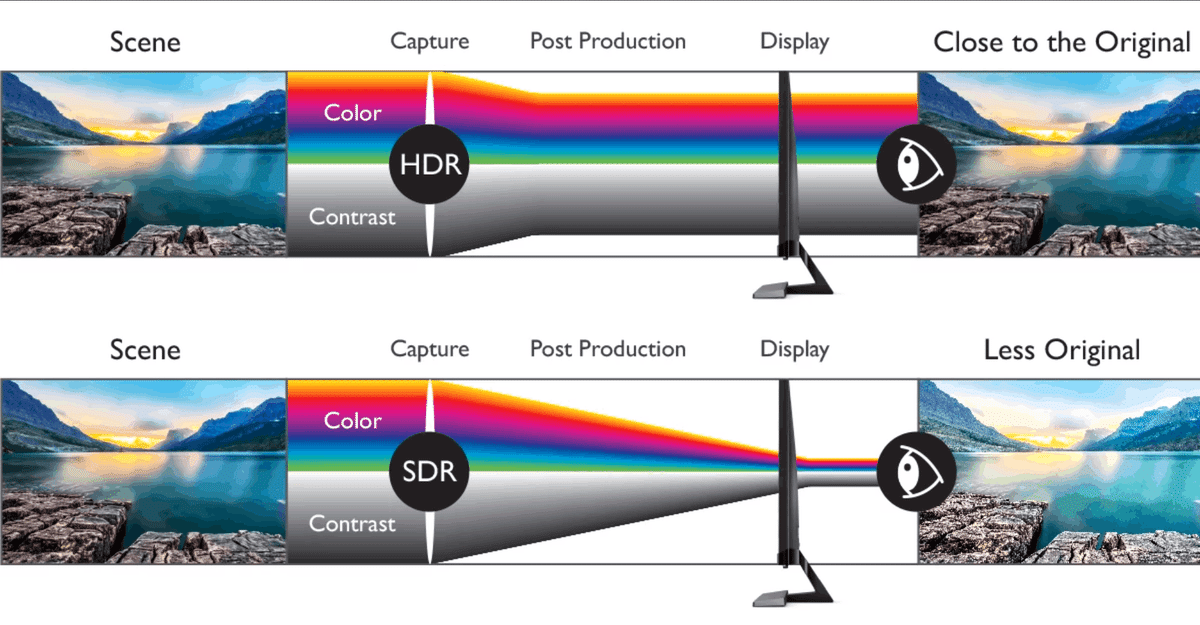

ダイナミックレンジ:Dynamic range

これは短く説明するのが難しいです。映像展示というよりはカメラでの撮影に重要な知識ではあります。基本的には1番明るいところから暗いところまでの光り方の分布?だと思って下さい。明るいディスプレイとセンサーや撮影技術の発達により、明るい中の諧調と暗い中の諧調の表現度があがってきたことで出てきた技術だと思われます。

ダイナミックレンジにはいくつか段階があります。10bitのHDRと12bitのDolby Visionという規格があります。またHDRの中にもPQやHLGという規格の違いがあります。

説明をだいぶ省きますが、HDRの中のPQとHLGという2種類の規格は気にしたほうが良いと思います。PQは表示機器側の表示範囲を無視して輝度を絶対値で決定するのに対して、HLGは機材の最大と最小の中で相対的に輝度を振り分けます。PQに対応している機材ならキレイに見えますが、HLGのが安全ではあります。

怖いのは、PQで書き出しておいてSDRの機材で再生すると盛大に白飛びするということです。気をつけましょう。

かなーーーり説明を端折ったので意味不明かもですが、HDRやlog撮影とかで調べていくと理解が深まると思います。

(HDRの項目は後日書き足すかもです)

クロマサブサンプリング:Chroma subsampling

こちらは、4Kでモニター表示とかだと肉眼で見分けるのは結構難しいです。ただ、FHDでプロジェクションして、近づいて鑑賞するタイプなら気にしても良いかも?とは思います。

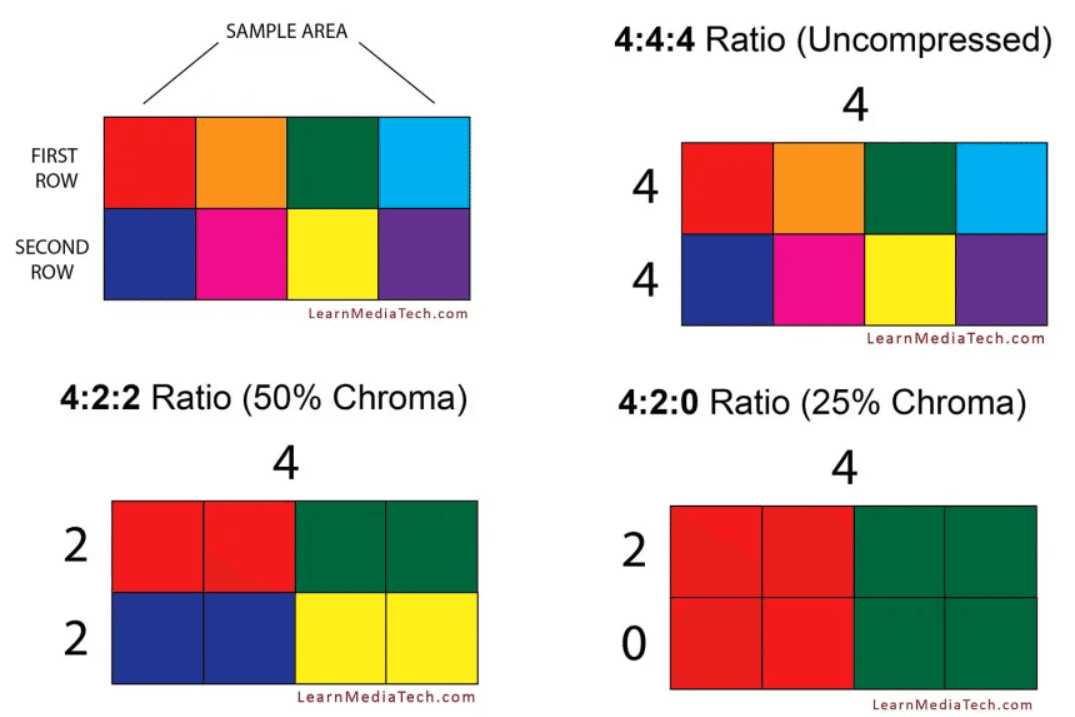

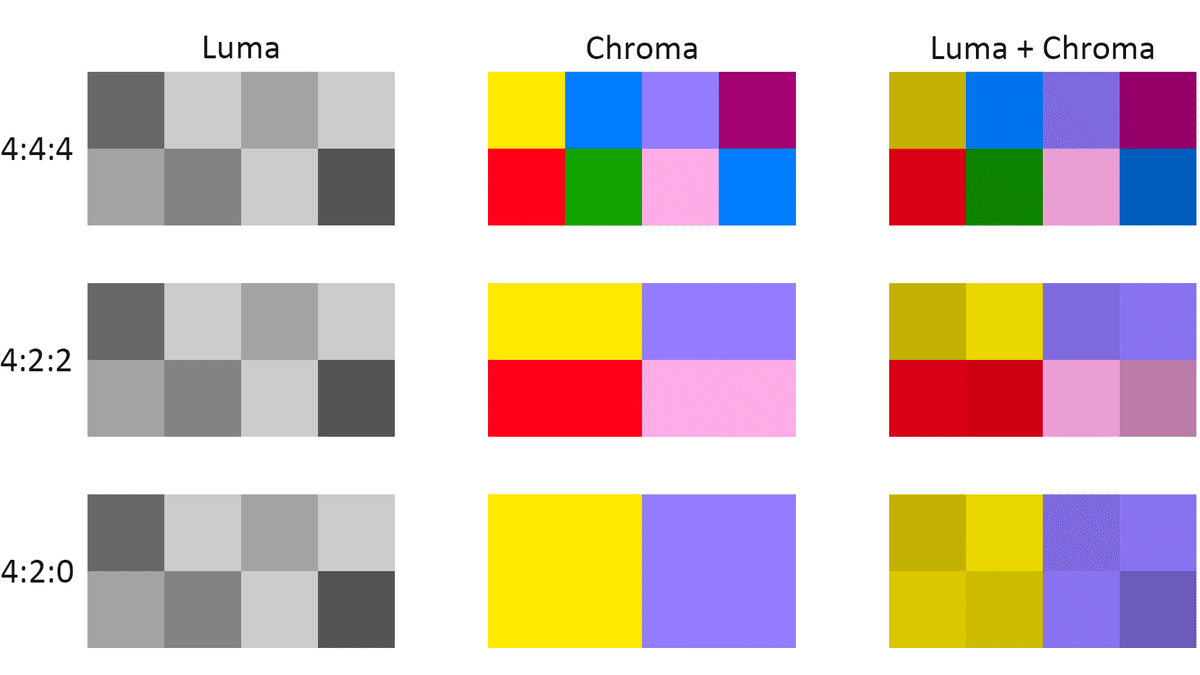

クロマサブサンプリングは4:4:4や4:2:0などのように3つの数字で表されています。(追加で、4444というのもありますが、透明などの追加のチャンネルが加わったもので字幕などの映像に使われてたりします。)

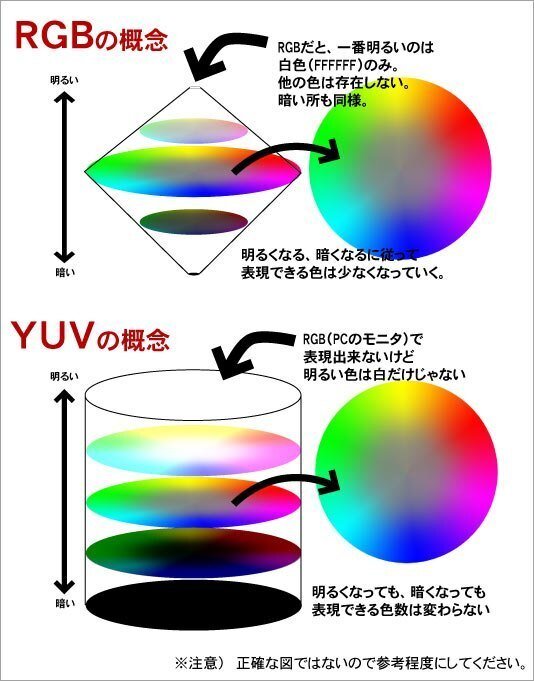

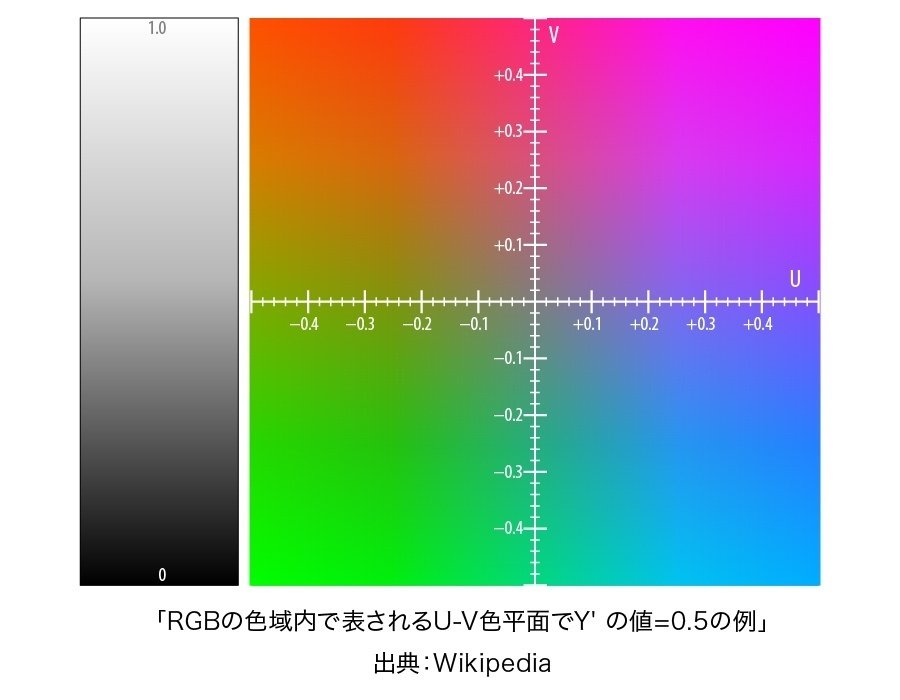

クロマサブサンプリングの説明の前に、RGBでなくYUVという色空間を説明します(YCbCrとYPbPrは省きます)。画像ではRGBで色を表すのですが、映像ではYUVで色が表されています。これは白黒テレビとカラーテレビが共存していた時の歴史的な流れから来ているので、あきらめてそういうもんだと覚えておきましょう。

YはLuminance(輝度)ですので、光の強さというか白っぽさと黒っぽさを担います。ですので、白黒テレビに映す場合はYだけのデータで表示できるということです。UとVは色差の情報です。RGBとは違い反対側には別の色があるため、2つの情報でRGBから明るさを抜いた情報が収まるわけです。

とりあえず、しっかり分からなくともYUVという色空間で映像が表示されてるんだなーと思っていただければ良いと思います。RGBをYUVに変換していることでデータを軽くするために情報を抜き取ってしまったのが4:2:2や4:2:0なのです。数字の意味としては分割の数になります。

横のピクセル数:横の分割:縦の分割

なぜそんなことができるのかというと、人間の目が色の差より明るさに敏感だからだそうです。正直、本当か?と思うので今度実験してみたいですね。よくある例え画像です。

クロマサブサンプリング444とかになると、現状はパソコンでしか再生できなくなります。クオリティを攻めるのは良いですが、お金が結構かかるのが難点だと思います。データ量も重くなってしまいます。

中間まとめ

このあたりの知識は、Youtubeなどであさるとザクザクでてきます。動画制作が一般的になった今、世界全土で動画に対するリテラシーが上がっています。そういった意味でも、このあたりは押さえておいたほうが良いと思います。美術館にきてがっかりする動画ファンが少しでも少なくなれば良いなと思います。

いっぽう、画質だけが作品の全てでは無いと思います。予算や環境の問題もあります。最終的には作品のコンセプトと相談かなと思います。上をみたらきりがないので「落としどころ」を見つける訓練をしたほうが良いのかなと個人的には思います。

音声の中身はどうなってるのか?

音に関しては、僕の知識だと足りない部分も多いかと思います。是非、「このあたりも基本かも?」というのがあればみなさま教えてくださいませ。自分の経験上、以下のような要素が音のデータでは大事でした。

サンプリングレート:sampling rate

ビット深度:bit depth

ビットレート:bit rate

チャンネル数:channel

チャンネルレイアウト:channel layouts

音量:audio levels

音は映像よりも難しいです。最初から難しくて恐縮ですが、スピーカから音がなるのは何故かを考えたいと思います。

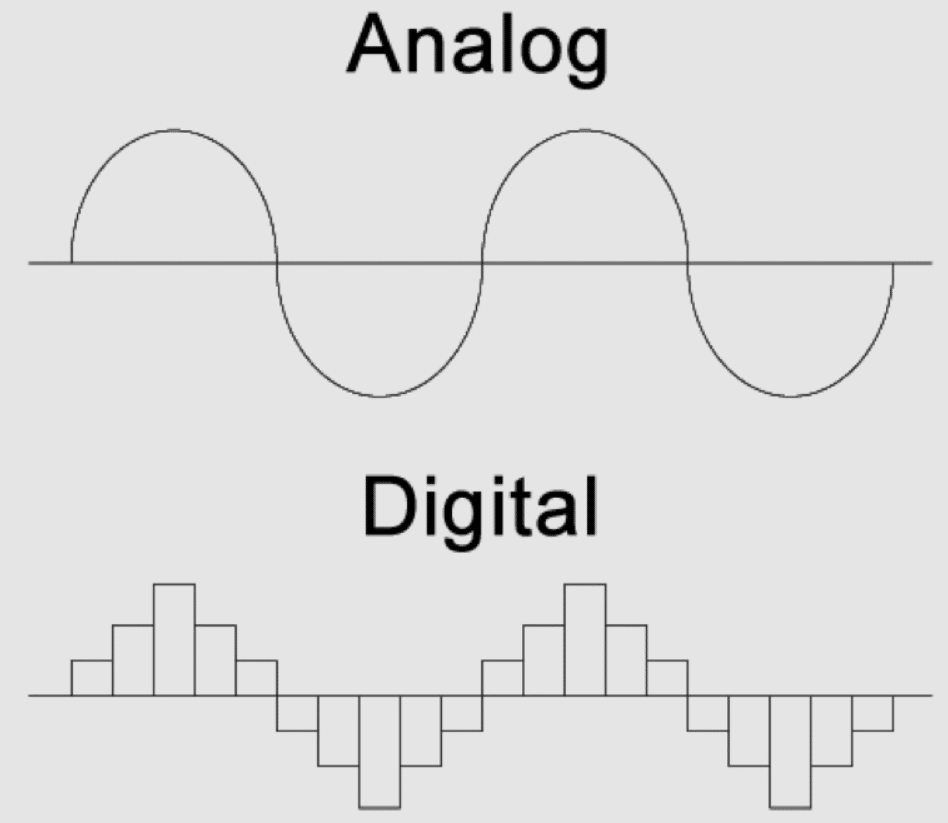

音は空気の振動であり振動は電圧の波に変換可能であることの理解がまずは必要です。音は空気の振動であることは中学校の理科で、振動は波で表せれることは高校物理でならいます。この時点で音は映像より難しさが増すことがお分かりいただけるかと思います。

すっごい簡潔に話すと、音データの中身はデジタルの波だと思ってください。アナログであったはずの波をどのようにデジタルデータに置き換えるのかというのがポイントだと思います。

もの凄い暴力的な説明をすれば、アナログはどこまで拡大してもギザギザの出ない波、ベクターデータのようなものです。デジタルは四角の細かさで決まるビットマップデータのようなものです。四角が小さければ小さいほど繊細に波を表現できますよね?

曲線の波をビットマップのように四角で表す時に必要な概念がサンプリングレートとビット深度なんです。

サンプリングレート:sampling rate

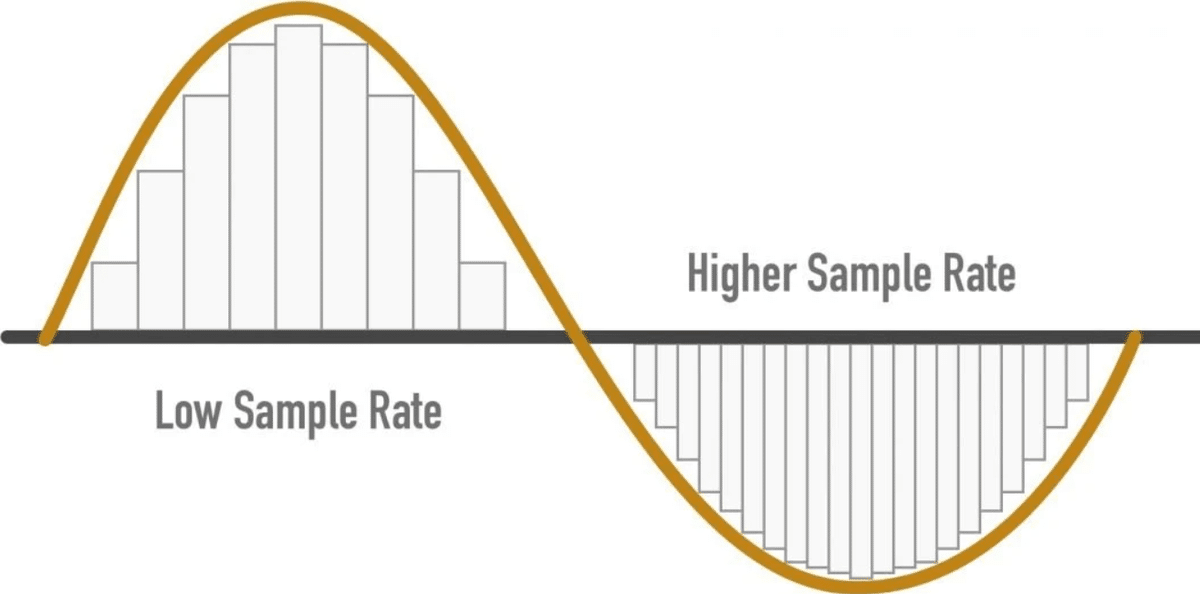

サンプリングレートとは「1秒間に波の高さを計る回数」と言ってよいのかなと思います。良くみるのが44,100Hzと48,000Hzです。1秒間に4万4千百回なのか、4万8千回なのかという違いです。

上の画像のように、サンプリングレートが高いほど波の曲線の再現性は高くなるわけです。映像でいうと解像度に近い感じがしますね。デジタルをアナログに直す処理をする機材のスペックに依存しますので、機材選びの際にお気をつけください。といっても、以下の記事に出てくる2種類であることが多いです。

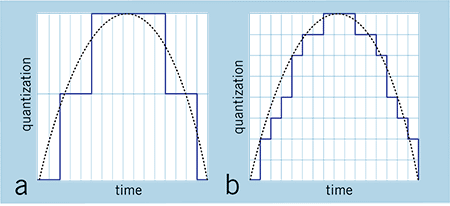

ビット深度(量子化ビット数):bit depth

ビット深度は映像データのほうでも出てきましたね。今度は波の高さを何分割して測定するかという話です。こちらも細かければ細かいほど微細な音がデータになることになります。同じサンプリングレートでもビット深度が低ければ波の再現性は良くないことが下の画像からわかると思います。

良く使われるのビット深度は16か24です。32bitというのが流行り出しましたが、ここでは割愛します。

ビットレート

ビットレートは、この後出てくる「データの基礎知識」にも登場します。ここでは、音のみのビットレートに関して説明します。

ビットレートとは、1秒間に流れるデータの量だと思ってください。bps=bit per secondという単位であらわされます。音の場合はK(1000の単位)がついてKbpsで表記されることがほとんどだと思います。

Kbps=K bit per second

いくらサンプリングレートやビット深度が高くとも、ビットレートが低ければ音質は劣化します。また、低いサンプリングレートやビット深度のデータに対して高いビットレートを設定しても意味はありません。両者の関係性をしっておくことが大事かなと思います。

チャンネル:channel

上記の二つの項目が音質だとすれば、この項目はインスタレーションにかかわってきます。作品プランで5人の声が別々のスピーカーから流れてほしいとします。こうなってくると5チャンネル必要となるわけです。

モノラル(1ch、正確には音源が真ん中あたりに聞こえる)やステレオ(2ch、左右から音が聞こえる)までなら一般的だと思います。家電が好きな場合、5.1chや7.1chのサウンドシステムを家に導入して映画をみている人も多いと思います。データに入るのは7.1ch程度ですが、映像インスタレーションだと16chとかを複数ファイルを同期して空間上で表現したりもします。

チャンネルレイアウト

チャンネルレイアウトは、機材のどの出力からどの音声が出るのかが決まるため大変重要です。インスタレーションでは、作家としっかりやり取りをして空間上にきっちり音声を振り分ける必要があります。

SMPTE/ITU : L R C LFE Ls Rs

Film : L C R Ls Rs Lfe

上記のように、5.1chといってもデータによって順番が違うことがあります。SMPTE/ITUは主にアメリカで、Filmは主にヨーロッパで一般的だそうです。

音量|dBFSとLUFS

dBという概念がまずややこしいです。編集ソフトなどのデータの上ではdBFC(デシベルフルスケール)というのを使います。

音の大きさは圧力のパスカルを使いdB SPLが基準っぽいです。SPLはSound Pressure Levelの略で、おそらくスピーカーなどのスペック表に乗っているdBはdB SPLのことだと思います。曖昧な知識で申し訳ないです……

また、電圧に対して使うdBというのもあります。dBuやdBm、さらにはdBVなどがあります。一概にdBといっても色々あるなと思っておいてもらえればうれしいです。

ひとまず、dBFSというのが編集ソフトなどで扱う相対的な音量を扱う単位だと考えて良いと思います。次に、LUFS/ラウドネスという概念を知っておくと良いと思います。

dBFS : Decibels relative to Full Scale

LUFS : Loudness Unit Full Scale

ラウドネスとは人間の耳で聞いた時の音量を数値にしたものです。機材やシステムによっては強制的にラウドネスを調整する仕組みが入っていいたりします。例えば、Youtubeなどは-13LUFSがラウンドネスノーマライゼーションの値です。編集ソフトでターゲットラウドネスを-13LUFSにして書き出すことで圧縮されない(聞こえにくくなってしまう音の発生を防ぐ)ことができます。

音量という身近な現象も掘り下げていくと大変難しい概念や仕組みがあることが分かります。この辺りはまだまだ勉強中ですので、理解が深まったころに再編集しようと思っています。

中間まとめ2

音はまだまだ勉強中のため、解説が単調になってしまい申し訳なわけないです。ストリーム数など触れる機会が少ない部分は省略しました。また、立体音響や音自体を作るような展示の場合は全く違った観点での説明が必要になると思います。

(僕も一度サウンドエンジニアの授業とか受けてみたいです。)

上のリンクは音の世界の奥深さがわかるオススメpodcastです。

データの基礎知識

映像データについてと音声データについて長々と解説してきましたが、もうすぐ終わりです!普段皆さんがみるmp4やらmovという拡張子がついたファイル(データ)とはなんなのかを説明していきます。

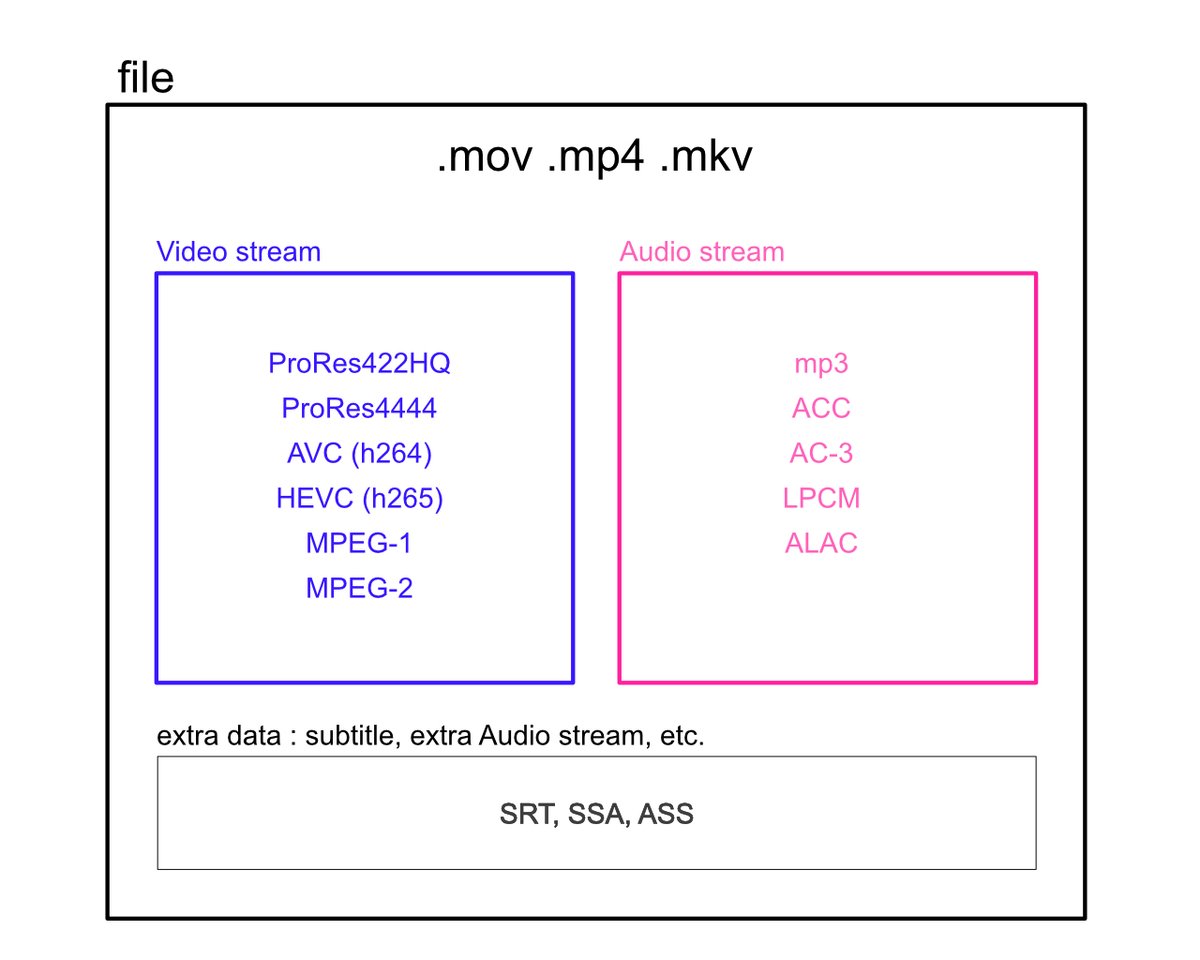

コンテナフォーマットとコーデック

.mp4や.movのような映像ファイルの中には、音のデータと映像のデータの2つが入っています。この2つのデータを格納しているファイルの種類をコンテナと言います。mp4などのコンテナフォーマット(容れ物の規格)は音と映像の複数のファイルをひとつのファイルに格納するためのものです。

良く使うコンテナフォーマット3つ

.mov ProRes系のコーデックが入る

.mp4 ほとんどのプレーヤーで再生できる

.mkv 字幕データも格納できる

コンテナフォーマットには以上のようなものがあります。これがそれぞれ何なのか?は今回はあまり深く考えずに、中に入れることができる映像ファイルや音ファイルの種類が違うことだけ覚えておきましょう。基本的にはmovとmp4がダントツで触れる機会が多いと思われます(2022年現在)。

コンテナに入れることができる音や映像は色々な種類のコーデックで圧縮されています。今回は分かりやすく「コーデックとは圧縮方法の種類」だと思っておいてください。圧縮方法によって表現できる幅が変わってくるので要注意です。

映像コーデック良く使うの3種

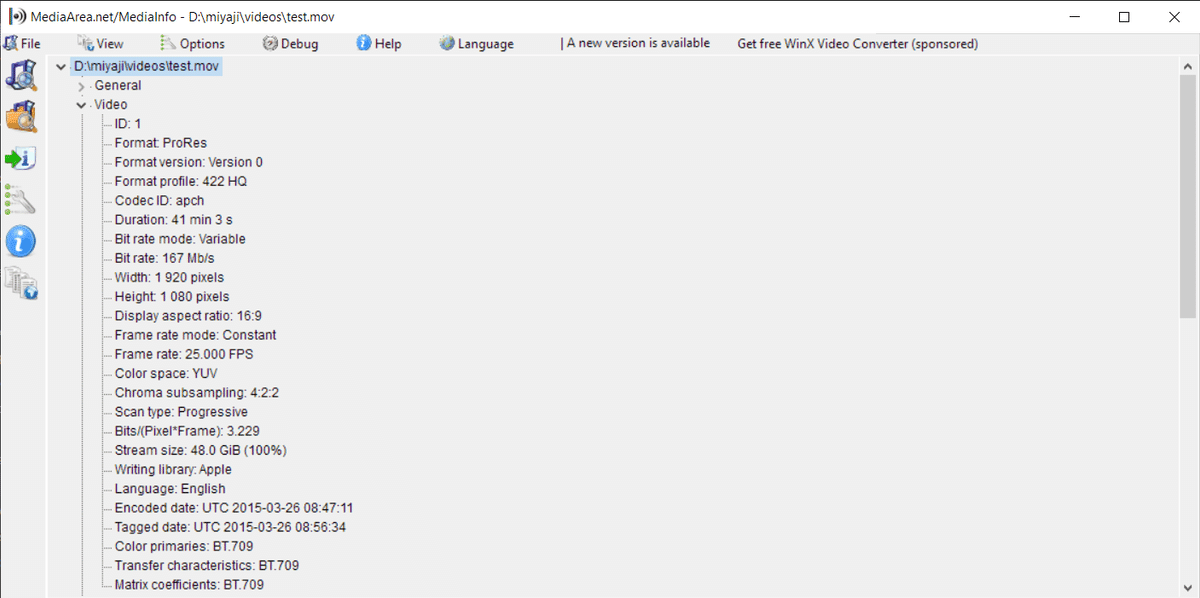

ProRes422HQ : クロマサブサンプリング422が使える

h265 : HEVCとも言われる。色深度10bitが使える

h264 : 古いメディアプレーヤーの時に利用する

ProResには種類があります。ProRes422HQのほかに、ProRes4444という透明などのチャンネルを追加したコーデックもあります。かなりきれいに映像を残せると思います。保管用データとしては優秀なのでは?と思う反面、パソコンでしか再生できないので展示運用コストが大きくなります。

2022年現在、1番お手頃なのがh265だと個人的には思っています。BrightSignというサイネージプレーヤーで再生可能なので、展示運用コストがかなり低いです。

音声コーデック良く使うの3種

AAC : 流せるプレーヤーが多い

wav : サウンドエンジニアの方からもらう時

AC-3 : マルチチャンネルの音が必要な時

音声コーデックはサウンドエンジニアの人からはwavのファイルで貰うことが多いかなという印象。申し訳ないですが、映像とくっつける時にAACにしてmp4の中に格納することが多いです。

コンテナとコーデックの関係

コンテナフォーマットによって、中に入れることができるコーデックが変わってきます。mov以外にProResを入れることはできませんし、mkvは字幕まで入れることができます。

時々、コンテナフォーマットのみを伝えられて機材選定をして欲しいといわれますが、コーデックが何か分からなければ機材は選定できません。個人的には映像の内容も見て再書き出しする時のコーデックやプロジェクターの種類なども考えるため、データはできるだけ早く見せて欲しいなと思っています。

ビットレートって?

音声の中身のところで少し出てきましたが、ビットレート(bit rate)という概念は覚えておいてください。1秒間にどれほどのデータ量が流れるかを表します。

価格の安いプレーヤーを利用する場合、処理できる情報量が少なすぎるため、ビットレートの部分がかなりシビアになります……。

プレーヤーの説明書などを読んで、適切なビットレートでファイルを書き出すことでカクついたりノイズが乗ったりすることが無くなる場合があります。

ただし、ビットレートが低いと画質はどんどん劣化していきます……

まとめ

映像作品を残す時にどこまでこだわってデータを残すべきでしょうか?モニターは手に入りやすくなりましたが、2022年現在は4Kのプロジェクターはまだまだ高級品かと思われます。120fpsや444のクロマサブサンプリングが本当に作品にとって重要かも考えものです。というか、上を見れば見るほど現実的ではないです。

基本的には、下の図の色の範囲が大きければ大きいほど高画質な映像データとなります。ただし、大きくなればなるほど再生できるプレーヤーも少ないですし表示できるモニターやプロジェクターも少なくなります。

上記の範囲はBrightSign HD224で再生できるデータとなります。HD224はビットレートは公式では最大が50Mbpsの推奨最大ビットレートが25Mbpsとなっています(僕は30Mbps前後で使用することが多いです)。カメラ、編集機材、プレーヤーは追いつていますが、全てを基準通りに展示できる環境はなかなか難しかも……色域が……(音は5.1chまで流せますが、映像コーデックが柔軟でないので微妙です。)

基本的には、データが「記録メディア→プレーヤー→ケーブル→映像機器」の順にキレイに流れるように書き出してあげることが重要だと思います。このあたりを理解していれば「なぜか映像が流れない!」の多くの場合を防ぐことができるのではないでしょうか?

逆に、低画質のデータにオーバースペックな機材を使うことはもったいない気がします。

無料で始められるソフトウェアとか

無料映像編集ソフト

BlacmagicdesignのDaVinci Resolveというのが個人的おすすめです。有料版のDaVinci Resolve STUDIOも現在47980円買い切りでバージョンの更新も更新料金は必要ないです。(僕が買った時が35000円程度でした……)

AdobeのPremiere ProとAfter Effectsの両方の領域に精通した作業ができます(映像編集ソフトなのでPhotoshopとIllastrator的な作業はできません)。

ちなみに、IllustratorとPhotoshopの部分をAffinityなどに置き換えれば、ある程度は脱Adobeすることは可能だと思います。買い切りソフトなのでかなりの金額を節約できます。ただし、共同作業者がAffinityを使ってることは少なく、1つのデザインを複数人で制作する時はAdobeはまだまだ強いです(2022年)。

Affinityは使いづらいなと思うこともしばしばあり、これからなのかなー?と思うソフトなのですが、映像編集においてはDaVinciの人口はかなり増えています。リモートワークによってBlacmagicのATEM miniが沢山売れたことや、Youtubeの盛り上がりによる映像制作が身近になったことが原因なのかな?と予想しています。

僕の業務内容にウェブや紙モノのデザインは入ってないので、買い切りのDaVinci ResolveとAffinityでやりくりしています。どうしてもAdobeが必要な時はたまにありまして、その時だけ月でAdobeを登録したりしています(年々、月だけ契約がやりにくくなってきている気がする……)。

無料音楽編集ソフト

DaVinciは音も編集できるソフトなのですが、音楽を作るソフトではありません。そこでサウンドエンジニアの人が良く使っているPro Toolsというのを紹介します。ProtoolsとはDAW:Digital Audio Workstationという音楽作成ソフトです。サウンドエンジニアの人が現場にはいることがあります。彼らは、セリフが入ったマルチ音源の音データを、現場や機材や時には映像に合わせて音質や音量やタイミングを編集しなおしたりしています。僕は最近Pro Toolsをインストールしてみましたが、あまり使っていないので紹介までとします!

最後に

ここまでをデータ編の基礎知識とします。このあたりまでは「作品理解」の範疇かと思いますので、映像展示に関わる全員が知っておいて欲しい「基礎知識」としました。

この辺りが水深1.2mほどの監視員のいるプールだとすれば、この先にはまだまだ大海が広がっています。監視員もいません!みんなが大海を自由に泳げる必要な無いと思うんです。ですが、展示を作り上げるうえでみんなが「泳ぐとは何なのか」を理解することは大事かなと思います。

その上で、その先の深い所や遠いところまで泳げる映像系エンジニアやサウンドエンジニア、テクニカルディレクターやインストーラーの人たちと展示を作り上げていけると良いのかなと思っています。

このあたりの知識をベースに持つことで、作品納品のやりとりや、展示での責任分解もしっかり行うことができるのではないでしょうか?映像展示はまだまだマネージメントされてない部分が多く、それらは共通した基礎知識がふんわりしているからかな?というのが僕の考えです。

たとえば、作家はProRes422HQで再生したいと思っているのに対して、BrightSign(H265のみ再生)しか備品になかったとします。この時、展示室に合わせた作品を作ってこなかった作家の問題でしょうか?それとも、展示空間に合わせた作品を選ばなかった企画者側の問題でしょうか?

(このあたり、責任分解されてないことは数多くあります……)

これは、個人の考えです。展示空間や備品にあわせて、ある程度データ側で合わせるという許可が作家から下りていたとします。展示機材や展示空間に合わせて作品が機能する状態に書き出し直すことはインストールの範疇かなと僕は思っています(僕個人は、許可が得られた場合は現場でガンガン書き出しなおしてます)。

(僕の仕事は機材選定が含まれていることがほとんどです。機材が用意されていた場合も、あまりにもひどければ口を出します。)

インストール:何か(人/機材/ソフトウェア/作品)を能力が発揮できる状態(使用可能な状態/権限を執行可能な状態)にしつらえること。

次の「ケーブル機材編」に関しては、逆にインストーラーや展示エンジニアの人達にある程度お任せしても良いのかなと思います。知識の寿命も短いです。コロコロ変わる規格や新しく出続ける機材についていくのが大変です。

書き出したらキリがないのである程度コンパクトに書く予定です。

ケーブル機材編のリンク

いいなと思ったら応援しよう!