各基盤モデル性能比較(o1, Gemini 2.0 Flash, Claude 3.5 Sonnet, Llama 3.3)

2022年のChatGPTの登場から始まり、ここ2年で実に多くの生成AI関連サービスが誕生し、世間を賑わせています。

もちろん、それを支える基盤モデルも、日々絶え間なく開発され続けています。

生成AIの世界では、そういったスピード感がある反面、どういったモデルが存在して、どういう違いがあるのか全体像が把握しきれない側面もあるかと思います。

この記事では、メジャーな基盤モデルを10個ほどピックアップして、まとめて比較していきます。

そもそも基盤モデルとは

基盤モデルとは、チャットボットや画像生成サービスを裏で動かしているAIそのものです。

洗濯機がモーターを使って動いているのと同じようなイメージで、生成AI関連サービスも基盤モデルを使って動いています。

モーターを使うことで洗濯機や電気自動車などが作られるように、基盤モデルを使うことで画像生成サービスであったり文書生成のサービスを作っているというわけです。

例えば、ChatGPTというAIチャットサービスは、GPT4oやGPT4o miniといった基盤モデルを使用しています。なので、基盤モデルの性能を比較することで、実質的に様々な生成AI関係のサービスのベースとなるAIを比較することができます。

結論から

今回の比較において、評価が良かったものが下の5つです。

順序立てて思考するような必要のある難しい問題においては、「思考の連鎖(Chain of Thought)」の機能を持つo1-preview(o1)が、

料金を考慮して万能なものを選ぶなら、Gemini2.0 flashやo1-miniがおすすめとなります。

o1-mini:少し高い、万能型

o1-preview:高価、思考力が必要な難しい問題向き

Llama 3.3 70B:安価、スピードも早く、クオリティはそこそこ

Gemini 1.5 pro:値段は普通、スピードは遅い、万能型

Gemini2.0 flash:安価(未定)、スピードも早く、万能型

各モデルの概要

GPT

ChatGPTは、OpenAI社によるモデルで、2022年11月30日のリリース以降、その簡単な使い方と言語理解能力により、わずか2ヶ月で1億ユーザーを突破する驚異的な発展を見せました。

GPT4oやGPT4o miniなどがメジャーなモデルで、2024年9月からリリースされたo1やo1-miniなどのoシリーズから「思考の連鎖(Chain of Thought)」の機能が導入され、論理的思考の能力が大幅に向上しています。

Gemini

Google社によるモデルで、大きく規模の違いで3つのモデルがあり、Flash→Pro→Ultraの順に規模が大きくなっています。

Claude

Anthropic社によるモデルで、一般的に自然な文章生成が特徴だとされています。こちらも、大きく規模の違いで3つのモデルがあり、Haiku→Sonnet→Opusの順に規模が大きくなっています。

Llama

InstagramやFacebookなどを手掛けるMeta社が開発しているモデルで、研究者向けにオープンソースとなっていることが特徴です。

クオリティの観点での比較

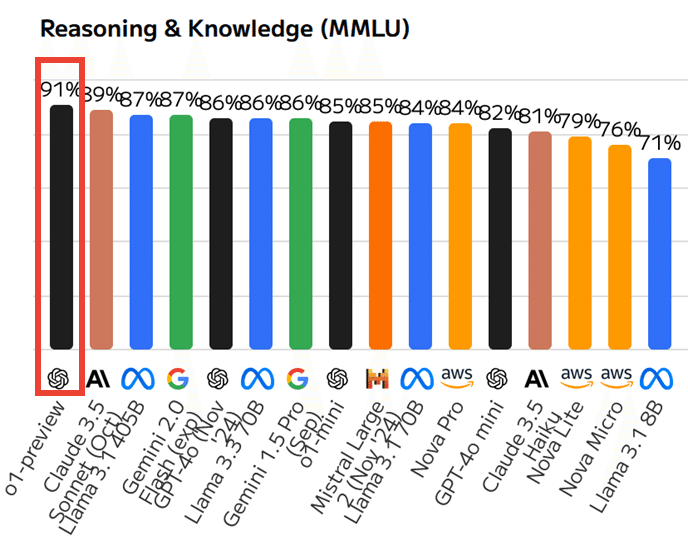

一般的な問題解決

MMLUという、基盤モデルの知識や問題解決能力を測定するメジャーなテストでの正解率です。左に行くほど良い結果となります。

推定される専門家レベルの正確さはおよそ89.8%である点を踏まえると、o1-previewは専門家超えと言えますが、他のモデルもこのテストではそれほど大きな差はないです。

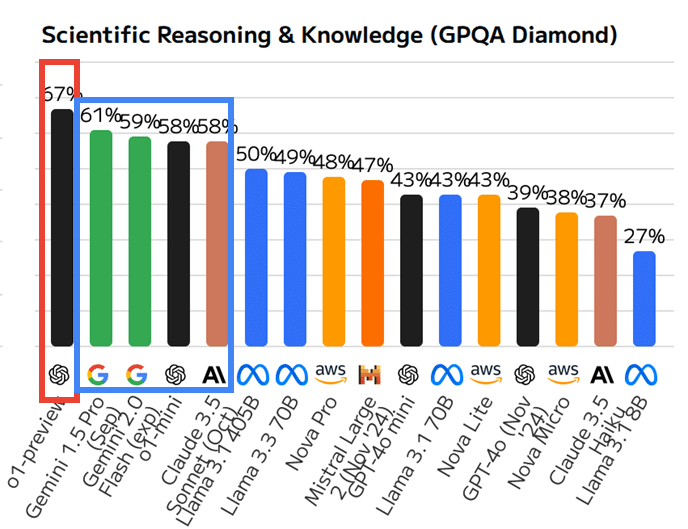

難易度の高い問題解決

MMLUよりも難易度が高いとされるGPQAのDiamondレベルでのテストが次のようになっています。

博士号取得者や博士課程の専門家でも正答率は65%、明らかなミスを除外しても74%であり、ここではo1-previewが頭一つ抜けています。

続いてgemini 1.5 pro, gemini2.0 flash, o1-mini, claude 3.5 sonnet(Oct)が同程度で、それ以降はガクッと性能が落ちています。

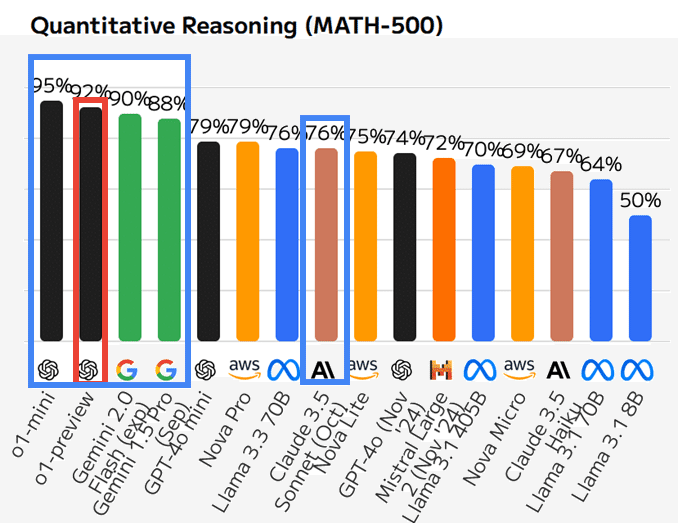

数学

数学問題でも、おおよそ順位はこれまでと同じく、o1-preview, o1-mini, gemini2.0 flash, gemini 1.5 proが好成績を残しているのですが、claude 3.5 sonnet(Oct)はここでは精度が落ちていることから、数学は苦手そうです。

スピードの観点での比較

一度に比較するものが多くなるとわかりにくくなるので、こちらの比較でもクオリティの観点で優秀だった、以下の5つのモデルをメインで見ていきましょう。

【OpenAIのoシリーズ】

・o1-preview

・o1-mini

【GoogleのGemini】

・gemini2.0 flash

・gemini 1.5 pro

【AnthropicのClaude】

・claude 3.5 sonnet(Oct)

生成速度

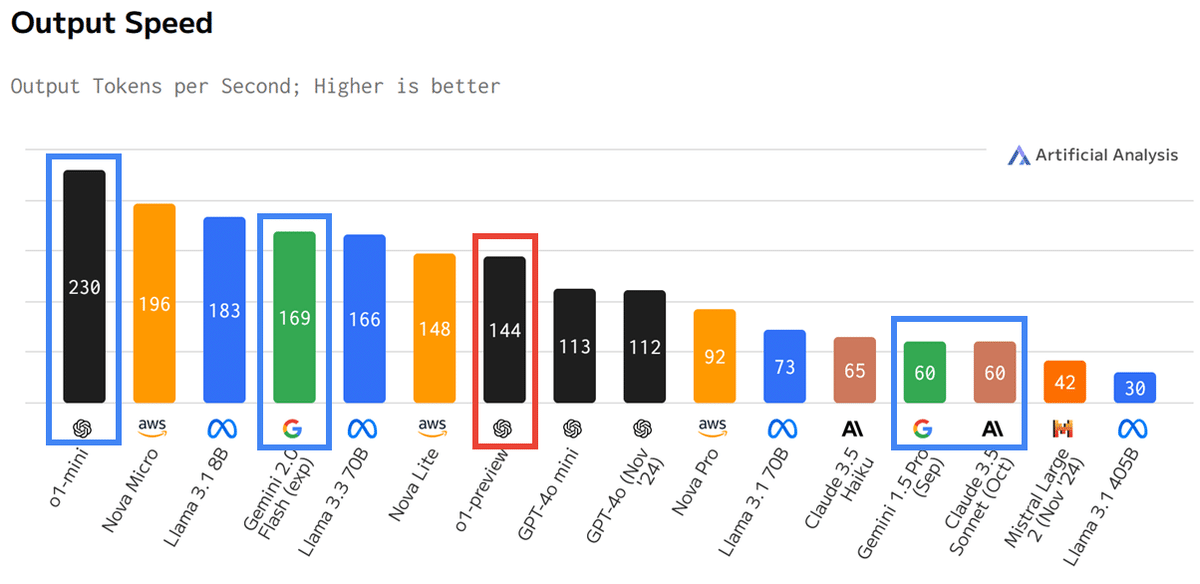

1秒あたりに生成できるトークン(文字)の量を測定した結果です。左に行くほど良い結果となります。

o1 miniは生成速度はかなり速く、続いてgemini2.0 flashやo1-previewはそれなりのスピードだと言えます。ただし、oシリーズは次項で取り扱うように思考時間がかなりかかるため、一概に生成速度だけで速いとは言えないです。

思考時間

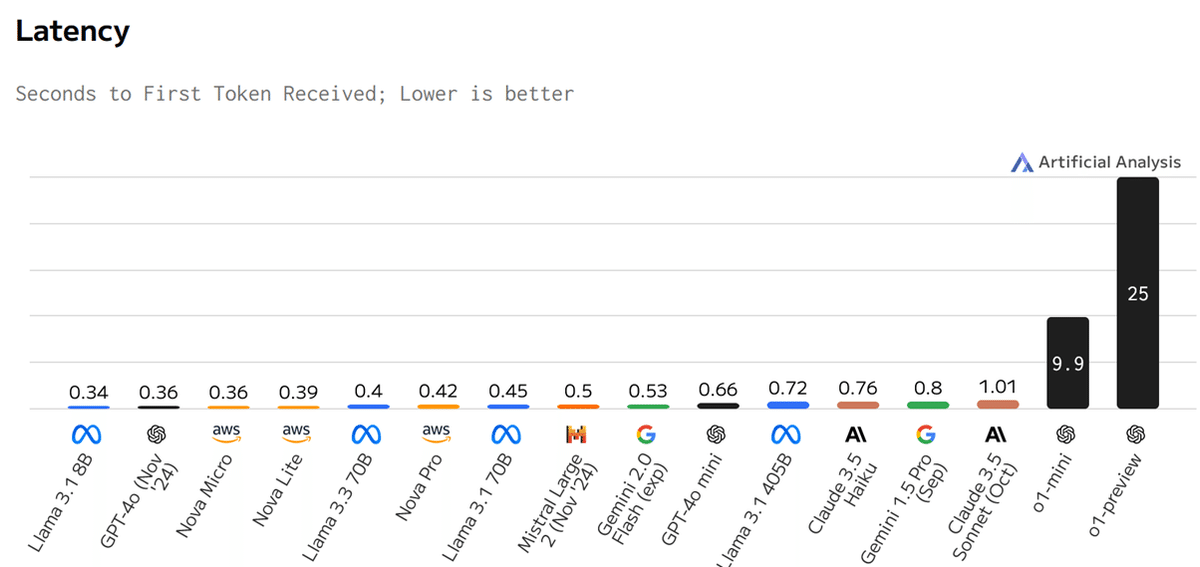

質問をして返答が返ってくるまでの時間です。左に行くほど良い結果となります。

「思考の連鎖(Chain of Thought)」によって論理的思考を行うo1-previewやo1 miniなどのoシリーズでは、質問を送ってから返答が返ってくるまでの思考時間が他のモデルと比べてかなり長くなっています。

コストの観点での比較

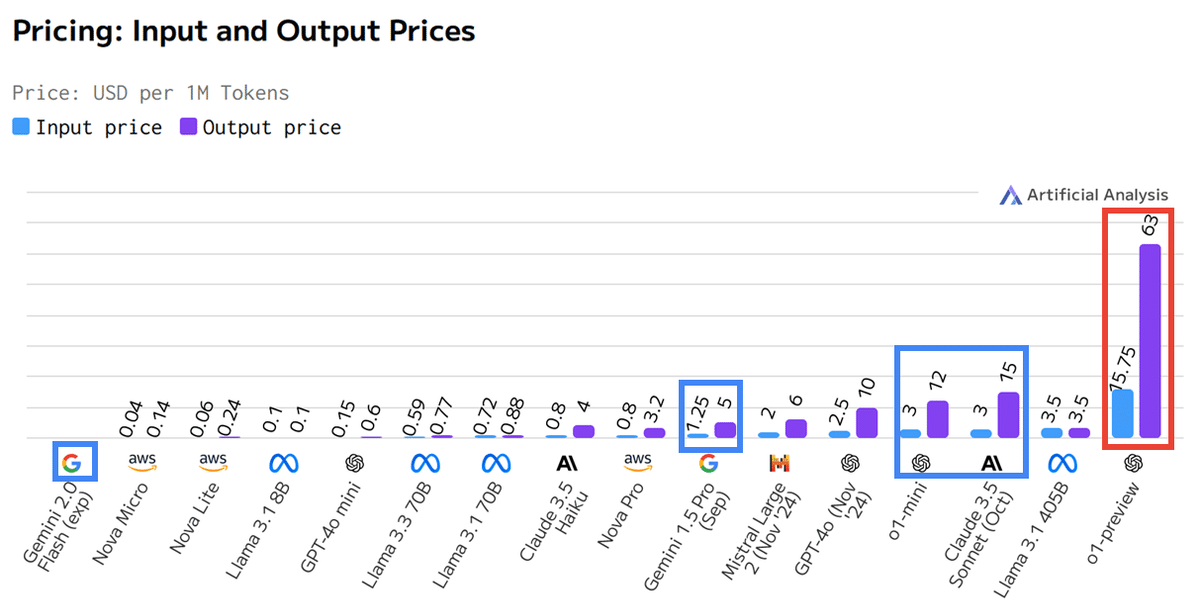

左側の水色の棒グラフ:質問のトークン(文字)数

右側の紫の棒グラフ:基盤モデルからの回答に使用されたトークン(文字)数

100万トークンあたりの料金を示しています。要約などなら左側、文章生成などなら右側の値により大きな影響を受けます。グラフ全体では左に行くほどコスパが良いと言えます。

o1-previewはかなりコストが高く、次いでo1-miniとClaude 3.5Sonnet (Oct)が現在のメジャーなモデルであるGPT-4o (Nov'24)と同等程度のコストとなっています。

gemini 1.5 proは、比較的安価でGPT-4o (Nov'24)の半分ほどの値段です。gemini2.0 flashも正式には公表されていないのですが、同じくコストは低そうだと言われています。

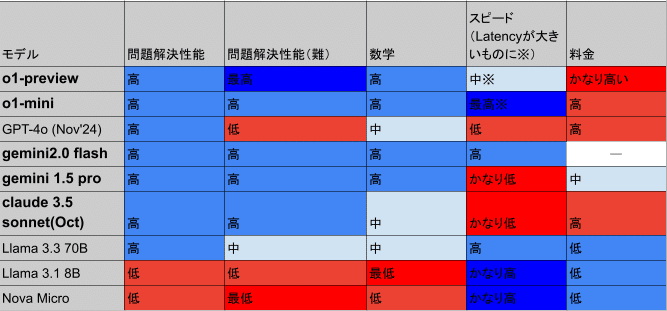

まとめ

記事中で触れたモデルの比較一覧です。

参考として、生成速度の観点で速かったNova Micro, Llama 3.1 8B, Llama 3.3 70Bも比較の参考として入れています。

参考文献

記事作成時点の2024/12/27のデータを参考にしています。

#生成AI #基盤モデル #AIモデル #ChatGPT #GPT4o #Gemini #Claude #Llama #AI比較 #AI性能比較 #o1preview #o1mini #Gemini20flash #Gemini15pro #Claude35Sonnet #Llama3370B #AIコスト #AI速度 #AI推論能力 #MMLU