【AI】AI事業者ガイドライン

本稿のねらい

経済産業省に設置された「AI事業者ガイドライン検討会」及び総務省に設置された「AIネットワーク社会推進会議」が、2024年4月19日付けで「AI事業者ガイドライン(第1.0版)」(本ガイドライン)を取りまとめた。

これは、次の各ガイドラインを見直しの上で統合するイメージである。

2017年7月28日付け制定「国際的な議論のための AI開発ガイドライン案」

2019年3月29日付け制定「人間中心のAI 社会原則」

2019年8月9日付け制定「AI利活用ガイドライン~AI利活用のためのプラクティカルリファレンス~」

2021年1月15日制定/2022年1月28日改訂「AI原則実践のためのガバナンス・ガイドライン Ver. 1.1」

本ガイドラインは、AIがもつリスクの大きさ(危害の大きさ&蓋然性)を把握し、その対策の程度をリスクの大きさに対応させるリスクベースドアプローチを採用し、かつ、アジャイル・ガバナンスの思想を参考とし適宜更新されることが予定されている(本ガイドラインが「第1.0版」とされているのはその思想の現れ)。

本ガイドライン取りまとめ後、EUのAI Act(AIA)を意識したのか、我が国でもソフトローではなくハードローによる規制(法規制)が検討され始めている。

とはいえ、現時点では「ソフトローを最大限活用しつつ、リスクの高いAIに対して必要な法的規制を検討」(第9回AI戦略会議【資料2-2】「『AI制度に関する考え方』について(概要)」4頁)とされている段階であり、ハイリスクAI以外のAIには引き続き本ガイドラインの内容が参考となることや、法規制が具体化・施行されるまでは相応に時間がかかると思われることから、ひとまずは本ガイドラインを参照する価値がある。

そこで、本稿では、本ガイドラインの中から、AIA等を踏まえ筆者が特に重要だと考える事項を中心に概説する。

なお、本ガイドラインの対象は、次の「AI事業者」、つまり「様々な事業活動においてAIの開発・提供・利用を担う全ての者(政府・自治体等の公的機関を含む)」である。

AI開発者(AI Developer)

AI システムを開発する事業者(AIを研究開発する事業者を含む)

AI モデル・アルゴリズムの開発、データ収集(購入を含む)、前処理、AIモデル学習及び検証を通してAI モデル、AIモデルのシステム基盤、入出力機能等を含むAIシステムを構築する役割を担う。

AI提供者(AI Provider)

AI システムをアプリケーション、製品、既存のシステム、ビジネスプロセス等に組み込んだサービスとしてAI利用者(AI Business User)、場合によっては業務外利用者に提供する事業者

AI システム検証、AIシステムの他システムとの連携の実装、AIシステム・サービスの提供、正常稼働のためのAIシステムにおけるAI利用者(AI Business User)側の運用サポート又はAIサービスの運用自体を担う。AIサービスの提供に伴い、様々なステークホルダーとのコミュニケーションが求められることもある。

AI利用者(AI Business User)

事業活動において、AIシステム又はAIサービスを利用する事業者

AI 提供者が意図している適正な利用を行い、環境変化等の情報をAI提供者と共有し正常稼働を継続すること又は必要に応じて提供されたAIシステムを運用する役割を担う。また、AIの活用において業務外利用者に何らかの影響が考えられる場合は、当該者に対するAIによる意図しない不利益の回避、AIによる便益最大化の実現に努める役割を担う。

なお、先日、2024年3月13日に採択され、同年5月21日に成立したEU AI Actについての概要記事を出しているため、あわせて参照されたい。

本ガイドラインの構成

本ガイドラインは、AI事業者が取り組むべき指針を示す本編と、どのような具体的アプローチを取るかを示す別添(付属資料)の大別され、それぞれの中で、各AI事業者に共通する部分(第2部)と、AI事業者ごとの部分(第3部から第5部)に分かれている。

本稿では、次のような献立で、本ガイドラインを概説する。

AIシステムのリスクとベネフィット(第1部関連)

AI事業者が共通して取り組むべき指針(第2部関連)

AI事業者ごとに取り組むべき指針とアプローチ(第3部から第5部関連)

AIシステムのリスク/ベネフィット

冒頭でも触れたとおり、本ガイドラインは、下記の観点から、AIがもつリスクの大きさ(危害の大きさ&蓋然性)を把握し、その対策の程度をリスクの大きさに対応させるリスクベースドアプローチを採用している。

AI は、新規ビジネスを生み出したり、既存ビジネスの付加価値を高めたり、生産性を向上させたりする等の便益をもたらす一方で、リスクも存在する。 このリスクについては可能な限り抑制することが期待される。

一方で、過度なリスク対策を講じることは、コスト増になる等、AI活用によって得られる便益を阻害してしまうことから、リスク対策の程度をリスクの性質及び蓋然性の高さに対応させるリスクベースアプローチの考え方が重要である。

AIを活用することで得られる/得られる可能性があるとされている基本的なベネフィットは次のとおりである。

運営コスト削減

既存事業のイノベーションを加速させる新製品・サービスの創出

組織変革

これに加えて、各分野への応用や展開モデルの活用も考えられている。

これに対する主なリスクは、次のとおり整理されている。

これらのうち、個別には諸々対応が実施又は検討されている。

個人情報:「生成AIサービスの利用に関する注意喚起等について」

機密情報:「秘密情報の保護ハンドブック」改訂(2024年2月)

ディープフェイク:「インターネット上の偽・誤情報対策技術の開発・実証事業」

著作権:「AI と著作権に関する考え方について」

これらのリスクとベネフィットを踏まえて、AI事業者の経営層がガバナンス体制を構築する必要がある。

なお、AIAも同様にリスクベースドアプローチを採用しているが、AIAの方が精緻というか、細かいカテゴライズがされているのは周知のとおり。

共通指針など

A. 基本理念

大した意味を持たない部分であり省略

B. 原則

C. 共通指針とあえて分ける意味がわからないため省略

C. 共通指針

【全体像】

【各論】

方向性がよくわからず(※)、まとめづらい。

※ 例えば、1)人間中心では論点提起+AIの要件だが、2)安全性ではAIの要件+AI事業者の義務など、内容がバラバラでうまいことカテゴライズされていないという意味(AIAはそのあたりうまく分類している)

1)人間中心

各主体は、AIシステム・サービスの開発・提供・利用において、後述する各事項を含む全ての取り組むべき事項が導出される土台として、少なくとも憲法が保障する又は国際的に認められた人権を侵すことがないようにすべきである。また、AIが人々の能力を拡張し、多様な人々の多様な幸せ(well-being)の追求が可能となるように行動することが重要である。

① 人間の尊厳・個人の自律

*AIプロファイリングなどが論点

② AIによる意思決定・感情の操作等への留意

*サブリミナル、フィルターバブル、エコーチェンバーなどが論点

③ 偽情報等への対策

*ディープフェイクなどが論点

④ 多様性・包摂性の確保

*ユニバーサルデザイン、アクセシビリティの確保などが論点

⑤ 利用者支援

⑥ 持続可能性の確保

*地球環境への影響などが論点

2)安全性

各主体は、AIシステム・サービスの開発・提供・利用を通じ、ステークホルダーの生命・身体・財産に危害を及ぼすことがないようにすべきである。加えて、精神及び環境に危害を及ぼすことがないようにすることが重要である。

① 人間の生命・身体・財産、精神・環境への配慮

*アウトプットの正確性・信頼性・堅牢性

*必要なモニタリング

*リスク分析・対策、情報提供

② 適正利用

③ 適正学習

*データの正確性・最新性・透明性・遵法性

3)公平性

各主体は、AIシステム・サービスの開発・提供・利用において、特定の個人ないし集団への人種、性別、国籍、年齢、政治的信念、宗教等の多様な背景を理由とした不当で有害な偏見及び差別をなくすよう努めることが重要である。また、各主体は、それでも回避できないバイアスがあることを認識しつつ、この回避できないバイアスが人権及び多様な文化を尊重する観点から許容可能か評価した上で、AIシステム・サービスの開発・提供・利用を行うことが重要である。

① AIモデルの各構成技術に含まれるバイアスへの配慮

*バイアスの要因となるポイントの特定

② 人間の判断の介在

4)プライバシー保護

各主体は、AIシステム・サービスの開発・提供・利用において、その重要性に応じ、プライバシーを尊重し、保護することが重要である。その際、関係法令を遵守すべきである。

① AIシステム・サービス全般におけるプライバシーの保護

5)セキュリティ確保

各主体は、AIシステム・サービスの開発・提供・利用において、不正操作によってAIの振る舞いに意図せぬ変更又は停止が生じることのないように、セキュリティを確保することが重要である。

① AIシステム・サービスに影響するセキュリティ対策

② 最新動向への留意

6)透明性

各主体は、AIシステム・サービスの開発・提供・利用において、AIシステム・サービスを活用する際の社会的文脈を踏まえ、AIシステム・サービスの検証可能性を確保しながら、必要かつ技術的に可能な範囲で、ステークホルダーに対し合理的な範囲で情報を提供することが重要である。

① 検証可能性の確保

*ログの記録・保存

② 関連するステークホルダーへの情報提供

*AI利用の事実・その範囲などの情報提供(電子透かしなど)

③ 合理的かつ誠実な対応

④ 関連するステークホルダーへの説明可能性・解釈可能性の向上

7)アカウンタビリティ(※)

各主体は、AIシステム・サービスの開発・提供・利用において、トレーサビリティの確保、「共通の指針」の対応状況等について、ステークホルダーに対して、各主体の役割及び開発・提供・利用するAIシステム・サービスのもたらすリスクの程度を踏まえ、合理的な範囲でアカウンタビリティを果たすことが重要である。

※ アカウンタビリティとは、説明責任のことではなく、AIに関する事実上・法律上の責任を負うこと及びその責任を負うための前提条件の整備に関する概念とのことである

① トレーサビリティの向上

② 「共通の指針」の対応状況の説明

③ 責任者の明示

④ 関係者間の責任の分配

⑤ ステークホルダーへの具体的な対応

⑥ 文書化

8)教育・リテラシー

各主体は、主体内のAIに関わる者が、AIの正しい理解及び社会的に正しい利用ができる知識・リテラシー・倫理感を持つために、必要な教育を行うことが期待される。また、各主体は、AIの複雑性、誤情報といった特性及び意図的な悪用の可能性もあることを勘案して、ステークホルダーに対しても教育を行うことが期待される。

9)公正競争確保

各主体は、AIを活用した新たなビジネス・サービスが創出され、持続的な経済成長の維持及び社会課題の解決策の提示がなされるよう、AIをめぐる公正な競争環境の維持に努めることが期待される。

10)イノベーション

各主体は、社会全体のイノベーションの促進に貢献するよう努めることが期待される。

① オープンイノベーション等の推進

② 相互接続性・相互運用性への留意

③ 適切な情報提供

D. 高度なAIシステムに関係する事業者に共通の指針

ここでいう「高度なAIシステム」とは、「最先端の基盤モデル及び生成AIシステムを含む、最も高度なAIシステム」(高度なAIシステムを開発する組織向けの広島プロセス国際指針)をいうとされている(本ガイドライン9頁)。

これが何を指すのか、どういう基準なのかは明確に定義されていないが、「高度なAIシステムを開発する組織向けの広島プロセス国際行動規範」によ

れば、次のようなリスクをもつものが想定されているように思える。

兵器開発等のリスク

サイバー攻撃リスク

健康安全を司る重要インフラへの干渉リスク

"自己複製"リスク

偏見・差別リスク

プライバシー・データ保護の侵害リスク

偽情報の助長リスク

民主主義・人権への脅威となるリスク

システミックリスク

なお、AIAは、"High-Risk AI Systems"を定義し、また"general-purpose AI model with systemic risk"を定義している。

この高度なAIシステムに関係する事業者は、上記C. 共通指針に加え、次の12の事項への遵守も求められている。

高度なAIシステムの開発全体を通じた適切な措置

上市/導入後の脆弱性・インシデントパターンの特定・緩和

高度なAIシステムの能力/限界/使用領域の公表と透明性確保支援

高度なAIシステムを開発する組織間の情報共有とインシデント報告

AIガバナンス及びリスク管理方針の策定/実施/開示

物理的セキュリティ/サイバーセキュリティ/内部脅威に対する安全対策を含む強固なセキュリティ管理への投資/実施

AI利用者やエンドユーザーがAI生成コンテンツを識別するための信頼できるコンテンツ認証/来歴メカニズムの開発/導入(電子透かし等)

社会的/安全/セキュリティ上のリスク軽減の研究と効果的な軽減策への投資の優先

世界最大課題(特に気候危機/世界保健/教育等)への対処のための高度なAIシステムの開発の優先

国際的な技術規格の開発/採用の推進(電子透かし等)

適切なデータインプット対策の実施/個人データと知的財産の保護

高度な AI システムの信頼/責任ある利用の促進と貢献

E. AIガバナンスの構築

これについては本ガイドライン別添20-70頁を参照のこと。(いかにもコンサル屋さんが好きそうな作成したであろう毒にも薬にもならない説明が書いてある)

個別指針/アプローチ

これは、とても見づらいのだが、後々、D-2とかP-2とか急に2から始まるよくわからない識別記号/番号を把握するために必要な表である。

つまり、D-2といえば、AI開発者に求められる事項のうち、共通指針の2)の安全性に関するものを指し、同様に、P-2といえば、AI提供者に求められる事項のうち、共通指針の2)の安全性に関するものを指すという具合である。

AI開発者に関する事項

AI開発者は、AIシステム/モデルの開発前・開発時・開発後のいずれの段階にも関与することから「AIの出力に与える影響力が高い」とされている。

【開発前(データ前処理/学習時)】主にリスク対応

D-2) ⅰ. 適切なデータの学習

・学習時のデータの適正取得

・個人情報・知的財産等が含まれる場合の適法な取扱い

*差分プライバシー、データ暗号化、データ管理コンソール

・データ管理制限機能等適切な保護

D-3) ⅰ. データに含まれるバイアスへの配慮

・データの質を管理

・代表的なデータセットによる学習

・不公正なバイアスがないか点検

【開発時】主にリスク対応とセキュリティ

D-2) ⅱ. 人間の生命・身体・財産、精神・環境に配慮した開発

・予期しない環境での利用にも耐えうる性能要求

*フェールセーフ機能、フォールトトレラント設計、フールプルーフ設計

・リスクを最小限に抑える方法要求

*ガードレール設定、フォールバック設計

D-2) ⅲ. 適正利用に資する開発

・安全なAI利用方法の方針/ガイダンス設定

*ガードレール設定

・事後学習させる学習済モデルの適切な選択

D-3) ii. AI モデルのアルゴリズム等に含まれるバイアス等への配慮

・AIモデルを構成する各技術要素によりバイアスが含まれることを検討

*プロンプトへの留意(利用規約等の締結で制限?)

*推論時の情報/外部サービスの確認

・代表的なデータセットによる学習

・不公正なバイアスがないか点検されることを確保

D-5) i. セキュリティ対策のための仕組みの導入

・セキュリティ・バイ・デザイン

D-6) i. 検証可能性の確保

・ログの記録/保存

【開発後】主にセキュリティと情報提供

D-5) ii. 最新動向への留意

D-6) ii. 関連するステークホルダーへの情報提供

*AIを活用している旨/AIを活用している範囲の表示

*倫理ポリシー策定

D-7) i. AI 提供者への共通指針の対応状況の説明

D-7) ii. 開発関連情報の文書化

AI提供者に関する事項

AI提供者は、AI開発者が開発したAIシステムに付加価値を加えてAIシステム・サービスをAI利用者に提供する。

また、AI提供者には、AI開発者が意図した範囲で実装し、正常稼働・適正運用の継続が求められる。

【AIシステム実装時】

P-2) ⅰ. 人間の生命・身体・財産、精神・環境に配慮したリスク対策

・様々な状況下でパフォーマンスレベルを維持できるようにする

・リスクを最小限に抑える方法の検討

P-2) ⅱ. 適正利用に資する提供

・AI開発者が設定した範囲での活用

・AI開発者が設定した想定利用環境の意識

P-3) ⅰ. AI システム・サービスの構成/データに含まれるバイアスへの配慮

・バイアスによるアウトプットへの留意

・公平性の基準の確認

*集団公平性:異なる集団間で差別を生じさせないこと

*個人公平性:属性値が類似している者の間で差別を生じさせないこと

P-4) ⅰ. プライバシー保護のための仕組み/対策の導入

・プライバシー・バイ・デザイン

P-5) ⅰ. セキュリティ対策のための仕組みの導入

・セキュリティ・バイ・デザイン

P-6) ⅰ. システムアーキテクチャ等の文書化

・ログの記録/保存

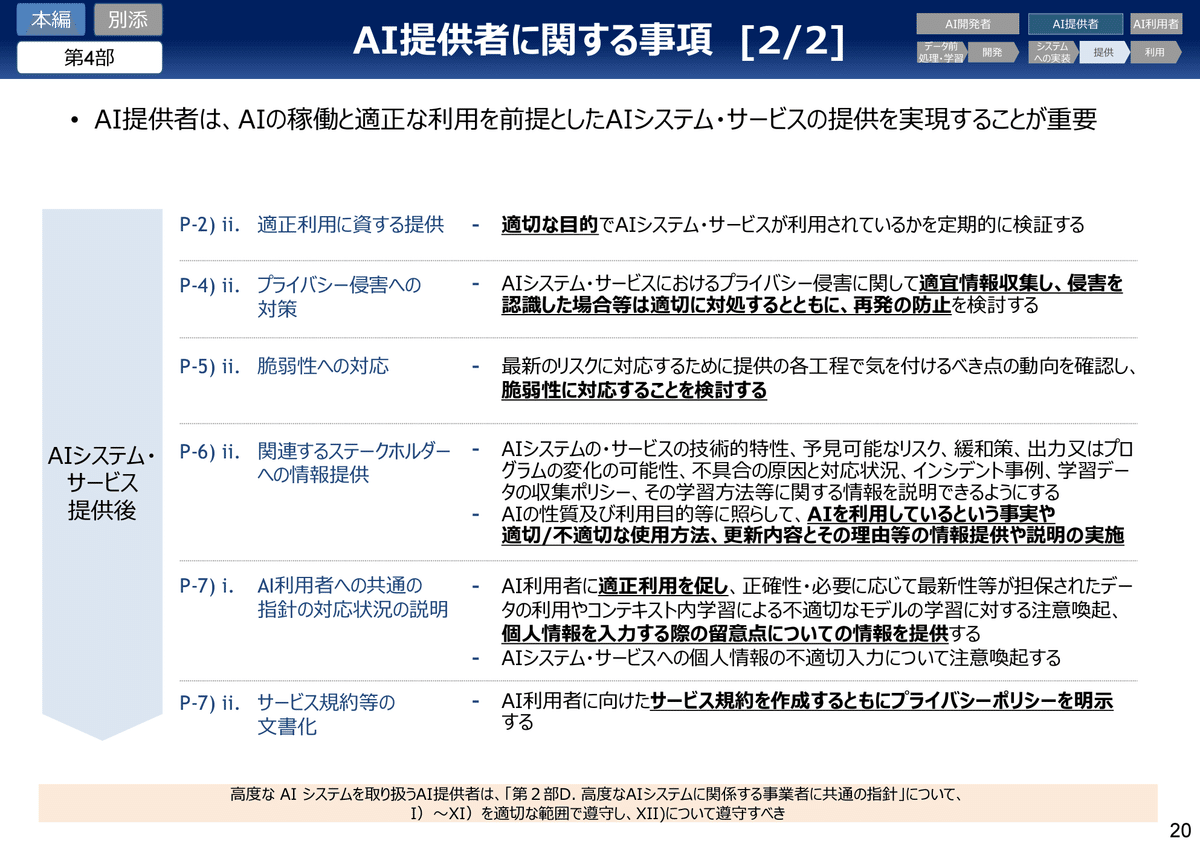

【AIシステム・サービス提供後】

P-2) ⅱ. 適正利用に資する提供

P-4) ⅱ. プライバシー侵害への対策

・プライバシー侵害に関する情報収集

・プライバシー侵害発生時の対応/再発防止

P-5) ⅱ. 脆弱性への対応

*機械学習特有の各種攻撃(データポイズニング等)への対策

P-6) ⅱ. 関連するステークホルダーへの情報提供

P-7) ⅰ. AI 利用者への共通指針の対応状況の説明

P-7) ⅱ. サービス規約等の文書化

・サービス内容・範囲・品質等に関するサービスレベル合意(SLA)

AI利用者に関する事項

繰り返しになるが、ここでいうAI利用者は、自己の事業活動において、業務効率化、生産性・創造性の向上等のベネフィットを受けるためにAIシステム/サービスを利用する事業者である。

U-2) ⅰ. 安全を考慮した適正利用

U-3) ⅰ. 入力データ又はプロンプトに含まれるバイアスへの配慮

U-4) ⅰ. 個人情報の不適切入力及びプライバシー侵害への対策

*個人情報の適正利用、プライバシー保護組織の創設

U-5) ⅰ. セキュリティ対策の実施

*機密情報の適正な取扱い

U-6) ⅰ. 関連するステークホルダーへの情報提供

当該AIの出力結果を特定の個人又は集団に対する評価の参考にする場合は、AIを利用している旨を評価対象となっている当該特定の個人又は集団に対して通知し、当ガイドラインが推奨する出力結果の正確性、公正さ、透明性等を担保するための諸手続きを遵守し、かつ自動化バイアスも鑑みて人間による合理的な判断のもと、評価の対象となった個人又は集団からの求めに応じて説明責任を果たす

これはAIAにおいてハイリスクAIのデプロイヤに課される義務に類似するが、より広いように感じる。

高リスクAIシステムを職場において使用開始する前に、使用者(デプロイヤ)は、労働者が当該AIシステムの使用対象となることを、労働者の代表と影響を受ける労働者に通知する

U-7) ⅱ. 提供された文書の活用及び規約の遵守

以上