NVIDIAのネットワーク・ソリューション:市場ポジションと世界最高峰のエコシステムについて

今や、NVIDIAの話題については、事欠かない状況にありますが、その話題の中でも比較的控えめに扱われやすいのが、ここ数年、彼らが製品開発と市場展開を加速しているネットワーキング・ソリューションの領域です。

ネットワーク・ソリューションといえば、NVIDIAのフラッグシップであるGPUを補完するサブプロダクト的なイメージがあるかもしれませんが、NVIDIAの驚異的な企業成長、特にデータセンター・セグメントの爆発的成長を支える重要な要素の1つであるのがネットワーク・ソリューションのプロダクトです。

今回の投稿では、少し視点を変えて、彼らの持っているネットワーキング・プロダクトについて、その市場ポジションや技術的な優位性などを競合他社への影響なども踏まえて、整理してお伝えしたいと思います。

[改訂履歴]

・2024/07/04:Spectrum-X Network Platform のYoutubeビデオの埋め込み

1. はじめに

NVIDIAのネットワーク・ソリューションにスポットファイトがあたった直近の出来事は、先月5月22日の同社FY25Q1の決算イベントです。

そこでは、AIに最適化されたSpectrum-X EthernetソリューションをQ1から出荷し始めたことが発表され、カンファレンスコールでは、ジェンスン・フアンCEOがネットワーク・ソリューションの製品開発の加速を声高らかに宣言しました。

そして、これを受けた株式市場では、データセンター向けイーサネット・ファブリック・ベンダーのArista Networks(ANET)の株価が8%を超えて一時下落。特にデータセンター向けのハイエンドのネットワーク・ソリューションを展開するベンダーへの影響が引き続き懸念されている状況にあります。

NVIDIAのネットワーキング・ビジネスは、スイッチチップに代表されるシリコンチップの開発からソフトウェアの開発、そしてネットワーク機器などの完成品の製造まで、垂直統合型のプロダクトビジネスであることから、既存のネットワーク業界の裾野広いプレイヤーに影響を与えるものと考えられており、この投稿では、NVIDIAが展開するネットワーキング技術であるNVLinkやInfiniBand、そしてイーサネットの特徴を踏まえ、AIファクトリーやAIクラウドといったNVIDIAの標榜する次世代データセンターのコンセプトを見据えて、特にNVIDAが製品拡充を加速しているイーサネットを技術ベースとした「Spectrum-Xシリーズ」について、競合他社への影響などを踏まえて、整理の上で紹介したいと思います。

2. NVIDIAのネットワーキング・ビジネス

(1)ネットワーキング・ビジネス概況

まず、NVIDIAの業績報告からネットワーキング・ビジネスのイメージをつかんでみたいと思います。

2025年度Q1決算で報告されているNVIDIAのデータセンター・セグメントの売上高は225.63億ドルで、これは前年対比で427%増、前四半期比では23%増となっています。この売上の内訳は、GPUプラットフォームを中心とするコンピューティング領域とInfiniBandとイーサネットによるネットワーキング領域の2つに区分されており、うちコンピュートの売上は前年対比5倍の194億ドルで、前四半期比では29%増となっています。また、ネットワーキングについては、前年対比3倍となる売上32億ドルで、前四半期比では5%減となっています(この5%減は出荷タイミングによる影響とのことです)。つまり大まかに区分すると、データセンター・ビジネスの総売上のうち、86%がGPUプラットフォームを中心とした売上であり、残り14%がネットワーキング・プロダクトの売上となります。

尚、2024年度通期では、データセンター・セグメントの売上高は474億ドルでしたが、ネットワーキングについては、「InfiniBandの出荷増によりネットワーキングの売上は133%増加した」と言及されているのみで、内訳となる数字は公表されていません。

とはいえ、GPUが主力製品の急成長を遂げているビジネスの中で、売上比率14%で、かつ急速に出荷が伸びているネットワーキング・ビジネスは、相当に優秀なカテゴリー製品であると言うことができます。

尚、NVIDIAのデータセンター・セグメントは、上述の通り、大きく以下の2つのカテゴリーのプロダクト・ソリューションから構成されます。

① コンピューティング・ソリューション

NVIDIAのフラッグシップであるGPUを中心としたアクセラレーテッド・コンピューティング・プラットフォームに係わるプロダクト・ソリューションです。生成AIのタスクやデータ解析、HPCやグラフィックス処理などの計算集約的なワークロードを高速処理するコンピューティング・プロダクトで、Hopper GPUコンピューティング・プラットフォーム(H100/H200)や次期Blackwellプラットフォーム等によって構成されています。

② ネットワーキング・ソリューション

NVIDIAのアクセラレーテッド・コンピューティング・プラットフォームを支える高性能なネットワーキング・プラットフォームに係わるプロダクト・ソリューションです。数百~数千のコンピュートノードを高速に相互接続するInfiniBandおよびイーサネットをベース技術したスイッチやネットワークアダプタ、DPU(データ処理ユニット)やケーブル、その他関連ソフトウェアが含まれます。

本投稿記事でスコープするのがこのネットワーキング・ソリューションです。

(2)FY25:推しのネットワーキング

さて、最近のNVIDIAは、彼らのネットワーキング・ソリューションをどのようにマーケットにアピールしているのでしょうか。参考として、直近のFY25Q1の決算でNVIDIAが言及したネットワーキング・ビジネスに関連する発表や発言を抜粋してみました。

これらの発表や発言から、NVIDIAのネットワーキング・ソリューションの重要性や意気込み、期待感を感じることができると思います。

① ネットワーキング・ソリューションへの取組み状況のアピール

以下は、FY25Q1決算時に配布されていたInvestor Presentationからネットワーク・ソリューションに関する発表内容を抜粋したものです。

巨大なAIシステムを高速通信で支えるネットワーキング・プラットフォームとして、GPUシステムと蜜に連携するInfiniBandプロダクトとイーサネットプロダクトをアピールしています。

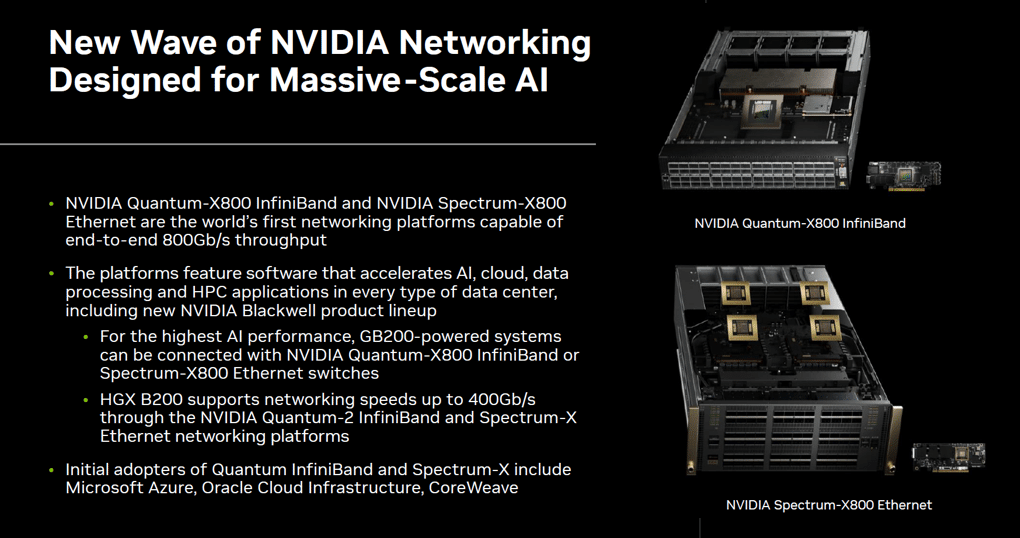

<巨大AIのために設計されたネットワーキングの新たな波>

NVIDIA Quantum-X800 InfiniBand と NVIDIA Spectrum-X800 Ethernetは、エンドツーエンドで 800Gbps のスループットを可能とする世界初のネットワーキング・プラットフォーム

Blackwellを含むデータセンターのあらゆるユースケース(AI、クラウド、データ処理、HPC)を加速するソフトウェアを備える

GB200システムは、Quantum-X800 InfiniBandまたはSpectrum-X800 Ethernetスイッチと接続して最高のAIパフォーマンスを実現

HGX B200は、NVIDIA Quantum-2 InfiniBandおよびSpectrum-X Ethernetネットワーキング・プラットフォームにより、最大速度400Gbpsをサポート

マイクロソフト、オラクル、CoreWeaveがQuantum InfiniBandとSpectrum-Xを採用

② 決算カンファレンスコールでの発表

以下は決算当日に行われたカンファレンスコールでのコレット・クレスCFOとジェンセン・ファンCEOの発言から、ネットワーク・ソリューションに関連する発言を抜粋したものです。ネットワーキング・ソリューションの製品開発を加速して、データセンター・ビジネスの拡大を目指していることが確認できます。

コレット・クレス CFOの発言

Q1に新たなSpectrum-X Ethernetネットワーキング・ソリューションの出荷を開始した。これにはSpectrum-4スイッチ、BlueField-3 DPU、新たなソフトウェア技術が含まる。これらは、従来のイーサネットと比較し、AI処理において1.6倍のネットワーク性能を実現する

Spectrum-Xは、10万GPUの巨大なクラスタを運用する顧客を含み、複数の顧客との取引量を増やしており、大規模AIデータセンターの新たな市場開拓が進んでいる

Spectrum-X には、1年以内に数十億ドル規模のプロダクトに成長することを期待している

Blackwellプラットフォームには、マルチGPUスパインを備えた第5世代NVLinkと1兆パラメータ規模のAIのために設計された新たなInfiniBandおよびイーサネット・スイッチX800シリーズが含まれる

ジェンセン・ファン CEOの発言

BlackwellからSpectrum-X、NIMsに至るまで次の成長に向けて態勢を整えている

非常に速いスパンで新たなネットワーキング・テクノロジーを発表予定

イーサネットのSpectrum-Xを発表。NVIDIAはイーサネットに全力を注いでエキサイティングなロードマップを準備する

Spectrum-Xは、イーサネットのみのデータセンターに大規模AIを導入する新市場を開拓するもの

NVIDIAには、豊富なパートナーエコシステムがある。DELLがSpectrum-Xの市場投入を発表した

ネットワーク技術であるイーサネットをSpectrum-Xでより優れたコンピューティング・ファブリックに仕立てていく

究極のパフォーマンスには、InfiniBandのコンピューティング・ファブリックを用意している

NVLink、InfiniBand、イーサネットの3つ全ての開発を加速させる

新たなCPU、新たなGPU、新たなネットワークNIC、新たなスイッチなど、山のように多くのチップが登場する。そして新たな機能、新たなソフトウェア・スタックが登場する。これらはすべて、CUDAで動作し、さらにNVIDIAのソフトウェア・スタック全体に統合されて動作する。

NVIDIAのアーキテクチャに投資すれば、高速化されたクラウドやデータセンターの拡充が自動的に進み、データセンターの能力向上とTCO削減が実現する

(3)AIファクトリーとAIクラウド

NVIDIAのネットワーキング・ビジネスを語るにあたっては、同社が掲げる高性能データセンターの重要な2つのコンセプトである「AIファクトリー」と「AIクラウド」について理解することが望ましいです。この「AIファクトリー」と「AIクラウド」は、近年のジェンセン・ファンCEOのキーノートで何度も説明されている各々の特徴によって区別されるデータセンターのコンセプトです。

AIワークロードのような計算集約的な処理が求められる近年のデータセンターは、大量のデータと大量の演算処理を行い、消費電力を抑えながら高い処理性能と信頼性を実現する必要があり、さらにスケーラビリティと経済性が求められます。

しかしながら、データセンターに求められる機能はAIモデルのライフサイクル・ステージによって異なり、それぞれのステージに応じたデータセンターのリファレンス・イメージとしてNVIDIAは、「AIファクトリー」と「AIクラウド」の2つのコンセプトを掲げています。

① AIファクトリー

AIファクトリーについては、その名前の通り、「AI工場」として捉えると分かりやすいですが、AIモデルを作るための重量級のAIタスクを実行するために特別に設計された高性能なデータセンターです。具体的には、AIモデルの開発やモデル学習、AIアプリケーションの開発、そしてAIモデルのデプロイメントなどを行う総合的なプラットフォームです。AIファクトリーは、AIモデルの開発や学習を短時間で可能とするよう、何百~何千もの高性能なGPUなどのハードウェアとソフトウェアによるコンピューティング環境とそれらの処理を遅延なく可能とある高性能ネットワークのエコシステムによって構成されます。

② AIクラウド

AIクラウドは、数千人規模のユーザーに対して、AIアプリケーション・サービスをマルチテナントモデルで提供するのクラウド・プラットフォームです。AIモデルの処理は、推論処理(Inference)が中心となり、データベースやアプリケーションモジュールと連携して様々なAIアプリケーション・サービスを提供します。結果として、高性能で効率的にワークロードを処理可能なことはもちろん、高いアクセサビリティを通じてオンデマンドでAIを利用でき、また、高度なセキュリティ機能とサービス需要に即したシステム弾力性を持つ必要があります。

このように、異なるワークロードを処理するAIファクトリーとAIクラウドの違いを踏まえて、NVIDIAは、各要件に沿ったネットワーク・ソリューションをある程度区別して提案することにしているようです。

AIファクトリーには、InfiniBandをベースとするコンピューティング・ファブリックである「Quantum InfiniBandシリーズ」の提案を推奨。そして、AIクラウドには、イーサネットをベースとするネットワーク・ファブリックである「Spectrum-Xシリーズ」の提案を推奨しています。

これらのQuantum InfiniBandシリーズとSpectrum-Xシリーズについては、この後のパートで紹介します。

3. ネットワーキング・ビジネスの源流

(1)Mellanoxの買収

さて、NVIDIAがネットワーキング・ソリューションの市場に本格的に参入したのは、データセンター・ビジネスの拡大戦略を進める中で行われた2019年の「Mellanox Technologies社」(以下、Mellanox)の買収からです。NVIDIAは、このイスラエルのネットワーキング・ソリューションを開発していたMellanoxを69億ドルで買収し、2020年にその買収オペレーションを完了しました。そして買収されたMellanoxのチームは、現在ではNVIDIAのネットワーキング部門のど真ん中でその役割を果たし続けています。

尚、興味深いのは当時、インテル、ザイリンクス(現AMD)、マイクロソフトがMellanoxの買収に名乗りをあげていたことです。最終的にはNVIDIAがこの買収を勝ち取りましたが、もしこれらのNVIDIAの競合企業がMellanoxを買収していたとしたら、現在の業界地図も少し違っていたかもしれません。

実際、NVIDIAは、Mellanoxの技術を活用して自社の製品ポートフォリオを強化することで、数千のGPUからなるコンピュートノードを高性能ネットワーキングで接続するスーパーコンピュータとしてのトータルシステムを短期で市場展開できるようになり、現在の生成AIおよびHPC市場で突出した垂直統合型のシステム提案力と競争力を持つに至っています。

(2)Mellanoxの概要と特徴

Mellanoxは、1999年にイスラエルで設立されたファブレス半導体メーカーです。InfiniBandおよびイーサネット標準に基づく高性能なインターコネクト・ソリューションとして、アダプタICやカード、スイッチIC、ゲートウェイIC、SoCマルチコア、NICプロセッサ、ケーブル、トランシーバー、ソフトウェアの設計・製造・販売を行っていました。

Mellanoxは、自社ブランドでの製品販売も行っていましたが、ビジネス規模としては、ネットワーク機器メーカーやサーバー機器メーカーにパーツやモジュールを納めるビジネスモデルが主力でした。買収前の2019年時点の売上は、13.3億ドルで、その内訳はInfiniBandが5.6億ドル、イーサネットが7.4億ドル。市場展開としても、欧米、中国、欧州とグローバル展開しており、中堅メーカーとしてその技術力と共にネットワーク業界でも高く評価されていた企業でした。

Mellanoxは、半導体ベースの高性能インターコネクト製品の設計開発に強みを持ち、InfiniBand技術およびイーサネット技術をベースとして、特にHPCやデータセンター向けのハイエンド・ネットワーク向けのスイッチやネットワークアダプタ、DPU(データ処理ユニット)やフルスタックのソフトウェアなどを通じて、大規模なデータセンター構築を可能とするソリューションを包括的に提供していました。特に混合信号回路や複雑な集積回路の開発能力に長け、最先端の光学コンポーネントやケーブル、マルチモード光信号を処理するトランシーバーチップセットの設計やアセンブリに関する専門知識を持ち、そしてそれらのコンポーネントを制御するソフトウェアの開発力も備えていました。

尚、Mellanoxは、ファブレスメーカーであったため、設計したICの製造は、TSMCやSTマイクロエレクトロニクスに製造委託し、また、インタフェースカードやスイッチは、Flextronics等に製造委託を行い、それら製品は、DELL/DELL EMC、IBM、HPE、Oracle、Fujitsuといった主要なサーバーやストレージメーカーに納められていました。

(3)Mellanoxの競合企業

この章の冒頭で述べた通り、現在のNVIDIAのネットワーキング・ビジネス・ユニットは、Mellanoxをコアに据えて発展して来たものです。

このMellanoxが当時、業界でどのような位置付けであったのか、Mellanox自身が競合企業であるとしていた企業名をプロダクトカテゴリに分けたものが以下のリストです。今後、これらの企業が、NVIDIAのネットワーキング・ビジネスの競合にあたるかどうか、少し眺めてみます。恐らく、これら全ての企業がNVIDIAのネットワーキング・ビジネスから何らかの影響を受けることになると思われます。

InfiniBandプロダクト: Intel、HPE(Cray)

イーサネットアダプタ: Intel、Broadcom、AMD、Cisco、Marvell等

プログラマブルSOC/NIC: Intel、Broadcom、Xilinx(現AMD)等

イーサネットスイッチシリコン: Broadcom、Intel、Innovium

イーサネットスイッチシステム: Cisco、Juniper、Arista Networks

(4)NVIDIAの優位性

NVIDIAはMellanoxを買収したことで、ネットワーキング・ソリューション領域でビジネスを行うための多くの資産を手に入れることに成功し、これにより、ネットワーク技術の基礎研究や応用研究からシリコンチップの設計、ソフトウェア開発、そして完成品の製造と販売までを一貫して行う垂直統合型ビジネスが可能となりました。

特に、NVIDIAの強みであるGPUをコアとしたHPCやAIアプリケーションをタイトかつ強力に支えるハイパフォーマンスなネットワーキング・ソリューションを自社で開発・提供できるようになったことは極めて重要で、多様な技術レイヤーで構成されるデータセンターやクラウドに対して、NVIDIAだけでエコシステム・プレイが可能となることから、新たな次世代データセンター市場においても、NVIDIAが優位なポジションを占めるであろうことは容易に想像することが可能です。

4. 異なる3つの通信技術

通信技術に係わるNVIDIAの研究開発や製品開発の取り組みは、大きく三つに分かれています。

まず1つ目は、NVIDIAが自社で独自に開発した「NVLink」と呼ばれるGPU間の高速インターコネクト技術です。2つ目は、業界標準のコンピューティング・ファブリック内の通信を担当する「InfiniBand」です。そして3つ目は、同じく業界標準のネットワーク技術である「イーサネット」です。

この投稿では、NVIDIAが古くから取り組んでいる「NVLink」とMellanoxが得意としていた「InfiniBand」についてはある程度簡潔に紹介し、その後、現在NVIDIAが製品開発を加速しているイーサネットをベースとしたソリューションであるSpectrum-Xついて、詳しく紹介します。

(1)NVLink

NVLinkはNVIDIAが独自に開発した技術で、GPUとGPU、もしくは、GPUとシステムコンポーネント間のデータ転送を高速化するインターコネクト技術です。この技術は2014年に発表され、2016年にTesla P100 GPUに初めて実装されて市場に出荷されました。NVLinkはPCIeよりもはるかに高い帯域幅と低遅延特性を持ち、単一システム内で複数のGPUを相互接続する技術です。

NVLinkは、Tesla V100やGeForce RTX、A100などにも実装されて進化を続けており、最新バージョンのNVLink 4.0では、帯域幅とエネルギー効率が大幅に改善され、業界における高速インターコネクト技術の最前線に位置する技術となっています。現在では、Hopperアーキテクチャと共に進化が進み、Grace CPU SuperchipやGrace Hopper Superchipとの統合計画も発表されるなど、生成AIやHPCのワークロードや大規模データセンターの要求に応えるテクノロジーとして、NVIDIAの差別化を支えるコアテクノロジーの1つとなっています。

(出典:NVIDIA)

NVLinkの主な特徴は以下の通りです。

(a)高速データ転送

高速データ転送を実現し、大規模な並列処理を必要とするHPCやAIアプリケーションにおけるGPUクラスタに不可欠な技術となっています。

(b)超低遅延

データリンクにおける遅延が極めて少なく、GPUとCPUをNVLinkで接続することでデータのリアルタイム共有が可能となり、計算集約的なタスクの処理パフォーマンスが大幅に向上します。

(c)NVSwitchとの統合

NVLinkを実装するNVSwitchによって、サーバーおよびサーバーラック間でのフルスピードでのGPU間通信が可能となり、大規模なGPUクラスタを容易に実現します。

NVLinkはデバイスレベルのインターコネクト技術として位置付けられており、一般的にはネットワーク技術の文脈で語られることは少ないです。このため、ここではNVLinkについての紹介は簡単なものに留めます。

ちなみに、NVLinkは、NVIDIAが極めて高い優位性を持つ技術ですが、これに対抗する技術も存在しています。AMDが開発し、同社のRyzenやInstinctなどのCPUやGPUで商用利用されている「Infinity Fabric」という技術がその代表的な存在です。

また、先日5月末に発表されたAMD、Intel、Broadcom、シスコ、グーグル、HPE、メタ、マイクロソフトが参加するインターコネクト技術の標準化のためのコンソーシアム「UALink Consortium」は、NVIDIAのNVLinkに対抗するオープンスタンダード技術として「UALink」を共同開発する企業連合ですが、この「UALink」の基盤技術として利用されるのがAMDの「Infinity Fabric」になります。

(2)InfiniBand

InfiniBandは、1999年に、インテル、マイクロソフト、HP、IBM、DELLなどが参加して設立した「InfiniBand Trade Association(IBTA)」を中心にHPCやデータセンターネットワーキングのニーズに応える技術として開発・策定されました。技術仕様の初版が2000年で2001年には製品が市場リリースされています。

InfiniBandが最も特徴的なのは、その設計上、通信処理をCPUから分離し、エンドツーエンドのデータ接続をシリコンハードウェア(IC)で実現している点にあり、これによって他の通信技術に比べ、低遅延で広帯域な通信を実現することが可能となっています。

現在のInfiniBandは、ポートあたり最大800Gbps(XDR)の帯域通信が可能で、数十万ノードまでスケーリング可能な高いスケーラビリティを備えています。このため、高負荷な科学技術計算を行うHPCクラスタやデータセンターで利用されるネットワークのパフォーマンスを大幅に向上させることができます。

また、InfiniBandはCPUを介さずにメモリ間で直接データ転送が可能なRDMA(Remote Direct Memory Access)や自動パスマイグレーション、通信トラフィックの優先付けの可能なQoS(サービス品質保証)など、エンドツーエンド通信の信頼性を高める高度な機能を備え、これらによって一貫したワイヤスピードレベルのパフォーマンスを提供します(100ns以下の遅延)。

さらに、InfiniBandはiSER、SRP、IPoIBなどの上位プロトコルをサポートして多様なアプリケーションに対応できる特徴を持ち、特にHPCや高性能データセンターを支えるコア技術として採用が進んでいます。

一方、InfiniBandの課題にあげられるのが、コスト、複雑さ、限定されたエコシステム、ベンダーロックインなどです。一般に、InfiniBandのハードウェアとソフトウェアは高価であり、導入や運用、メンテナンスにかかるコストも大きくなります。そのため、TCO(総所有コスト)の観点から見ると、イーサネットのような汎用性を持ったネットワーク技術に比べてコスト負担が大きくなる傾向にあります。

また、システムの構築と管理には高度な専門知識が必要で、特に大規模なシステムの場合、専門的な人材による管理・運用が不可欠です。さらに、限定されたエコシステムの問題は、InfiniBandのハードウェアやソフトウェアの製品やメーカーが限られており、システム選定における選択肢が限定的となり、その結果、特定のメーカーに依存せざるを得ない、いわゆるベンダーロックインのリスクが生じる可能性があります。

[凡例]

・HCA(Host Channel Adapter)

サーバーに装備するホストアダプタカード

・TCA(Target Channel Adapter)

ストレージ側に装備するアダプタカード

・Switch

Subnet Managerを内蔵するスイッチ

・Subnet Manager

ファブリック内部でネットワークを管理(アクティブ/スタンバイ)

・SMA(Subnet Manager Agent)

Subnet Manager と通信するエージェント

・Router

複数のサブネットを接続ためのルーター

① NVIDIA Quantum InfiniBandソリューション

では、NVIDIAのInfiniBandソリューションについて簡単に紹介します。

AIファクトリーというコンセプトのリファレンス・イメージは、NVLink高速GPUインターコネクトとQuantum InfiniBandによって最適化されたネットワークに支えられる1兆パラメータを持つ基盤モデルのトレーニングが可能な最高レベルのパフォーマンスを発揮する少数テナントで構成されたデータセンター環境というものです。端的に言えば、AIファクトリーのネットワークには、InfiniBandが想定されているということです。

NVIDIAのInfiniBandソリューションである「Quantum InfiniBandシリーズ」は、スイッチ、ネットワークアダプタ、ケーブル、DPU(データ処理ユニット)、ゲートウェイ、ソフトウェアで構成される包括的かつエンドツーエンドのInfiniBandソリューションで、元々Mellanoxが開発・販売していたテクノロジーやプロダクトをベースに発展・拡張させてきた製品群になります。これらは、HPC環境に最適化設計されたInfiniBandの持つ元々の特徴を備え、数百~数千のコンピュートノードを相互接続し、データセンタースケールのスーパーコンピューティングを支えるコンピューティング・ファブリックを構築します。

従来のイーサネットとは異なるInfiniBandの特徴の例としては、パフォーマンス強化のためのSHARP(Scalable Hierarchical Aggregation and Reduction Protocol)と呼ばれるデータ削減および帯域幅を倍増させる技術。また、並列演算処理技術を利用してコンピュート・エンジンとのネットワーク統合を行い、複雑な演算をオフロードしながら演算処理を集約する技術。さらには輻輳制御やQoS、アダプティブルーティングによって輻輳を抑え、データの到着順序を損なうことなく、ネットワークの状態に応じて最適なトラフィック分散を行うなど、高度な通信処理を実現することができます。

5. Spectrum-X Ethernetソリューション

前置きが長くなりましたが、この投稿を書くモチベーションのきっかけとなったNVIDIAのイーサネット・ソリューションである「Spectrum-X Ethernet」を紹介します。このSpectrum-X Ethernetは、前述の通り、NVIDIAのデータセンター・コンセプトである「AIクラウド」に最適なネットワーク・ファブリックとして推奨されているソリューションです。

まず、イーサネットというネットワーク技術についての簡単な紹介と主主なInfiniBandとの違いについて紹介させて頂きます。

(1)イーサネットの基礎と課題

イーサネット(Ethernet)は、1970年代に開発され、1980年から市場に普及し始めた通信技術であり、現在では最も普及しているネットワーク技術の1つといえます。この技術は、IEEE(米国電気電子学会)のIEEE 802委員会のワーキンググループが中心となって標準化が進められており、時代のニーズに即して、新たなテクノロジーを生み出しながら現在も進化を続けています。直近でも、通信速度を高速化した800Gbpsの技術(802.3df)が標準化されています。

これまでイーサネットは、業界標準のネットワークインフラとして、様々なシナリオに広範かつ包括的に対応できる多様な機能セットを組み込んで成長してきたネットワークプロトコルです。その広範な互換性と汎用性を持つ特性により、企業内ネットワーク、キャンパス・ネットワーク、データセンターなどで幅広く利用されています。

しかし、NVIDIAが掲げるAIクラウドの要求仕様に最適化されているかというと、必ずしもそうではありません。そのため、解決しなければならない課題が存在します。

① イーサネットに対する新たな要求事項

従来からのデータセンターは、多用途かつ小規模なワークロードに対応することを目的として、サーバーやストレージ、ネットワーキングといった計算リソースが物理的に集中して構成されています。しかし、近年では従来のデータセンターとは異なる、大規模で分散されたAIワークロードを高い処理能力で支える環境が求められるようになっています。そして、それに伴い、分散配置されるAIモデルの推論処理を支えるネットワークに対する技術的要件にも大きな変化が訪れています。

例えば、分散コンピューティング環境では、複数のサーバーやノードが高速かつ低遅延で互いに負荷分散しながらワークロードを協調的に処理することが求められ、特にマルチテナント化され、生成AIアプリケーションの推論処理のような極めて計算集約的なタスクが分散して処理される環境では、データ量やモデルサイズの増大に伴って、ユーザーに対するサービス品質の維持が困難となります。そのため、負荷分散によってボトルネックの発生を抑える分散コンピューティングと協調的に動作するネットワーク技術が不可欠になります。

従来のイーサネットは、汎用性と相互接続性が重要視される環境に最適なネットワーク技術であり、疎結合型のアプリケーションが求める品質に対し、必要十分なネットワークサービスを提供できるようには設計されています。しかし、複数ホスト間でGPUの並列処理を行うような計算負荷の高いAIワークロードの分散環境における厳しいネットワーク要件を満たすような技術ではありません。

また、複数の異なるAIタスクが同時並行で処理されるマルチテナント型のAIクラウドでは、各々の処理が他の処理に影響を及ぼさないようにする仕組みであったり、ネットワークのリンク障害によるパフォーマンス劣化がシステム全体に及ばないように抑制する仕組みが必要となります。そしてこれらの課題については、従来から量産されているコモディティASICでは達成は難しく、AIタスクの分散処理における課題を解決するための新たなテクノロジーの開発が求められていました。

② InfiniBandとの特徴比較

従来のイーサネットとInfiniBandを比較してみます。

InfiniBandは、前述の通り、NVIDIAのコンセプトであるAIファクトリーに適した高速で極めて遅延が少ない通信技術であり、大量の科学計算やAIワークロード、特にAIモデルの開発や学習に最適な技術です。一方、イーサネットは、広範な互換性と汎用性を持ち、企業内ネットワークやデータセンターなど、幅広いユースケースを対象として業界標準のネットワークとして広く一般に利用されています。

ここで、高性能が求められるデータセンターへの実装を想定して、InfiniBandとイーサネットの特徴を比較してみます。

(a) ネットワークアーキテクチャ

InfiniBandは、低遅延・高帯域幅通信に最適設計されています。一方、イーサネットは、汎用性と互換性を重視し、低遅延と高帯域幅通信に最適化されていません。

(b) プロトコル

InfiniBandは、CPUを介さずにメモリ間でデータを直接転送できますが、イーサネットはCPUが通信処理に介在し、ボトルネックになることがあります。

(c) 通信遅延

InfiniBandの遅延は、100ns(100ナノ秒)以下ですが、イーサネットは、μs(マイクロ秒)レベルの遅延が発生します。

(d) 信頼性

InfiniBandは、高度なエンドツーエンドのサービス品質を担保する機能を持ち、イーサネットに比べて高い信頼性を提供します。

(e) スケーラビリティ

InfiniBandは、低遅延を維持しながら数百万ノードまで拡張可能です。イーサネットは、規模拡大するとパフォーマンスに影響が出やすい。

・・・と、上記の通り、比較結果は、イーサネットに対して厳しい内容になりました。

総じて言えば、InfiniBandは、そのアーキテクチャに内包する機能により、HPCやAIワークロードのような低遅延・高帯域幅が求められる特殊なユースケースで優れた性能を発揮するテクノロジーとなっています。

一方でイーサネットの良さは、その成熟した技術による安定性と信頼性にあります。イーサネットは、現代のネットワーキング技術の中核を成す重要な通信技術であり、互換性を持った豊富なデバイスやソフトウェアのエコシステムによって、高い経済性(コストが安い)を提供し、より幅広いアプリケーションに適応します。さらに、導入や管理が容易なネットワーキング技術であり、小規模から大規模の企業ネットワークやデータセンターにおいて幅広く利用することが可能である等、多くの利点を持っています。

というのがこれまでの話ですが、、、 イーサネットも時代のニーズと共に進化しています。

そして、これまでに例を挙げたイーサネットの課題に対するNVIDIAの回答となるソリューションが「Spectrum-X」となります。

NVIDIAは、この「Spectrum-X」をAIクラウドを支えるネットワークとして位置づけています。つまり、マルチテナントのAIアプリケーションの推論処理を支え、数千人規模のユーザーにAIアプリケーション・サービスを適切に届けることができる高速・低遅延のネットワーク・ファブリックとしてこの「Spectrum-X」をアピールし始めてるのです。

以下に引き続き、NVIDIAの最新のネットワーク・ファブリックである「Spectrum-X」について紹介していきます。

(2)Spectrum-X ソリューション概要

Spectrum-Xソリューションは、AIクラウドのパフォーマンスと効率を向上させるために開発された最新の標準技術に基づくイーサネット・プラットフォームです。従来のイーサネットに比べて、大規模言語モデルやAI推論のような大規模なAIワークロードを優れたパフォーマンスで処理することができ、また、高い電力効率を持って、マルチテナント環境においても一貫して予測可能なパフォーマンスを提供できるネットワーク・ソリューションとなっています。

Spectrum-Xは、スイッチからSuperNIC、GPUまでのエンドツーエンドのシームレス接続を実現する唯一のイーサネットネットワーキング・プラットフォームとしており、その概要とハードウェアとソフトウェアの構成は以下の通りです。

① Spectrum-X Ethernetソリューション

今回のFY25Q1決算で、出荷開始と発表されたSpectrum-X Ethernetソリューションは、約2年前の2022年3月のGTCで初めて、「NVIDIAは、HPCの能力を初めてイーサネット市場にもたらそうとしている」として紹介されたソリューションで、現在では、「Spectrum-Xは、マルチテナント型のAIクラウドに必要な高帯域幅とパフォーマンス分離を実現できる唯一のイーサネット・プラットフォーム」であるとNVIDIAから紹介されています。

Spectrum-X Ethernetソリューションは、NVIDIAが開発した先進的なイーサネット・スイッチチップ「NVIDIA Spectrum-4」と強力なネットワークアクセラレータである「BlueField-3 DPU」を搭載した「SuperNIC」が密接に連携することにより、イーサネットのパフォーマンスを1.6倍まで高速化でき、マルチテナントクラウドにおいて予測可能な一貫したパフォーマンスときめ細かなセキュリティ機能を提供できるとしています。

以下はSpectrum-X Ethernetソリューションのエコシステムを構成する要素です。

(a)Spectrum-X Ethernetスイッチ

Spectrum-X Ethernetスイッチは、51.2Tbpsの容量を持つASIC「Spectrum-4」を実装し、2Uスイッチ内で最大64ポートの800GbEまたは128ポートの400GbEをサポートします。AIワークロード専用に設計された初のスイッチで、高性能・低遅延のアーキテクチャと標準のイーサネットを統合することで、性能要求の高いAIアプリケーションに高い効率性と信頼性を提供します。

(b)BlueField-3 SuperNICs(サーバーやストレージのホストに搭載)

BlueField-3 SuperNICは、SDN(ソフトウェア定義のネットワーク)を構成するためのNIC(Network Interface Card)で、クラウドからデータセンターコア、エッジのホストに実装されます。BlueField-3 SuperNICは、最大400GbpsのGPU間の通信となるRoCEネットワーク接続を実現し、AIワークロードの効率処理や輻輳制御などによって、フルパフォーマンスの通信性能を提供します。

<その他、Spectrum-X Ethernetソリューションのエコシステムの構成要素>

(c)ネットワークOS「Cumulus Linux」

(d)Linuxベースのオープンソース ネットワークOS「Pure SONiC」

(e)ネットワーク運用管理ツール「NetQ」

(f)データセンターのデジタルツイン化ソフトウェア「NVIDIA Air」

(g)OEM先等で利用するソフトウェア開発キット「Spectrum SDK」

(h)自動化やセキュリティ向けタスクなどのプログラマブル環境「DOCA」

尚、Spectrum-X Ethernetソリューションの実装については、一般的には、図7に示す標準的なトポロジーで構成されます。つまり、バックボーンとなるスパインスイッチとEoR(End of Row)スイッチ、そしてBlueField-3 DPUアダプタカードが実装されたサーバーおよびストレージファームの3つの層が多段で接続する大規模データセンターに適したスパイン-リーフアーキテクチャの一種で構成されます。

(出典:NVIDIA)

(3)Spectrum-Xのアドバンテージ

Spectrum-Xは、従来のイーサネットの課題を解決し、従来のイーサネットでは実現が難しかったAIクラウドの要件を満たして、以下の利点をもたらすとしています。

AIクラウドでのパフォーマンスの向上

マルチテナント環境での高いパフォーマンス

スケーラブルなAIクラウドを実現

標準技術であるイーサネットの採用による高い相互互換性

パフォーマンスの可視化を実現

高い電力利用効率

ネットワーク構成の自動化が可能

それでは、NVIDIAがこれまでイーサネットの課題をどう技術的に解決してきたのかについて以下に触れてみたいと思います。

① RoCE(RDMA over Converged Ethernet)

AIのパフォーマンスを最大限に引き出すための1つの方法として、推論処理を行う複数のGPUが余計なものを介さずに効率的に連携する必要があります。InfiniBandには、RDMA(Remote Direct Memory Access)という、コンピュータのメモリに直接アクセスし、高速で低遅延のデータ転送を実現する技術が標準で装備されています。このRDMAは、GPUサーバーやストレージなどの各システムのCPUを利用することなく、各システムのメモリ間で直接データ転送を行う技術で、従来存在していた中間プロセス(データのコピーの繰り返しやノード間の送受信や転送など)をバイパスすることで、より効率的な高速・低遅延のデータ転送を実現します。

従来のイーサネットにはこのRDMAに相当する機能はありませんでしたが、新たにイーサネットの標準技術として、イーサネット上でRDMAの機能を実現する技術であるRoCE(RDMA over Converged Ethernet)が開発されました。これによってイーサネット上でも、GPUメモリに直接アクセスでき、CPUをバイパスし、データ複製を繰り返すことなくシステム間のデータ転送を効率的に実現できるようになりました。

NVIDIAのSpectrum-Xは、このRoCEを実装することで、効率的なデータ転送を実現しています。

(出典:NVIDIA)

② RoCE Adaptive Routing

Spectrum-Xスイッチに実装されたRoCE(RDMA over Converged Ethernet)には、アダプティブルーティングという機能があります。これは、スイッチが最も混雑していないポートを自動的に選択してデータ伝送を行う仕組みを提供し、これによりネットワーク全体の負荷を分散して、安定した高い帯域幅を確保することを可能にします。

従来のデータセンターのアプリケーションは、小規模なデータフローを大量に発生させる傾向があり、そのためトラフィックの平均化が比較的容易でした。そのため、ルーティングはスイッチ上のシンプルなアルゴリズム(例:ECMP)で行うことで、問題を回避できていました。

しかしながら、AIワークロードでは、少数の大規模な「エレファントフロー」と呼ばれるデータフローが発生し、通信リンク上の帯域幅を一気に大量に消費してしまいます。この際、複数のエレファントフローが同時発生すると、大きな輻輳が発生し、システム全体で大きな遅延が生じ、最悪の場合、モデルの推論処理が予測不能なほど長時間になってしまうケースが発生します。

RoCEをサポートしたイーサネットは、RoCEのアダプティブルーティング機能を利用することで、非常に粒度の細かいルーティングによってエレファントフローを動的に負荷分散して輻輳を避けることが可能となりました。尚、パケット単位でのルーティングを行うパケットスプレー技術では、パケットが到着先で順不同に届く可能性がありますが、Spectrum-Xスイッチの負荷分散機能とSpectrum-X SuperNICによるDDP(Direct Data Placement)を組み合わせることで、再順序化メカニズムを実現し、エンドツーエンドでのアダプティブルーティングを実現することが可能となっています。

アダプティブルーティングの仕組み(出典:NVIDIA)

③ 輻輳制御

マルチテナントのAIクラウド環境では、異なるAIジョブが同時に実行され、ネットワークが輻輳し、データ遅延の増加と有効な帯域幅が減少する他、バックプレッシャーのネットワーク伝播によって隣接して異なるテナントにも悪影響を及ぼす可能性があります。Spectrum-Xでは、Spectrum-Xスイッチのテレメトリーデータを利用し、NIC/SuperNICと協調してフローメータリングを行う仕組みを持っていることから、ネットワーク全体で輻輳制御が可能な仕組みを実現しています。

輻輳を回避する仕組み(出典:NVIDIA)

④ RoCE パフォーマンス・アイソレーション

マルチテナント環境のAIクラウドでは、同じ環境内で実行される他のジョブから自身のジョブを保護する必要があります。一般的なイーサネットのASICチップには、ASICレベルでのジョブ保護機能が組み込まれておらず、同じ宛先ポートにネットワークトラフィックを送信する他のシステムの隣接ジョブ、つまり「Noisy Neighbor(騒がしい隣人)」によって特定のジョブが被害を受け、必要な通信帯域幅を確保できなくなることがあります。また、イーサネットで構成されたAIクラウドの同じ環境で異種混合のアプリケーションをサポートする場合、大きなデータフレームサイズのアプリケーションが同じ宛先ポートにデータを送信すると、帯域幅の不均衡が発生し、より重要なアプリケーションに必要な帯域が割り当てられず、処理が遅れる可能性が生じます。

これらの課題に対し、RoCEの機能として、共有パケットバッファを利用したパフォーマンスアイソレーションの仕組みを組み入れて、ネットワークの公平性を保つメカニズムを持たせています。これは、スイッチのすべてのポートにユニバーサルに共有可能なキャッシュバッファを設けることで、Noisy Neighborやネットワークの不公平性を防ぎ、様々なAIアプリケーションの異なるワークロードに必要なパフォーマンスの制御を行うことができます。

予測可能な帯域幅の分配が可能な仕組みを提供。上がSpectrum-Xの場合で

下が一般的な量産AISICの場合。(出典:NVIDIA)

⑤ ロスレス・ネットワーキング(Lossless Networking)

InfiniBandでは、ロスレス・ネットワークが基本要件となっていますが、イーサネットは、本質的にロスの発生を見込んだ設計になっています。イーサネットのようなロスの発生するネットワークでは、データの損失や劣化を前提にデータが送信されますが、ロスの発生によってデータの再送や輻輳が発生し、その場合、パフォーマンスやGPUのアイドル時間、消費電力に悪影響を及ぼす可能性があります。

一方、ロスレス・ネットワークでは、全てのデータパケットが正確に目的地に到達することが保証して、データの損失や劣化なしに相手方のノードにデータを送信することができます。これにより、広帯域・低遅延の大規模なユースケースには、一般にロスレスであるInfiniBandが標準的に選択されてきました。

しかしながら、イーサネットでもロスレス・ネットワークが実現できるようなりました。これは、RoCEとPFC(Priority Flow Control)を組み合わせて実現するもので、この組み合わせによってイーサネット上でもデータの損失や劣化を発生せず、パフォーマンスを効率的に維持するネットワークを実現できるようになり、NVIDIAのSpectrum-Xでも、このRoCEとPFCを実装することでイーサネット上でのロスレス・ネットワークを実現しています。

⑥ カットスルー・スイッチング

一般に、イーサネット・スイッチの送受信方式には、ストア・アンド・フォワードとカットスルーの2つのモードがあります。ストア・アンド・フォワードは、データフレーム全体を受信してからデータを送信する動作に入りますが、カットスルーはデータフレームの全てを受信する前に到着したデータを送信します。そのため、カットスルーの方が通信パフォーマンスが高く、AIクラウドのAIワークロードではカットスルーモードの利用が推奨されます。

但し、カットスルーでは、ホスト、リーフスイッチ、スパインスイッチの通信経路をエンドツーエンドで同じリンクスピードで構成する必要があるという課題がありますが、Spectrum-Xでは、リンクスピードに関わらず、カットスルー・ネットワークを実現することが可能です。

⑦ ジッターの抑制

ジッターとは、データパケットが受信側に到達するまでの遅延が時間的に変動する現象を指し、具体的には、パケットの到着時間が予測不可能に揺れ動くことで、一定のタイミングでデータを受信することが困難になります。

Spectrum-Xは、リアルタイムのネットワークモニタリングと管理機能を提供し、高精度なタイミング制御技術を利用してデータパケットの送信と受信のタイミングを管理し、パケットの到達時間のばらつきを抑えることが可能です。また、一部のネットワーク処理をハードウェアレベルでアクセラレーションすることで、一貫したデータ処理を実現し、その結果、ジッターの発生を抑えることができます。

(出典:NVIDIA)

(4)Spectrum-XとInfiniBandを比較

この章ではこれまで、NVIDIAがSpectrum-X Ehternetソリューションで、従来のイーサネットの課題をどのようなテクノロジーで解決してきたかを紹介しきました。

では、RoCEをサポートするSpectrum-XがInfiniBandと同等のネットワークとして機能するか、という点についてですが、いまだに幾つかの点でInfiniBandが優位性を持っていると言えます

現時点の結論としては、やはりNVIDIAがAIファクトリーとAIクラウドでそのネットワークの推奨を分けている通り、要求の厳しい低遅延、広帯域のクラスタリング・アプリケーション、AIのモデル学習のような特に大規模なユースケースには、InfiniBandが優位となり、一方、パフォーマンス要求が最優先でないAIアプリケーションには、相互接続性が高く、コスト効率の高いオプションとして、RoCEベースのイーサネット、つまりSpectrum-Xが有効な選択肢であると言えます。

(a)遅延

InfiniBandは、RoCE over Ethernetに比べて遅延が大幅に低く、InfiniBandの遅延が100ns以下ですが、イーサネットの場合は、500~700nmで推移します。マルチホップ環境では、InfiniBandの遅延に対する優位性はさらに高くなります。

(b)帯域幅

最新のInfiniBand XDR規格は、ポートあたり最大800Gbpsをサポートし、イーサネットも802.3df規格でポートあたり最大800Gbpsをサポートします。InfiniBandは、ワイヤスピードを実現しますが、イーサネットは規模が大きくなるとオーバーヘッドやCPU使用率が高くなる特性を持っています。

(c)輻輳制御

InfiniBandは、ハードウェアベースの輻輳制御メカニズムを使用して輻輳を押さえており、極めてロスレスな環境を実現します。RoCEをベースとするイーサネットは、エンドツーエンドの輻輳通知メカニズムに依存していることから、規模が大きくなって複雑さが増すとパフォーマンスに影響を及ぼす可能性があります。

(d)スケーラビリティ

InfiniBandは、専用のスイッチド・ファブリックによって超低遅延を維持しながら数万ノードまで拡張できますが、RoCEベースのイーサネットの大規模実装は複雑になるため、遅延のパフォーマンスが劣化する傾向があります。

(e)ハードウェア・アクセラレーション

InfiniBandのスイッチとアダプタには、HPCのような高負荷ワークロードに最適化されたSHARP、Adaptive Routingなどの特殊なハードウェア・アクセラレーション機能がありますが、RoCEベースのイーサネットは、ソフトウェア処理に依存するため、処理にオーバーヘッドが生じます。

(f)技術的な成熟度

元来、HPC環境のために開発されたInfiniBandは、マルチテナンシー、ネットワーク仮想化、高度なモニタリング、診断などの豊富な機能を備えており、広帯域・超低遅延環境に対する技術がより成熟しています。

6. 競合他社への影響について

NVIDIAがこのままネットワーク・ソリューションを強化・拡充して行けば、世の中の既存のネットワーク・ソリューション・ベンダーに確実に影響を与えることになります。特にハイパフォーマンスなデータセンターを支えるコアネットワーク領域でビジネスを行っている企業への影響は必至かと思われます。

もちろん現時点では何ら決着はついておらず、勝敗を決める様々な要素にはムービングパーツが無限にあるため、勝負はこれからとも言えますが、

少なくともNVIDIAが定義する「AIファクトリー」や「AIクラウド」のユースケースにおいては、GPUを中心とするエコシステム・プレイが単独で出来るNVIDIAが現在においても優位なポジションに躍り出ていそうな雰囲気を感じています。

(1)Arista Networks(ANET)

NVIDIAのFY2025Q1の決算報告でのSpectrum-Xの出荷報告がなされた後、ANETの株価が大きく下げました。また、この投稿を掲載するタイミングでも(NVIDIAの影響かどうかは定かではありませんが)ANETの株価の戻てはおらず、下げ基調となっています。

ANETのイーサネット製品に実装されているスイッチチップは、Broadcom製です。実はANETは、Broadcomと共に、NVIDIAに先んじて、RoCE(RDMA over Converged Ethernet)の一連の機能を自社の製品に実装し、広く市場展開を行っており、実際、データセンター向けイーサネット・スイッチのそれら強みを訴求して、近年のデータセンター向け市場で業績を上げて来た経緯があります。

今回NVIDIAがSpectrum-Xの出荷を開始したとのことで、恐らくこれはもう、ANETのビジネスに影響がおよぶのは、大なり小なり避けられないと思われます。只、既にデータセンター向けの高性能イーサネット・スイッチを市場展開していたANETは、現時点においては、NVIDIAのSpectrum-Xに匹敵するか、逆に成熟度や安定度では、NVIDIA以上のソリューションを持っている可能性はあり、まだ十分にNVIDIAと戦える位置にいるのかもしれません。

しかしながら近年、特に高い性能が求められるデータセンターでは、ネットワークシステムだけが単独で動作するのではなく、様々なハードウェアとソフトウェアが互いに連携しながら不可分な関係の中で包括的にシステム運用されるようになっています。しかも、AIモデルの推論処理を行うデータセンターは、やはり、NVIDIAの圧倒的な優位性を持つGPUサーバーを支えるためのインフラという位置づけであり、主役はGPUです。したがって今後も引き続いてNVIDIAがGPUやNVLinkを中心とする垂直統合型のエコシステム・プレイを拡大するのであれば、ANETの様なネットワーク・プロダクト1本で勝負する企業としてはなかなかに難しい側面を迎えることになるのではないかと思われます。

もちろん今後将来、ANETが巻き返すことになるのか、それとも市場全体のパイが大きくなってANETもNVIDIAもエンジョイできるようになるのかは、末端に居る筆者には分かりませんが、いずれにせよ、今後の両社およぎ業界の動きを見守って行きたいと思います。

(2)Broadcom(AVGO)

ANETと同じ理由で、Broadcomは、NVIDIAのSpectrum-Xの影響を確実に受けます。但し、ビジネスインパクトとしては、主にハイエンドのイーサネット・スイッチに実装されるネットワークチップ(Tomahawk、Jericho、Trident)やそのアセンブリ製品、そして、ホスト用のNIC製品に限定される可能性が高く、その他の広範なシリコン・プロダクトを展開するBroadcomの全体のビジネスにとっては、その影響は限定的になるであろうと推測されます。

ネットワーク関連チップに限定してみても、AVGOは、超ハイエンドなイーサスイッチのみならず、ローエンドからミドルエンドのスイッチやホストアダプタ用のシリコン・プロダクト、そしてVmwareのエンタープライズ・ソフトウェアも展開していますので、やはり、ハイエンドをターゲットとしたNVIDIAのSpectrum-4から受けるBroadcom全社への影響は限定的であろうと推測されます。但し、先の将来のことは分からず、AVGOにも頑張って欲しいと祈っています。

(3)その他の主要ベンダー

その他、Cisco System(CSCO)やJuniper Networks(JNPR)などのレガシーベンダーが展開するデータセンター向け製品にも影響は及びます。

DELLやHPEも自社でネットワーク製品を開発・販売していますが、Lenovo(LNVGY)やSuper Micro(SMCI)と共にNVIDIAのSpectrum-Xについての販売パートナーシップを既に表明し、顧客からのSpectrum-Xの注文を受け付けていますので、NVIDIAのレールにしっかりと乗って、競争力あるハイエンドデータセンター向けのネットワーク・ソリューションの販売オプションをしっかりと確保した、ということかと思います。

以上です。

何かご意見、ご質問等ありましたら、何なりとお知らせください。

対応させて頂きます。

御礼

最後までお読み頂きまして誠に有難うございます。

役に立ちましたら、スキ、フォロー頂けると大変喜び、モチベーションにもつながりますので、是非よろしくお願いいたします。

だうじょん

免責事項

本執筆内容は、執筆者個人の備忘録を情報提供のみを目的として公開するものであり、いかなる金融商品や個別株への投資勧誘や投資手法を推奨するものではありません。また、本執筆によって提供される情報は、個々の読者の方々にとって適切であるとは限らず、またその真実性、完全性、正確性、いかなる特定の目的への適時性について保証されるものではありません。 投資を行う際は、株式への投資は大きなリスクを伴うものであることをご認識の上、読者の皆様ご自身の判断と責任で投資なされるようお願い申し上げます。