自分自身をメタ認知するOpenAI o1登場

OpenAIが9/12に最新のAIモデルを発表しました。

https://openai.com/index/introducing-openai-o1-preview/

既に有料会員は使えるようになっており、私も少し(週に30プロンプトという制約・・・)試してみました。

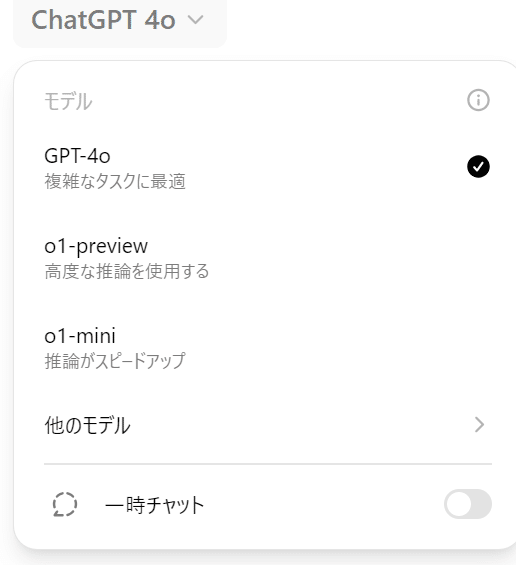

名称が前例に倣ってないのが気になりましたが、公式サイトによると従来と異なるためこのモデルを「OpenAI o1」と名付けることにしたそうです。

触ってみるとすぐに気づいたのは、回答までに「考えています」といった推論時間を要する点です。これはUI(心理学?)上の工夫というよりは、実際に推論プロセスを大きくかえたようです。プロンプトが限られているので、下記の公開技術情報をもとに少し深堀してみたいと思います。

https://openai.com/index/learning-to-reason-with-llms/

まずは、ベンチマーク結果から。

一目でわかるように、数学や自然科学の分野ではGPT4oと比較しても圧倒的な違いが分かります。

今回の特長は「強化学習」で、特に思考のプロセスをどのように学習させていくのかに気を配っているようです。

こちらの公式文書にわかりやすい図があったので引用します。

まず、従来モデルの考え方ですが、トークンというマシン用に分解された言語要素の生成確率を計算することで文章を紡いでいきます。

それに対して今回は「推論トークン」という新しい概念を導入しています。LLMの入出力「結果」だけでなく、推論(Reasoning)「過程」も学習させて補正しているようです。

これで連想したのは「メタ認知」という言葉です。

ようは、自身の認知を客観視する認知です。まさに今回の新モデルはLLMが自身の認知過程をも客観的に評価して強化しているメタ認知(というかメタ強化学習?)的な行為を行っているようです。

それによる効果として「安全性」の向上も期待できます。(実際公式サイトでもふれています)

丁度最近、競合GoogleがファクトチェックするLLMを発表しました。

それを事業化するサービスもはやりつつあります。過去投稿を。

人間の高度な推論と誤解訂正能力、少なくともさらに洗練されたAIモデルであることは違いないでしょう。

今回の完全リニューアルモデルOpenAI o1が、果たしてAGIにどの程度近づくことになるのか?そもそもAGIという曖昧模糊としたものを思考に組み入れてよいのか?

今回のモデルに倣って私(人間)もメタ認知してみようと思います。