Humata(自分のファイルのためのChatGPT)で英語の論文を読むのがめちゃくちゃ楽に!

Humataは、ユーザーが用意した文書ファイルを基にして、ChatGPTのように質問に答えたり、内容を要約したりできるチャット型オンラインAIサービスです。

今回、英語の論文を読むのに、Humataがとても便利だと分かったので、そのHumataの概要や使い方を紹介します。

1.Humataとは?

Humataは、ユーザーが自分で用意した文書ファイルを基にして、質問に答えたり、内容を要約したりできるオンラインAIサービスで、ChatGPTのようにチャット形式でタスクを指示したり、質問したりできるようになっています。

公式サイトのタイトルに、「ChatGPT for your files.」(自分のファイルのためのChatGPT)とありますが、その方がイメージしやすいでしょう。

使用できる機能としては、以下のようなものがあります。

文書ファイル内の長い文章を要約する。

文書ファイルの内容に関連する質問に回答する。

文書ファイルに基づいて、新しい文章を自動的に生成する。

また、現在、使用できるのはPDFファイルのみとなっています。

2.Humataの使い方

最初に、以下のサイトにアクセスし、メールアドレス入力とパスワード設定をしてサインアップします。

すると、「Welcom to Humata!」以外にほとんど何も書かれていない画面が現れますので、ここに文書ファイルをドラッグ&ドロップするか、画面をクリックして、文書ファイルをアップロードします。

すると、右側に文書ファイルが表示され、左下の空欄に質問などを入力して、「Ask」ボタンを押すと、左側の画面に入力した文章が表示され、その下にHumataの回答が表示されます。回答の下には、参考にした頁番号が記載され、文書ファイル表示の該当部分に黄色マーカーが引かれます。

なお、日本語の文書の場合は、短い文書だと問題なく使用できましたが、長い文書の場合は、質問の際にエラーが発生し、使えないことがありました。基本的に、英語の文書を対象としているようです。文書サイズは10MBまでで、それ以上は拒否されます。

また、質問の入力は、日本語、英語のどちらにも対応しており、日本語質問の場合は日本語での回答、英語質問の場合は英語での回答となります。

3.実際の使用例(英語論文の場合)

文書ファイルは、論文公開サイトのarXiveからダウンロードした音声生成AIのVALL-Eの論文「Neural Codec Language Models are Zero-Shot Text to Speech Synthesizers」のPDFファイルを使用しています。

(1) 日本語質問と英語質問

日本語と英語で同じ質問をして、回答の精度を比較してみました。

問 VALL-Eについて教えて

答 VALL-Eは、音声コーデックコードを中間表現として使用するTTSの言語モデルアプローチです。60,000時間の音声データでVALL-Eを事前に訓練し、ゼロショットシナリオでのインコンテキスト学習能力を示します。LibriSpeechとVCTKで新しい最先端のゼロショットTTS結果を達成しました。さらに、VALL-Eは音響環境と話者の感情を合成に保持でき、サンプリングベースのデコードプロセスで異なる出力を提供できます。

問 Tell me about VALL-E.

答 VALL-E is a language model approach for TTS using audio codec codes as intermediate representations. We pre-train VALL-E with 60K hours of speech data, and show the in-context learning capability in zero-shot scenarios. We achieve new state-of-the-art zero-shot TTS results on LibriSpeech and VCTK. Furthermore, VALL-E could keep the acoustic environment and speaker's emotion in synthesis, and provide diverse outputs in different sampling-based decoding processes.

(DeepL翻訳)

答 VALL-Eは、音声コーデックコードを中間表現として用いるTTSのための言語モデルアプローチである。VALL-Eを6万時間の音声データで事前学習し、ゼロショットシナリオでのインコンテキスト学習機能を示す。その結果、LibriSpeechとVCTKにおいて、最新のゼロショットTTSの結果を得ることができた。さらに、VALL-Eは、音響環境と話者の感情を維持したまま合成を行い、異なるサンプリングベースの復号化プロセスで多様な出力を提供することができる。

基本的に同じ内容の回答を返してきます。日本語で質問しても、英語の回答を日本語訳して回答してくるようで、回答の精度に差はないようです。翻訳の誤りに気を付けさえすれば、日本語で質問しても問題ないようです。

(2) 論文の要約

問 論文を要約して

答 VALL-Eは、オーディオコーデックコードを中間表現として使用するTTSの言語モデルアプローチです。60K時間の音声データでVALL-Eを事前訓練し、ゼロショットシナリオでのインコンテキスト学習能力を示します。LibriSpeechとVCTKでのゼロショットTTSの最新の結果を達成しました。さらに、VALL-Eは合成中の音響環境と話者の感情を保持し、異なるサンプリングベースのデコードプロセスで多様な出力を提供できます。

※「VALL-Eについて教えて」と聞いた時と基本的に同じ回答です。

問 論文の概要を教えて

答 この論文では、Transformerネットワーク、敵対的ベクトル量子化オートエンコーダ、BERT事前訓練、拡散確率モデル、自己教師表現、Kaldi音声認識ツールキット、フローベース生成ネットワーク、テキストから音声へ、教師なしユニット発見、Wavenet、ニューラル離散表現学習、CSTR音声クローニングツールキット、話された内容と声の要因分解、適応テキストから音声へ、レイヤー正規化、およびエンドツーエンドニューラルオーディオコーデックなど、ニューラル音声合成の最新の進歩をレビューします。

※専門用語の羅列で分かりにくいです。

問 論文の内容を初心者向けに分かりやすく説明して

答 VALL-Eは、オーディオコーデックコードを中間表現として使用して、テキストから音声を合成するゼロショットテキストから音声へのシンセサイザーです。60K時間の音声データを使用して事前訓練し、LibriSpeechとVCTKで最新の結果を達成しました。VALL-Eは、合成中の音響環境と話者の感情を保持し、異なるサンプリングベースのデコードプロセスで多様な出力を提供できます。

※TTS(text-to-speach)を「テキストから音声を合成する」と言い換えて分りやすくしていますが、その後の文章が重複して、少しおかしくなっています。この質問の仕方でも、全体的に、あまり分かりやすく簡単にはなっていないようです。

同じような質問でも、聞き方によって回答の内容や精度が変わります。同じ質問でも、最初からやり直すと、また違う回答を返してくることがありますので、色々と聞き方を変えて、良い回答が返ってくる聞き方を探してみてください。

(3) 追加質問

返ってきた回答などを元に、さらに色々と追加質問をしてみます。

問 オーディオコーデックコードについて教えて

答 オーディオコーデックコードは、音声を符号化してネットワーク伝送を圧縮するために使用されるコーデックモデルです。オーディオコーデックモデルは、トレーニング中に見られない話者であっても高品質な波形を再構築できます。オーディオコーデックモデルは、従来のオーディオコーデックアプローチよりも低ビットレートでは大幅に優れています。

※よく説明してくれていますが、最後の一文がよく分からないですね。実際には、VALL-Eは、EnCodecという昨年10月にMetaが発表した新しいオーディオコーデックモデルを使用しています。

問 ゼロショットシナリオでのインコンテキスト学習能力とは何ですか?

答 ゼロショットシナリオでのインコンテキスト学習能力とは、モデルがテキストなしで音声を合成する能力を持つことを意味します。インコンテキスト学習能力を持つモデルは、テキストなしで音声を合成するために、オーディオコーデックコードを中間表現として使用することができます。

※テキストには「文字情報」という意味もあるので、「テキストなし」と言うより、「教師なし」あるいは「ファインチューニングなし」と言った方が分かりやすいのではないでしょうか。

問 VALL-Eの性能評価について教えて

答 VALL-Eは、LibriSpeechとVCTKデータセットで評価されました。テストスピーカーはトレーニングコーパスでは見られませんでした。VALL-Eは、LibriSpeechで+0.12の平均オプションスコア(CMOS)と+0.93の類似性平均オプションスコア(SMOS)の改善を示し、VCTKで+0.11 SMOSと+0.23 CMOSの改善を達成しました。さらに、VALL-Eはグランドトゥルースと比較して+0.04 CMOSスコアを達成し、未知のスピーカーの合成音声が人間の録音と同じくらい自然であることを示しています。

※「テストスピーカーはトレーニングコーパスでは見られませんでした。」というのは、今回、テストした人の声は、トレーニングで使用したデータの中には入っていなかった、つまり、未学習の音声だったという意味です。

細かい質問をしても、きちんと対応してくれます。ただ、説明があまり分かりやすくはなく、まだ改善の余地がありそうです。

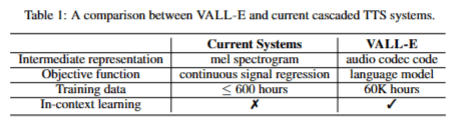

(4) 図表の読み取り

Humataは画像を認識していないはずですが、図や表の内容を把握できているかどうか確認してみます。

問 1頁目の図の内容を教えて

答 1ページ目の図は、VALL-Eの一般的な構造を示しています。VALL-Eは、VAEとGANをベースにしています。VAEはスピーカーIDを潜在コードにエンコードし、GANは潜在コードに基づいて音声を生成します。また、VALL-Eは、オートレグレッシブ(AR)デコーダーのみの言語モデルと、最初の量子化器から最後の量子化器までの離散トークンに対する非オートレグレッシブ(NAR)言語モデルを使用して、条件付きコーデック言語モデルとして訓練されます。

※一見、内容を理解して回答しているように見えますが、「VALL-Eは、VAEとGANをベースにしています。」というのがどこから出てきたのか疑問です。また、ARデコーダーとNAR言語モデルについても、Figure 1には描かれていないようです。

問 Figure 3の内容を教えて

答 Figure 3は、条件付きコーデック言語モデルの構造を示しています。実践では、NARデコーダーは7回呼び出され、7つの量子化器でコードを生成します。これは、音素列x、音響プロンプト. ̃. C、および前のコードブックC. : ,<j . :. p ( C. : , 2:8. | x , . ̃. C ; θ. N AR. ) =. 8. ∏. j =2. p ( c. : ,j . | C. : ,<j . , x , . ̃. C ; θ. N AR. ) (2)に基づいています。ARモデルとNARモデルの組み合わせは、音声品質と推論速度の良いトレードオフを提供します。

※数式部分は上手く表現できていませんが、Figure 3の注釈などから図の内容をある程度把握しているようです。

問 Table 1の内容を教えて

答 1ページ目の表は、LibriSpeechテストクリーンでのVALL-Eの人間評価結果を示しています。SMOS比較によると、VALL-Eはグランドトゥルースに非常に近いことを示しており、テスト中の未知のスピーカーに関して、合成されたスピーチが非常に似ていることを示しています。自然な発話に関しては、VALL-Eはベースラインを+0.12 CMOSで上回り、提案手法がゼロショットシナリオでより自然でリアルなスピーチを合成できることを示しています。

※残念ながら、論文2頁目のTable 1ではなく、9頁に掲載されたTable 3の説明になってしまったようです。

図表の内容も、注釈や本文からできるだけ把握しようとしていますが、図表に描かれていない内容を回答したり、別の図表と間違えて回答したりすることがあるので注意が必要です。

(5) 論文に関連したレポートの作成

論文に関連して、VALL-Eに関するレポートを書いてもらいます。

問 VALL-Eについて400字くらいでレポートを書いて

答 VALL-Eは、オフザシェルフのニューラルオーディオコーデックモデルから抽出された離散コードを使用して、TTSを条件付き言語モデリングタスクとして扱うゼロショットテキストからスピーチ合成器です。LibriLightコーパスを使用してトレーニングされ、7000人以上のユニークなスピーカーを持つ60K時間の英語スピーチから構成されています。スピーチの自然さとスピーカーの類似性に関して、現在の最先端のゼロショットTTSシステムを大幅に上回ります。また、同じ入力テキストで様々な出力を提供し、音響プロンプトとスピーカーの感情のアコースティック環境を維持することができます。

※ある程度書けていますが、284字なので、少し短いですね。また、専門用語が多く、少し分かりにくいです。

次に、Humataに最初にレポートの構成を考えてもらってから、レポートを書いてもらいます。

問 VALL-Eに関するレポートの構成を考えて

答 はい、VALL-Eに関するレポートの構成を考えます。レポートは、VALL-Eの概要、モデル構造、評価結果、結論、制限、今後の課題などから構成されます。VALL-Eの概要では、VALL-Eが何であるか、どのようなタスクを実行するか、どのような特徴があるかなどを説明します。モデル構造では、VALL-Eがどのようなモデル構造を持つかを説明します。評価結果では、VALL-EがLibriSpeechおよびVCTKでどのような結果を達成したかを説明します。結論では、VALL-Eが他のゼロショットTTSシステムよりも優れていることを示します。制限では、VALL-Eが抱えるいくつかの問題を説明します。最後に、今後の課題では、VALL-Eが今後どのような課題に取り組むかを説明します。

問 それでは、まず、「VALL-Eの概要」について、レポート本文を書いてください。

答 VALL-Eは、ゼロショットテキストから音声合成を行うためのニューラルネットワークモデルです。VALL-Eは、自動回帰(AR)モデルと非自動回帰(NAR)モデルを組み合わせたモデル構造を持ち、話者の特徴を再現することができます。VALL-Eは、従来のパイプライン(例えば、フォネーム→メルスペクトログラム→波形)とは異なり、フォネーム→離散コード→波形のパイプラインを持ちます。VALL-Eは、フォネームと音響コードプロンプトに基づいて離散オーディオコーデックコードを生成し、対象のコンテンツと話者の声に対応します。VALL-Eは、LibriSpeechおよびVCTKで評価され、LibriSpeechでは4.29±0.09のスコアを達成しました。VALL-Eは、他のゼロショットTTSシステムよりも優れていることが示されました。VALL-Eは、反響を伴う音声も合成することができますが、ベースラインの出力はクリーンな音声です。VALL-Eは、クリーンな環境だけでなく、多くの音響状況を含む大規模なデータセットで訓練されているため、音響一貫性を学習することができます。また、VALL-Eは、モデルが感情的TTSデータセットで微調整されていなくても、音声合成中に音声プロンプトの感情を保持することができます。

※なお、LibriSpeechの4.29±0.09のスコアというのは、VCTKのGroundTruth(人間による正解音声)のスコアで、VALL-Eのスコアではありません。他の部分は、特に大きく間違っているところはないようです。

以下、同じように、項目ごとにレポート本文を書いていってもらいます。

最終的に全部の文章を繫げたのが以下のレポートになります。

〇 VALL-Eに関するレポート

1.VALL-Eの概要

VALL-Eは、ゼロショットテキストから音声合成を行うためのニューラルネットワークモデルです。VALL-Eは、自動回帰(AR)モデルと非自動回帰(NAR)モデルを組み合わせたモデル構造を持ち、話者の特徴を再現することができます。

VALL-Eは、従来のパイプライン(例えば、フォネーム→メルスペクトログラム→波形)とは異なり、フォネーム→離散コード→波形のパイプラインを持ちます。VALL-Eは、フォネームと音響コードプロンプトに基づいて離散オーディオコーデックコードを生成し、対象のコンテンツと話者の声に対応します。

VALL-Eは、LibriSpeechおよびVCTKで評価され、LibriSpeechでは4.29±0.09のスコアを達成しました。VALL-Eは、他のゼロショットTTSシステムよりも優れていることが示されました。

VALL-Eは、反響を伴う音声も合成することができますが、ベースラインの出力はクリーンな音声です。VALL-Eは、クリーンな環境だけでなく、多くの音響状況を含む大規模なデータセットで訓練されているため、音響一貫性を学習することができます。

また、VALL-Eは、モデルが感情的TTSデータセットで微調整されていなくても、音声合成中に音声プロンプトの感情を保持することができます。

2.モデル構造

VALL-Eのモデル構造は、自己回帰(AR)モデルと非自己回帰(NAR)モデルの2つの部分から構成されています。ARモデルは、音素埋め込み、音響埋め込み、変換復号器、予測層からなる第一量子化器からトークンを生成するために用いられます。NARモデルは他の7つの量子化器からトークンを生成するために使用されます。NARモデルは、8つの独立した音響埋め込み層を含むことを除いて、ARモデルと同様のアーキテクチャを持ちます。

学習時には、最初のコードブックに含まれる次のトークンの確率を最大にするようにモデルが最適化されます。推論では、音素列と未見の話者の3秒間の在籍録音が与えられると、まず学習済みの言語モデルによって、対応するコンテンツと話者の音声を含む音響コードマトリックスが推定されます。その後、ニューラルコーデックデコーダが高品質な音声を合成します。

3.評価結果

VALL-EをLibriSpeechとVCTKという2つのデータセットで評価しました。 LibriSpeechでは、VALL-EはWER5.9、話者類似度スコア0.585を達成しました。VCTKでは、VALL-EはWER 5.3、話者類似度スコア0.732を達成しました。

両データセットにおいて、VALL-Eは、話者類似度の点でベースラインを上回りました。また、自然さの観点からは、VALL-EはVCTKにおいてベースライン比CMOS 0.00、LibriSpeechにおいてベースライン比CMOS +0.12を達成しました。

さらに、VALL-EはVCTKにおいて、CMOSがグランドトゥルースに対して+0.04となり、このデータセットにおける人間の録音との統計的有意差がないことが示されました。

4.結論

結論として、条件付きコーデック言語モデリングタスクに基づくゼロショットTTSシステム、VALL-Eを発表しました。LibriSpeechとVCTKという2つのデータセットでVALL-Eを評価しました。その結果、VALL-Eは話者の類似度や自然さの点でベースラインを上回ることが分かりました。また、VALL-EはVCTKにおいて、グランドトゥルースに対して+0.04のCMOSを達成し、このデータセットにおける人間の録音との統計的有意差がないことを実証しました。

VALL-Eにはいくつかの制約があります。まず、VALL-Eは一人の話し手に限定しています。複数の話者の音声を生成することはできません。第二に、VALL-Eは1つの言語に限定されていることです。複数言語の音声を生成することはできません。第三に、VALL-Eは単一ドメインに限定されています。複数のドメインの音声を生成することはできません。最後に、VALL-Eは単一スタイルに限定されています。複数のスタイルの音声を生成することはできません。

今後は、VALL-Eの限界に対応していく予定です。VALL-Eを複数の話者、言語、ドメイン、スタイルに拡張する予定です。また、非自己回帰モデルの活用やモデリングにおける注意メカニズムの変更により、VALL-Eの合成の頑健性を向上させる予定です。最後に、学習データをさらにスケールアップし、韻律、話し方、話者の類似性の観点でモデルの性能を向上させる予定です。

ある程度まとまったレポートを作成することができましたが、重複する部分が多く、細かい間違いもありました。また、説明不足の専門用語も多く、正式に提出できるようなレポートにするには、人間による修正が必要です。しかし、ゼロから自分でレポートを書くよりは、時間短縮ができると思います。

文章生成能力の高いChatGPTを使えれば、もう少しまとまったレポートが作成できるし、プロンプトで指示して文章を修正することも簡単にできると思うのですが、どうでしょうか。ChatGPTに自分が用意した文書ファイルを読み込める機能や検索結果を利用できる機能が追加されることが期待されます。