ChatGPTも過去のことは忘れてしまうのか?【LLM における壊滅的な忘却(モデルドリフト)】

はじめに

最近面白い記事を見かけました。

ChatGPTも人間と同じように過去の情報は忘れてしまうのでしょうか?

「AIなんだから人間と違って忘れるはずないよね?」と思ってしまいますが、実はそうでもないようです。

壊滅的忘却 (CF) とは、LLM が新しい情報を学習する際に、以前に取得した知識を失う傾向にある現象を指します。

この現象によると、ChatGPTのようなLLMも、人間と同じように新しいことを覚えると過去のことは忘れます。

改めて考えると、器の大きさが決まっていて学習できる量が決まっているのであれば、古いことは忘れても不思議ではありません。

生成AIのモデルを新しいデータでトレーニングしたり、特定タスク向けにファインチューニングすると以前学習した情報が失われる傾向があります。

この現象のことを「モデル ドリフト」と呼びます。

その影響で概念や知識の表現が劣化したり、新しい情報によって上書きされる可能性があります。

なのでチャット回答精度の低下につながる可能性があります。

LLM ドリフト

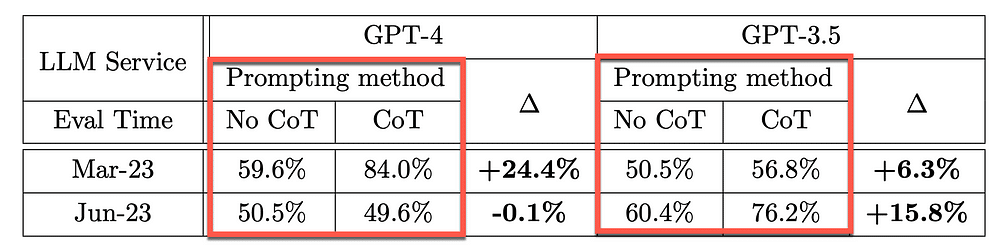

GPT-3.5とGPT-4で2023 年 3 月と2023 年 6 月に実施された以下の評価は、さまざまなタスクで両モデルを比較しています。

評価の結果、GPT-3.5 と GPT-4 のパフォーマンスと動作は時間の経過とともに大きく変化していました。

変化の例

GPT-4 ( 2023 年 3 月) は、素数と合成数の識別において良好なパフォーマンスを示しました (精度 84%) が、GPT-4 (2023 年 6 月) は、次のCoTの低下が部分的に原因として、パフォーマンスが低かった (精度 51%)。

GPT-3.5 は、特定のタスクにおいて 3 月と比較して 6 月に改善されました。

GPT-4は、3月に比べて6月には機密性の高い質問や世論調査の質問に答える意欲が減りました。

6 月のマルチホップ質問では GPT-4 のパフォーマンスが向上しましたが、GPT-3.5 のパフォーマンスは低下しました。

どちらのモデルでも、6 月は 3 月に比べてコード生成時のフォーマットミスが多かった。

この研究では、LLM の動作は時間の経過とともに変化するため、LLM を継続的に監視する必要性が強調されています。

GPT-4 がユーザーの指示に従う能力が時間の経過とともに低下し、動作のドリフトに寄与していることを示す証拠があります。

以下の表は、プライム テストにおける思考連鎖 (CoT) の有効性の時間の経過に伴うドリフトを示しています。

上記のソース元は以下です。

ChatGPT の動作は時間の経過とともにどのように変化しますか?

GPT-4の「Mar-23」ー「CoT」の良好さに比較して「Jun-23」の精度が大幅にダウンしているようです。

CoT でGPT-4 は 3 月に24.4% の精度が向上していますが、6 月には全く精度が上がらず -0.1% 低下しました。

これだけをみても、GPT-4 は CoT プロンプト手法を最適化する機能を失っているように見えます。

一方、GPT-3.5 はCoTで 3 月の 6.3% から 6 月の 15.8% に増加しています。

GPT-3.5の場合は、逆に精度が向上しているようです。

「急にGPT-4の精度が悪くなったなー」と感じている人は、もしかしたらこの「ドリフト」の影響かもしれませんね。

以下の図は、4 か月間のモデル精度の変動を示しています。場合によっては、精度が 60% 以上失われます。

まとめ

ChatGPTにはこの記事のような「壊滅的忘却」が存在することがわかりました。

これはGPTシリーズだけの問題なのでしょうか? Claudeや他のLLMでも同じなのかは気になりますね。

スケールが大きくなるほど、モデルは領域知識、推論、読解力の物忘れが激しくなるようです。

モデルが新しくなるときは気を付けたほうが良さそうですが、どうしても新しいモデルで問題がでるようでしたら、古いモデルを使う方法もあるでしょう。

モデルが新しくなったら、すべての領域で良くなるだろうと思ってましたがそうでもないということがわかりました。

自分も最近よく忘れ物をするので生成AIも少し人間ぽくて面白いですね。