AIの出力結果に「説明」は必要なのか、日本内科学会講演会レポート――Dr. 心拍の「デジタルヘルスUPDATE」(56)

m3.comで掲載された執筆記事を公開します。医師の方は下記URLからお読みください。

AIの出力結果に「説明」は必要なのか、日本内科学会講演会レポート――Dr. 呼坂の「デジタルヘルスUPDATE」(56) | m3.com AI Lab

呼吸器診療が専門の総合病院で勤務しつつ、ヘルスケアビジネスにも取り組むDr.心拍氏を中心とするチームが、日々のデジタルヘルスニュースを解説します。

Dr.呼坂が第119回内科学会総会・講演会のプログラムの中から興味深い演題についてダイジェスト版をお届けする本シリーズ。今回は、「AIと内科診療」というシンポジウムの中の「AI技術の発展と医療への応用」をご紹介します。これはシンポジウムの中の最初の演題で、東京大学大学院医学系研究科公共健康医学専攻医療科学講座教授の大江和彦氏がこれまでのAIと内科診療の歴史と課題、今後の展望についてわかりやすく話されました。

医師の頭脳活動をAIが実現するには課題が多い

ある診療プロセスでAIを役立てようとした際にまず行う必要のあることとは、医療者がその診療プロセスで何をどのように考えているのかということを細分化する作業です。

① 問診

② 考える(思いつく疾患と優先順位)

③ 検査戦略を立てて検査をする

④ 考える(診断を決める)

⑤ 治療計画を立てて治療する

このような診療プロセスにおいて、構造的・体系的な知識、ルールや経験的な知識、戦略的な知識、知識の適用力などが求められます。しかし、これらの知識をAIに教え込みつづけるには限界がありますし、与えていない知識は使えないという課題もあります。確かにひと昔前のAIってそのような辞書的イメージがありました。

人間は、膨大なデータから何か特徴的な所見を見つけてパターン認識し、判断・分類することができますが、このような判断や分類は「知識」という視点で説明することはできません。そのため現在のAIは、事前の知識やルールによらず、計算機が自分で膨大なデータから「モデル」すなわち潜んでいる特徴パターンと結果の関係を作り上げる手法として機械学習、特に深層学習という技術を活用しています。画像認識がその一例になるでしょう。

画像認識で大活躍する畳み込みニューラルネットワーク(CNN)

現在、画像認識AIでよく耳にするようになった畳み込みニューラルネットワーク(CNN)については、以下の3つの特長が挙げられます。

深層学習の一手法であり画像認識、音声認識で高い識別精度を示す

画像の特徴を抽出するフィルタを教師あり学習により自動獲得するニューラルネットワーク

層を繰り返すことで低~高レベルの特徴抽出フィルタを段階的に獲得

医療分野でも、CNNは様々な画像診断支援に応用されています。具体的には

① 分類:皮膚がんの診断分類など

② 検出:内視鏡における胃がんの検出など

③ 領域分割:リンパ節転移における領域分割など

に使われています。

現在、承認されているプログラム医療機器を以下に示します。2022年度の診療報酬改定で「人工知能技術(AI)を用いた画像診断補助に対する加算」が新たに承認されたため、今後AIを用いた画像診断はさらに進んでいくと思います。先日、私も実際に画像診断支援AIに少し触れる座談会に参加しましたので参考にしてみてください。

胸部X線読影支援AI、点数付いたら使ってみたい?――現役医師のぶっちゃけAI座談会(後編)| m3.com AIラボ

出典:000244149.pdf (pmda.go.jp)

AIを活用した医療診断システム・医療機器の課題

次にAIの課題についてです。PMDA科学委員会において議論された結果、今後検討が必要な事項として、

① データ再利用のあり方

② 評価データに求められる条件

③ 市販後に性能変化することを意図するAI(Adaptive AI)の審査のあり方

の3つが挙げられました。

AIは常に学習を繰り返しながら日々進化していくものです。評価する側も、その進化を活かすためにどう評価すべきかを検討する必要があると感じました。

AIのブラックボックス問題、説明できるAIはできるのか?

「ブラックボックス問題」もAIが持つ課題としてよく取り上げられます。これは、機械学習が判定したとき、その理由を人間が理解できないという不透明さの問題です。そのため「説明可能なAI」の登場が望まれる傾向にあります。

これはその通りで、人間わからないと受け入れがたいということもあり、どうしてAIがそういう判断をしたのか、たとえそれがとても優秀な成績を出すAIだとしても理由を知りたくはなりますよね。

しかし、説明可能なAIの研究は進んでいるものの、そもそもAIの仕組み自体が知識をもとに考えているわけではないため、どうしてもその説明は後付けとなってしまいます。また、AIに限らず機序不明なシステムも多く、説明できていないまま使用されているというケースも実際にはあるため、そもそも説明が必要なのかという議論もあります。

学習データの偏りによる判断の偏り

開発の際の学習データが偏る危険性がある、という課題もあります。ある機械学習アルゴリズムでは、色素性皮膚病変の学習データとして白人データが圧倒的に多く使用されているとします。その場合、どんなに高度なアルゴリズムを組めたとしても有色皮膚における色素性病変の診断性能は低下するでしょう。背景となる皮膚色が大きく異なるため、性能に限界が生じるのです。このような問題に気づかないまま開発が進むと、有色皮膚の患者に不公平な診断バイアスをもたらすリスクが生じます。

実際の具体例として、皮膚病変の良悪性を識別するために機械学習させる際、悪性では物差しが写りこんでいる写真が多かったということがあります。その結果、病変ではなく、物差しの有無で悪性か良性かをAIは判断することになったのです。

出典:https://www.jidonline.org/article/S0022-202X(18)32293-0/fulltext

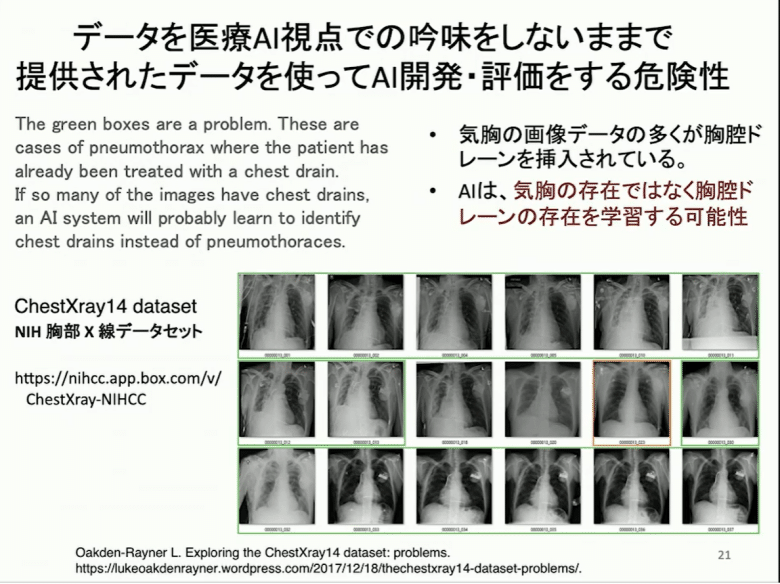

また、胸部X線画像から気胸の検出を行う画像診断支援AIの開発でも同様のことがおきました。提供された気胸の画像の多くには胸腔ドレーンが挿入されていたのです。この場合、AIはやはり気胸の存在ではなく胸腔ドレーンの存在を学習する危険性があります。このように、AIを開発する際には学習データの偏りに注意する必要があります。

最後に

今回、第119回内科学会総会・講演会を聴講し、年々AIへの注目度が増してきているという印象を持ちました。AIの歴史を学ぶことで目の前の課題が明確になり、今後何を見据えて進めていく必要があるのか、どんなことに注意しなければならないのか、自分にとっても大きな収穫になったように思います。

特にAIを開発するときの注意点に関しては、背景の色だけでなく物差しや胸腔ドレーンといった本来の画像診断とは関係ないものの存在がバイアスリスクとなる危険性を実感することができました。AI開発者だけでなくAIを使う側も常に意識しておかなければならない観点だと感じました。

【著者プロフィール】

Dr.心拍 解析・文 (Twitter: @dr_shinpaku)

https://twitter.com/dr_shinpaku

呼吸器内科の勤務医として喘息やCOPD、肺がんから感染症まで地域の基幹病院で幅広く診療している。最近は、医師の働き方改革という名ばかりの施策に不安を抱え、多様化する医師のキャリア形成に関する発信と活動を行っている。また、運営側として関わる一般社団法人 正しい知識を広める会 (tadashiiiryou.or.jp)の医師200名と連携しながら、臨床現場の知見や課題感を生かしてヘルスケアビジネスに取り組んでいる。

各種医療メディアで本業知見を生かした企画立案および連載記事の執筆を行うだけでなく、医療アプリ監修やAI画像診断アドバイザーも行う。また、ヘルステック関連スタートアップ企業に対する事業提案などのコンサル業務を複数行い、事業を一緒に考えて歩むことを活動目的としている。