【Ollama】Phi-3 Mediumをローカルで使ってみた感想!

👋みなさんこんにちは!AI-Bridge Labのこばです!

今回はMicrosoft社のオープンソースLLM「Phi-3」の中規模モデルPhi-3 Mediumのインストラクションチューニング(Instruction Tuning)版を試してみました!

Ollamaを使って自宅のPCからローカルLLMを気軽に試せるようになったので、今後も隙あらば色々なオープンソースLLMを使ってみた感想をレポートしていければと思います👍 何か良いモデルがあればコメントでシェアしていただけたら嬉しいです!

超簡単にオープンソースLLMを動かせる「Ollama」の導入については以下の記事をご参照ください

Phi3について

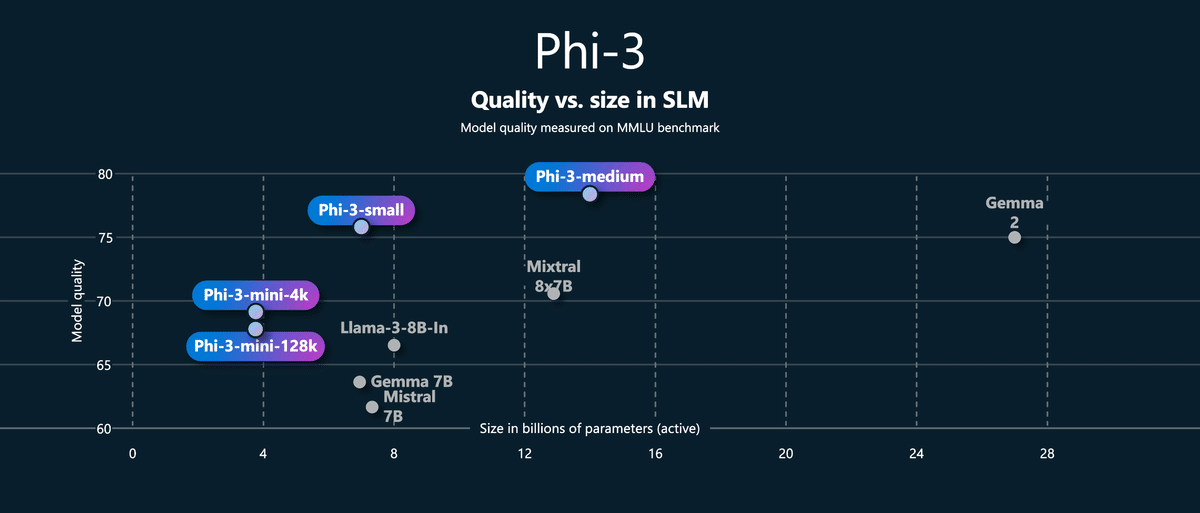

Phi-3は、Microsoftが開発した小型言語モデル(SLM)であり、特に高いパフォーマンスと効率性を誇るモデルです。

特徴と強み

高いパフォーマンスと効率性:

Phi-3は、量子化や剪定、知識蒸留などの高度なトレーニング技術を活用して、コンパクトで効率的なモデルを実現しています。

特に、小型モデルのPhi-3-miniは、わずか3.8Bのパラメータでありながら、GPT-3.5やMixtral 8x7Bと同等のパフォーマンスを発揮します。

展開の柔軟性:

Phi-3は、小型で高速な推論能力を持ち、自動車システムや産業オートメーションなど、さまざまなアプリケーションで利用可能です。

Phi-3-miniは、スマートフォンやローカルPC上でも実行可能で、特にリソースが限られた環境での利用に適しています。

今回使ったモデル

Phi3:14b-Medium-4k-Instruct-Q6_K

パラメータとアーキテクチャ

パラメータ数: 14B

アーキテクチャ: Dense decoder-only Transformerモデル

コンテキスト長: 4Kトークン

量子化とファイルサイズ

量子化タイプ: Q6_K

ファイルサイズ: 11.45GB

▼Ollamaのモデルページと実行コマンドはこちら

ollama run phi3:14b-medium-4k-instruct-q6_K▼Hugging Faceにあるモデルデータはこちら

感想レポート

1. 動作環境

自宅PCのメモリ: 32GB

phi-3 medium モデル: 量子化モデルでファイルサイズ11.45GBと軽量のため、動作はスムーズ

2. パフォーマンス

全体的に期待を上回る性能を発揮。

特に、言語理解能力の高さは目を見張るものがあり、日本語での会話や言語処理においても高い精度を実現。

創造力が求められる詩の作成でも一瞬で出力。感動しました🥹

3. 使用感

言語理解タスクにおいては、Llama-3-70B-Instructなどの大型モデルと比較しても遜色ない、もしくは勝るぐらいの自然な対話が可能

文脈理解や常識推論の問題は高い正解率。

RAGとの組み合わせにより、実用レベルのポテンシャルを発揮する可能性が高い

限定的な言語処理タスク(ラベリング、顧客への返信文ドラフト作成など)では実用レベルで活用できる可能性が高い。

4. 課題

論理的思考を問う問題への対応は難しく、Claude3 opusが出した論理問題を全部間違えるぐらい厳しかった。

5. まとめ

phi-3 medium モデルは小型ながら高い言語理解能力と創造性、推論能力を備えており、自然でスムーズな会話が可能です。phi3も第一言語は英語なので、日本語の場合、能力が低下すると書かれていた割にはかなり高性能です。

私のPCで動作するレベルのLLMではサイズ、能力鑑みて現時点でベストという印象です。

論理的思考能力やコード生成能力はまだ発展途上であるため、今後に期待したいです。

AIBridge Lab について

AIを使った課題解決や業務効率化に興味のある方は、ぜひAI-Bridge Lab.までご相談ください。経験豊富なコンサルタントが、御社の状況に合わせたAI活用をご提案させていただきます。お問い合わせ、お待ちしております!

ご依頼等は以下のメールアドレスまでお気軽にお問い合わせください。

いいなと思ったら応援しよう!